Автоматика и телемеханика, № 11, 2019

Интеллектуальные системы управления,

анализ данных

© 2019 г. Е.К. КОРНОУШЕНКО, д-р техн. наук (ekorno@mail.ru)

(Институт проблем управления им. В.А. Трапезникова РАН, Москва)

ПРОЦЕДУРА КЛАССИФИКАЦИИ ОБЪЕКТОВ

С СЕМАНТИЧЕСКОЙ ИЕРАРХИЕЙ ПРИЗНАКОВ

Предложена процедура классификации объектов с иерархической

структурой взаимоотношений (семантикой) признаков с учетом их мо-

дальностей. Понятия семантики признаков и их модальности объясня-

ются перед описанием самой процедуры. Рассматривается трехуровневая

модель с семантической иерархией признаков: «классифицируемые объ-

екты - метапризнаки - признаки объектов». Метапризнаки интерпрети-

руются как семантические обобщения относящихся к ним признаков объ-

ектов. Важным этапом предлагаемой процедуры является агрегирование

признаков нижнего уровня с учетом их семантической связи с метапри-

знаками. Агрегирование приводит к существенному уменьшению размер-

ности исходной задачи классификации, решаемой теперь в терминах зна-

чений функций агрегирования. В качестве примера используется выбор-

ка Dermatology из известного репозитория UCI Machine Learning. На этом

примере показано, что несмотря на существенную несбалансированность

выборки Dermatology результаты применения предлагаемой процедуры

вполне сравнимы с лучшими результатами ряда известных алгоритмов

классификации, полученными на этой выборке.

Ключевые слова: субпризнак, метапризнак, семантическая иерархия при-

знаков, модальность признака, агрегирование, классификация.

DOI: 10.1134/S0005231019110084

1. Введение

Варианты постановок и решений задач классификации1 существенным об-

разом зависят от структуры множества признаков классифицируемых объек-

тов2 и иерархии классов, априори введенных на объектах исходной выборки.

Структура множества признаков (как и сами признаки) может быть раз-

ной для разных постановок задачи классификации. Так, при допущении, что

все признаки независимы и измеримы (в соответствующих шкалах), в каче-

стве модели исходных данных может быть выбрана так называемая «плос-

кая» (flat) модель [1]. Альтернативами «плоской» модели являются различ-

1 В данной работе рассматривается только классификация «с учителем» (supervised

classification), предусматривающая наличие обучающей выборки, объекты которой одно-

значно принадлежат тому или иному классу введенного на выборке разбиения.

2 Под объектом может пониматься некая сущность (физический объект, наблюдение и

т.п.), описываемая соответствующей совокупностью признаков из выбранного множества

признаков. В зарубежных работах «носители» признаков называются по-разному: object,

entity, instance и т.п. Далее для единообразия будет использоваться слово «объект».

140

ные иерархические модели, в которых каждый уровень иерархии характери-

зуется соответствующим распределением «признаков-классов» [1]. В данной

статье предполагается, что каждый объект описывается соответствующей со-

вокупностью признаков (которые могут принадлежать и другим объектам),

а классов - небольшое число и они независимы.

В последние десятилетия в работах по искусственному интеллекту (особен-

но в работах по классификации документов, изображений и т.п.) стало ши-

роко употребляться понятие семантики данных [2], семантики признаков [3]

и семантической иерархии признаков (СИП) [4]. Предпосылками для уче-

та СИП при классификации объектов с признаками различной физической

природы явились многочисленные примеры иерархии признаков от «простей-

ших» понятий (например, желтый, красный и т.д.) до более сложных (напри-

мер, цвет), которые «встраиваются» как промежуточные уровни в соответ-

ствующие иерархии [5, 6]. Как показано в работах [4, 7], при классификации

объектов, допускающих построение СИП, учет СИП улучшает результаты

классификации таких объектов по сравнению с использованием для их клас-

сификации «плоской» модели.

Следующим важным понятием в данной работе является понятие модаль-

ности признаков. Считается [8], что модальность признака определяется кон-

текстом исследуемой ситуации, в которой под модальностью признаков мо-

жет пониматься различие в смысловом раскрытии понятия того или ино-

го признака. Так, основными модальностями при классификации изображе-

ний [5] являются такие модальности как текстура, цвет, наличие геометриче-

ских особенностей в изображении (углов, прямых линий и т.п.). В медицине,

например, широко применяются так называемые мультимодальные исследо-

вания [6], в которых одновременно анализируются признаки с различными

модальностями (изображения, видео, текст). При этом согласно [6] качество

классификации состояния пациента намного лучше, чем в случае использо-

вания признаков только одной модальности.

В данной статье рассматривается процедура построения алгоритма клас-

сификации в случае, когда признаки объектов имеют разные модальности

и допускают построение СИП. Верхний уровень модели с СИП составляют

объекты - «носители» признаков, а нижний - сами «простейшие» признаки

с теми или иными значениями. На промежуточном уровне модели распола-

гаются так называемые метапризнаки, содержание каждого из них опреде-

ляется соответствующим множеством относящихся к данному метапризна-

ку «простейших» признаков нижнего уровня. Суть предлагаемого подхода к

классификации - обоснование перехода от большой совокупности «простей-

ших» признаков к гораздо меньшей совокупности метапризнаков путем соот-

ветствующих агрегирований признаков нижнего уровня с учетом семантики

взаимоотношений признаков среднего и нижнего уровней. Как указано в ра-

ботах [1, 9, 10], специфика агрегирования признаков при переходе к метапри-

знакам в структурах с СИП состоит в том, чтобы при агрегировании сохраня-

лась структура семантических связей между признаками нижнего и среднего

уровней. В [11, 12] описываются требования, которым должна удовлетворять

выбираемая функция агрегирования и сама процедура выбора. В частности,

в такой функции должны учитываться совокупные эффекты, обусловленные

141

«горизонтальными» взаимовлияниями признаков на одном и том же уровне, и

такие совокупности признаков должны входить в область определения функ-

ции агрегирования. Известные методы уменьшения размерности, такие как

LLE (метод локального линейного вложения, local linear embedding), ISOMAP

и другие методы, анализируемые в [13], широко используются в различных

задачах. Однако, как указывается в [14], в подобных методах не учитыва-

ются семантические зависимости между переменными различных уровней и

различных модальностей, все такие переменные «сливаются» в переменные

пространств меньшей размерности.

Цель настоящей работы состоит в том, чтобы на примере простейшей трех-

уровневой структуры с СИП продемонстрировать основные этапы процедуры

классификации объектов:

— обоснование вводимых элементов промежуточного слоя;

— формирование модели с СИП для каждого объекта;

— выбор функций агрегирования признаков нижнего уровня;

— решение исходной задачи классификации в терминах значений исполь-

зуемых функций агрегирования с учетом указанных выше требований на

взаимоотношения переменных разных уровней.

В качестве иллюстративного примера рассматривается выборка

Dermatology из известного репозитория UCI Machine Learning [15], опи-

сывающая диагностику 6 видов кожных заболеваний у 343 пациентов на

основе 34 клинических и гистопатологических анализов. Показано, как по

этой выборке строится модель с СИП и как вводимое в модель агрегирование

уменьшает размерность исходной задачи классификации.

Работа построена следующим образом. Во введении приводятся необхо-

димые определения, связанные с СИП, и кратко представлен круг работ по

вопросам семантической иерархии и агрегирования. В разделе 2 подробнее

раскрываются формальные понятия, входящие в описание модели с СИП.

В разделе 3 обсуждается тип функций агрегирования, используемых для аг-

регирования признаков нижнего уровня. В разделе 4 представлена упрощен-

ная версия алгоритма классификации из работы [16], адаптированная для

решения задачи классификации в терминах значений используемых функ-

ций агрегирования, а в разделе 5 оценивается вычислительная сложность

предложенной процедуры. В разделе 6 описывается применение этой проце-

дуры к выборке Dermatology. Особенности данной процедуры, важные при

рассмотрении практических задач, обсуждаются в разделе 7. В заключение

делаются выводы о возможных применениях предложенного подхода.

2. Определение модели с СИП

Прежде всего, подробнее определим понятие модели с СИП. Пусть задана

совокупность S из n объектов, которые необходимо классифицировать. Каж-

дый из объектов описывется соответствующей совокупностью признаков, воз-

можно, разных модальностей, называемой описанием объекта. Обозначим че-

рез N0 мощность объединения X0 всех признаков. Иерархическая модель Hi

с СИП строится для каждого объекта Oi, i ≤ n. На верхнем уровне модели Hi

располагается сам объект Oi. Второй уровень модели содержит m метапри-

142

знаков M1, . . . , Mm, где m зависит от специфики рассматриваемой задачи

(так, например, в приводимой ниже выборке Dermatology метапризнаками

являются возможные виды заболеваний). Будем считать, что множество ме-

тапризнаков {M1, . . . , Mm} сопоставляется каждому объекту из S. При этом

если описание объекта Oi, i ≤ n не содержит некоторого метапризнака Mu,

u ≤ m, полагаем Mu = 0 в модели Hi. Каждому ненулевому метапризнаку Mj

в модели Hi однозначно сопоставляется множество Gij «простейших» призна-

ков нижнего уровня (для простоты называемых субпризнаками). Все элемен-

ты множества Gij суть значения признаков из описании объекта Oi. При этом

каждый субпризнак из Gij может входить в описания других объектов из S,

и соответственно - в другие множества3 Gis, . . . , Gik. Однозначность отнесе-

ния множества Gij к метапризнаку Mj говорит о том, что все субпризнаки

из Gij имеют семантические связи с Mj , а некоторые субпризнаки из Gij -

и с другими метапризнаками.

Переменные разных уровней в модели Hi могут анализироваться «сверху-

вниз» или «снизу-вверх». Для наглядности направление исследуемого соот-

ношения указывается направлением соответствующей стрелки ↓ или ↑. Мо-

дель Hi может быть представлена следующим образом:

{

Oi ↓ {Mj}mj=1 ↓ {Gij}mj=1 ↓

{xijk}Nj

}m ,

k=1

j=1

где xijk - элементы множества Gij с мощностью Nj.

В плане дальнейшего перехода к классификации объектов из S рассмот-

рим, как распределяются метки (labels) классов на уровнях модели Hi. До-

пустим, что на исходной совокупности объектов S введено некоторое раз-

биение π на K (K ≤ m) блоков (классов), и пусть объект Oi принадлежит

ν-му классу Cν (т.е. имеет метку ν). Эта метка переносится и на субпризнаки

из Gij , входящие в описание объекта Oi. Заметим, что поскольку субпризнаки

из Gij могут входить в описания и других объектов из S, скажем, объекта Or,

входящего в блок Cμ разбиения π, таким субпризнакам кроме метки ν при-

писывается и метка μ, так что каждый субпризнак из Gij может иметь, в

принципе, несколько меток (такая совокупность меток называется в лите-

ратуре bag of labels). Метки каждого субпризнака из Gij переносятся и на

те метапризнаки Mj , . . . , Mk, с которыми данный субпризнак семантически

связан. Этот факт учтем в виде соотношения

(1)

↑ {Op}rp=1

↑ {ν}.

=1

Здесь {Op}rp=1 - совокупность объектов, в описания которых входят призна-

ки, семантически связанные с Mj , . . . , Mk, а {ν} - множество меток таких

объектов, включающее метку ν объекта Oi. Аналогично строятся модели Hr

для остальных объектов Hr, r = 1, . . . , n из S. Далее считаем выполненными

следующие условия:

3 Так, при постановке медицинского диагноза учитывается тот факт, что тот или иной

симптом (субпризнак) может относиться к разным заболеваниям - см. приведенный ни-

же пример. На этапе классификации такие неоднозначности учитываются и усложняют

выработку диагноза.

143

1. Все модели Hr, r = 1, . . . , n изначально отличаются только значениями

субпризнаков нижнего уровня и структурой семантических связей субпри-

знаков с соответствующими метапризнаками (нулевые значения на втором и

третьем уровнях допустимы).

2. Субпризнаки с неопределенными или неизвестными значениями не до-

пустимы.

3. Каждый объект исходной совокупности S принадлежит однозначно к

тому или иному классу разбиения π = (C1, . . . , CK ), классы взаимно незави-

симы и K ≤ m4.

Ключевой момент предлагаемого подхода к классификации структур с

СИП состоит в агрегировании субпризнаков в каждом из множеств Gij ,

i = 1,...,n, j = 1,...,m и переходе от пространства исходных признаков

большой размерности N0 к пространству значений функций агрегирования

гораздо меньшей размерности m. Предварительная подготовка исходных дан-

ных к запуску процедуры классификации состоит в прохождении следующих

этапов: а) нормализация субпризнаков в каждом множестве Gij , i = 1, . . . , n,

1 ≤ j ≤ m и выбор функций агрегирования; б) нахождение значений функ-

ций агрегирования для каждого множества Gij ; в) определение каждой мо-

дели Pi, i = 1, . . . , n, являющейся модификацией соответствующей модели Hi

в терминах найденных значений функций агрегирования.

3. Выбор функций агрегирования для субпризнаков

Этапы выбора функций агрегирования для субпризнаков:

а. Поскольку значения субпризнаков в каждом множестве Gij могут из-

начально выбираться из разных шкал, перед агрегированием субпризна-

ки необходимо их нормализовать. Нормализация проводится по правилу

yijk

∑n

, где каждая нормализованная величина yijk есть доля ис-

xsjk

s=1

ходного значения субпризнака xijk из Gij в сумме (по всем объектам сово-

купности S) значений этого субпризнака. Подчеркнем, что нормализующий

1

множитель

∑n

для каждого признака Xk ∈ X0, входящего (с разными

s=1

xsjk

значениями) в множества Gij , 1 ≤ j ≤ m, i = 1, . . . , n, один и тот же. Распре-

деление нормализованных значений {yijk}, k = 1, . . . , N на множестве Gij не

является вероятностным, поскольку сумма (по k) переменных {yijk} в общем

случае не равна единице.

б. Выбираемая функция агрегирования должна быть чувствительной к

распределению и значениям ненулевых агрегируемых переменных. В случае

вероятностного распределения таких значений можно использовать инверс-

ную энтропию [17] (энтропию со знаком плюс). По аналогии с [17] функцию

агрегирования переменныхijk yijk в множествах Gij определим как

⎛

⎞

Nj

∑

(2)

Fij (yij1, . . . , yijNj ) =⎝-

yijk log2(yijk)|yijk > 0⎠ .

k=1

4 Случай K > m имеет особенности, требующие отдельного рассмотрения.

144

Для удобства отображение

(2) назовем псевдоэнтропией. Отображение

Fij : [0, 1]Nj → R является нелинейным монотонным неубывающим отобра-

жением. Функция Fij переводит вектор (yij1, . . . , yijNj ) в соответствующее

положительное число wij ∈ R, которое назовем весом метапризнака Mj в объ-

екте Oi выборки S. Аналогичным образом найдем веса wij для всех метапри-

знаков Mj , j = 1, . . . , m, i = 1, . . . , n. Отличие модели Pr от модели Hi лишь

в том, что элементы {M1, . . . , Mm} второго уровня заменяются значениями

соответствующих весов wrj. Строку весов, сопоставляемых объекту Oi, обо-

значим как Wi = {wij }, j = 1, . . . , m.

4. Процедура классификации объектов

с использованием весов метапризнаков

4.1. Разбиение исходной совокупности S

на обучающую и тестовую выборки

Классификация (supervised) объектов предусматривает разбиение исход-

ной совокупности S на обучающую выборку (ОВ) и тестовую выборку (ТВ),

которые содержат nОВ и nТВ объектов соответственно. При этом все объек-

ты сохраняют те же метки, что и ранее в совокупности S. Другими словами,

разбиение π разделяется на два подразбиения πОВ и πТВ с выполнением сле-

дующих важных требований:

Требования к формированию ОВ и ТВ.

а. Каждый класс подразбиения πТВ должен иметь непустое пересечение с

каким-либо классом подразбиения πОВ.

б. Модели для объектов Oi из ОВ и ТВ являются теми же, что и ранее

построенные модели Hi для этих объектов из S. в. Метки объектов из ТВ не

участвуют в процедуре построения алгоритма классификации, а используют-

ся лишь при определении точности классификации построенного алгоритма.

Задача классификации объектов с СИП формулируется следующим обра-

зом. Метки объектов из ОВ априори считаются известными. Метка ν объек-

та Oi из ОВ переносится на компоненты соответствующего этому объекту Oi

вектора весов Wi = {wij }, j = 1, . . . , m, так что соотношение (1) для объек-

та Oi выглядит так:

Oi ↓ {wj}mj=1 ↓ ν.

Метки для объектов из ТВ определяются вхождением этих объектов в тот

или иной блок подразбиения πТВ. Для удобства при рассмотрении моделей из

ТВ все элементы снабжаются штрихами. При этом функция агрегирования

субпризнаков в G′pj определяется по аналогии с (2) как

⎛

⎞

N′j

∑

F′ij(y′ij1,... ,y′ijN′ ) =⎝-

y′ijt log2(y′ijt)y′

>0⎠.

ijt

j

t=1

Поскольку значения субпризнаков в моделях объектов из ОВ и ТВ могут не

совпадать, для корректного сравнения значений весов wij и w′ij, получаемых с

применением функций агрегирования Fij и F′ij , нормализующий множитель

145

1

∑n

для субпризнаков из G′ij должен быть тем же самым, что и при

xsjk

s=1

нормализации субпризнаков в Gij .

4.2. Классификация объектов ТВ с использованием весов метапризнаков

Ниже с краткими комментариями приводятся основные этапы алгоритма

из [16] с адаптацией к классификации объектов в терминах весов метапри-

знаков.

Пусть Z - тестовый объект, модель HZ для которого характеризуется век-

тором весов метапризнаков W′Z = (w′Z1, . . . , w′Zm). Перечислим основные эта-

пы адаптированного алгоритма классификации, обозначаемого для кратко-

сти как ААК.

А. Определение понятия “допустимой близости” для весов метапризна-

ков. Для каждого метапризнака Mj определяются его максимальный mmaxj

и минимальный mminj веса по всем объектам из S. Разность этих значений

делится на некоторое выбираемое число h (о выборе значения h будет сказано

далее в п. Д). Обозначим dj =wmaxj -wminjh.Двазначенияwrjиwsjназовем

dj-близкими, если модуль их разности не больше dj. Для простоты будем

считать, что h не зависит от j.

Б. Построение матрицы весов для тестового объекта Z. Пусть w′Zj —

вес метапризнака Mj в объекте Z. Совокупность весов метапризнака Mj

в объектах из ОВ, таких что эти веса dj -близки к значению w′Zj, назовем

dZj-окрестностью значения w′Zj. Множество объектов из ОВ, образующих

dZj-окрестность значения w′Zj, обозначим как U(w′Zj,dj), совокупность ве-

сов метапризнаков объектов из множества U(w′Zj , dj ) — как V (w′Zj , dj ), а со-

вокупность меток объектов из U(w′Zj , dj ) — как L(w′Zj, dj ). Пусть NZjν —

число объектов из U(w′Zj, dj ), входящих в блок Cν разбиения πОВ. Сопоста-

NZjν

вим значению w′Zj число5 gZjν =

, где | ∗ | обозначает мощность

|U(w′Zj,dj)||C∇|

соответствующего множества. Найденное число gZjν будем рассматривать

как вес метки ν в множестве L(w′Zj , dj ) . Подобным образом найдем мно-

жество NZjμ объектов из U(w′Zj, dj ), принадлежащих классу Cμ, μ = ν, и вы-

числим вес gZjμ каждой метки μ (μ = 1, . . . , K). Сформируем столбец весов

меток GZj = (gZj1, . . . , gZjK )T для веса w′Zj метапризнака Mj в объекте Z.

Заметим, что все координаты в GZj — неотрицательные и не большие еди-

ницы. Столбец весов GZj можно интерпретировать как локальный (по мета-

признаку Mj ) классификатор для объекта Z. Аналогичным образом найдем

векторы-столбцы весов для ненулевых значений всех m метапризнаков объ-

екта Z и сгруппируем эти столбцы в матрицу QZ размера K × m, которую

назовем матрицей весов меток метапризнаков в объекте Z.

В. Определение метки для тестового объекта Z. Интерпретируем мат-

рицу QZ как совокупность локальных классификаторов (по метапризнакам

объекта Z). В [18] говорится о том, что классифицирующая способность объ-

единения локальных классификаторов может быть усилена путем их взве-

шивания (combining) с использованием какой-либо нелинейной монотонной

5 В [16] объясняется структура коэффициента gZj.

146

функции. В качестве такой функции взвешивания ΦZμ по каждой стро-

ке GZμ с номером μ в матрице QZ возьмем функцию того же типа, что и

Fij (см. (2)), и применим еe к каждой строке GZμ матрицы QZ . Сформируем

вектор RZ = E(GZK ), который назовем классифицирующим вектором для

объекта Z. Номер координаты вектора RZ с наибольшим значением считаем

меткой, приписываемой тестовому объекту Z. Аналогичным образом произ-

водится классификация остальных объектов ТВ.

Г. Параметры классификации. Тестовый объект Z считается правильно

классифицированным, если его метка, найденная в п. В, совпадает с мет-

кой этого объекта в подразбиении πТВ. Точность классификации определя-

ется как отношение правильно классифицированных объектов ТВ к общему

количеству объектов ТВ. При анализе алгоритма классификации в первую

очередь обращается внимание на значение точности классификации. Однако

точность классификации является лишь одним из качеств алгоритма клас-

сификации. При наличии более двух классов с сильно различающейся мощ-

ностью основную “нагрузку” при классификации может брать на себя класс

с наибольшей мощностью, и высокий процент правильной классификации

может не означать хорошей классификации объектов в классах с неболь-

шой мощностью, хотя во многих практических задачах именно такие классы

представляют особый интерес. Подобный случай рассматривается в приво-

димом ниже примере (см. раздел 7). Классификация в случае сильно несба-

лансированных выборок представляет отдельное направление в классифика-

ции, в рамках этого направления известно много публикаций. В ААК пред-

лагается использовать следующую меру ρТВ наполняемости блоков разбие-

∑K′

|C′0ν|

ния πTB = (C′1, . . . , C′K′ ): ρTB =

, где |C′0ν | - количество правиль-

ν=1 |C′ν|

но классифицированных объектов в классе C′ν . Значения показателя ρТВ

определены в интервале [0, K′]. Чувствительность меры ρТВ к наполнению

того или иного класса обратно пропорциональна мощности наполняемого

класса.

Д. Выбор значения параметра h существенным образом влияет на точ-

ность классификации в ААК, поэтому достижение «приемлемого» значения

точности классификации определяет окончательное значение h. Это - типич-

ный подход «с обратной связью» (wrapper approach). При условии, что вы-

бор значения h не зависит от метапризнаков объектов, процедура выбора h

может быть сведена к простейшему одномерному поиску [16]. При переходе

к использованию весов метапризнаков исходная задача превращается в стан-

дартную задачу классификации, которую можно решать в рамках «плоской»

модели «объекты - метапризнаки» с применением любого алгоритма класси-

фикации. Однако в данной работе используется алгоритм из [16], поскольку

он обладает рядом практически важных особенностей, обсуждаемых в раз-

деле 7.

5. Оценка вычислительной сложности предложенного алгоритма

Описанная выше процедура классификации объектов с СИП состоит из

двух последовательных частей: а) агрегирование входной информации на ОВ

147

и ТВ; б) решение задачи классификации с использованием весов метапри-

знаков. Пусть, как и ранее, N0 - размерность пространства всех субпризна-

ков. При агрегировании рассматриваются значения каждого субпризнака по

всем объектам ОВ и ТВ. Для простоты положим, что ОВ и ТВ имеют по

n объектов, тогда вычислительная сложность этапа агрегирования оценива-

ется как O(2nN0). ААК представляет собой сложный цикл, в котором для

каждого объекта ТВ рассматриваются все объекты ОВ и для каждой па-

ры объектов производится сравнение значений каждого из m соответствую-

щих весов метапризнаков на предмет их «допустимой близости». Положим,

что для определения «приемлемого» значения параметра h, определяющего

значение d(h)-близости, полный цикл ААК повторяется q раз, q ≤ m. Тогда

вычислительная сложность этапа б) оценивается как O(n2mq) или, с уче-

том того, что q ≤ m, - как O(n2m2). Для оценки всей процедуры необходимо

рассмотреть асимптотическое поведение функции nN0 + n2m2. При выполне-

нии условия N0 < nm2 с учетом замечаний, сделанных в [19], вычислительная

сложность всей процедуры оценивается как O(n2m2). Если же рассматривать

задачу классификации в рамках «плоской» модели (без агрегирования) с ис-

пользованием алгоритма из [16] , то вычислительная сложность алгоритма

классификации оценивается как O(n2N20) при условии, что N0 > qm. Таким

образом, агрегирование уменьшает вычислительную сложность задачи клас-

(N

)2

0

сификации в отношении порядка

m

6. Пример

В качестве примера, на котором демонстрируется эффективность предло-

женной процедуры классификации, использовалась выборка Dermatology из

репозитория UCI Machine Learning [15]. В этой выборке представлены резуль-

таты 34 клинических анализов (наличие сыпи или покраснений на коже, тем-

пература тела и т.п.) и гистопатологических анализов (шелушение, соскаб-

ливания, биохимия и т.п.), проведенных над 343 пациентами с целью опреде-

ления (классификации) у них тех или иных кожных заболеваний из 6 видов

возможных заболеваний. Более подробная информация о связи тех или иных

результатов анализов с конкретным видом заболевания, представляющая ин-

терес для читателя, содержится в [20, 21]6. Значения каждого из анализов у

каждого пациента определялись в единой качественной шкале (0, 1, 2, 3), где

0 означает отсутствие данного анализа у исследуемого пациента. Поскольку

тот или иной анализ в общем случае не достаточен для однозначного ука-

зания вида заболевания, предварительно исследовалась «неоднозначность»

каждого из анализов, и для каждого вида заболевания формировалось мно-

жество соответствующих анализов (без учета их значений), возможно связан-

ных с этим заболеванием. Гистограмма количества таких связей для каждого

из анализов представлена в [21]. По причинам, не относящимся к тематике

данной статьи, из исходного множества анализов были удалены анализы с

номерами 1, 2, 11, 13, 17, 18, 32, 34. Из оставшихся 26 анализов были вы-

делены 6 совокупностей анализов, каждая из которых, возможно, связана

6 В частности, в [20] более подробно указано, какие признаки и каких кожных заболе-

ваний являются клиническими, а какие - гистопатологическими.

148

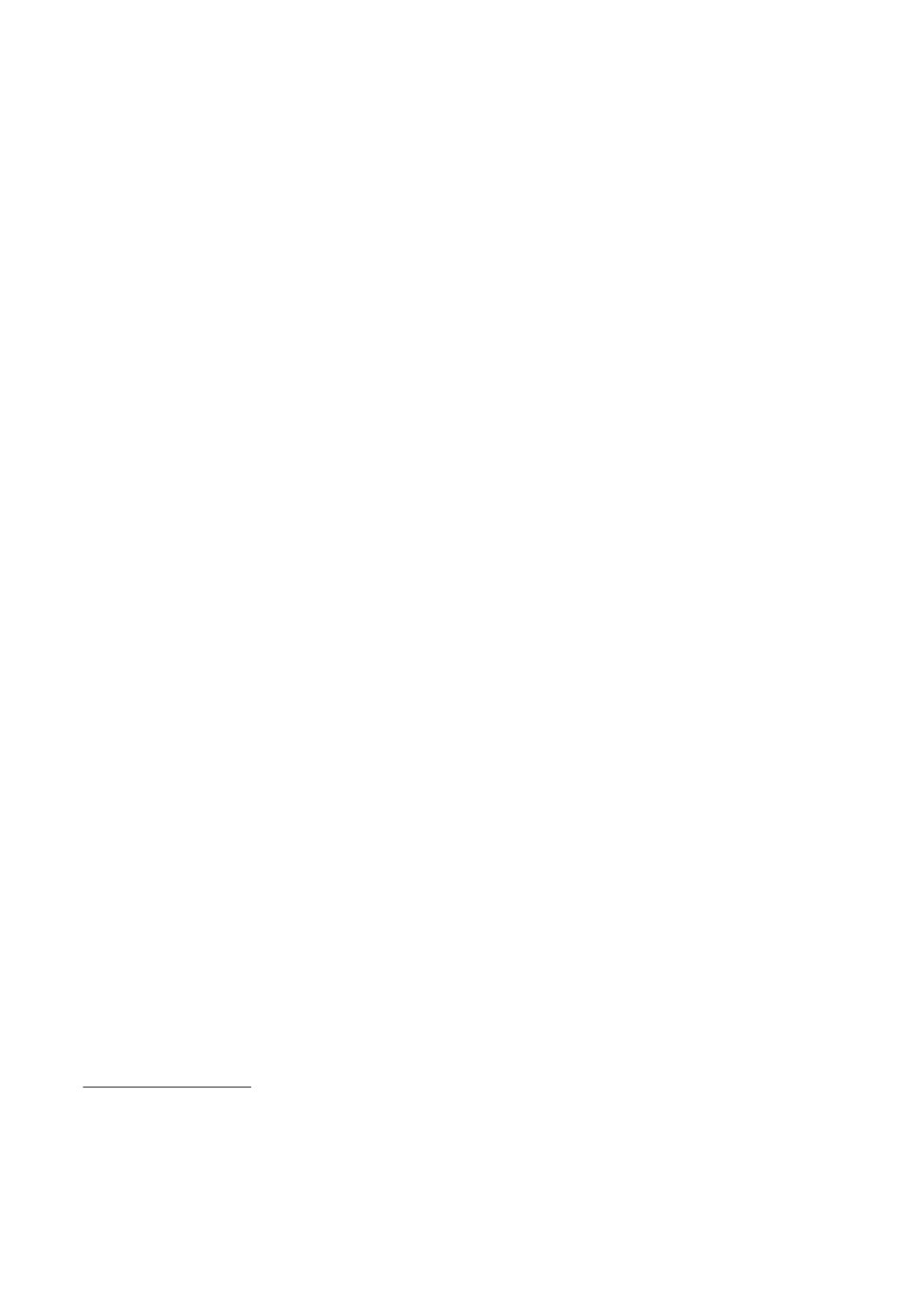

Таблица 1. Совокупности упорядоченных по «важности» анализов

для соответствующих видов заболеваний

Номер вида

Номера анализов

заболевания

1

20, 22, 21, 28, 16, 10, 9, 19, 24, 3, 26, 29, 6, 33, 12, 27

2

28, 20, 22, 5, 26, 21, 9, 24, 27, 16, 29, 6, 12, 25, 8, 33

3

33, 27, 29, 6, 12, 25, 8, 21, 14, 20, 22, 16, 9, 10, 4, 23

4

21, 9, 20, 22, 10, 28, 33, 27, 6, 12, 25, 8, 23, 29, 24, 4

5

15, 5, 14, 20, 10, 9, 22, 26, 28, 24, 27, 29, 6, 12, 25, 33

6

7, 31, 5, 22, 26, 21, 24, 30, 27, 29, 6, 12, 8, 15, 33,19

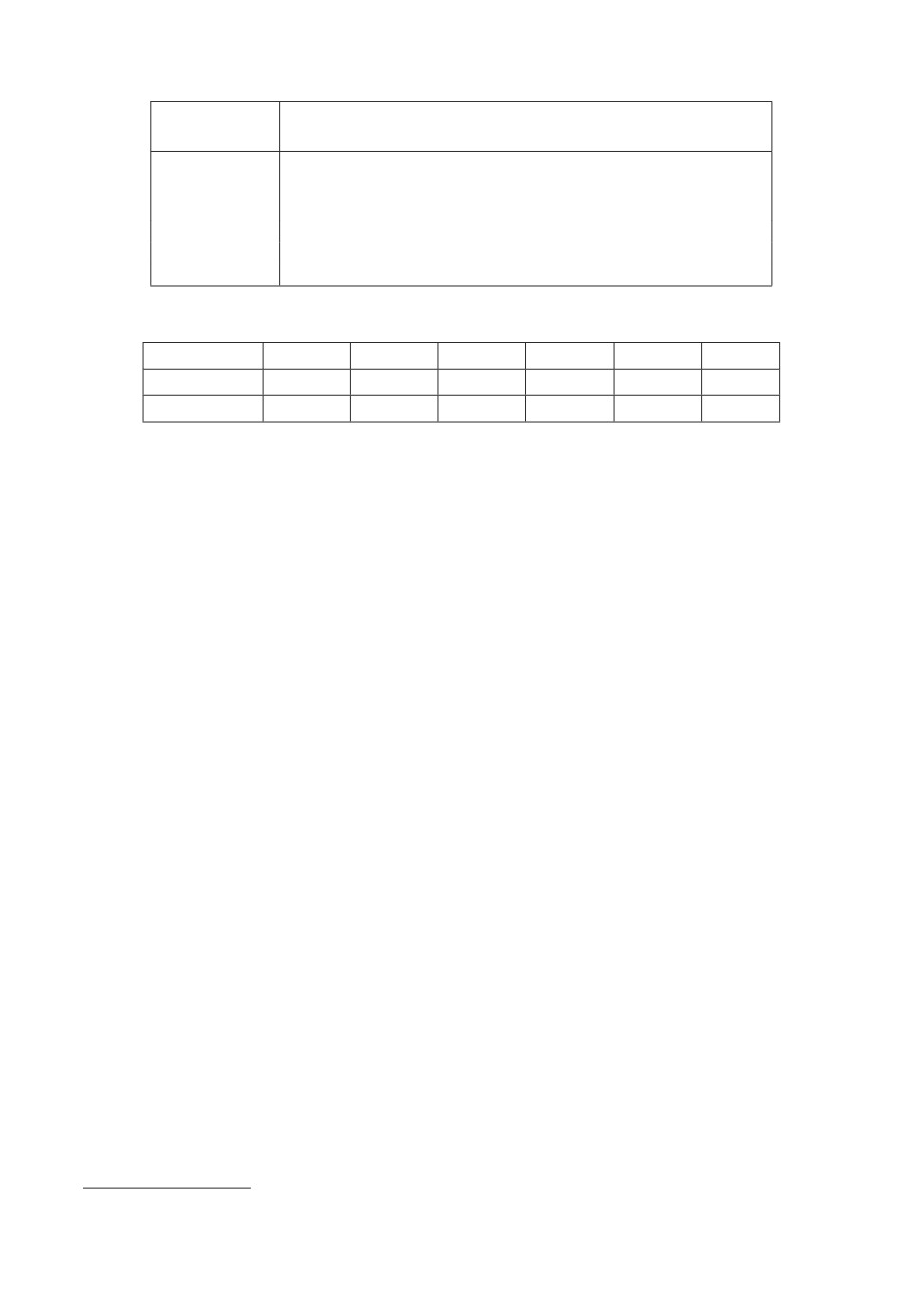

Таблица 2. Мощности классов разбиений πОВ и πТВ

πОВ

55

31

30

25

24

6

πТВ

52

29

40

24

23

4

{C′0ν}

49

24

40

23

23

3

с соответствующим видом заболевания (см. табл. 1). Анализы в каждой из

этих совокупностей упорядочивались по «важности» при отнесении их к ука-

занному виду заболевания7.

В терминах моделей с СИП все входящие в выборку Dermatology анализы

интерпретируются как субпризнаки с разными значениями для разных па-

циентов, а виды заболеваний - как метапризнаки. При этом согласно табл. 1.

тот или иной субпризнак может соответствовать нескольким метапризнакам.

Множество пациентов в выборке Dermatology можно рассматривать как вы-

борку S, в которой каждому пациенту соответствует определенная строка в

выборке S. Состояние каждого пациента характеризуется конкретной сово-

купностью ненулевых анализов. По этой совокупности с привлечением кон-

силиума врачей для каждого пациента был указан диагноз, т.е. конкретный

вид заболевания из 6 возможных видов. В терминах задачи классификации

такой диагноз интерпретируется как приписывание соответствующей метки

каждому пациенту, а совокупность таких меток на множестве пациентов -

как введение разбиения π на выборке S. При этом каждый пациент одно-

значно относится к некоторому классу Cν разбиения π, т.е. характеризуется

меткой ν. Таким образом, исходная информация вполне достаточна для при-

менения описанной выше процедуры классификации.

По исходной выборке S сформируем ОВ и ТВ путем попеременного отне-

сения очередного пациента к ОВ или ТВ и определим разбиения πОВ и πТВ

с соблюдением указанных в разделе 4.1 требований. Мощности классов этих

разбиений приведены в первых двух строках табл. 2. Видим, что ОВ и ТВ яв-

ляются несбалансированными выборками, поскольку число элементов самого

крупного блока разбиения πОВ и πТВ превышает число элементов самого мел-

кого блока более чем в 9 раз. Точность классификации ААК, описанного в

разделе 4.2 и примененного к объектам ТВ, составляет 94,7%. При этом чис-

ло правильно классифицированных объектов в каждом блоке разбиения πТВ

7 В силу агрегирования субпризнаков в моделях с СИП подобная упорядоченность далее

не используется (см. раздел 7).

149

Таблица 3. Сравнительные оценки точности классификации некоторых алгорит-

мов на выборке Dermatology

Алгоритм

«Наивный

Дерево

kNN

ЛДА

VFI5

ААК

классификации

Байес»

решений

Точность классификации (%)

97,2

98,3

96,1

98,3

96,2

94,7

представлено в третьей строке табл. 2, а определенный в разделе 4.2 коэф-

фициент ρТВ заполнения блоков разбиения πТВ равен 5,47, что говорит о

хорошем качестве заполнения блоков разной мощности8. В табл. 3 приведе-

ны заимствованные из [21] данные о точности классификации на ТВ9 ря-

да известных алгоритмов (в том числе алгоритма VFI5, описанного в [20],

и ААК), в которых использовались 6 множеств признаков, приведенных в

табл. 1. Сокращенные названия алгоритмов в табл. 3: kNN - некоторый алго-

ритм из семейства kNN-алгоритмов, базирующихся на понятии «ближайшей

окрестности», а ЛДА - линейный дискриминантный анализ. Согласно табл. 3

точность классификации ААК несколько меньше, чем в приведенных алго-

ритмах, однако ААК обладает рядом положительных качеств при решении

практических задач, эти качества обсуждаются в разделе 7.

7. Практически важные особенности ААК

Обсуждаемые ниже особенности ААК включают: 1) качество классифика-

ции на существенно несбалансированных выборках; 2) уменьшение размерно-

сти множества данных на этапе классификации; 3) ослабление контекстной

зависимости модальностей субпризнаков в ААК.

1. Качество классификации ААК на существенно несбалансированных вы-

борках. Если исходная выборка является существенно несбалансированной

выборкой (как в приводимом выше примере), то высокая точность классифи-

кации в целом может не означать хорошей классификации объектов в классах

с небольшой мощностью. Поясним эту мысль на приведенном выше примере.

Здесь ААК обеспечил неплохое качество заполнения наименьшего блока C6

разбиения πТВ, классифицировав правильно три объекта из четырех. Непло-

хое качество заполнения мелких блоков показал и исходный алгоритм ав-

тора [16] на ряде существенно несбалансированных выборок из репозитория

UCI Machine Learning. Это свойство исходного алгоритма и ААК допускает

следующее объяснение.

Общий подход к построению алгоритмов классификации (supervised) со-

стоит в том, что каждому объекту из ОВ «навешивается» метка класса задан-

ного разбиения πОВ, и далее этим меткам приписываются веса, вычисляемые

тем или иным образом. Поскольку при каждом разбиении исходной выбор-

ки на ОВ и ТВ в каждой из них - конечное число объектов, каждой метке

класса при каждом разбиении соответствует некоторое конечное множество

8 Это же свойство алгоритма, описанного в [16], проявлялось и при рассмотрении ряда

сильно несбалансированных выборок из репозитория UCI Machine Learning.

9 Как сказано в [21], ОВ и ТВ составляли по 50% исходной выборки Dermatology.

150

объектов исходной выборки с точечными значениями признаков10. Посколь-

ку точность классификации на конкретной выборке зависит от количества

объектов в ОВ и ТВ, для обоснования результирующей точности классифи-

кации используют разные процедуры разбиений (butstrap, boosting и т.п.).

Однако в таких процедурах каждой метке будет соответствовать другое, но

конечное множество признаков с точечными значениями. Отличие алгорит-

ма из работы

[16] и ААК от известных алгоритмов состоит в том, что для

всякого значения количественного или качественного признака из ТВ зада-

ется непрерывная окрестность «допустимо близких» к нему значений этого

же признака из ОВ. (см. раздел 4.2, п. Д). При этом каждой метке будет

соответствовать результирующее конечное множество интервалов значений

этого признака. Поскольку проблема построения алгоритма с оптимальным

значением точности классификации в классе обычно используемых выборок

является, как известно, NP -полной, о превосходстве того или иного подхода

к построению алгоритма можно судить лишь по полученным результатам на

используемом множестве выборок.

В приводимом выше примере ААК позволяет вместо значений 26 каче-

ственных признаков рассматривать 6 весов метапризнаков как значений ис-

пользуемых функций агрегирования. Совокупность классов на ТВ, содер-

жащей 171 объект, имеет вид (см. табл. 2): C1 = 52, . . . , C6 = 4, т.е. число

элементов в максимальном блоке превышает число элементов в минималь-

ном блоке более чем в 13 раз). Точность классификации ААК на ТВ равна

94,7%. Заметим, что правильная классификация каждого из трех объектов

блока C6 «забирает» 100(3 : 171 ) ≈ 1,7% от полной точности классификации.

Согласно табл. 3 максимальная точность классификации двух известных ал-

горитмов классификации («Наивный Байес» и Дерево решений) на той же

ТВ равна 98,3%. Отсюда следует, что такая точность классификации каж-

дого из этих алгоритмов может быть достигнута и при полном «игнорирова-

нии» блока C6 вместе с правильной классификацией объектов в остальных

блоках ТВ, поскольку 100% - 1,7% ≈ 98,3% (это тем более справедливо для

остальных алгоритмов из табл. 3). При этом согласно табл. 2 ААК правильно

классифицирует 3 из 4 элементов в блоке C6.

2. Уменьшение размерности множества данных на этапе классификации.

В силу агрегирования субпризнаков в каждом из множеств, семантически

связанных с соответствующими метапризнаками, размерность множества

(N

)2

0

значений m функций агрегирования уменьшается в

раз по сравнению

m

с размерностью N0 множества субпризнаков.

3. Ослабление контекстной зависимости модальностей субпризнаков в

ААК. Во многих практических задачах (особенно в медицине) значения суб-

признаков на ОВ и ТВ определяются приближенно (в качественных шкалах),

что имеет место и в рассмотренном выше примере. В то же время известно,

что такой популярный подход как построение дерева решений крайне чув-

ствителен к возмущениям значений признаков из ОВ. Теоретический анализ

качества алгоритмов классификации (supervised) в рамках статистического

10 Особняком здесь стоит алгоритм VFI5, описанный в [20], в котором для каждой метки

вычисляются интервалы значений каждого признака объектов из ОВ.

151

подхода представлен в работе [22] в предположении, что вероятностные рас-

пределения значений признаков статистически эквивалентны на ОВ и ТВ.

Однако это предположение, как правило, не выполняется в практических за-

дачах (в частности, в приводимом выше примере). В устройствах обработки

информации с помехами для повышения помехоустойчивости давно применя-

ется агрегирование, реализуемое на сумматорах различных видов. При этом,

как правило, не обращается внимание на модальности агрегируемых сигна-

лов.

Во многих практических задачах модальность признака зависит от его

значений, при этом понятие модальности становится контекстно зависимым

(context sensitive). Нормализация субпризнаков и их последующее агрегиро-

вание в каждом из множеств Gij позволяет несколько уменьшить взаимо-

влияния субпризнаков в множествах Gij . Поскольку и нормализация, и аг-

регирование проводятся для тех же субпризнаков в ТВ, распределения мо-

дальностей субпризнаков в соответствующих множествах Gij и G′ij могут не

совпадать, как и значения соответствующих весов wij и w′ij. Наличие меток

разбиения πОВ на субпризнаках из ОВ «удаляет» эту проблему, так как всем

субпризнакам из множества Gij , относящегося к объекту Oi с меткой ν, при-

писывается метка ν (как и всему вектору весов Wi = {wij }, j = 1, . . . , m, и

приписывание другой метки μ весу w′ij зависит лишь от «допустимой бли-

зости» веса w′ij к wij. Таким образом, наличие известного разбиения на ОВ

является очень важной «подсказкой» при построении алгоритмов классифи-

кации для моделей с СИП.

И еще одно важное замечание относительно упорядочения анализов по

«важности» в строках табл. 1. Можно заметить, что и в [20], где подробно

описывается алгоритм VFI5, и тем более в ААК не используется такое упо-

рядочение. Оно крайне важно лишь на этапе выработки исходного диагноза

для каждого пациента, и становится ненужным на этапе классификации, ко-

гда метка для каждого пациента уже определена. Подобный процесс упоря-

дочения анализов по «важности» довольно сложный и ответственный, тогда

как наличие исходных меток на объектах выборки существенно упрощает

применение алгоритмов классификации.

8. Заключение

Описанная в настоящей статье процедура классификации объектов с СИП

предусматривает выполнение двух необходимых условий:

- функции агрегирования не нарушают исходных семантических связей

субпризнаков с метапризнаками, к которым они относятся;

- нормализующие множители для субпризнаков из соответствующих мно-

жеств Gij и G′ij в ОВ и ТВ совпадают.

Несмотря на простоту иерархии моделей с СИП, практические особенности

процедуры классификации объектов с СИП, приведенные в разделе 7, поз-

воляют применять эту процедуру для проведения классификации во многих

многомерных задачах, в которых понятия семантической связи и модально-

сти переменных имеют существенное значение (в частности, в медицинских,

финансовых и социальных задачах).

152

СПИСОК ЛИТЕРАТУРЫ

1.

Borges H.B., Silla C.N., Nievola J.C. An evaluation of global-model hierarchical

classification algorithms for hierarchical classification problems with single path of

labels // Comp. Math. Appl. 2013. V. 66. P. 1991-2002.

2.

3.

Motik B., Maedche A., Volz R. A Conceptual Modeling Approach for Semantics-

Driven Enterprise Applications // Proc. Meaningful Internet Syst. 2002. P. 1082-

4.

Albaradei S., Wang Y. Object Classification Using a Semantic Hierarchy //

5.

Fatimaezzahra M., Abdelaziz E., Mohamed S., Loubna B. Towards Domain Ontology

Creation Based on a Taxonomy Structure in Computer Vision // Int. J. Adv.

Comput. Sci. Appl. (IJACSA). 2016. V. 7. No. 2. P. 28-43.

6.

Wang Y., Halper M., D. Wei D., Perl Y., Geller J. Abstraction of complex concepts

with a refined partial-area taxonomy of SNOMED // J. Biomed. Inform. 2012. V. 45.

7.

Ciaramita M., Hofmann T., Johnson. M. Hierarchical Semantic Classification: Word

faa4/a19f4edd1d97a09

8.

Deng W.-Y., Liu D., Dong Y.-Y. Feature Selection and Classification for High-

Dimensional Incomplete Multimodal Data // Math. Probl. Eng. 2018. V. 2018.

9.

Fernandez M.J., Eastman C.M. Basic Taxonomic Structures and Levels of

Abstraction // Proc. 1st ASIS SIG/CR Classif. Res. Workshop. 1990. P. 59-70.

10.

Verma N., Mahajan D., Sellamanickam D., Nair V. Learning Hierarchical Similarity

11.

Bettencourt L.M.A. The Rules of Information Aggregation and Emergence

of Collective Intelligent Behavior // onlinelibrary.wiley.com/doi/10.1111/j.1756-

8765. . . /full

12.

13.

Bengio Y., Paiement J.-F., Vincent P., Delalleau O., Le Roux N., Ouimet M. Out-

of-Sample Extensions for LLE, Isomap, MDS, Eigenmaps, and Spectral Clustering.

14.

Hua Y. Cross-Modal Correlation Learning by Adaptive Hierarchical Semantic //

15.

Machine Learning Repository // archive.ics.uci.edu/ml/datasets.html

16.

Корноушенко Е.К. Алгоритм классификации путем парного сравнения призна-

ков // АиТ. 2017. № 11. С. 151-166.

Kornoushenko E.K. Classification Algorithm Based on Pairwise Comparison of

Features // Autom. Remote Control. 2017. V. 78. No. 11. P. 2062-2074.

17.

Magimai.-Doss M., Hakkani-Tür D., Cetin O., Shriberg E., Fung J., Mirghafori N.

Entropy-based C;assifier Combimation for Sentence Segmentation //

153

18. Воронцов К.В. Комбинаторный подход к оценке качества обучаемых алгорит-

мов / Математические вопросы кибернетики. Под ред. О.Б. Лупанова. Т. 13. М.:

Физматлит, 2004. С. 5-36.

19. Zindros D. A Gentle Introduction to Algorithm Complexity Analysis //

20. Govenir H.A., Demiroz G., Ilter N. Learning differential diagnosis of erythemato-

squamous diseases using voting feature intervals // Artif. Intelligence Medicin. 1998.

V. 13. P. 147-165.

21. El-Baz A.H. Filter Based Feature Selection for Automatic Detection of Erythemato-

squamous Diseases // British J. Math. Comput. Sci. 2015. V. 9. No. 5. P. 394-406.

22. Schain M. Machine Learning Algorithms and Robustness // Diss. Phd. Tel-Aviv.

Статья представлена к публикации членом редколлегии О.П. Кузнецовым.

Поступила в редакцию 04.04.2018

После доработки 20.12.2018

Принята к публикации 07.02.2019

154