Автоматика и телемеханика, № 12, 2020

Тематический выпуск1

© 2020 г. В.М. АЗАНОВ, канд. физ.-мат. наук (azanov59@gmail.com)

(Московский авиационный институт)

ОПТИМАЛЬНОЕ УПРАВЛЕНИЕ ДИСКРЕТНОЙ СТОХАСТИЧЕСКОЙ

СИСТЕМОЙ С ВЕРОЯТНОСТНЫМ КРИТЕРИЕМ И

НЕФИКСИРОВАННЫМ ВРЕМЕНЕМ ОКОНЧАНИЯ2

Рассматривается задача оптимального управления дискретной стоха-

стической системой с критерием в форме вероятности первого достиже-

ния границ заданной области. Формулируются и доказываются достаточ-

ные условия оптимальности в форме метода динамического программи-

рования. С помощью поверхностей уровней 1 и 0 функции Беллмана на-

ходятся двусторонние оценки функции правой части уравнения метода

динамического программирования, функции Беллмана и функции опти-

мального значения вероятностного критерия, и предлагается способ по-

строения субоптимального управления. Формулируются условия эквива-

лентности с задачей оптимального управления с вероятностным терми-

нальным критерием. Рассматривается пример.

Ключевые слова: дискретные системы, стохастическое оптимальное

управление, вероятностный критерий, метод динамического программи-

рования, функция Беллмана.

DOI: 10.31857/S0005231020120016

1. Введение

Одним из важнейших направлений исследований в области стохастическо-

го оптимального управления являются задачи с нефиксированным моментом

остановки. Среди них отдельно выделяют задачу стохастического быстродей-

ствия [1, 2], задачу с бесконечным горизонтом управления [3-6], задачу оп-

тимизации времени пребывания системы в заданной трубке траекторий [1, 7]

и задачу оптимизации момента первого достижения границ заднной обла-

сти [1, 8, 9]. Модели управления с нефиксированным моментом остановки

имеют широкое применение в авиационной [10], экономической [11], биоло-

гической, робототехнической и энергетической [1] областях. В случае систем

с непрерывным временем известность получили методы, основанные на до-

статочных условиях оптимальности в форме метода динамического програм-

мирования, позволяющие искать оптимальные стратегии в классе позицион-

ных. Интересно, что использование именно вероятностного критерия [1, 7]

1 Статьи данной рубрики являются окончанием тематического выпуска, посвященного

В.С. Пугачеву (№ 11, 2020).

2 Работа выполнена при поддержке Российского фонда фундаментальных исследований

(проект № 18-08-00595).

3

приводит к конструктивной форме постановки задач управления с нефикси-

рованным временем, для которой удается записать уравнение Беллмана. Тем

не менее до сих пор существует ряд принципиальных проблем численного

поиска оптимального управления, а аналитические решения получены лишь

для ряда модельных задач [1]. Это обстоятельство связано со следующими

трудностями: решение уравнения Беллмана может быть не единственным;

даже если решение уравнения Беллмана существует в классе гладких функ-

ций, оно может быть недопустимым (например, потому что при нем может не

существовать сильного решения уравнения стохастической системы в форме

Ито); в классе допустимых управлений не всегда существует такое, при кото-

ром достигается точная грань критерия; уравнение Беллмана связано с так

называемым “проклятьем размерности”.

В случае дискретного времени качественная теория подобных задач изло-

жена в [3]. Известны решения отдельных задач экономики [11] и модельных

примеров [9]. В [9] была рассмотрена задача оптимизации вероятности пер-

вого достижения окрестности нуля траекториями линейной стохастической

системы в канонической форме управляемости Бруновского. С помощью ее

сведения к задаче с вероятностным терминальным критерием и дальнейшим

использованием метода динамического программирования в форме [12] было

найдено ее аналитическое решение.

В настоящей статье исследуется задача оптимального управления дискрет-

ной стохастической системой с критерием вероятности первого достижения

ее траекториями заданной трубки. Исследуются достаточные условия опти-

мальности, схожие с [12], и свойства двусторонних границ функции Белл-

мана [13, 14]. Находятся условия эквивалентности с задачей оптимального

управления с вероятностным терминальным критерием [12]. В качестве при-

мера рассматривается задача управления портфелем ценных бумаг.

2. Постановка задачи

Рассмотрим стохастическую систему с дискретным временем

{

xk+1 = fk (xk,uk,ξk) ,

(1)

k = 0,N,

x0 = X,

где xk ∈ Rn вектор состояния, uk ∈ Uk ⊂ Rm - вектор управления, Uk - мно-

жество ограничений на управление, ξk - вектор случайных возмущений со

значениями на Rs и известным распределением Pξk , fk : Rn × Rm × Rs → Rn -

функция перехода (функция системы), N ∈ {0} ∪ N горизонт управления.

В отношении системы (1) введем п р е д п о л о ж е н и я:

1. Известна полная информация о векторе состояния xk (данный факт

позволяет строить управление в классе функций uk = γk (xk), где γk (·)

некоторая измеримая функция). В данном случае говорят, что “управление

ищется в классе полной обратной связи по состоянию”;

2. Начальное состояние x0 = X является детерминированным вектором

из Rn;

3. Функция системы fk (xk, uk, ξk) непрерывна для всех k;

4

4. Вектор управления uk формируется следующим образом: uk = γk (xk),

где γk : Rn → Rm

- измеримая функция с ограниченными значениями

uk ∈ Uk, причем Uk компактное множество;

5. Вектор состояния xk+1 формируется следующим образом: на шаге k

реализуется вектор xk, далее формируется вектор управления uk = γk (xk) и

в последнюю очередь реализуется случайное возмущение ξk;

6. Управлением называется набор функций u (·) = (γ0 (·) , . . . , γN (·)) ∈ U,

классом допустимых управлений называется множество U = U0 × . . . × UN ,

где Uk множество борелевских функций γk (·) с ограниченными на Uk зна-

чениями;

7. Случайный вектор ξk является непрерывным с значениями в Rs и из-

вестным распределением Pξk , причем компоненты вектора ζ = (X, ξ0, . . . , ξN )

независимы.

Заметим, что система (1) является марковской, т.е. ее поведение в будущем

не зависит от прошлого и полностью определяется текущим состоянием.

На траекториях системы (1) определим функционал вероятности

(

)

⋃

P (u (·)) = P

{xk+1 ∈ Fk+1}

,

k=0

множества Fk имеют вид

{

Fk = {x ∈ Rn : Φk (x) ≤ ϕ} , k = 1,N + 1,

F0 = Rn,

где ϕ ∈ R

известный скаляр, Φk : Rn → R

непрерывные функции,

k = 1,...,N + 1, причем ΦN+1 (x) ограничена снизу.

Рассматривается задача

(2)

P (u(·)) → max ,

u(·)∈U

где U = U0 × . . . × UN .

Физически задача (2) заключается в поиске управления, максимизирую-

щего вероятность первого достижения трубки траекторий, заданной в виде

последовательности множеств {Fk+1}Nk=0.

Отметим, что метод динамического программирования в форме [12], сфор-

мулированный для задач оптимального управления с вероятностным терми-

нальным критерием, неприменим в общем случае к задаче (2). В разделе 3

устанавливаются достаточные условия оптимальности в форме метода дина-

мического программирования, схожие с [12].

3. Метод динамического программирования и

двусторонние оценки функции Беллмана

Определим функцию Беллмана Bk : Rn → [0, 1] в задаче (2) как

(

)

Bk (x) =

sup

P min Φi+1 (xi+1) ≤ ϕxk = x

γk(·)∈Uk,...,γN (·)∈UN

i=k,N

5

Принимая во внимание сделанные в разделе 2 предположения, cформулируем

теорему об уравнении Беллмана для задачи (2) в пространстве состояний

размерности n.

Теорема 1. Пусть выполнены условия:

1) функции fk (xk, uk, ξk) непрерывны для всех k = 0, N ;

2) функции Φk (xk) непрерывны для всех k = 1, N + 1;

3) функция ΦN+1 (xN+1) ограничена снизу;

4) случайные векторы X, ξ0, . . . , ξN независимы;

5) множества U0, . . . , UN компактны.

Тогда оптимальное управление в задаче (2) существует в классе изме-

римых функций u∗ (·) ∈ U и определяется в результате решения следующих

задач:

γ∗k (x) = arg max Mξ

(3)

[IFk (x) + (1 - IFk (x)) Bk+1 (fk (x, u, ξk

))] ,

k

u∈Uk

(4)

Bk (x) = max Mξk [IFk (x) + (1 - IFk (x)) Bk+1 (fk (x,u,ξk

))] , k = 0, N ,

u∈Uk

(5)

BN+1 (x) = IFN+1

(x) .

Доказательства теоремы 1, всех последующих теорем, утверждений и ле-

мы приведены в Приложении.

В теореме 1 Mξk [·] оператор математического ожидания по распреде-

лению Pξk случайного вектора ξk, а IFk (x) индикаторная функция мно-

жества Fk. Заметим, что соотношения (3)-(5) отличаются от классического

уравнения Беллмана [12] в задаче с вероятностным терминальным критерием

наличием в правой части дополнительного слагаемого IFk (x) и множителя

1 - IFk (x) под оператором математического ожидания.

Как известно, прямое интегрирование уравнения Беллмана связано с труд-

ностями вычислений кратных интегралов и решения задач стохастического

программирования в его правой части. Указанные трудности неоднократ-

но проявлялись даже для систем простейшего вида, например для системы

управления портфелем ценных бумаг [15-17] и для системы управления ста-

ционарным спутником [12]. Вследствие этого на протяжении почти двадцати

лет задачи оптимального управления с вероятностным критерием рассмат-

ривались в одношаговой N = 0 и двухшаговой N = 1 постановках [15-17].

В [13, 14] с использованием поверхностей уровня 1 и 0 были найдены дву-

сторонние границы функции Беллмана, что позволило получить решение от-

дельных задач оптимального управления с вероятностным критерием для

произвольного шага по времени N.

По аналогии с [13, 14] исследуем свойства функции Беллмана для зада-

чи (2) с помощью поверхностей уровня 1 и 0 функции Беллмана.

4. Двусторонние границы функции Беллмана

Введем в рассмотрение поверхности уровней 1 и 0 функции Беллмана

Ik = {x ∈ Rn : Bk (x) = 1} , Ok = {x ∈ Rn : Bk (x) = 0}

6

и множество Bk = Rn \ {Ik ∪ Ok}. Для удобства введем обозначение Fk =

= Rn \ Fk. Нетрудно видеть, что из определения введенных множеств вы-

полнено, что

Bk (x) = 1,

x∈Ik,

Ik ∪ Bk ∪ Ok = Rn,

Bk (x) ∈ (0,1) ,

x∈Bk,

Bk (x) = 0,

x∈Ok.

Теорема 2. Справделивы утверждения:

1. Множества Ik, k = 0, N , удовлетворяют рекуррентным соотношени-

ям в обратном времени

Ik = Fk ∪ {x ∈ Rn : ∃u ∈ Uk : Pξ

(fk (x, u, ξk) ∈ Ik+1) = 1} , k = 0, N ,

k

IN+1 = FN+1;

2. Множества Ok, k = 0, N , удовлетворяют рекуррентным соотношени-

ям в обратном времени

Ok = Fk ∩ {x ∈ Rn : ∀u ∈ Uk : Pξ

(fk (x, u, ξk) ∈ Ok+1) = 1} , k = 0, N ,

k

ON+1 = FN+1;

3. Для x ∈ Ik функция γ∗k(x) принимает любое значение из множества

UIk(x)

(6)

UIk (x) = {u ∈ Uk : Pξ

(fk (x, u, ξk) ∈ Ik+1) = 1};

k

4. Для x ∈ Ok функция γ∗k (x) принимает любое значение из множества

Uk;

5. Уравнение Беллмана в области x ∈ Bk допускает представление

{

(7) Bk (x) = max Pξk (fk (x, u, ξk) ∈ Ik+1) +

u∈Uk

[

]}

+ Pξk (fk (x,u,ξk) ∈ Bk+1)Mξk Bk+1 (fk (x,u,ξk))

fk (x,u,ξk) ∈ Bk+1

;

6. Для x ∈ Bk и u ∈ Uk справедлива система неравенств

Pξk (fk (x, u, ξk) ∈ Fk+1) ≤ Pξk (fk (x, u, ξk) ∈ Ik+1) ≤

(8)

≤ Mξk [Bk+1 (fk (x,u,ξk))] ≤ 1 - Pξk (fk (x,u,ξk) ∈ Ok+1);

7. Для x ∈ Bk функция Беллмана удовлетворяет двустороннему неравен-

ству

(9)

Ψk (x) ≤ Bk (x) ≤ Bk (x) ≤ Bk

(x),

где

(10)

Ψk (x) = sup Pξk (fk (x,u,ξk) ∈ Fk+1

),

u∈Uk

7

Bk (x) нижняя, а Bk (x) верхняя оценки функции Беллмана

Bk (x) = sup Pξk (fk (x,u,ξk) ∈ Ik+1) ,

u∈Uk

Bk (x) = sup {1 - Pξk (fk (x,u,ξk) ∈ Ok+1)} ,

u∈Uk

причем BN (x) = BN (x) = BN (x).

Отличием правой части соотношений п. 1 теоремы 2 от соотношений для

поверхности уровня 1 функции Беллмана в задаче с терминальным вероят-

ностным критерием [18] является наличие операции объединения с множе-

ством Fk. Для поверхности уровня 0 функции Беллмана отличие заключа-

ется в наличии операции пересечения с множеством Fk. Пункты 3 и 4 уста-

навливают простейшие (относительно (3)) выражения для определения опти-

мального управления при xk ∈ Ik ∪ Ok, которые с точностью до конструкций

множеств Ik совпадают с аналогичными в задаче с терминальным вероят-

ностным критерием. Пункты 6 и 7 теоремы 2 устанавливают двусторонние

оценки функции правой части уравнения динамического программирования

и функции Беллмана соответственно. При этом выражения для нижних и

верхних границ с точностью до конструкций множеств Ik и Ok совпадают

с аналогичными в задаче с терминальным критерием [13, 18]. Отличием же

является наличие дополнительного неравенства в левой части (8) и, как след-

ствие, неравенства Ψk (x) ≤ Bk (x).

Исследуем детально свойства стратегии, максимизирующей на каждом

шаге нижнюю границу функции правой части уравнения динамического про-

граммирования.

5. Субоптимальная стратегия

(

)

Определим стратегию u (·) = γ0 (·) , . . . , γN (·) , где

(11)

γk (x) = arg max Pξk (fk (x,u,ξk) ∈ Ik+1), k = 0,N.

u∈Uk

Данная стратегия обладает следующими с в о й с т в а м и:

• При x ∈ Ik ∪ Ok для всех k = 0, N выполнено равенство γ

(x) = γ∗k (x);

k

• Для k = N выполнено равенство γk (x) = γ∗k (x);

• Из Fk = Ik для всех k = 0, N следует γk (x) = γ∗k (x).

Теорема 3. Пусть стратегия u(·) существует в классе U. Тогда спра-

ведливы утверждения:

1. Значение вероятностного критерия на стратегии u (·) имеет вид

P (u (·)) = F (ϕ, N, X) +

(

) (

)

∑

⋂

⋃

⋂

{

}

+ P

{xk ∈ Ik} P

xk+1 ∈ Ik+1

{xk ∈ Ik}

+

(12)

l=1

k=1

k=0

k=1

(

) (

)

⋂

⋃

{

}

⋂

+P

{xk ∈ Ik} P

xk+1 ∈ Fk+1

{xk ∈ Ik}

,

k=1

k=0

k=1

8

где xk

траектория системы, замкнутой управлением (11)

{

xk+1 = fk (xk,uk,ξk) ,

k = 0,N,

x0 = X,

где uk = γ

(xk);

k

2. Оптимальное значение вероятностного критерия имеет вид

P (u∗ (·)) = F (ϕ, N, X) +

(

) (

)

∑

⋂

⋃

{

}

⋂

+ P

{x∗k ∈ Ik} P

x∗k+1 ∈ Ik+1

{x∗k ∈ Ik}

+

(13)

l=1

k=1

k=0

k=1

(

) (

)

⋂

⋃

{

}

⋂

+P

{x∗k ∈ Ik} P

x∗k+1 ∈ Fk+1

{x∗k ∈ Ik}

,

k=1

k=0

k=1

где x∗k

траектория системы, замкнутой оптимальным управлением

{

x∗k+1 = fk (x∗k,u∗k,ξk) ,

k = 0,N,

x∗0 = X,

где u∗k = γ∗k (x∗k);

3. Для любых ϕ ∈ R, N ∈ N, X ∈ Rn справедлива система неравенств

(14)

FF (ϕ,N,X) ≤ F (ϕ,N,X) ≤ P (u (·)) ≤ P (u∗

(·)) ≤ F (ϕ, N, X) ,

где функции

FF : R × N × Rn → [0,1] , F : R × N × Rn → [0,1] , F : R × N × Rn → [0,1]

имеют вид

FF (ϕ,N,X) = Ψ0 (X) , F (ϕ,N,X) = B0 (X) , F (ϕ,N,X) = B0 (X) .

Из теоремы 3 можно получить оценку качества субоптимальной страте-

гии (11) u (·)

P (u∗ (·)) - P (u (·)) ≤ Δ (ϕ, N, X) ,

справедливую для всех

ϕ ∈ R, N ∈ {0} ∪ N, X ∈ Rn,

где функция Δ : R × N × Rn → [0, 1] имеет вид

Δ(ϕ,N,X) = F (ϕ,N,X) - F (ϕ,N,X) -

(

) (

)

∑

⋂

⋃

{

}

⋂

− P

{xk ∈ Ik} P

xk+1 ∈ Ik+1

{xk ∈ Ik}

-

(15)

l=1

k=1

k=0

k=1

(

) (

)

⋂

⋃

{

}

⋂

−P

{xk ∈ Ik} P

xk+1 ∈ Fk+1

{xk ∈ Ik}

k=1

k=0

k=1

9

Исследуем условия эквивалентности задачи (2) и задачи оптимального

управления с вероятностным терминальным критерием.

6. Условия эквивалентности с задачей оптимального управления

с вероятностным терминальным критерием

Рассмотрим вероятностный терминальный критерий на траекториях си-

стемы (1)

(16)

Pϕ (u(·)) = P(xN+1 ∈ FN+1) = P(ΦN+1 (xN+1

) ≤ ϕ)

и задачу оптимального управления

(17)

Pϕ (u(·)) → max .

u(·)∈U

Согласно [12] решение задачи (17) существует в классе U и определяется в

результате решения уравнений динамического программирования

[

]

(18)

γϕk (x) = arg max Mξ

Bϕk+1 (fk (x,u,ξk))

,

k

u∈Uk

[

]

(19)

Bϕk (x) = max Mξ

Bϕk+1 (fk (x,u,ξk))

,

k = 0,N,

k

u∈Uk

(20)

BϕN+1 (x) = IF

(x) ,

N+1

где Bϕk (x) - функция Беллмана в задаче (17).

Сформулируем утверждение об эквивалентности задач (2) и (17).

Лемма. Пусть для всех k = 0,N выполнено Fk ⊆ ΔIk, где

(21)

ΔIk = {x ∈ Rn : ∃u ∈ Uk : P(fk (x,u,ξk) ∈ Ik+1) = 1}.

Тогда задача (3) эквивалентна задаче оптимального управления с вероят-

ностным терминальным критерием (17) в смысле равенства оптимальных

стратегий u∗ (·) = uϕ (·), оптимальных значений критериев P (u∗ (·)) =

= Pϕ (uϕ (·)) и равенства для всех k = 0,N + 1 и x ∈ Rn функций Белл-

мана Bk (x) = Bϕk (x).

Отметим, что из леммы для узкого класса систем можно получить более

конкретные условия эквивалентности задач (2) и (17), однако это не является

целью данной статьи.

Применим полученные результаты для исследования дополнительных

свойств задачи оптимального управления портфелем ценных бумаг с веро-

ятностным критерием.

7. Управление портфелем ценных бумаг с

нефиксированным временем окончания

Рассмотрим дискретную стохастическую систему управления вида [13, 19]

∑

,

xk+1 = xk 1 + bu1k + ujkξj-1k

(22)

k = 0,N,

j=2

x0 = X,

10

где n = 1, m и s = m - 1 размерности векторов состояния, управления

и случайных возмущений соответственно, X > 0, b > -1, ϕ < 0 детерми-

(

)T

нированные скаляры, ξk =

ξ1k,... ,ξm-1k

случайные векторы с незави-

симыми компонентами, причем ξk+1 и ξk являются независимыми для всех

k = 0,N - 1. Пусть ограничения на управления заданы в виде

∑

Uk = U =

u∈Rm :

uj = 1, uj ≥ 0, ∀j = 1,m

,

k = 0,N.

j=1

Предположим, что носитель распределения случайных векторов ξk имеет вид

⊗

[

]

suppρξ (t) =

εj,εj

, причем ∀j = 1, m - 1 выполнено -1 ≤ εj ≤ b ≤ εj.

j=1

Рассмотрим задачу оптимального управления с нефиксированным време-

нем

(

)

(23)

P min {-xk+1} ≤ ϕ

→ sup

k=0,N

u(·)∈U

и задачу с вероятностным терминальным критерием

(24)

P(-xN+1 ≤ ϕ) → sup .

u(·)∈U

В обозначениях, введенных в статье, имеем:

∑

Fk = F = [-ϕ,+∞), Φk (x) = -x, fk

(x,u,ξ) = x1+bu1 + ujξj-1.

j=2

Если за X принять размер стартового капитала, за xk - размер капитала

на начало k-го года, за u1k - долю xk капитала, вкладываемого в безрисковый

актив (например, в надежный банк), имеющий доходность b, ujk - доли ка-

питала, вкладываемые в рисковые активы, характеризующиеся доходностя-

ми ξj-1k, j = 2, m, то задача (23) заключается в максимизации вероятности

достижения размера капитала уровня (-ϕ) за время, ограниченное сверху

величиной N + 1, а задача (24) за время N + 1 путем инвестиций в неко-

торые активы.

Задача (24) рассматривалась в двухшаговой постановке N = 1 для слу-

чая одного рискового актива m = 2 в [15, 16]. В [13] был найден целый класс

асимптотически оптимальных (при N → ∞) стратегий. Задача (23) рассмат-

ривается впервые.

Воспользуемся результатами настоящей статьи и проверим условия экви-

валентности задач (23) и (24).

Утверждение 1. Для всех k = 0,N выполнены равенства

[

)

(

)

(

]

Ik = ΔIk =

ϕIk , +∞

,

Bk =

ϕOk, ϕIk

,

Ok =

-∞,ϕOk

,

11

где скаляры ϕIk , ϕOk определяются выражениями

(

{

})k-N-1

ϕI

= -ϕ 1 + max b, max εj

,

k

j=1,m-1

(

{

})k-N-1

ϕO

= -ϕ 1 + max b, max εj

k

j=1,m-1

Из утверждения 1 вытекает, что условие леммы выполняется F ⊆ ΔIk и,

следовательно, задачи (23) и (24) являются эквивалентными. Из утвержде-

ния 1 следует, что управление, оптимальное по вероятностному терминально-

му критерию, максимизирует вероятность первого достижения капиталом xk

уровня (-ϕ) за время, ограниченное сверху величиной N.

Воспользуемся двусторонними границами функции оптимального значе-

ния вероятностного критерия для определения оценки такого момента вре-

мени N∗ ∈ N, что

(

)

P max

x∗k ≥ ϕ

= 1,

k∈{0,...,N∗}

где {x∗k}Nk=0 - траектории системы (22), замкнутой оптимальным управлением

u∗ (·). Интересно, что двусторонние границы функции оптимального значе-

ния вероятностного критерия (см. теорему 3) позволяют найти такую оценку

без нахождения оптимального управления.

Утверждение 2. Пусть {xk}Nk=0

траектории системы (22), замк-

нутой управлением (11), где

∑

(25)

γ

(x) = arg max Px 1 + bu1 + uj ξj-1k≥ϕI

,

k = 0,N.

k

k+1

u∈U

j=2

Тогда существует N ∈ N, такой что

(

)

P max

xk+1 ≥ ϕ

= 1,

k={0,...,N}

причем для любых X > 0, b > -1 выполнено N∗ ≥ N и

ln (-ϕ) - ln (X)

(26)

N =

(

{

}) - 1

ln

1 + max b, max εj

j=1,m-1

Проведем серию численных экспериментов для проверки адекватности

оценки (26). При этом будем рассматривать случай одного рискового актива,

для которого в [13] была найдена стратегия (25)

{

(1, 0)T , x ≥ -ϕ (1 + b)k-N-1 ,

γk (x) =

(0, 1)T , x < -ϕ (1 + b)k-N-1 .

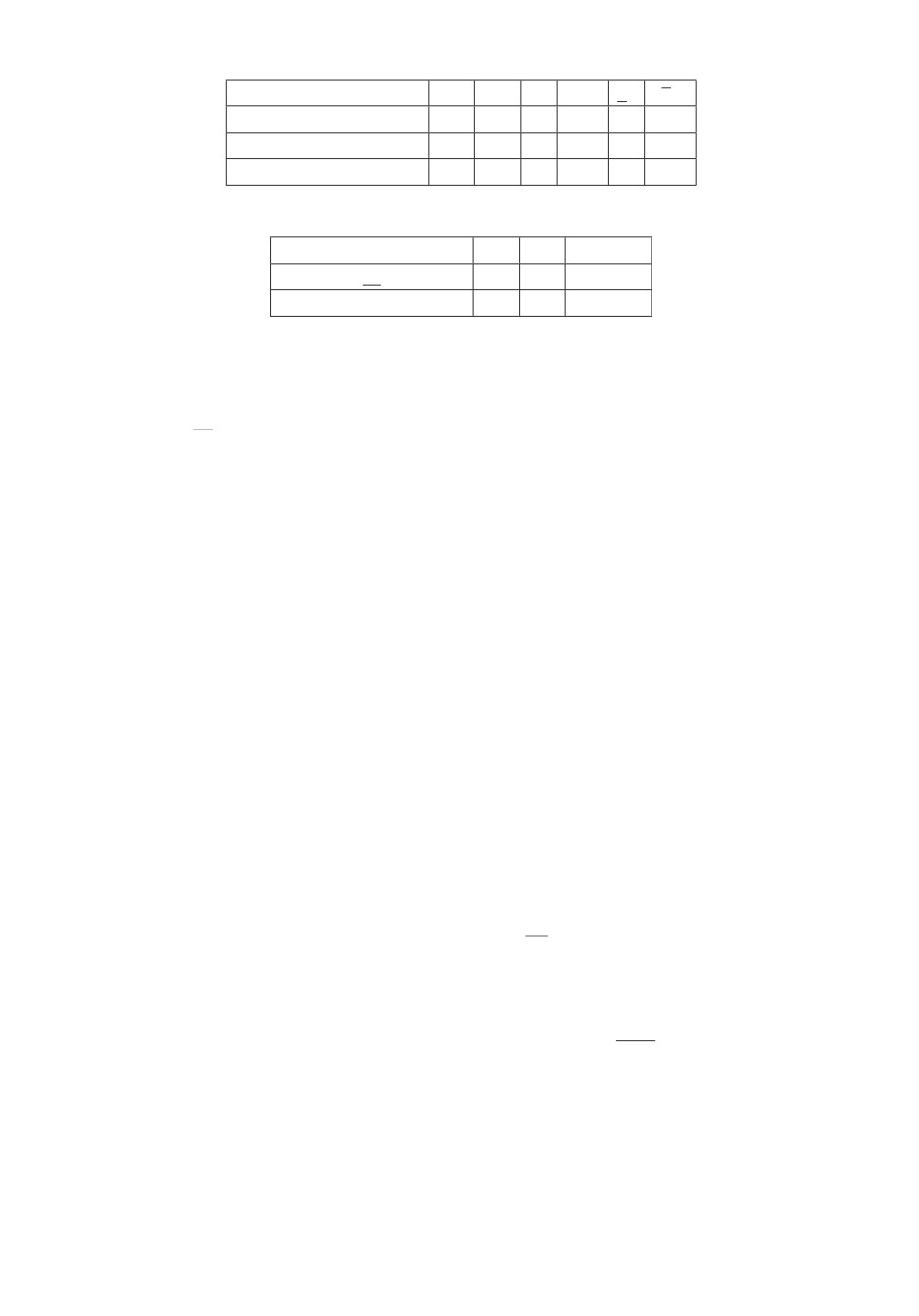

Значения параметров системы заданы в табл. 1.

12

Таблица 1. Значения параметров системы

Номер эксперимента N ϕ X b ε1 ε1

а

200

100

15

0,01

-1

0,02

б

200

100

20

0,01

-1

0,02

в

200

100

25

0,01

-1

0,02

Таблица 2. Значения параметров системы

Номер эксперимента а б

в

N

189

160

138

N∗

189

160

139

Для моделирования уровня N∗ будем использовать метод Монте-Карло из

50000 наблюдений. Результаты моделирования занесены в табл. 2. Из табл. 2

видно, что N является относительно точной оценкой числа N∗.

8. Заключение

В статье рассмотрена задача оптимального управления дискретной сто-

хастической системой с критерием вероятности первого достижения траекто-

риями системы заданной трубки траекторий. Получены достаточные условия

оптимальности в форме метода динамического программирования. Найдены

двусторонние оценки функции правой части уравнения метода динамическо-

го программирования, функции Беллмана и функции оптимального значения

вероятностного критерия. Получены аналитические выражения для прибли-

женного определения оптимального управления и найдены оценки точности

такого управления. Доказаны условия эквивалентности данной задачи и за-

дачи оптимального управления с вероятностным терминальным критерием.

Данные условия были проверены на задаче оптимального управления порт-

фелем ценных бумаг.

ПРИЛОЖЕНИЕ

Доказательство теоремы

1. Введем в рассмотрение функцию

Φ0 : Rn → R, такую что Φ0 (x) = Φ1 (x). Расширим вектор состояния системы

путем введения новой переменной yk = mini=0,k Φi (xi). Расширенная система

управления имеет вид

xk+1 = fk (xk, uk,ξk),

yk+1 = min {yk, Φk (xk)} ,

k = 0,N,

x0 = X,

y0 = Φ0 (X) ,

где uk = γk (xk, yk). Введем в рассмотрение функцию правой части расширен-

ной систем

f :Rn+1 ×Rm ×Rs →Rn+1 :

fk (x,y,u,ξ) = (fk (x,u,ξ) ,min {y, Φk (x)})T .

13

Тогда эквивалентную задачу оптимального управления можно представить

в виде

P(min {yN+1, ΦN+1 (xN+1)} ≤ ϕ) → sup , k = 0,N,

u(·)

U

гд

U

U0 × ...

UN,

{

}

Uk =

γ : Rn+1 → Rm| γ измерима по Борелю, ∀x ∈ Rn+1 : γ(x) ∈ Uk

Эквивалентность выше понимается в смысле равенства критериев

(

)

P (u (·)) = P min Φk+1 (x) ≤ ϕ

= P(min{yN+1, ΦN+1 (xN+1)} ≤ ϕ).

k=0,N

Уравнение Беллмана для эквивалентной задачи имеет вид [12]:

[

(

)]

Bk+1

(Π.1)

γ∗k (x,y) = arg max Mξ

fk (x,y,u,ξk)

,

k

u∈Uk

[

(

)]

Bk+1

(Π.2)

Bk (x,y) = max Mξ

fk (x,y,uk,ξk)

,

k

u∈Uk

(Π.3)

BN+1 (x,y) = I{min{y,Φ

(x, y) , k = 0, N .

N+1(x)}≤ϕ}

Согласно [12] если выполнены условия:

1) функци

fk непрерывны для всех k = 0,N;

2) функция min {y, ΦN+1 (x)} непрерывна и ограничена снизу;

3) случайные векторы X, ξ0, . . . , ξN независимы;

4) множества U0, . . . , UN компактны,

то оптимальное управление существует в классе измеримых функций и опре-

деляется в результате решения задач (П.1)-(П.3).

На шаге k = N уравнение Беллмана можно записать в виде

[

]

(Π.4)

BN (x,y) = max Mξ

=

N

I{min{y, ΦN (x), ΦN+1(f(x,u,ξk))}≤ϕ} (x, y)

u∈UN

[

(

)

= max MξN I{min{y,ΦN (x)}≤ϕ} (x,y) +

1 - I{min{y, ΦN(x)}≤ϕ} (x,y)

×

u∈UN

]

× I{ΦN+1(f(x,u,ξk))≤ϕ} (x)

=

[

(

)

×

= max MξN I{min{y,ΦN (x)}≤ϕ} (x,y) +

1 - I{min{y, ΦN(x)}≤ϕ} (x,y)

u∈UN

]

× BN+1 (fN (x,u,ξN))

Отсюда легко показать, что для любого k = 0, N уравнение (П.2) можно пред-

ставить в виде

[

(Π.5)

Bk (x,y) = max Mξ

I{min{y,Φk(x)}≤ϕ} (x,y) +

k

u∈Uk

]

(

)

+

1 - I{min{y, Φk(x)}≤ϕ} (x,y)

Bk+1 (fk (x,u,ξk)) ,

14

поэтому для функции Беллмана в эквивалентной задаче справедливо пред-

ставление

1,

y ≤ϕ,

{

}

B

(Π.6)

k(x, y) =

max Mξk IFk(x)+(1-IFk(x))Bk+1(fk(x,u,ξk)) , y > ϕ.

u∈Uk

Отсюда получаем представление и для оптимального управления

любой элемент из Uk,

y ≤ϕ,

{

}

(Π.7) γ∗(x, y) =

k

arg max Mξk IFk (x) + (1 - IFk (x))Bk+1(fk(x, u, ξk)) , y > ϕ.

u∈Uk

Условия 1-5 теоремы 1 получаются из условий существования оптималь-

ного управления для задачи с терминальным критерием. Причем пункты

2 и 3 следуют из условий непрерывности и ограниченности снизу функции

min {y, ΦN+1 (x)}.

Теорема 1 доказана.

Доказательство теоремы 2. 1. Рассмотрим уравнение Беллмана на

некотором шаге k. Для поверхности уровня 1 справедливо соотношение

{

}

Ik = x ∈ Rn

max Mξ

[IFk (x) + (1 - IFk (x)) Bk+1 (fk (x, u, ξk))] = 1

=

k

u∈Uk{

}

=Fk ∪ x∈Rn

max Mξ

[Bk+1 (fk (x, u, ξk))] = 1

k

u∈Uk

Используя формулу полного математического ожидания, получаем

{

{

Ik = Fk ∪ x ∈ Rn

max

Pξk (fk (x, u, ξk) ∈ Ik+1) ×

u∈Uk

[

]

×Mξk

Bk+1 (fk (x,u,ξk))

fk (x,u,ξk) ∈ Ik+1

+

+ (1 - Pξk (fk (x, u, ξk) ∈ Ik+1)) ×

}

[

]}

×Mξk

Bk+1 (fk (x,u,ξk))

fk (x,u,ξk) ∈ Ik+1

=1 .

Из равенств

[

]

Mξk

Bk+1 (fk (x,u,ξk))

fk (x,u,ξk) ∈ Ik+1

= 1,

[

]

Mξk

Bk+1 (fk (x,u,ξk))

fk (x,u,ξk) ∈ Ik+1

< 1,

следует, что

{

{

Ik = Fk ∪ x ∈ Rn

max

Pξk (fk (x, u, ξk) ∈ Ik+1) +

u∈Uk

+ (1 - Pξk (fk (x, u, ξk) ∈ Ik+1)) ×

}

}

[

]

×Mξk

Bk+1 (fk (x,u,ξk))

fk (x,u,ξk) ∈ Ik+1

=1

=

{

}

=Fk ∪ x∈Rn

max Pξ

(fk (x, u, ξk) ∈ Ik+1) = 1

k

u∈Uk

Утверждение 1 доказано.

15

2. Аналогично п. 1 получаем соотношение для поверхности уровня 0 функ-

ции Беллмана:

{

}

Ok = x ∈ Rn

max Mξ

[IFk (x) + (1 - IFk (x)) Bk+1 (fk (x, u, ξk))] = 0

=

k

u∈Uk{

}

=Fk ∩ x∈Rn

max Mξ

[Bk+1 (fk (x, u, ξk))] = 1

k

u∈Uk

Выполним преобразование правой части последнего выражения с использо-

ванием формулы полного математического ожидания:

{

{

Ok = Fk ∩ x ∈ Rn

max

Pξk (fk (x, u, ξk) ∈ Ik+1) ×

u∈Uk

[

]

×Mξk

Bk+1 (fk (x,u,ξk))

fk (x,u,ξk) ∈ Ik+1

+

+ Pξk (fk (x,u,ξk) ∈ Bk+1)×

[

]

×Mξk

Bk+1 (fk (x,u,ξk))

fk (x,u,ξk) ∈ Bk+1

+

+ Pξk (fk (x,u,ξk) ∈ Ok+1)×

}

}

[

]

×Mξk

Bk+1 (fk (x,u,ξk))

fk (x,u,ξk) ∈ Ok+1

=0 .

Из равенств

[

]

Mξk

Bk+1 (fk (x,u,ξk))

fk (x,u,ξk) ∈ Ik+1

= 1,

[

]

Mξk

Bk+1 (fk (x,u,ξk))

fk (x,u,ξk) ∈ Bk+1

∈ (0, 1) ,

[

]

Mξk

Bk+1 (fk (x,u,ξk))

fk (x,u,ξk) ∈ Ok+1

=0

получаем, что

{

{

Ok = Fk ∩ x ∈ Rn

max

Pξk (fk (x, u, ξk) ∈ Ik+1) +

u∈Uk

+ Pξk (fk (x,u,ξk) ∈ Bk+1)×

}

}

[

]

×Mξk

Bk+1 (fk (x,u,ξk))

fk (x,u,ξk) ∈ Bk+1

=0

=

{

=Fk ∩ x∈Rn

∀u∈Uk : Pξ

(fk (x, u, ξk) ∈ Ik+1) = 0,

k

}

Pξk (fk (x, u, ξk) ∈ Bk+1) = 0

=

}

= Fk ∩ {x ∈ Rn

∀u ∈ Uk : Pξ

(fk (x, u, ξk) ∈ Ok+1) = 1

k

Утверждение 2 доказано.

3. Утверждение 3 следует из утверждения 1 теоремы 2.

4. Утверждение 4 выполнено, поскольку при x ∈ Ok справедливо равенство

Bk (x) = 0.

5. Утверждение 5 следует из утверждения 1 теоремы 2.

16

6. При x ∈ Bk функция правой части уравнения метода динамического

программирования представима в виде

Mξk [Bk+1 (fk (x,u,ξk))] = Pξk (fk (x,u,ξk) ∈ Ik+1) ×

(

[

])

×

1-Mξk

Bk+1 (fk (x,u,ξk))

fk (x,u,ξk) ∈ Bk+1

+

+ (1 - Pξk (fk (x, u, ξk) ∈ Ok+1)) ×

[

]

×Mξk

Bk+1 (fk (x,u,ξk))

fk (x,u,ξk) ∈ Bk+1

,

откуда с использованием двустороннего неравенства для выпуклой комбина-

ции получаем

{

}

min Pξk (fk (x, u, ξk) ∈ Ik+1) , (1 - Pξk (fk (x, u, ξk) ∈ Ok+1))

≤

≤ Mξk [Bk+1 (fk (x,u,ξk))] ≤

{

}

≤ max Pξk (fk (x,u,ξk) ∈ Ik+1) , (1 - Pξk (fk (x,u,ξk) ∈ Ok+1))

С использованием соотношений 1- Pξk (fk(x, u, ξk) ∈ Ok+1) = Pξk (fk(x, u, ξk) ∈

∈ Ik+1) + Pξk(fk(x,u,ξk) ∈ Bk+1) и Fk ⊆ Ik завершаем доказательство утвер-

ждения 6 теоремы 2.

7. Утверждение 7 следует из предыдущего путем взятия супремума во всех

частях неравенства (8).

Доказательство теоремы 3.

1. Введем систему гипотез, образую-

щих полную группу несовместных событий:

{

}

{

}

⋃

⋂

{xk ∈ Ik}

,

{xk ∈ Ik}

k=1

k=1

Тогда с учетом формулы полной вероятности справедлива цепочка равенств

(

)

⋃

{

}

P (u(·)) = P

xk+1 ∈ Fk+1

=

k=0

(

) (

)

⋃

⋃

{

}

⋃

(Π.8)

=P

{xk ∈ Ik} P

xk+1 ∈ Fk+1

{xk ∈ Ik}

+

k=1

k=0

k=1

(

) (

)

⋂

⋃

⋂

{

}

+P

{xk ∈ Ik} P

xk+1 ∈ Fk+1

{xk ∈ Ik}

k=1

k=0

k=1

Исследуем второй множитель первого слагаемого правой части последнего

выражения. Из цепочки равенств

(

)

(

)

P xN+1 ∈FN+1

xN ∈IN

=P xN+1 ∈IN+1

xN ∈IN

=1

следует, что

(

)

⋃

{

}

⋃

P

xk+1 ∈ Fk+1

{xk ∈ Ik}

= 1.

k=0

k=1

17

С учетом последнего равенства выражение (П.8) принимает вид

(

)

⋃

P (u (·)) = P

{xk ∈ Ik}

+

k=1

(Π.9)

(

) (

)

⋂

⋃

{

}

⋂

+P

{xk ∈ Ik} P

xk+1 ∈ Fk+1

{xk ∈ Ik}

k=1

k=0

k=1

Введем в рассмотрение систему гипотез, образующих полную группу несов-

местных событий:

{

}

{

}

⋃

⋂

{xk ∈ Ik}

,

{xk ∈ Ik}

k=1

k=1

Воспользуемся формулой полной вероятности для первого слагаемого в пра-

вой части (П.9):

(

)

⋃

P

{xk ∈ Ik}

=

k=1

(

) (

)

⋃

⋃

⋃

(Π.10)

=P

{xk ∈ Ik} P

{xk ∈ Ik}

{xk ∈ Ik}

+

k=1

k=1

k=1

(

) (

)

⋂

⋃

⋂

+P

{xk ∈ Ik} P

{xk ∈ Ik}

{xk ∈ Ik}

k=1

k=1

k=1

Аналогично (П.9) преобразуем правую часть (П.10), откуда получим

(

) (

)

⋃

⋃

P

{xk ∈ Ik}

=P

{xk ∈ Ik}

+

k=1

k=1

(Π.11)

(

) (

)

⋂

⋃

⋂

+P

{xk ∈ Ik} P

{xk ∈ Ik}

{xk ∈ Ik}

k=1

k=1

k=1

Выполним подстановку (П.10) в (П.9):

(

)

⋃

P (u(·)) = P

{xk ∈ Ik}

+

k=1

(

) (

)

⋂

⋃

⋂

(Π.12)

+P

{xk ∈ Ik} P

{xk ∈ Ik}

{xk ∈ Ik}

+

k=1

k=1

k=1

(

) (

)

⋂

⋃

⋂

{

}

+P

{xk ∈ Ik} P

xk+1 ∈ Fk+1

{xk ∈ Ik}

k=1

k=0

k=1

18

Проводя аналогичные преобразования в отношении первого слагаемого

в (П.12) и вводя системы гипотез

{

}

{

}

⋃

⋂

{xk ∈ Ik}

,

{xk ∈ Ik}

,

l = 1,...,N - 2,

k=1

k=1

получаем выражение для значения вероятностного критерия на страте-

гии u (·):

P (u (·)) = P (x1 ∈ I1) +

(

) (

)

∑

⋂

⋃

⋂

+ P

{xk ∈ Ik} P

{xk ∈ Ik}

{xk ∈ Ik}

+

(Π.13)

l=1

k=1

k=1

k=1

(

) (

)

⋂

⋃

{

}

⋂

+P

{xk ∈ Ik} P

xk+1 ∈ Fk+1

{xk ∈ Ik}

k=1

k=0

k=1

Заметим теперь, что для первого слагаемого (П.13) справедлива цепочка ра-

венств

P(x1 ∈ I1) = P(f0 (X,u0,ξ0) ∈ I1) = B0 (X) = F (ϕ,N,X) ,

откуда следует выражение (14).

Пункт 1 теоремы 3 доказан.

2. Для доказательства п. 2 теоремы 3 достаточно заметить, что при xk ∈ Ik

выполнено u∗k = uk для всех k = 0, N , откуда аналогичным способом можно

получить выражение (14) для функции оптимального значения вероятност-

ного критерия на траекториях системы {x∗k}N+1k=1, замкнутой оптимальным

управлением u∗ (·).

Пункт 2 теоремы 3 доказан.

3. Пункт 3 теоремы 3 непосредственно следует из п. 7 теоремы 2 и п. 1

теоремы 3.

Теорема 3 доказана.

Доказательство леммы. Рассмотрим соотношения динамического

программирования (3)-(5) и (18)-(20) для задач (2) и (17) соответственно.

Поскольку в (19) ∀x ∈ Rn выполняется равенство

[

(

)

]

Bϕk (x) = max

M IIϕ

(x) +

1-IIϕ

(x) Bϕk+1 (fk (x,u,ξk)) ,

k = 0,N,

u∈Uk

k

k

где Iϕk - поверхность уровня 1 функции Беллмана Bϕk (x), то описанные усло-

вия эквивалентности верны в том случае, если поверхности уровня 1 функ-

ций Беллмана в задачах (2) и (17) равны Ik = Iϕk. С учетом рекуррентного

соотношения для Ik (см. п. 1 теоремы 2) отмеченное равенство справедливо

только в том случае, если

(Π.14)

Fk ⊆ {x ∈ Rn : ∃u ∈ Uk : P(fk (x,u,ξk) ∈ Ik+1) = 1}, k = 0,N.

Лемма доказана.

19

Доказательство утверждения 1. В соответствии с п. 1 теоремы 2

запишем уравнение для поверхностей уровней 1 и 0 функции Беллмана на

шаге k = N:

{

( (

)

)

}

∑

IN = F ∪ x ∈ R : ∃u ∈ U : P x

1+u1b+ uiξi

N

≥ -ϕ

=1

,

i=2

{

( (

)

)

}

∑

ON = F ∩ x ∈ R : ∀u ∈ U : P x

1+u1b+ uiξi

N

< -ϕ

=1

i=2

Используя результат из [13], где были найдены решения соответствующих

уравнений, и введенные в разделе 6 обозначения для границ множеств Ik

и Ok, получаем:

[

)

(

{

})-1

[

)

IN

= [ϕ, +∞) ∪ ϕ

1 + max b, max bj

,+∞

=

ϕIN , +∞

,

j=2,m

(

]

(

{

})-1

(

]

ON

= (-∞, ϕ] ∩

-∞,ϕ

1 + max b, max bj

=

-∞,ϕON

j=2,m

Отсюда следует, что IN = ΔIN . Используя п. 1 теоремы 2, получаем, что на

шаге k = N - 1 уравнение для изобелл примет вид

{

( (

)

)

}

∑

IN-1 = F ∪ x ∈ R : ∃u ∈ U : P x

1+u1b+ uiξi

≥ϕI

=1

,

N-1

N

i=2

{

( (

)

)

}

∑

ON-1 = F ∩ x ∈ R : ∀u ∈ U : P x

1+u1b+ ui ξi

<ϕO

=1

N-1

N

i=2

По аналогии с шагом k = N получаем

[

)

(

]

IN-1 = ΔIN-1 =

ϕIN-1, +∞

,

ON-1 =

-∞,ϕON-1

Оперируя математической индукцией, заключаем, что для всех k = 0, N вы-

полнено

[

)

(

]

Ik = ΔIk =

ϕIk , +∞

,

Ok =

-∞,ϕOk

Утверждение 1 доказано.

Доказательство утверждения 2. Рассмотрим стратегию управле-

ния (11), которая с учетом утверждения 1 принимает вид (25). Из п. 3 теоре-

мы 3 следует, что

(

)

(Π.15)

P (u (·)) = P

max

xk+1 ≥ -ϕ

≥ F (ϕ,N,X),

k∈{0,...,N}

где функция F с учетом

(

{

})-N

ϕI

= -ϕ 1 + max b, max εj

1

j=1,m-1

20

имеет вид

(Π.16)

F (ϕ, N, X) =

∑

ϕ

= maxPX1 + bu1 + ujξj-1≥-(

{

})N

0

u∈U

j=2

1 + max b, max εj

j=1,m-1

Нетрудно видеть, что величину N ∈ N можно определить как корень урав-

нения F (ϕ, N, X) = 1, но поскольку таких корней бесконечное множество, то

будем искать оценку N в виде

(Π.17)

N = min{N ∈ N : F (ϕ,N,X) = 1}.

Из (П.15) и (П.17) следует, что

(

)

P max

xk+1 ≥ -ϕ

= 1.

k∈{0,...,N}

Из определений поверхности уровня 1 функции Беллмана и функции F сле-

дует, что уравнение F (ϕ, N, X) = 1 эквивалентно включению X ∈ I0, что в

свою очередь эквивалентно неравенству

ϕ

X ≥-(

{

})N+1 .

1 + max b, max εj

j=1,m-1

Путем логарифмирования получаем

ln (-ϕ) - ln (X)

N ≥

(

{

}) - 1.

ln

1 + max b, max εj

j=1,m-1

Используя (П.17) окончательно получаем (26).

Утверждение 2 доказано.

СПИСОК ЛИТЕРАТУРЫ

1. Афанасьев В.Н., Колмановский В.Б., Носов В.Р. Математическая теория кон-

струирования систем управления. М.: Высш. шк., 2003.

2. Смирнов И.П. Об одной задаче быстродействия для стохастической управляе-

мой системы // Дифференц. уравнения. 1986. Т. 22. № 2. С. 247-254.

3. Бертсекас Д., Шрив С. Стохастическое управление: случай дискретного време-

ни. М.: Наука, 1985.

4. Zhou J. Infinite Horizon Optimal Control Problem for Stochastic Evolution Equa-

tions in Hilbert Spaces // J. Dyn. Control Syst. 2016. V. 22. No. 3. P. 531-554.

5. Agram N., Haadem S., Øksendal B., Proske F. A Maximum Principle for Infinite

Horizon Delay Equations // SIAM J. Math. Anal. 2013. V. 45. No. 4. P. 2499-2522.

21

6.

Agram N., Øksendal B. Infinite Horizon Optimal Control of Forward-Backward

Stochastic Differential Equations with Delay // J. Comput. Appl. Math. 2014. V. 259.

Part B. P. 336-349.

7.

Черноусько Ф.Л., Колмановский В.Б. Оптимальное управление при случайных

возмущениях. М.: Наука, 1978.

8.

Смирнов И.П. Об управлении вероятностью входа системы в заданную об-

ласть // Дифференц. уравнения. 1990. Т. 26. № 10. С. 1753-1758.

9.

Азанов В.М. Оптимальное управление линейной дискретной системой по кри-

терию вероятности // АиТ. 2014. № 10. С. 39-51.

Azanov V.M. Optimal Control for Linear Discrete Systems with Respect to Proba-

bilistic Criteria // Autom. Remote Control. 2014. V. 75. No. 10. P. 1743-1753.

10.

Семаков С.Л. Выбросы случайных процессов: приложения в авиации. М.: Наука,

2005.

11.

Хаметов В.М., Шелемех Е.А. Суперхеджирование американских опционов на

неполном рынке с дискретным временем и конечным горизонтом // АиТ. 2015.

№ 9. С. 125-149.

Khametov V.M., Shelemekh E.A. Superhedging of American Options on an Incom-

plete Market with Discrete Time and Finite Horizon // Autom. Remote Control.

2015. V. 76. No. 9. P. 1616-1634.

12.

Малышев В.В., Кибзун А.И. Анализ и синтез высокоточного управления лета-

тельными аппаратами. М.: Машиностроение, 1987.

13.

Азанов В.М., Кан Ю.С. Двухсторонняя оценка функции Беллмана в задачах

стохастического оптимального управления дискретными системами по вероят-

ностному критерию качества // АиТ. 2018. № 2. С. 3-18.

Azanov V.M., Kan Yu.S. Bilateral Estimation of the Bellman Function in the Prob-

lems of Optimal Stochastic Control of Discrete Systems by the Probabilistic Perfor-

mance Criterion // Autom. Remote Control. 2018. V. 79. No. 2. P. 203-215.

14.

Азанов В.М., Кан Ю.С. Усиленная оценка функции Беллмана в задачах стоха-

стического оптимального управления с вероятностным критерием качества //

АиТ. 2019. № 4. С. 53-69.

Azanov V.M., Kan Yu.S. Refined Estimation of the Bellman Function for Stochas-

tic Optimal Control Problems with Probabilistic Performance Criterion // Autom.

Remote Control. 2019. V. 80. No. 4. P. 634-647.

15.

Григорьев П.В., Кан Ю.С. Оптимальное управление по квантильному критерию

портфелем ценных бумаг // АиТ. 2004. № 2. C. 179-197.

Grigor’ev P.V., Kan Yu.S. Optimal Control of the Investment Portfolio with Respect

to the Quantile Criterion // Autom. Remote Control. 2004. V. 65. Nо. 2. P. 319-336.

16.

Бунто Т.В., Кан Ю.С. Оптимальное управление по квантильному критерию

портфелем ценных бумаг с ненулевой вероятностью разорения // АиТ. 2013.

№ 5. С. 114-136.

Bunto T.V., Kan Yu.S. Quantile Criterion-based Control of the Securities Portfolio

with a Nonzero Ruin Probability // Autom. Remote Control. 2013. V. 74. Nо. 5.

P. 811-828.

17.

Кибзун А.И., Игнатов А.Н. Двухшаговая задача формирования портфеля цен-

ных бумаг из двух рисковых активов по вероятностному критерию. // АиТ.

2015. № 7. С. 78-100.

Kibzun A.I., Ignatov A.N. The Two-Step Problem of Investment Portfolio Selection

from Two Risk Assets via the Probability Criterion // Autom. Remote Control. 2015.

V. 76. No. 7. P. 1201-1220.

22

18. Азанов В.М., Кан Ю.С. Синтез оптимальных стратегий в задачах управле-

ния стохастическими дискретными системами по критерию вероятности // АиТ.

2017. № 6. C. 57-83.

Azanov V.M., Kan Yu.S. Design of Optimal Strategies in the Problems of Discrete

System Control by the Probabilistic Criterion // Autom. Remote Control. 2017.

V. 78. No. 6. P. 1006-1027.

19. Кибзун А.И., Игнатов А.Н. Сведение двухшаговой задачи стохастического оп-

тимального управления с билинейной моделью к задаче смешанного целочис-

ленного линейного программирования // АиТ. 2016. № 12. С. 89-111.

Kibzun A.I., Ignatov A.N. Reduction of the Two-Step Problem of Stochastic Optimal

Control with Bilinear Model to the Problem of Mixed Integer Linear Programming //

Autom. Remote Control. 2016. V. 77. No. 12. P. 2175-2192.

Статья представлена к публикации членом редколлегии А.И. Кибзуном.

Поступила в редакцию 02.03.2020

После доработки 20.05.2020

Принята к публикации 09.07.2020

23