Автоматика и телемеханика, № 6, 2021

Обзоры

© 2021 г. И.А. ХОДАШИНСКИЙ, д-р техн. наук (hodashn@rambler.ru)

(Томский государственный университет систем управления и радиоэлектроники)

МЕТОДЫ ПОВЫШЕНИЯ ЭФФЕКТИВНОСТИ РОЕВЫХ

АЛГОРИТМОВ ОПТИМИЗАЦИИ1

Роевые алгоритмы относятся к классу популяционных метаэвристиче-

ских методов оптимизации. Несмотря на использование различных мета-

фор, большинство роевых алгоритмов имеют схожую структуру, в них

можно выделить такие общие компоненты, как инициализация популя-

ции решений, диверсификация и интенсификация решений. На основании

концепции общности был проведен анализ ключевых подходов, методов

и способов повышения эффективности роевых алгоритмов оптимизации.

В обзоре роевые алгоритмы оптимизации рассматриваются как совокуп-

ность операторов, без детального обсуждения каждого алгоритма, основ-

ное внимание сосредоточено на анализе ключевых компонентов алгорит-

мов. Основная идея повышения эффективности заключается в соблюде-

нии баланса между диверсификацией и интенсификацией. В этом контек-

сте рассмотрены механизмы поддержки популяционного разнообразия,

методы настройки и регулировки параметров роевых алгоритмов, подхо-

ды к гибридизации алгоритмов, обозначено несколько открытых проблем,

связанных с темой обзора.

Ключевые слова: оптимизация, метаэвристики, роевые алгоритмы, дивер-

сификация, интенсификация.

DOI: 10.31857/S0005231021060015

1. Введение

Многие сложные проблемы в области науки, техники, экономики и бизнеса

могут быть сформулированы как задачи оптимизации. Традиционные мето-

ды оптимизации, основанные на производных, доказали свою эффективность

в решении различных типов задач оптимизации. Однако применение этих ме-

тодов связано с рядом ограничений, таких как “застревание” в локальных оп-

тимумах, сильная зависимость от начальных условий, большая вычислитель-

ная сложность и неприменимость к конкретным классам целевых функций.

Это привело к необходимости разработки альтернативных методов, которые

могли бы преодолеть эти ограничения [1].

Поиск оптимальных решений NP-трудных задач часто выполняется с по-

мощью методов, получивших название “метаэвристики”. Прежде чем перейти

1 Исследование выполнено при финансовой поддержке Российского фонда фундамен-

тальных исследований (проект № 19-17-50050).

3

к рассмотрению метаэвристик, дадим рабочее определение понятию эври-

стика это способ нахождения “достаточно хороших” решений без доказа-

тельства оптимальности найденных решений. Качество или эффективность

решения могут быть выражены через точность, стабильность, экономию па-

мяти или времени. Термин “мета” указывает на обобщенность и “методоло-

гию верхнего уровня”. Как правило, эвристики предназначены для решения

конкретных задач, в то время как метаэвристики независимы от решаемых

проблем. По мнению Шона Люка, автора известной книги “Основы метаэв-

ристик” [2], метаэвристика общее, но неудачное название стохастического

алгоритма оптимизации, который применяется в качестве последней надеж-

ды на пути к решению задачи оптимизации. Стохастическая оптимизация

большой класс алгоритмов и методов, использующих случайность для поиска

оптимального (субоптимального) решения сложных задач. Применяются ме-

таэвристики в том случае, когда 1) неизвестен способ поиска оптимального

решения; 2) недостаточно имеющейся априорной информации; 3) невозмо-

жен полный перебор; 4) можно проверить качество решения, т.е. неизвестна

аналитическая форма целевой функции f(x), но ее значение может быть вы-

числено для конкретного решения x.

Метаэвристики не используют вычисление производных целевой функции,

однако, в отличие от детерминированных методов оптимизации, метаэвристи-

ки позволяют находить за приемлемое время удовлетворительные решения

задач большой размерности. Широкому применению метаэвристик способ-

ствуют увеличение вычислительной мощности компьютеров и развитие па-

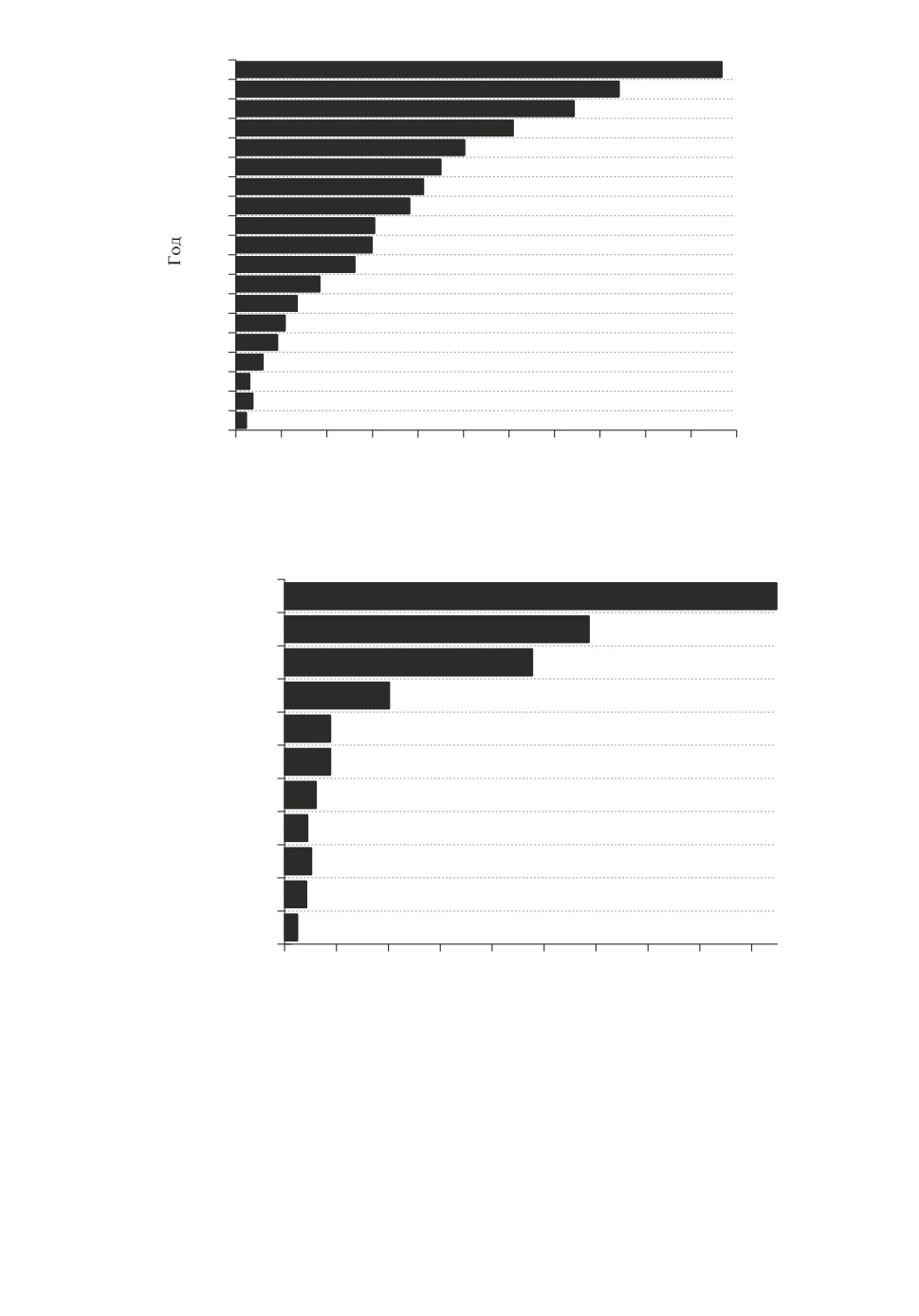

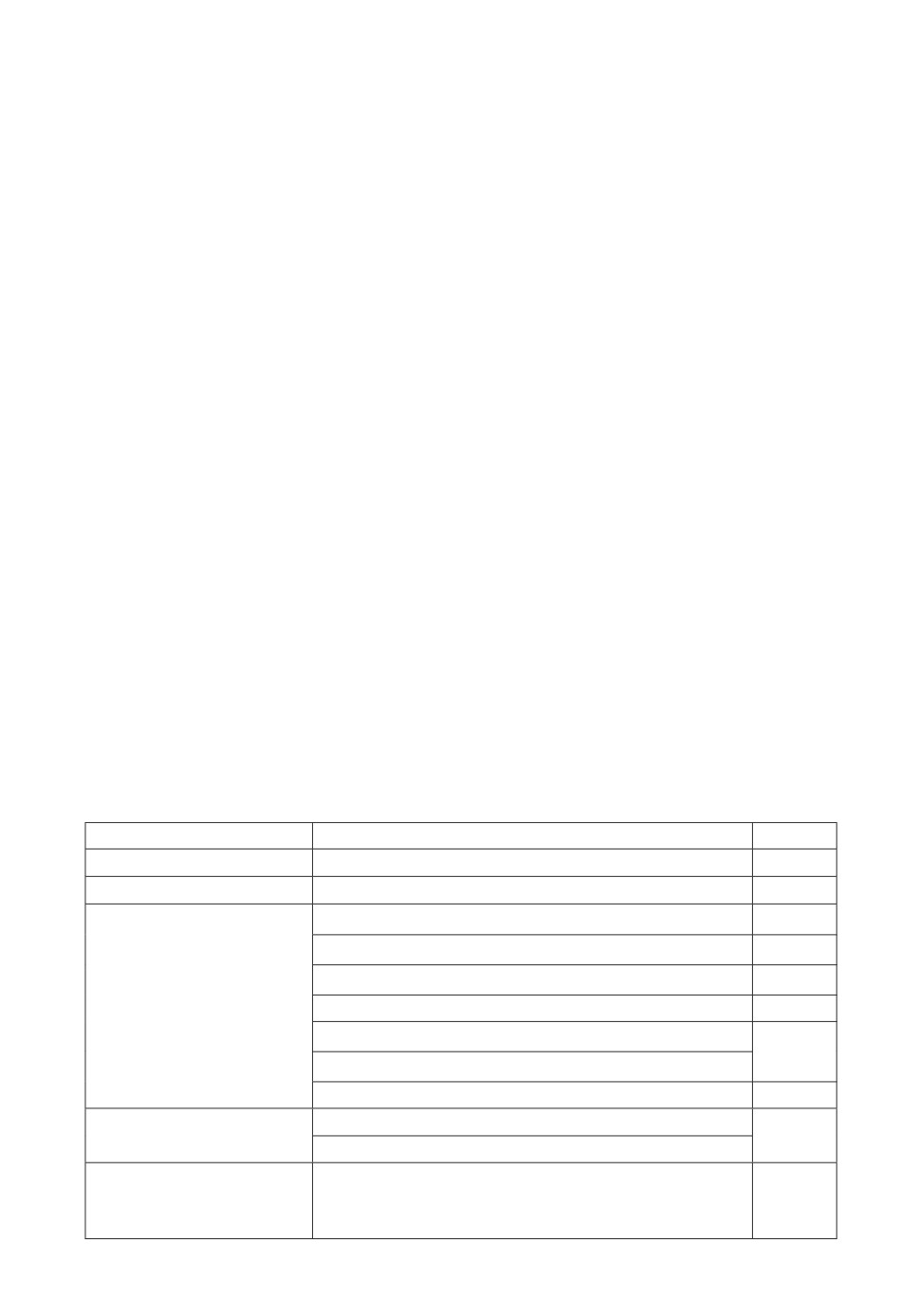

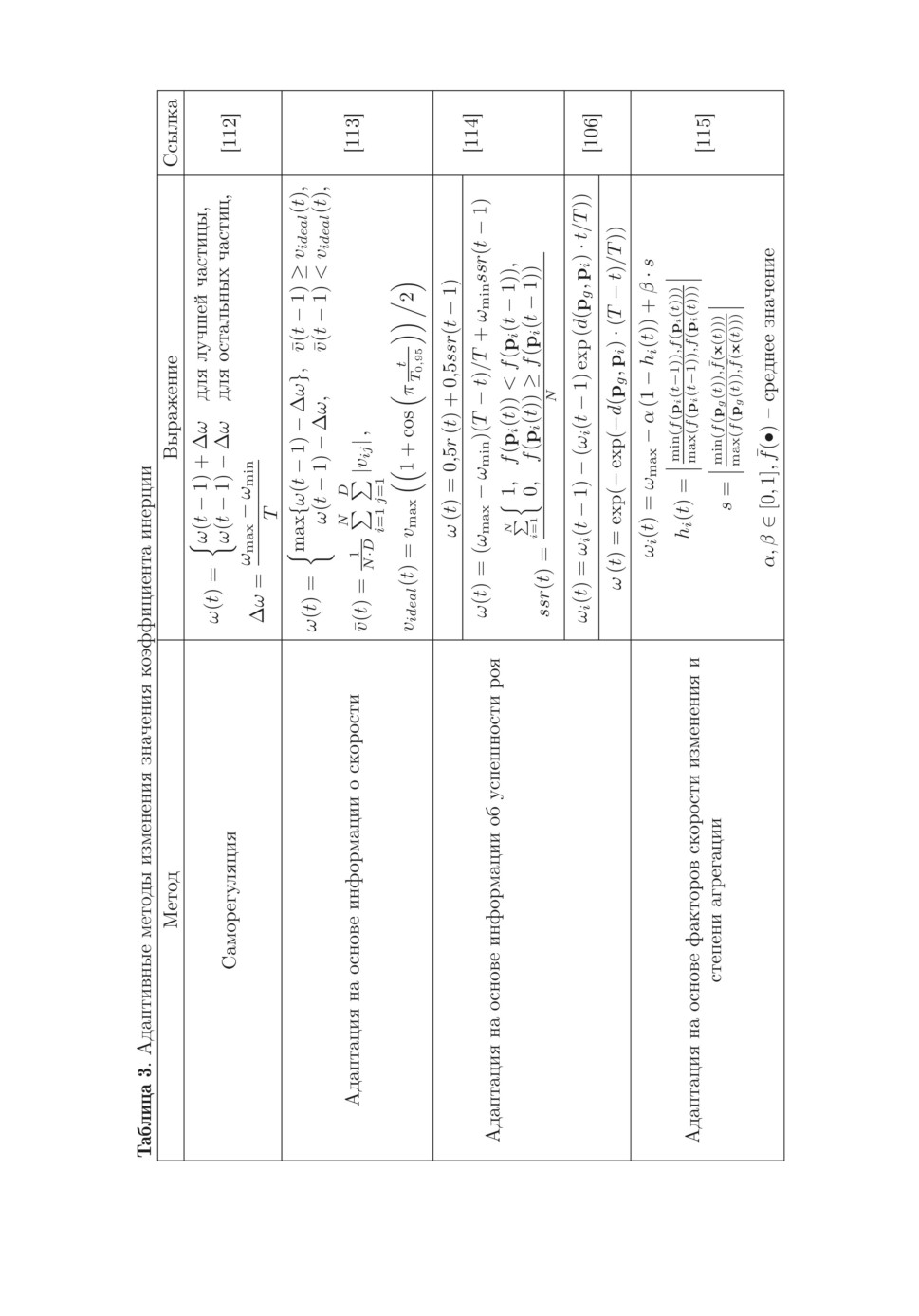

раллельных архитектур [3]. На рис. 1 приведено распределение количества

статей, индексируемых в базе данных Scopus, в которых упоминалось слово

“metaheuristic”, а на рис. 2 указано распределение статей по отраслям знаний.

Метаэвристические методы классифицируются по различным основани-

ям. Методы, формирующие последующее решение на основе единственного

предыдущего решения, относятся к траекторным методам, типичными пред-

ставителями которых являются алгоритм имитации отжига [4] и поиск с за-

претами [5]. Популяционные методы формируют решение на основе своего

предыдущего опыта и информации о лучших решениях в популяции. Траек-

торные методы в большей степени ориентированы на интенсификацию реше-

ний, тогда как базовая метаэвристика, основанная на популяциях, в большей

степени ориентирована на диверсификацию [3]. Популяционные методы раз-

делены на четыре класса [6]: эволюционные алгоритмы, основанные на про-

цессах эволюции; алгоритмы, имитирующие физические процессы; роевые

алгоритмы, основанные на поведенческих процессах социальных животных;

алгоритмы, имитирующие поведение человека.

Концепция отсутствия универсального алгоритма оптимизации, оформ-

ленная в виде “теоремы о бесплатных завтраках” [7], фактически констатиру-

ет отсутствие необходимости оценивать эффективность алгоритмов оптими-

зации в среднем для всех проблем. Теорема указывает на важность понима-

ния взаимосвязи между компонентами алгоритма оптимизации и спецификой

решаемой проблемы и побуждает специалистов к проведению новых иссле-

дований в области роевых алгоритмов. Эти исследования можно разделить

на три большие категории [8]. Первая категория связана с исследованием и

4

2019

2018

2017

2016

2015

2014

2013

2012

2011

2010

2009

2008

2007

2006

2005

2004

2003

2002

2001

0

200

400

600

800

1000 1200 1400 1600 1800 2000 2200

Количество статей

Рис. 1. Распределение количества статей, индексируемых в базе данных

Scopus, в которых упоминалось слово “metaheuristic”.

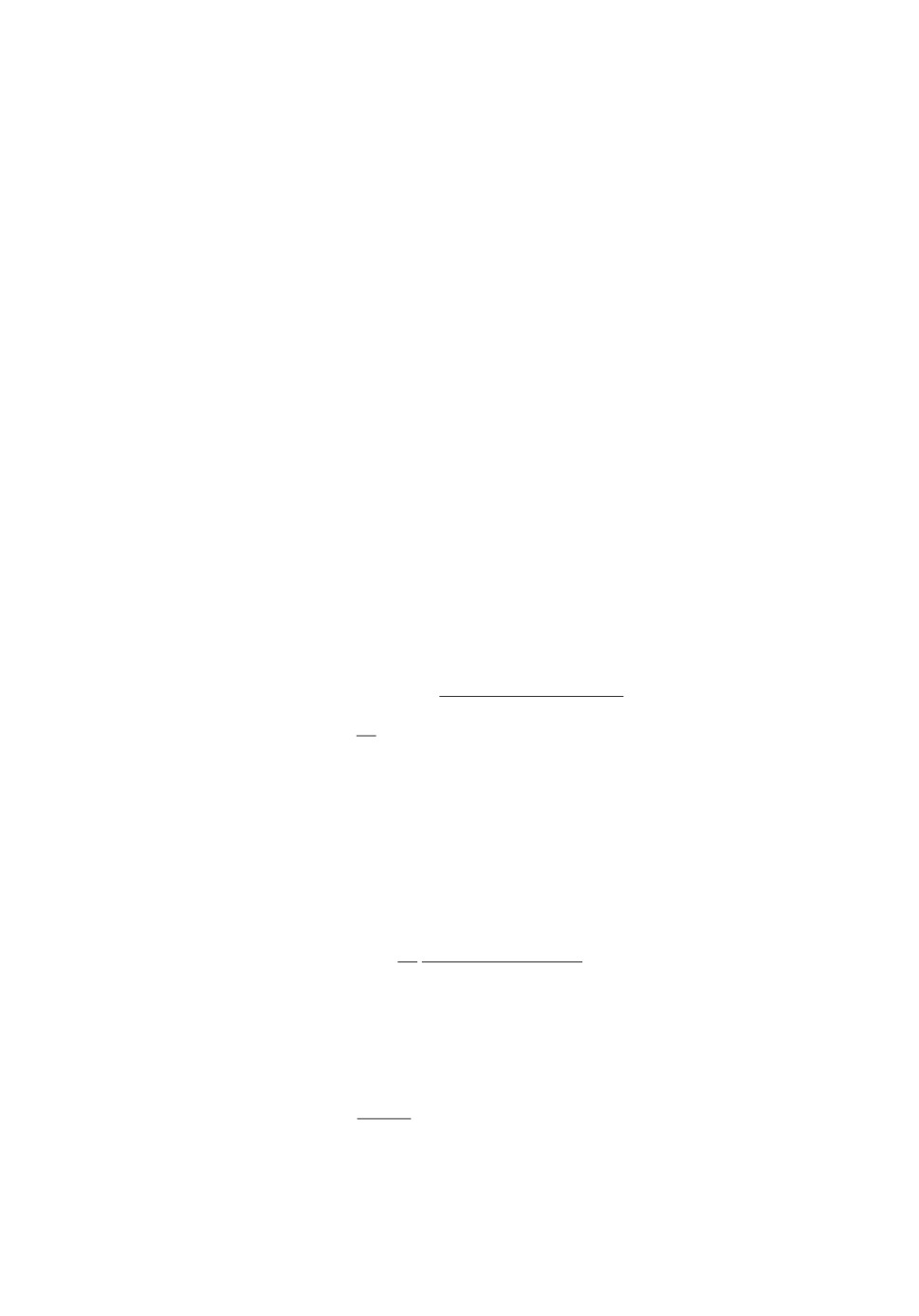

Computer Sci.

Engineering

Mathematics

Decision Sci.

Business

Energy

Physics & Astr.

Social Sci.

Materials Sci.

Environm. Sci.

Chemical Engin.

0

1000

2000

3000

4000

5000

6000

7000

8000

9000

Количество статей

Рис. 2. Распределение по отраслям знаний статей, в которых упомина-

лось слово “metaheuristic”.

модификацией роевого алгоритма для улучшения его сходимости, точности

решения, уменьшения времени выполнения. Вторая категория относится к

исследованию типов проблем, которые могут быть решены с помощью данно-

го алгоритма. Большинство роевых алгоритмов изначально предназначались

для решения однокритериальных задач безусловной оптимизации. После то-

го как алгоритм показал свою эффективность в решении указанных задач,

5

проводится его модификация для решения других типов задач, таких как

задачи одноцелевой оптимизации с ограничениями, задачи многоцелевой оп-

тимизации, задачи многоцелевой оптимизации с ограничениями, комбинатор-

ные задачи оптимизации и т.д. Третья категория связана с исследованиями

практических приложений алгоритмов.

Цель обзора связана с первой категорией исследований. Существующие об-

зоры, посвященные метаэвристической оптимизации, по большей части сосре-

доточены на эволюционных алгоритмах и в меньшей степени на роевых ал-

горитмах. Обзоры, за редким исключением, сосредоточены на рассмотрении

метафор, лежащих в основе метаэвристиеских алгоритмов, и не раскрывают

общего понимания механизмов генерации и модификации решений. В пред-

ставленном обзоре роевые алгоритмы оптимизации рассматриваются как со-

вокупность операторов, без детального обсуждения каждого алгоритма, ос-

новное внимание сосредоточено на анализе ключевых компонентов роевых

алгоритмов.

Статья организована следующим образом. В разделе 2 дается краткое опи-

сание основных понятий и терминологии роевых алгоритмов. Так как алго-

ритм роящихся частиц является прототипом для реализации многих после-

дующих роевых алгоритмов, его описанию посвящен раздел 3. Процедуры

инициализации рассматриваются в разделе 4. В разделе 5 приведены некото-

рые меры популяционного разнообразия, а механизмы поддержки разнообра-

зия в разделе 6. Проблемы настройки и регулировки значений параметров

рассматриваются в разделе 7. В разделе 8 дается краткое описание основных

подходов к гибридизации роевых алгоритмов. Открытые проблемы кратко

рассмотрены в разделе 9. В разделе 10 подведены итоги.

2. Основные понятия и терминология

Алгоритмы оптимизации ищут точку в пространстве поиска, в которой

значение целевой функции максимально или минимально в зависимости от

задачи оптимизации.

Рассмотрим задачу поиска минимального значения функции

min f(x), xmin ≤ x ≤ xmax,

xmin = (x1,min,x2,min,... ,xD,min) , xmax = (x1,max,x2,max,... ,xD,max),

xmin и xmax определяют пространство поиска, f : ℜD → ℜ целевая функ-

ция D-мерного векторного аргумента, которая оценивает решение x =

= (x1, x2, . . . , xD).

Большинство традиционных методов оптимизации требуют выполнения

определенных условий, таких как выпуклость, непрерывность и т.д. Прини-

мая во внимание ограничения традиционных методов, исследователи предло-

жили использовать методы стохастической оптимизации, в частности роевые

алгоритмы.

Большинство роевых алгоритмов оптимизации основаны на метафоре при-

родных или техногенных процессов. Однако анализ работы метаэвристиче-

ского алгоритма должен быть выполнен с использованием общепринятой тер-

6

минологии в области оптимизации, а не на языке метафоры. Реальная цен-

ность использования таких метафор в алгоритмах оптимизации часто неясна

и вызывает ряд критических замечаний [9, 10]. Основное замечание связано

с отсутствием алгоритмических различий в так называемых новых метаэв-

ристиках по сравнению с ранее опубликованными. Автор публикации [11],

проведя строгий анализ гармонического поиска [12], приходит к выводу, что

эта метаэвристика является частным случаем хорошо известной эволюцион-

ной стратегии. В [13] показано, что оптимизация на основе черных дыр [14]

является упрощенной версией алгоритма роящихся частиц. Анализ алгорит-

ма под названием “интеллектуальные капли воды” [15] позволил авторам [10]

сделать вывод о том, что все основные алгоритмические компоненты этой

метаэвристики являются упрощениями или частными случаями алгоритма

муравьиной колонии. Другое важное критическое замечание связано с со-

мнением по поводу полезности использования некоторых метафор при раз-

работке алгоритмов оптимизации. Авторы публикаций [9, 10, 13] указывают

на то, что, хотя некоторые метафоры имеют хорошее математическое описа-

ние, созданные на их основе метаэвристики либо существенно модифицируют

указанные описания, либо вообще не соответствуют исходной метафоре. В [9]

утверждается, что в большинстве случаев метафоры совершенно не нужны

для описания алгоритма оптимизации, роль метафор часто преувеличивается

их авторами.

Роевые алгоритмы оптимизации могут рассматриваться как итеративные

процедуры поиска, где рой это множество взаимодействующих частиц, ко-

торые определяют потенциальное решение задачи оптимизации в D-мерном

пространстве. Итоговое решение может быть представлено либо отдельной

частицей (координаты частицы в пространстве поиска), либо группой частиц,

где каждая частица представляет собой часть решения. Существуют две ос-

новные схемы кодирования возможных решений: векторное и представление

в виде графа. В векторном типе представления каждое возможное решение

кодируется строкой значений:

(1)

xi = (xi1,xi2,... ,xiD

) i = 1,2,...,N,

где N размер популяции, D размерность пространства поиска.

Многие задачи комбинаторной оптимизации, например задача коммивоя-

жера, могут быть представлены в виде графа. В таком представлении части-

цы перемещаются от одного узла к другому, пока не пройдут все узлы, и не

будет найдено полное решение проблемы (путь, соединяющий все города).

Схемы кодирования во многом определяют способ формирования новых

вариантов решения. В большинстве роевых алгоритмов новые решения ге-

нерируются случайным образом или с использованием эвристики, которая

объединяет существующие решения для получения нового. Для векторного

представления типичный метод обновления выполняется на основе уравнения

(2)

xi(t + 1) = xi(t) + Δi

(t + 1),

где xi(t)

текущее решение, xi(t + 1) обновленное решение, Δi(t) мо-

дифицирующий вектор, t текущая итерация. Модифицирующий вектор

7

может быть сформирован так: 1) на основе градиента; 2) перестановкой от-

дельных частей нескольких решений; 3) внесением направленного возмуще-

ния, вычисленного как разность двух решений, умноженная на равномерно

распределенное случайное число; 4) внесением случайного возмущения, ос-

нованного на распределениях Гаусса, Коши, Леви.

В силу ограниченности объема статьи будет рассмотрен только векторный

тип представления решения.

Большинство роевых алгоритмов имеют сходную структуру, в которой

можно выделить ключевые компоненты и функции:

1) инициализация задание значений параметрам алгоритма, формиро-

вание начальной популяции;

2) диверсификация (глобальный поиск) генерация новых решений или

исследование всего пространства поиска, когда модифицирующий вектор мо-

жет принимать большие значения, обеспечивая разнообразие решений и не

позволяя застрять в локальном оптимуме;

3) интенсификация (локальный поиск) улучшение ранее найденных ре-

шений, выполняемое на ограниченном пространстве поиска, в этом случае

модифицирующий вектор принимает малые значения.

Перечисленные выше компоненты реализуют вычислительные процедуры,

например диверсификация почти всегда выполняется путем рандомизации, а

интенсификация реализуется путем незначительного изменения лучших ре-

шений. Роевые алгоритмы можно классифицировать на две группы. В первую

группу входят алгоритмы, в которых явно присутствуют компоненты дивер-

сификации и интенсификации, например меметические алгоритмы [16], алго-

ритм на основе теории электромагнетизма [17], алгоритм ворон [18], прямой

алгоритм муравьиной колонии [19]. Ко второй группе относятся алгоритмы

с одним выражением, отвечающим как за диверсификацию, так и за интен-

сификацию, например алгоритм роящихся частиц [20], алгоритм “кукушкин

поиск” [21]. Для соблюдения баланса между диверсификацией и интенсифи-

кацией необходима мера измерения популяционного разнообразия, определив

которую, можно поддерживать баланс путем изменения параметров алгорит-

ма или гибридизации.

Типичным представителем алгоритмов с одним выражением является ал-

горитм роящихся частиц, являющийся прототипом для реализации многих

последующих алгоритмов и примером для иллюстрации методов повышения

эффективности. Далее приведено краткое описание этого алгоритма.

3. Стандартный алгоритм роящихся частиц

Алгоритм роящихся частиц имеет мало настраиваемых параметров,

небольшое требование к памяти, что делает его вычислительно эффектив-

ным. Алгоритм роящихся частиц [20] это стохастический метод поиска,

основанный на итеративном взаимодействии частиц, образующих рой. Пере-

мещение частицы в пространстве поиска определяют три фактора: инерция,

память, сотрудничество. Инерция подразумевает, что частица не может мгно-

венно изменить свое направление движения. Каждая частица имеет память

8

и хранит свою лучшую позицию в пространстве поиска. Известна частице и

лучшая позиция роя. Зная эти две позиции, частица динамически изменя-

ет скорость согласно ее собственному опыту и опыту полета других частиц.

Таким образом, движение каждой частицы задается ее лучшей позицией, ее

текущей скоростью, ускорением, заданным предыдущей позицией, и уско-

рением, заданным лучшей частицей в рое. Рой прекращает движение при

выполнении хотя бы одного из следующих условий: рой достиг состояния

равновесия, найдено оптимальное решение (ошибка меньше заданной), вы-

полнено заданное количество итераций. Пространство поиска множество

действительных чисел, рой состоит из N частиц-решений. Позиция i-й части-

цы определяется вектором (1). Лучшая позиция, которую занимала i-я части-

ца, определяется вектором pi = (pi1, pi2, . . . , piD), модифицирующий вектор в

выражении (2) определяется скоростью частицы vi = (vi1, vi2, . . . , viD). Ско-

рость и положение i-й частицы на итерации t + 1 определяют уравнения

xi(t + 1) = xi(t) + vi(t + 1),

vi(t + 1) = w · vi(t) + c1 · rand · (pi(t) - xi(t)) + c2 · Rand · (pg(t) - xi(t)),

где i = 1, 2, . . . , N ; vi(t) вектор скорости i-й частицы на итерации t; xi(t)

координаты i-й частицы на итерации t; c1, c2 положительные коэффици-

енты ускорения; pi(t) лучшая позиция i-й частицы на первых t итерациях;

pg(t) глобально лучшая позиция частицы в рое на первых t итерациях (за-

дается индексом g); w эмпирический коэффициент инерции; rand, Rand

случайные числа из диапазона [0; 1].

Если коэффициенты ускорения и инерции не меняются в процессе рабо-

ты алгоритма, то для соблюдения баланса между диверсификацией и ин-

тенсификацией значения этих коэффициентов рекомендуется устанавливать

c1 = c2 = 1,419, а w = 0,721 [22].

Рой имеет своего рода топологию, описывающую взаимосвязи между ча-

стицами. Каждая частица имеет множество соседей. Соседями частицы мо-

жет быть весь рой или некоторое его подмножество. Две наиболее часто ис-

пользуемые топологии известны как gbest и lbest. Топология gbest является

полносвязной топологией, в отличие от lbest, в которой частица взаимодей-

ствует с ограниченным числом соседей. Алгоритм с топологией gbest быстро

сходится и имеет больше шансов застрять в локальных оптимумах. Алгоритм

с топологией lbest медленнее сходится, но более полно исследует пространство

поиска и, как правило, находит лучшее решение [3].

4. Инициализация

Если целевая функция имеет несколько локальных оптимумов, то тради-

ционные алгоритмы сходятся к одному из тех, положение которого определя-

ет процедура инициализации. Алгоритмы могут найти глобальный оптимум,

если начальные решения принадлежат области притяжения глобального оп-

тимума. Процедура инициализации играет важную роль и в роевых алгорит-

мах, где отсутствие разнообразия в популяции может привести к преждевре-

менной сходимости и попаданию в локальный оптимум. Таким образом, эф-

фективность методов оптимизации может быть повышена за счет разработки

9

методов генерации перспективных начальных решений. Однако на сегодняш-

ний день отсутствуют системные исследования процесса инициализации и то-

го, как начальные распределения решений могут влиять на эффективность

роевых алгоритмов при решении определенного класса проблем [1].

Процедура инициализации включает задание начального размера популя-

ции и собственно создание начальной популяции. Размер популяции влия-

ет на надежность и вычислительные затраты алгоритма. Небольшой размер

популяции может привести к быстрой сходимости к локальному оптимуму,

большой размер увеличит вычислительные затраты и может привести к мед-

ленной сходимости [23]. Размер популяции может быть увязан с размерно-

стью пространства поиска D. В [8] предлагается определять размер популя-

ции в алгоритме роящихся частиц как

[10 + 2√D],

где [·]

целая часть числа. Для задач большой размерности (D ≥ 50) в [24]

размер популяции в алгоритме “кукушкин поиск” предлагается устанавли-

вать равным D. Авторы [25] определяют размер популяции в модифициро-

ванном алгоритме искусственной пчелиной колонии как 5D, а в модифициро-

ванном алгоритме серого волка размер популяции задается равным 3D [26].

Однако чаще всего размер популяции выбирается экспериментальным путем.

Другим подходом к решению этой проблемы является введение адаптивного

метода формирования размера популяции, который делает роевый алгоритм

менее чувствительным к начальному выбору размера популяции.

Можно выделить несколько различных стратегий создания начальной по-

пуляции: стохастические методы, квазислучайные последовательности, ме-

тод оппозиционного обучения, многошаговый метод. Группу стохастических

методов можно разделить на две подгруппы: генераторы псевдослучайных

чисел и генераторы хаотических чисел. В роевых алгоритмах при отсутствии

априорных знаний генерация случайных чисел является распространенным

способом создания начальной популяции, которая может быть определена

как

(

)

xi,j ∼ U

lowj; upj

,

i = 1,2,...,N, j = 1,2,...,D,

где U представляет собой равномерное распределение, lowj, upj нижнее и

верхнее значения j-й переменной.

Равномерное распределение начальных решений по пространству поис-

ка не является единственно возможным, наряду с равномерным использует-

ся распределение Леви, бета-распределение, нормальное распределение, лог-

нормальное распределение и др. [1]. Основным достоинством метода на осно-

ве псевдослучайных чисел является простота, поскольку средства генерации

псевдослучайных чисел присутствуют в каждом языке программирования, с

их помощью легко решается проблема инициализации начальной популяции.

Для создания стохастических начальных популяций используются хаоти-

ческие методы, для которых характерны эргодичность, случайность и ре-

гулярность [27]. Чтобы создать хаотическую популяцию, нужна хаотическая

10

карта. В очень общем виде одномерные хаотические карты работают следую-

щим образом [27]:

(

)

xt+1i,j = fm

xti,j

,

где xti,j

j-я переменная i-й частицы на итерации t, m определяемый

пользователем параметр. Обычно x0i,j выбирается случайным образом, по-

следующие точки создаются путем многократного применения хаотической

карты. Наиболее часто применяются следующие хаотические карты: логисти-

ческое отображение (Logistic Map), синусоидальное отображение (Sinusoidal

iterator), отображение tent-map, гауссово отображение (Gauss Map).

Авторы [28] считают что, хотя метод генерации случайных чисел очень

прост с точки зрения программирования, он не очень эффективен, потому

что сгенерированные компьютером числа не покрывают равномерно про-

странство поиска. Квазислучайные последовательности относятся к детер-

минированным методам, генерирующим одну и ту же популяцию. Детерми-

нированные методы инициализации разработаны для обеспечения равномер-

ного распределения частиц на всем пространстве поиска. В последнее время

эти методы привлекают больше внимания, потому что в отсутствие предва-

рительных знаний о проблеме, однородность начальной популяции может по-

высить исследовательскую способность алгоритма на его ранних стадиях [27].

В квазислучайной последовательности разнообразие популяции, как прави-

ло, лучше, чем при псевдослучайной генерации. Для формирования началь-

ной популяции алгоритма роящихся частиц использовались квазислучайные

последовательности Ван-дер-Корпута [28] и Фора [29], а для инициализации

популяции алгоритма гравитационного поиска использовали генератор Собо-

ля [30].

Идея инициализации на основе оппозиционного обучения основана на про-

тивоположных отношениях между сущностями и заключается в одновре-

менном формировании как текущих решений, так и решений, противопо-

ложных текущим, используя для этого противоположные числа. В [31] да-

но определение противоположной точки в D-мерном пространстве. Пусть

z = (z1,...,zD)

точка в пространстве и zj ∈ [aj ; bj ], j = 1, 2, . . . , D. Про-

тивоположность z определяется как ž = (ž1, . . . , žD) как

(3)

žj = aj + bj - zj .

Одновременное использование случайного решения и его противоположно-

сти дает больше шансов найти оптимальное решение [31]. Можно предпо-

ложить, если текущие случайно сгенерированные решения далеки от оп-

тимального решения, то их противоположности будут ближе к этому ре-

шению. Приведенное выше определение противоположной точки называет-

ся противоположностью типа I, она определяется в соответствии с отно-

шением между точками в пространстве поиска без учета их функциональ-

ных значений. Противоположность типа II определяется с учетом функцио-

нального пространства задачи следующим образом [31]. Предположим, что

для функции f (x1, x2, . . . , xD) предопределены или могут быть оценены ymin

и ymax. Пусть y = f (x1,x2,... ,xD) ∈ ℜ и y ∈ [ymin;ymax]. Для каждой точки

11

x = (x1,x2,...,xD) противоположная точка типа II x = (x1, x2,..., xD) опре-

деляется как

(4)

xII = {x| y = ymin + ymax

− y}.

Авторы [31] теоретически доказали, что в общем случае противоположные

числа с бóльшей вероятностью будут ближе к оптимальному решению, чем

чисто случайные; в [32] теоретические исследования были подтверждены экс-

периментально применительно к метаэвристике “дифференциальная эволю-

ция”. Применением инициализации на основе оппозиционного обучения улуч-

шены алгоритм роящихся частиц [33], алгоритм на основе стада криля [34],

алгоритм на основе электромагнетизма [17]. На первом этапе методы оппози-

ционного обучения генерируют набор точек, называемых исходной популяци-

ей. Исходная популяция может быть сгенерирована с использованием любого

метода инициализации, например генератором равномерно распределенных

чисел [32] или хаотической картой [35]. Затем используются некоторые про-

стые эвристические правила (например выражения 3 или 4) для создания

другой популяции такого же размера. Итоговая популяция формируется пу-

тем объединения обеих популяций на основе значений целевых функций вхо-

дящих в них решений.

Примером многошагового метода является центроидальная тесселяция

Вороного. С помощью этого метода можно разделить пространство поиска на

равные объемы, не используя целевую функцию. Врéменная популяция со-

здается с использованием генератора равномерно распределенных чисел или

более сложных методов. Затем с помощью множества случайно сгенерирован-

ных вспомогательных точек пространство поиска разделяется на несколько

областей. Эти области итеративно расширяются, пока не будут выполнены

некоторые критерии. Центры областей используются в качестве начальной

популяции [36]. Другим примером многошагового метода является подход к

поиску перспективных регионов, названный Smart Sampling [37], который ге-

нерирует начальные решения, оценивает их, используя целевую функцию,

и разделяет их на два класса

“хорошие” и “плохие”

на основе порога,

применяемого к значению целевой функции каждого решения. На размечен-

ной выборке начальных решений строится классификатор, который позво-

ляет проверять, является ли вновь сгенерированное решение хорошим без

использования целевой функции. Если новое решение классифицируется как

“хорошее”, оно может быть оценено целевой функцией. Подход Smart Sam-

pling эффективен только в том случае, если вычислительно затратным явля-

ется процесс определения значения целевой функции.

В [1] предложен метод инициализации на основе латинского гиперкуба,

суть которого заключается в разделении значений каждой координаты по-

иска на N равных интервалов, в каждый из которых попадает по одному

начальному решению. Такой метод позволяет избежать проблемы чрезмер-

ного скопления решений в одной точке пространства поиска. Исследования

показывают, что такой метод может обеспечить лучшее покрытие, чем рав-

номерное распределение [1].

Автор обзора [1] отмечает следующие проблемы рассмотренных методов

инициализации: стохастические методы просты и легко реализуемы, однако

12

они плохо масштабируемы; хаотические методы сильно зависят от началь-

ных условий; методы оппозиционного обучения генерируют популяцию удво-

енного размера, что приводит к удваиванию вычислительных затрат; метод

латинского гиперкуба очень эффективен при небольших размерностях про-

странства поиска, но он не дает явного преимущества при решении задач

высокой размерности [1]. Как не существует единственного эффективного

алгоритма оптимизации (“теорема о бесплатных завтраках” [7]), так не су-

ществует единственного эффективного алгоритма инициализации, в [1] на

примерах показано, что для разных задач следует использовать разные ал-

горитмы.

5. Меры популяционного разнообразия

Эффективность роевого алгоритма во многом определяет баланс между

фазами диверсификации и интенсификации. О том, в какой фазе находится

алгоритм в каждый момент выполнения, можно судить по значению попу-

ляционного разнообразия. Разнообразие определяется как расстояние между

решениями в пространстве поиска или как различие между значениями целе-

вых функций найденных решений. Недостаточное популяционное разнообра-

зие приводит к быстрой сходимости к потенциально неоптимальному реше-

нию. Для управления поиском решений необходимо иметь метрику для опре-

деления популяционного разнообразия. Метрики, основанные на расстоянии

Минковского, наиболее часто используются для определения разнообразия.

В [38] популяционное разнообразие определяется как

v

u

∑u∑

1

√

Div =

(xij(t) - xj(t))2,

N

i=1

j=1

где xj(t) среднее значение по j-му признаку на итерации t.

В [35, 39] разнообразие популяции алгоритма роящихся частиц и алгорит-

ма искусственной пчелиной колонии рассчитывается по формуле

∑ ∥xi - x∥

1

i=1

Div =

N max

∥xi - xj∥

1≤i,j≤N

В [40] разнообразие популяции основано на норме L1:

∑∑

1

Div =

|xij (t) - xj (t)| .

N ·D

i=1 j=1

По мнению авторов [41], медиана более эффективно указывает на центр

j-го измерения, поэтому в [41] среднее значение xj(t) заменено на медиану.

13

В [42] разнообразие определяется через Евклидово расстояние относитель-

но лучшего решения в популяции

v

u

∑u∑

1

√

Div =

(xij (t) - pjg(t))2.

N

i=1

j=1

Разнообразие может быть определено как значение расстояния между луч-

шими решениями. В [43] это расстояние между всеми лучшими решениями,

найденными каждой из частиц,

∑

∑

2

Div =

|pi - pj| .

N (N - 1)

i=1 j=i+1

В [44] разнообразие определяется как значение расстояния между текущим

и усредненным лучшим решением каждой частицы:

∑

1

Div =

|pi - pi| .

N

i=1

В качестве показателя преждевременной сходимости в [45] рассматрива-

ется разность целевых функций лучших решений на двух итерациях:

δ(t) = f (pg(t - 1)) - f (pg(t)) .

Констатируется преждевременная сходимость, если для заданного числа по-

следовательных итераций значение δ (t) меньше заданного порога.

Мера разнообразия, основанная на относительном расстоянии частиц до

глобально лучшей частицы, предложена в [45]:

∥xi - pg∥

Div = max

√

i=1,...,N

∑ (xmax,j - xmin,j

)2

j=1

Популяционное разнообразие может быть определено на основе индекса

квази-энтропии, который вычисляется по формулам [46]

∑

QE(t) = - Pi(t)log Pi(t),

i=1

f (pi(t))

Pi(t) =

,

∑

f (pi(t))

i=1

где f(pi(t))

лучшее значение целевой функции i-й частицы на первых t

итерациях. Авторы [46] предполагают, что на ранних стадиях оптимизации

ни одна из частиц не находится в области глобального оптимального решения

и индекс QE изменяется незначительно. На более поздних стадиях, когда

все больше частиц попадают в область глобального оптимального решения,

индекс QE резко уменьшается и, когда он достигнет определенной доли от

начального значения, запускается локальный поиск.

14

Разнообразие в [44] определяется через распределение текущих скоростей

частиц

∑

1

Div =

|vi - vi| ,

N

i=1

где vi, vi текущее и среднее значения скорости i-й частицы соответственно.

Популяционное разнообразие может быть определено на основе значения

целевой функции. В [1] популяционное разнообразие определяется по форму-

ле

min (fbest , favg )

Div =

,

max (fbest , favg )

где fbest (t), fworst (t), favg (t)

лучшее, худшее и среднее значения целевой

функции.

В [16, 47] проведено исследование метрик разнообразия при поиске опти-

мума различных математических функций. Для исследования были выбраны

метрики

{

}

fbest - favg

ξ = Div = min

1

,

,

fbest

{

}

σf

ν = Div = min

1

,

,

favg

favg -fbest

ψ = Div = 1 -

,

fworst - fbest

(5)

|fbest - favg |

χ = Div = 1 -

,

max |fbest - favg |k

σf

ϕ = Div =

,

|fworst - fbest |

где σf

стандартное отклонение от среднего значения целевой функции.

Недостатками метрики ξ являются слабая устойчивость и сильная зависи-

мость от области изменения целевой функции. Однако с ее помощью удает-

ся получить хороший результат для многомерных и сложных ландшафтов

целевых функций, которые имеют ограниченный диапазон изменчивости и

минимум у которых находится около нуля (например в инженерных задачах

для минимизации ошибки). Метрика ν зависит от стандартного отклонения

и, следовательно, от распределения значений целевой функции по всем эле-

ментам популяции. Эта метрика также как и ξ-метрика хорошо работает с

целевыми функциями, имеющими ограниченный диапазон изменчивости, но

она менее чувствительна к разбросам значений этих функций. В отличие от

ξ- и ν-метрик, ψ не зависит от диапазона изменения значений целевой функ-

ции. Эта метрика очень чувствительна к небольшим изменениям и поэтому

особенно подходит для ландшафтов целевых функций, содержащих плато и

15

области с небольшим градиентом. Метрика χ характеризует не только ме-

ру разнообразия, но и является оценкой лучшего результата по сравнению с

другими решениями. Метрика ϕ может рассматриваться как комбинация ν-

и ψ-метрик [16, 47].

Метрик разнообразия столько же, сколько проблем, т.е. метрики разно-

образия специфичны для конкретной проблемы [48]. Не существует “наилуч-

шей” метрики в целом, но есть “наиболее подходящая” метрика, зависящая не

только от ландшафта целевой функции, но и от алгоритма оптимизации [16].

Автор [16] утверждает, что эффективная метрика разнообразия для эволюци-

онной стратегии вряд ли будет эффективной для определения разнообразия

для дифференциальной эволюции; это соображение автор [16] рассматривает

как следствие теоремы об отсутствии бесплатных завтраков [7].

Разнообразие характеризует состояние популяции или распределение ча-

стиц. Большое значение Div означает, что поиск находится в состоянии ди-

версификации, малое значение свидетельствует о том, что поиск находится

в состоянии интенсификации [40]. С помощью измерения разнообразия рас-

считывается доля диверсификации и интенсификации на каждой итерации:

(

)

Div

Xdv =

,

Divmax

)

( |Div - Divmax|

Xit =

Divmax

Используя приведенные выше соотношения, можно поддерживать разнооб-

разие популяции на достаточном уровне, не допуская ранней сходимости ал-

горитма. Механизмы поддержки популяционного разнообразия рассмотрены

в разделе 6.

6. Механизмы поддержки популяционного разнообразия

Результаты поиска, выполняемого роевым алгоритмом, зависят от уста-

новленного или динамического баланса между двумя компонентами алго-

ритма: диверсификацией и интенсификацией. Успешно работающий компо-

нент диверсификации обеспечит поиск на всем пространстве поиска, однако

этот компонент может замедлить процесс сходимости алгоритма. Существу-

ют несколько основных механизмов поддержания разнообразия: 1) ре-ини-

циализация; 2) введение новых операторов: хаотических процедур и операто-

ров кроссовера и мутации; 3) разделение популяции на субпопуляции.

6.1. Ре-инициализация

Ре-инициализация частиц является эффективным способом поддержания

разнообразия, такой механизм способствует выходу частиц из локальных оп-

тимумов и дает алгоритму возможность находить “достаточно хорошее” ре-

шение. Различают случайную ре-инициализацию, когда повторно генериру-

ются большинство частиц, и элитную ре-инициализацию, когда сохраняются

решения с лучшей целевой функцией [44].

16

В [49] новое решение генерируется на основе предыдущего решения пу-

тем добавления в него шума. По количеству повторно инициализированных

решений определено три стратегии.

1. Количество ре-инициализированных решений уменьшается в процессе

поиска. Более половины решений ре-инициализируются в начале поиска, а за-

тем количество ре-инициализированных решений линейно уменьшается при

каждой ре-инициализации. Эта стратегия заключается в том, чтобы сначала

сосредоточиться на диверсификации, а в конце поиска на интенсификации.

2. Часть решений повторно инициализируется после заданного числа ите-

раций. Количество ре-инициализированных решений не меняется в процессе

поиска.

3. Количество ре-инициализированных решений увеличивается в процессе

поиска. Менее половины решений ре-инициализируются в начале поиска, и

число ре-инициализированных решений линейно увеличивается при каждой

ре-инициализации. Эта стратегия заключается в том, чтобы сначала сосре-

доточиться на интенсификации, а в конце поиска на диверсификации.

В [50] ре-инициализация выполняется следующим образом: через заданное

количество итераций в текущую популяцию из N решений добавляется еще N

случайно сгенерированных решений; из полученных 2N решений выбираются

N лучших; процесс повторяется заданное количество раз. В [51] предлагаются

две стратегии ре-инициализации алгоритма роящихся частиц. Первая страте-

гия предполагает повторную инициализацию отдельных частиц, чье лучшее

положение не улучшается после заданного числа итераций. Вторая страте-

гия подразумевает ре-инициализацию всей популяции, когда число лучших

частиц в рое, имеющих значение целевой функции, близкое к значению целе-

вой функции глобально лучшей частицы, превысит заданное пороговое значе-

ние. В [52] предлагается элитная схема ре-инициализации, когда случайным

образом генерируются все решения за исключением лучшего, полученного на

последней итерации, при условии, что после заданного числа итераций отно-

сительное улучшение значения целевой функции меньше порогового. В [45]

активируется процедура ре-инициализации, если подтверждается состояние

преждевременной сходимости или недостаточного популяционного разнооб-

разия. В этом случае каждое решение заменяется на его противоположность,

используя метод оппозиционного обучения.

6.2. Введение новых операторов

6.2.1. Эволюционные операторы

Операторы кроссовера и мутации, применяемые в эволюционных алгорит-

мах, все чаще применяются и в роевых алгоритмах для увеличения популя-

ционного разнообразия [34, 53-56]. Оператор мутации, вносящий возмущение

в решение z ∈ ℜD, может быть определен как

x`= x + Z,

где Z

вектор случайных чисел, распределенных по заданному закону.

Примерами являются операторы мутации на основе распределения Гаусса

17

Таблица 1. Описание операторов мутации

Схема

Оператор мутации

De/Best/1

x = pg + F · (xr1 - xr2)

De/Best/2

x = pg + F · (xr1 - xr2 + xr3 - xr4)

De/CurrToBest/1 x = xi + K · (pg - xi) + F · (xr1 - xr2)

De/CurrToRand/1 x = xi + K · (xr3 - xi) + F · (xr1 - xr2)

De/Rand/1

x = xr1 + F · (xr2 - xr3)

De/Rand/2

x = xr5 + F · (xr1 - xr2 + xr3 - xr4)

De/RandToBest/1 x = xr3 + K · (pg - xr3) + F · (xr1 - xr2)

(

(

))

Z ∼N

µ,σ2

и Коши (Z ∼ C(x0, γ)). Динамическая регулировка парамет-

ров σ2 и γ в процессе выполнения роевого алгоритма позволяет изменять

баланс между диверсификацией и интенсификацией. Большие значения ука-

занных параметров могут привести к появлению сильно возмущенных ре-

шений, малые значения параметров способствуют выполнению локального

поиска.

Оператор мутации может быть основан не только на законах распределе-

ния. Популяционное разнообразие алгоритма роящихся частиц и гравитаци-

онного поиска в [57, 58] регулируется оператором мутации, построенным на

основе вейвлета Морле:

{xij(t + 1) + (xmax,j - xij (t + 1)) , σ > 0,

xij(t + 1) =

xij(t + 1) + (xij(t + 1) - xmin,j) , σ ≤ 0,

(

1

(z

a

)

z)

σ=

2

cos

5

,

√ae

a

где a масштабный коэффициент, z ∈ [-2,5a; 2,5a].

Авторы [59] вводят в алгоритм гравитационного поиска знаковую мута-

цию:

xi(t + 1) = xi(t) + si · Δi(t + 1),

{-1, rand < P

s,

sij =

1, rand ≥ Ps,

где Δi модифицирующий вектор, вычисленный по оригинальной схеме гра-

витационного поиска, si вектор мутации, Ps вероятность мутации.

В роевых алгоритмах для увеличения популяционного разнообразия ча-

сто применяется оператор мутации, заимствованный из алгоритма диф-

ференциальной эволюции [60-63]. В табл. 1 приведены операторы мутации

[64], здесь pg

лучшее решение в текущей популяции; F и K коэффи-

циенты масштабирования, действительные положительные числа; индексы

r1,r2,r3,r4,r5 = 1,N

случайно сгенерированные целые числа, причем r1 =

= r2 = r3 = r4 = r5 = i.

18

Оператор кроссовера на основе исходного списка решений генерирует но-

вые решения путем “смешивания” информации о решениях из исходного спис-

ка. Оператор кроссовера O(xi, xk, j) применяется для формирования нового

решения путем изменения j-го элемента xij и xkj в выбранных решениях.

Новый элемент решения xlj с использованием оператора арифметического

кроссовера вычисляется по формуле

xlj = αxij + (1 - α)xkj,

где α коэффициент масштабирования, случайно выбранный из некоторо-

го интервала. Элемент решения с применением геометрического кроссовера

определяется по формуле

xlj = (xij · xkj)α , α ∈ [0,1] .

Случайный кроссовер формирует элемент решения по схеме

{xij, rand ≤ 0,5,

xlj =

xkj, rand > 0,5.

В [55] предложен оператор самоадаптирующегося кроссовера:

xlj(t + 1) = xij(t) · (1 - Cr) + xkj(t) · Cr,

f (xi(t)) - f (pg(t))

Cr = 0,8 + 0,2 ·

,

f (pw(t)) - f (pg(t))

где pw и pg худшее и лучшее решения в популяции соответственно.

В [65] приведена классификация операторов кроссовера, применяемых в

решении задач с непрерывно меняющимися параметрами, а также проведе-

но эмпирическое исследование 14 операторов кроссовера при решении задач

нахождения минимума математических функций. В [56] описан двухточеч-

ный полный кроссовер, в котором каждое из двух решений (оригинальное и

его противоположность, полученная методом оппозиционного обучения) де-

лится на три части двумя случайно выбранными точками. Новое решение

формируется путем обмена частями исходных решений. Итоговые решения

получаются после упорядочения по значению целевой функции шести новых

решений и двух исходных.

Изменяя частоту (вероятность) применения операторов кроссовера и му-

тации в роевом алгоритме, можно регулировать баланс диверсификация-

интенсификация.

6.2.2. Хаотические операторы

Существуют два способа включения хаоса в роевые алгоритмы оптими-

зации. Первый способ состоит в том, чтобы использовать последовательно-

сти, сгенерированные хаотическими системами, для замены случайных чи-

сел, используемых в оригинальном алгоритме. Другой способ заключается

19

во включении хаотического поиска в качестве локального поиска в ориги-

нальный алгоритм. Оба способа авторы [66] применяют в алгоритме гравита-

ционного поиска для повышения скорости сходимости и решения проблемы

выхода из локальных оптимумов. Двенадцать хаотических карт применяются

для настройки значений коэффициентов инерции (ωn, ωf ) в алгоритме стадо

криля [54]. Хаотические последовательности используются в качестве гене-

раторов псевдослучайных чисел в алгоритме искусственной пчелиной коло-

нии [67], алгоритме роящихся частиц [68], алгоритме кузнечика [53].

6.3. Разделение популяции на субпопуляции

Многопопуляционные методы за последние десять лет стали одними из

часто используемых методов оптимизации. Концепция этого метода следую-

щая: исходная популяция делится на несколько субпопуляций; над элемен-

тами субпопуляции выполняются некоторые эволюционные операции; взаи-

модействуя между собой, субпопуляции обмениваются элементами, дробятся,

поглощают друг друга, что способствует предотвращению преждевременной

сходимости и поддержанию популяционного разнообразия путем распределе-

ния элементов по всему пространству поиска. Многопопуляционные методы

сравнительно легко интегрируются в роевые алгоритмы оптимизации и часто

работают эффективнее, чем алгоритмы с одной популяцией [69].

Многопопуляционные алгоритмы можно классифицировать на два ти-

па: конкурирующие и кооперативные. Для алгоритмов конкурирующего ти-

па каждая субпопуляция ищет решения в области, выделенной только для

нее [70]. Кооперативные алгоритмы ведут поиск в одной и той же области,

взаимодействуя и обмениваясь информацией [71].

В [69] обозначены проблемы и решения, характерные для многопопуля-

ционных методов оптимизации. Первая проблема заключается в том, как

определить количество субпопуляций: большое их количество связано с вы-

сокими вычислительными затратами, малое количество может не привести к

желаемому эффекту. Указанная проблема решается двумя способами. Пер-

вый способ использовать фиксированное количество субпопуляций. По это-

му способу функционирует большинство многопопуляционных методов. Его

преимущество заключается в простоте реализации. Однако число субпопуля-

ций определяется эмпирически, и трудно получить единые и эффективные

правила для определения этого числа при решении различных практических

задач. Второй способ заключается в динамическом изменении числа субпо-

пуляций во время оптимизации. Выдвигается предположение, что на началь-

ных этапах требуется большое количество субпопуляций для увеличения по-

пуляционного разнообразия и распределения возможных решений по всему

пространству поиска. На поздних этапах небольшое количество субпопуля-

ций способствует уменьшению разнообразия, что может быстрее приблизить

решение к глобальному оптимуму.

Вторая проблема заключается в определении параметров коммуникации

(миграции) между субпопуляциями. К таким параметрам относятся: 1) коли-

чество решений, подлежащих обмену; 2) коммуникационная (миграционная)

политика, которая определяет, какие решения должны быть заменены реше-

20

ниями других субпопуляций; 3) частота коммуникаций; 4) топология комму-

никаций. Чаще других применяется коммуникационная политика, основан-

ная либо на жадном алгоритме, либо на случайном отборе, например элитар-

ная политика миграции предполагает замену худших решений в субпопуля-

ции лучшими решениями другой субпопуляции. Среди множества топологий

можно выделить иерархическую и случайную топологии, а также линейные

(цепочечные), кольцевые и решетчатые (клеточные) топологии, которые мо-

гут быть однонаправленными или двунаправленными.

Одной из широко применяемых многопопуляционных стратегий является

модель островов [72], в которой популяция делится на несколько субпопуля-

ций, называемых островами, эволюционирующие независимо друг от друга,

но периодически взаимодействующие друг с другом посредством миграций.

Схема взаимодействия, состоящая из последовательно происходящих процес-

сов миграции и эволюции, позволяет создать баланс между диверсификацией

и интенсификацией [18]. В [73] приводится динамическая островная модель,

в которой размер популяции фиксирован, но размер каждой субпопуляции

может меняться; топология задается полносвязным неориентированным гра-

фом. На каждой итерации алгоритма каждое решение мигрирует с исходного

острова на остров назначения в соответствии с заданными вероятностями и

динамически изменяющейся матрицей миграции, которая формируется с ис-

пользованием алгоритма QLearning [74]; вместо единственной миграционной

политики используется несколько миграционных политик.

В [18] предлагается иерархическая модель с 16 островами и четырьмя то-

пологиями миграции. Острова нижних уровней ответственны за глобальный

поиск, острова верхнего уровня выполняют локальный поиск. После каж-

дой итерации лучшее решение мигрирует в соседнюю субпопуляцию верхне-

го уровня. Миграция между субпопуляциями одного уровня поддерживается

путем замены лучшего решения текущей субпопуляции худшим решением

соседнего острова.

Коммуникации могут быть синхронными или асинхронными. В первом

случае все субпопуляции обновляют свои решения одновременно, тогда как

во втором случае решения обновляются по наступлению какого-либо собы-

тия. Обе модели имеют свои преимущества и недостатки. Синхронные ост-

ровные модели проще в реализации, тогда как асинхронные модели являются

более гибкими и эффективными [75]. Важным улучшением модели островов

является слабосвязанная модель с виртуальным хранилищем совместно ис-

пользуемых данных, получившая название “океан” [76]. “Океан” позволяет

легко реализовать гетерогенность и динамическое изменение числа островов,

уменьшить задержку на обмен решениями за счет того, что “океан” хранит

решения, которые были отправлены островом, но еще не приняты другим ост-

ровом, таким образом реализован асинхронный режим обмена решениями.

В изложенном авторами [77] подходе на островах независимо работают четы-

ре алгоритма: алгоритм пчелиной колонии для генерации правил нечеткого

классификатора, алгоритм пчелиной колонии для оптимизации параметров,

алгоритм адаптивной эволюционной стратегии и метод наименьших квад-

ратов. “Океан” реализует обмен только множеством лучших решений, нахо-

21

дящихся в нем. Моменты отправки и приема лучших решений из “океана”

выбирают сами алгоритмы, выполняющиеся на островах.

В клеточной топологии популяция делится на множество субпопуляций

малого размера, обычно состоящих только из одного решения. Коммуникации

происходят только в пределах небольшой окрестности, определенной вокруг

отдельного решения или малой субпопуляции. При такой топологии снижа-

ется риск преждевременной сходимости по причине медленного распростра-

нения информации от соседа к соседу [78]. В качестве топологий окрестности

в [79] рассматриваются три клеточные структуры кубическая, тригональ-

ная и гексагональная, интегрированные в алгоритм роящихся частиц. В [80]

описан алгоритм роящихся частиц с клеточно-структурированной популяци-

ей, частицы в которой распределены в двумерной сетке и взаимодействуют

со своими соседями в соответствии с заданной окрестностью; авторы иссле-

дуют шесть типов окрестности: две линейные (L5, L9) и четыре компактных

окрестности (C9, C25, C13, C21); для обработки краевых ячеек используется

тороидальная структура.

Третья проблема многопопуляционных методов как определить область

поиска каждой субпопуляции. Одним из решений этой проблемы является

кластеризация. Авторы [81] используют метод кластеризации для разделения

популяции в алгоритме гравитационного поиска. При инициализации размер

субпопуляции выбирается случайным образом из множества T = {5, 10, 25}.

После каждого цикла работы алгоритма размер субпопуляции изменяется

по результатам поиска. Если лучшее решение в субпопуляции не улучшает-

ся, из множества T случайным образом выбирается новое значение, в про-

тивном случае размер не меняется. В [82] предлагается многопопуляционный

алгоритм роящихся частиц, который использует метод иерархической класте-

ризации, позволяющий адаптивно корректировать количество необходимых

субпопуляций. Алгоритм кластеризации на основе нечетких c-средних в [83]

используется для адаптивного разделения популяции на кластеры в алго-

ритме роящихся частиц. Для каждого кластера вычисляется его адаптивная

ценность, полученная в результате конкурентного обучения. Кластеры ран-

жируются в соответствии с их ценностью. Кластеры с малой адаптивной цен-

ностью поглощаются соседними кластерами, имеющими бóльшую ценность.

Роевый алгоритм со структурированной популяцией имеет больше пара-

метров, чем его аналог с единой популяцией. Дополнительно введенные па-

раметры существенно влияют на работу алгоритма, поэтому настройка и ре-

гулировка этих параметров имеют важное значение для повышения эффек-

тивности алгоритма [75].

7. Настройка и регулировка значений параметров

Роевые алгоритмы характеризуются наличием стохастических компонен-

тов и свободных параметров, которые могут быть установлены пользовате-

лем. Основная проблема здесь в том, что нет никакой гарантии, что хорошо

настроенный алгоритм, хорошо работающий для одного типа проблем, может

хорошо работать для другого типа проблем. Эффективность роевых алгорит-

мов во многом зависит от значений параметров, задаваемых в начале работы

22

и изменяемых в процессе выполнения алгоритма. По сути, это две проблемы:

проблема автономной настройки и проблема регулировки значений парамет-

ров “на лету”. Процедура настройки параметров требует большого количества

прогонов алгоритма для анализа его эффективности на одном или несколь-

ких экземплярах проблем с различными настройками параметров. Процедура

эта является вычислительно затратной, что является основным недостатком

настройки параметров. Преимущество настройки параметров заключается в

ее универсальности, хороший метод настройки применим для задания пара-

метров многих различных метаэвристик. Недостатком регулировки парамет-

ров является ее узкая специализация, хорошо подобранные стратегии управ-

ления для одного алгоритма обычно не подходят для другого алгоритма [84].

7.1. Автономная настройка параметров

Автономная настройка параметров выполняется перед началом работы ал-

горитма. Цель состоит в том, чтобы априори найти лучшее сочетание значе-

ний параметров. Автономная настройка параметров является сложной про-

блемой из-за большого количества значений, которые может принимать каж-

дый параметр. При этом необходимо учитывать, что параметры некоторых

алгоритмов являются взаимозависимыми. Теоретический анализ, проведен-

ный авторами [85], показал, что для обеспечения стабильной работы алгорит-

ма роящихся частиц необходимо выполнение следующего соотношения между

параметрами алгоритма:

(

)

(c1 + c2) < 24

1-ω2

/(7 - 5ω) .

А в [86] условие сходимости алгоритма роящихся частиц определено как

1 > ω > ((c1 + c2)/2 - 1) ≥ 0.

На ранних этапах исследований метаэвристик настройка параметров осу-

ществлялась либо “вручную” путем проведения серий экспериментов с раз-

личными конфигурациями параметров и выбора среди них лучшей на основе

полученных результатов, либо “по аналогии” с применением настроек, пока-

завших хорошие результаты при решении подобных проблем [87].

В последние два десятилетия проблеме автоматической настройки пара-

метров стали уделять больше внимания [84, 87-91]. В [92] утверждается, что

при разработке и создании нового метаэвристического алгоритма только 10 %

времени тратится на разработку алгоритма, а 90 % времени уходит на тон-

кую настройку его параметров. Актуальность этой проблемы определяется

следующим [89]:

1) использование методов автоматической настройки параметров может

сократить затраты времени и позволит достичь лучших результатов по срав-

нению с ручными методами;

2) методы автоматической настройки могут помочь решить вопрос, пре-

восходит ли один алгоритм другой, потому что он принципиально лучше или

потому что его разработчики более успешно подобрали его параметры;

23

3) конечные пользователи часто не знают о влиянии настроек параметров

алгоритма на его эффективность, поэтому просто используют настройки по

умолчанию, однако конфигурация параметров по умолчанию может не рабо-

тать должным образом для конкретных проблемных ситуаций, с которыми

сталкивается пользователь;

4) автоматическая настройка параметров позволяет устранить необходи-

мость пользователю устанавливать связь между настраиваемыми парамет-

рами и решаемой проблемой.

Проблема настройки параметров может рассматриваться как проблема оп-

тимизации, часто называемая мета-оптимизацией. Здесь алгоритм настройки

является мета-оптимизатором, который ищет оптимальный (или по крайней

мере хорошо работающий) набор параметров для целевого (настраиваемо-

го) алгоритма. Сложность проблемы автоматической настройки обусловлена

стохастической природой целевого алгоритма и метрики его эффективности

[84, 90].

Конечной целью оптимизации является решение конкретных проблем, воз-

никающих в реальном мире, но чтобы не решать каждую конкретную задачу

отдельно и заново не начинать исследование с нуля, когда появляется новая

задача, можно предположить, что некоторые из задач имеют общую структу-

ру и могут рассматриваться как различные примеры общей проблемы. Этот

шаг абстракции является фундаментальным для формального развития оп-

тимизации и открывает путь к разработке алгоритмов и формальному ана-

лизу их свойств [88]. Если настройка алгоритма выполняется на одном при-

мере проблемы, показателем эффективности может быть среднее значение

показателя эффективности целевого алгоритма на нескольких прогонах. По-

казатель эффективности целевого алгоритма для множества примеров про-

блемы может быть определен как средняя эффективность алгоритма по дан-

ному множеству. Однако в некоторых случаях показатели эффективности

могут сильно различаться, тогда показатели нормализуют для каждого при-

мера [88]. Для нахождения оптимальной настройки параметров (или конфи-

гурации) обычно требуется большое количество прогонов целевого алгоритма

с разными конфигурациями на различных примерах. Таким образом, про-

блема настройки параметров является вычислительно дорогой и трудоемкой

задачей [84].

Существующие методы автоматической настройки работают по принци-

пу генерация-оценка, т.е. путем генерации различных конфигураций пара-

метров и их оценки с помощью метрик эффективности [90, 91]. В качестве

методов генерации часто используются методы планирования эксперимента

[92-94], а также кригинг модели [95] и метод прямого поиска на адаптивных

сетках [96]. Простым является метод повторной оценки параметров, который

оценивает каждую конфигурацию несколько раз и возвращает среднее значе-

ние [90]. В методе грубой силы сначала генерируется семейство конфигураций

параметров, как правило, с помощью методов планирования эксперимента,

затем оценивается эффективность каждой конфигурации. В этом методе за-

траты на тестирование низкоэффективных конфигураций равны затратам

на тестирование высокоэффективных конфигураций. Кроме того, здесь нет

критерия, который определяет, сколько прогонов каждой конфигурации на

24

каждом экземпляре должно быть выполнено для обработки стохастичности

целевого алгоритма [84]. Метод F-Race [88] поэтапно оценивает возможные

конфигурации на примерах проблемы. После каждого этапа с использова-

нием непараметрического теста Фридмана проверяется, есть ли статистиче-

ские значимые отличия в показателях эффективности среди конфигураций-

кандидатов. Если обнаружены значимые отличия, то после ранжирования

кандидатов худшие отбрасываются и не участвуют в оценке на следующем

этапе. Ранжирование в методе F-Race является еще и способом нормализации

показателей эффективности, определяемых для разных примеров проблемы.

В методе F-Race вычислительные ресурсы используются более эффективно,

чем в методе грубой силы. Однако если целевой алгоритм имеет большое

количество параметров и/или каждый параметр имеет большой диапазон

изменений, тогда для получения хорошего результата необходимо оценить

большое количество возможных конфигураций, что может стать практически

невыполнимой задачей с точки зрения выполненных вычислений. К достоин-

ствам методов F-Race и грубой силы относятся их понятность и простота

реализации, с помощью этих методов можно настраивать как числовые, так

и категориальные параметры [84].

Метод ParamILS [89] это один из самых современных методов автома-

тической настройки параметров, с его помощью можно настраивать как чис-

ловые, так и категориальные параметры. В этом методе новая конфигурация

параметров сравнивается с лучшей на текущий момент конфигурацией после-

довательности примеров проблемы. Если новая конфигурация хуже лучшей

конфигурации, она исключается, иначе она оценивается на следующем при-

мере и снова сравнивается с лучшей. Процесс продолжается до тех пор, пока

новая конфигурация не будет оценена на всех примерах последовательности

и будет определена новая лучшая конфигурация.

Перспективным подходом к решению проблемы настройки параметров яв-

ляется применение моделей поверхности отклика для описания зависимости

эффективности целевого алгоритма от настроек его параметров. Процедура

SPO [84] настраивает только числовые параметры и строит модель поверх-

ности отклика, называемую моделью Кригинга. Метод SMAC работает как

с числовыми, так и категориальными параметрами целевого алгоритма. Для

построения поверхности отклика здесь используется случайный лес. Экспе-

риментальное исследование показало, что с помощью SMAC удается полу-

чить лучшие результаты по сравнению с ParamILS. Метод SMAC особенно

хорош при решении задач настройки со многими категориальными парамет-

рами [84].

Подводя итог рассмотрения методов настройки параметров, можно утвер-

ждать, что эти методы выполняются до запуска настраиваемого алгоритма

и выполняют поиск значений параметров, которые останутся фиксированны-

ми во время выполнения алгоритма. Кроме того, процессы настройки обычно

включают несколько прогонов алгоритма, чтобы проанализировать его эф-

фективность на разных значениях параметров с учетом его стохастической

природы [97].

25

7.2. Регулировка значений параметров

Проблема регулировки значений параметров в роевых алгоритмах появи-

лась одновременно с самими этими алгоритмами. В [98] отмечается, что изме-

нение параметров в процессе выполнения алгоритма позволяет: искать реше-

ния, двигаясь в пространстве поиска большими шагами в начале работы ал-

горитма, и вести поиск оптимальных решений малыми шагами на последних

этапах; алгоритму приспосабливаться к изменяющемуся ландшафту целевой

функции; алгоритму накапливать информацию о целевой функции в процес-

се поиска и использовать эту информацию для повышения эффективности

на поздних этапах и освобождает пользователя от необходимости выполнения

этапа настройки значений параметров.

Методы регулировки значений параметров выполняются во время работы

роевого алгоритма и изменяют значения его параметров во время выполнения

алгоритма. Указанные методы могут быть разделены на две категории [99]:

детерминированные и адаптивные. Детерминированные методы работают без

обратной связи и следуют заранее установленному правилу при задании но-

вых значений параметров. Адаптивные методы изменяют значения парамет-

ров на основе информации, получаемой после очередной итерации работы

алгоритма.

Детерминированные методы регулировки значений параметров основаны

исключительно на количестве пройденных итераций. В качестве примера рас-

смотрим методы регулировки коэффициента инерции алгоритма роящихся

частиц, поскольку этот параметр в бóльшей степени ответственен за соблюде-

ние баланса между диверсификацией и интенсификацией. Несмотря на зна-

чительный объем исследований, многие стратегии изменения коэффициента

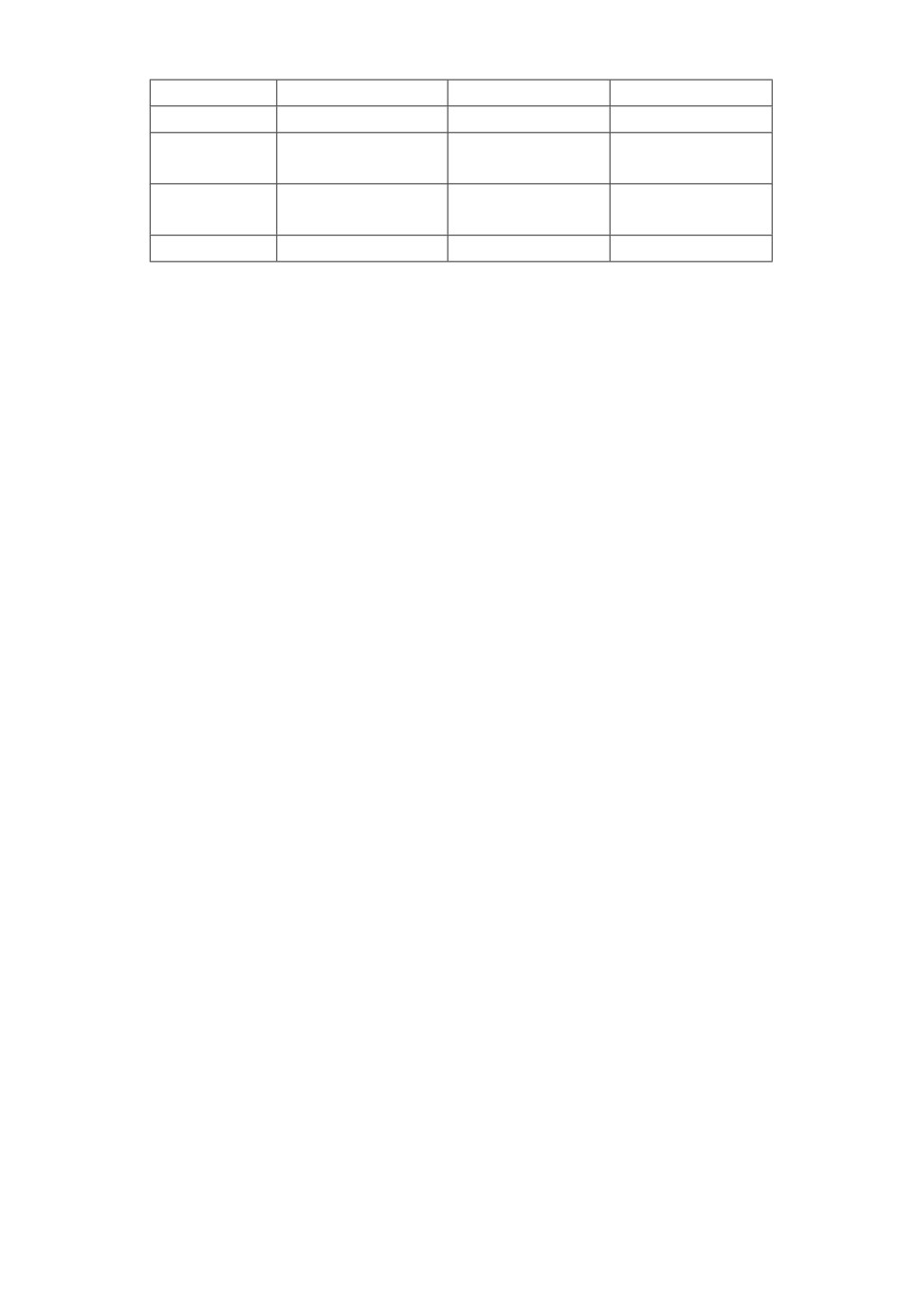

инерции не изучены ни аналитически, ни эмпирически [100]. В табл. 2 приве-

дены детерминированные методы регулировки коэффициента инерции; здесь

Таблица 2. Детерминированные методы изменения значения коэффициента

инерции

Метод

Выражение

Ссылка

Случайное изменение

ω (t) = 0,5 + r (t)/2

[101]

Линейное изменение

ω (t) = ωmax - (ωmax - ωmin) · (t/T )

[102]

ω(t) = ωmax - (ωmax - ωmin)(t/T )1/π2

[103]

ω (t) = ω · u-t

[104]

ω (t) = (2/t)0,3

[105]

Нелинейное изменение

ω (t) = exp(- exp((T - t)/T ))

[106]

ω (t) = ωmin + (ωmax - ωmin)e-10t/T

[107]

ω(t) = ωmin + (ωmax - ωmin)e-16t/T2

ω(t) = ωmax + (ωmin - ωmax) · log10(1 + 10t/T )

[108]

ω (t) = 0,5z(t) + 0,5r(t)

Хаотическое изменение

[109]

ω (t) = z(t)ωmin + (ωmax - ωmin) · (T - t)/T

((ωmin + ωmax)/2 + (ωmax - ωmin)/2) ×

Осциллирующее

ω(t) =

× cos(2πt(4k + 6)/3T), t < 3T/4,

[110]

изменение

ωmin иначе

26

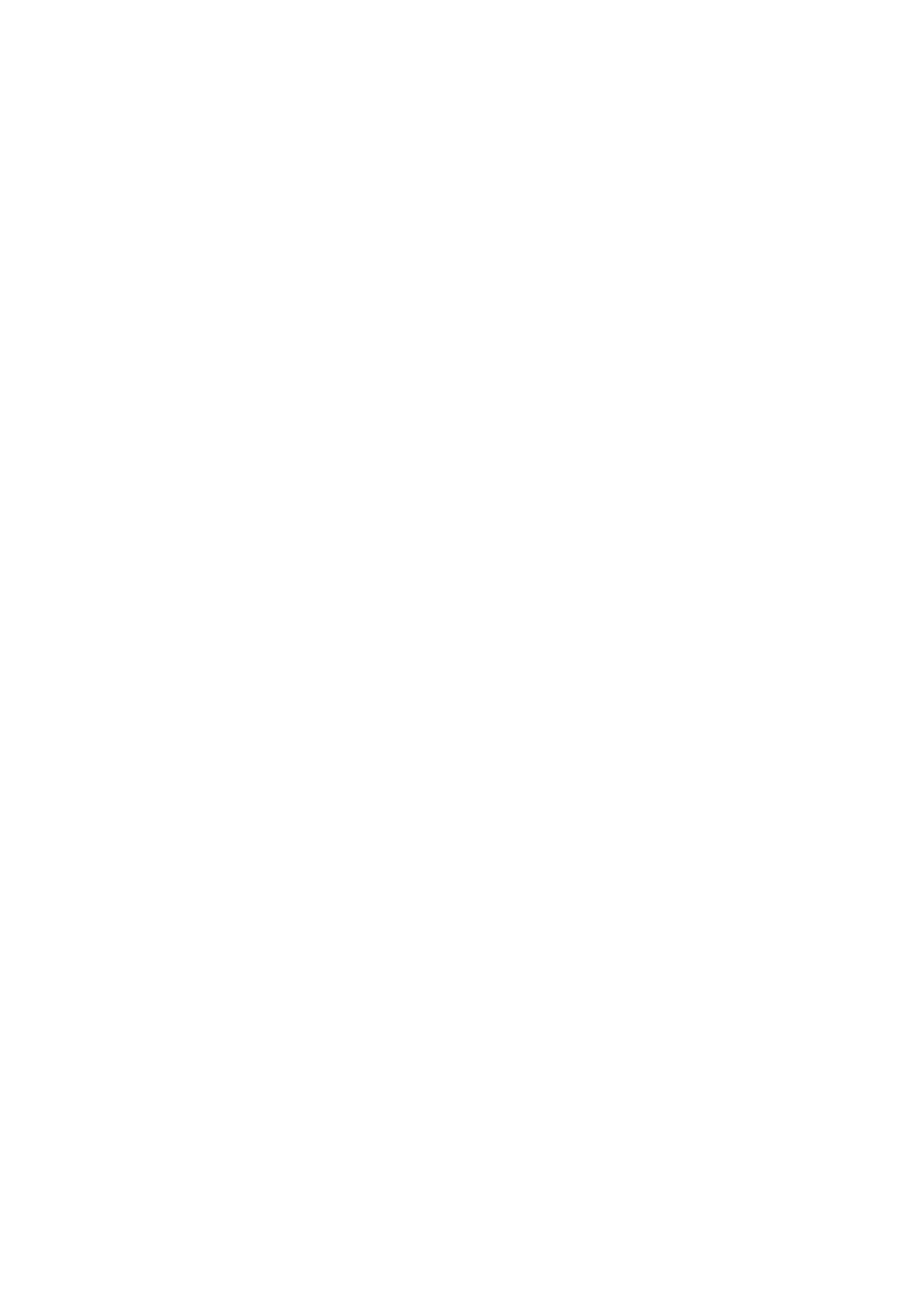

Таблица 4. Стратегии регулировки значений параметров c1 и c2

Стратегии

Состояния

c1

c2

Стратегия 1 Диверсификация Увеличение

Уменьшение

Незначительное Незначительное

Стратегия 2 Интенсификация

увеличение

снижение

Незначительное

Незначительное

Стратегия 3 Сходимость

увеличение

увеличение

Стратегия 4 Прыжок

Уменьшение

Увеличение

приняты обозначения: t текущая итерация; T максимальное число ите-

раций; r (t) ∈ [0, 1] равномерно распределенное случайное число; ω ∈ [0, 1],

u ∈ [1,0001;1,005]; z (t) значение хаотического логистического отображения

(Logistic Map).

Авторами [111] предложен детерминированный способ регулировки значе-

ний коэффициентов c1 и c2 алгоритма роящихся частиц:

c1(t) = c1i + (c1f - c1i) · t/T,

c2(t) = c2i + (c2f - c2i) · t/T,

где c1i и c2i

начальные значения коэффициентов, c1f и c2f

конечные

значения коэффициентов. В [111] рекомендовано использовать следующие

начальные значения этих коэффициентов: c1i = c2f = 2,5, c2i = c1f = 0,5.

Адаптивные методы динамически регулируют параметры роевых алгорит-

мов в процессе их работы. В качестве средств адаптации используются та-

кие характеристики, как средняя скорость, компактность роя, расстояние до

лучшей частицы в рое. В табл. 3 приведены адаптивные методы регулировки

коэффициента инерции.

Быстрая сходимость и уход из локальных оптимумов две наиболее важ-

ные цели в исследовании роевых алгоритмов. Для достижения этих целей в

[116] предложены четыре стратегии адаптивной регулировки коэффициентов

ускорения алгоритма роящихся частиц (табл. 4).

Оценка состояния популяции основана на вычислении суммарного расстоя-

ния между частицами роя

f = (dg - dmin)/(dmax - dmin),

где dmin, dmax, dg минимальное, максимальное суммарное расстояние и сум-

марное расстояние до лучшей частицы в рое. Значение f относительно велико

в состоянии диверсификации или прыжка и относительно мало в состоянии

интенсификации или сходимости.

Коэффициент инерции ω уравновешивает возможности глобального и ло-

кального поиска, в [116] значение ω адаптивно регулируется в соответствии

с выражением:

ω(f) = 1/(1 + 1,5 exp(-2,6f)).

Регулировка значений параметров c1 и c2 выполняется с помощью нечеткой

системы типа синглтон, на вход которой подается значение f.

28

В последнее время увеличивается количество исследований, связанных с

встраиванием хаоса в алгоритмы оптимизации. Использование хаоса усили-

вает диверсификационные и интенсификационные свойства алгоритмов оп-

тимизации [53]. Стадии диверсификации и интенсификации в роевых алго-

ритмах регулируются хаотическим изменением их параметров: шага полетов

Леви в алгоритме кукушкин поиск [117], гравитационных констант в грави-

тационном поиске [118], коэффициента c в алгоритме кузнечика [53], двух

коэффициентов γ и β в алгоритме светлячков [119], четырех параметров

в алгоритме летучих мышей [120].

Нечеткие системы достаточно часто используются для регулировки пара-

метров роевых алгоритмов. В [121] адаптивная нечеткая схема построена на

вычислении разности значений целевой функции лучших решений на двух

последних итерациях алгоритма роящихся частиц (df). Предлагаются сле-

дующие нечеткие правила регулировки значений параметров c1 и c2:

ЕСЛИ df маленькое, ТО c1 большое, c2 маленькое,

ЕСЛИ df среднее, ТО c1 среднее, c2 среднее,

ЕСЛИ df большое, ТО c1 маленькое, c2 большое.

Входная переменная df и выходные переменные c1 и c2 представлены тре-

мя нечеткими термами: маленькое, среднее, большое.

В [122] для модификации параметров c1 и c2 построены три нечеткие си-

стемы типа Мамдани с разными входными переменными, в качестве кото-

рых используются нормированные значения: а) популяционного разнообра-

зия, б) усредненной разности между значением целевой функций каждой ча-

стицы и значением целевой функции лучшей частицы, в) итерации. Все вход-

ные переменные представлены тремя равномерно распределенными на интер-

вале [0; 1] нечеткими термами с треугольными функциями принадлежности.

Выходные переменные (c1 и c2) представлены пятью равномерно распреде-

ленными на интервале [0,5; 2,5] нечеткими термами с треугольными функ-

циями принадлежности. Входными переменными для первой нечеткой систе-

мы являются итерации и разнообразие, для второй итерации и усреднен-

ная разность, для третьей итерации, разнообразие и усредненная разность.

Первые две системы имеют по девять нечетких правил, третья

27.

В модифицированном алгоритме роящихся частиц FAIPSO [123] коэффи-

циенты c1 и c2 корректируются c применением нечеткой системы, которая

имеет шесть входных переменных, содержащих информацию о расстояниях

между частицами, два выхода (c1 и c2) и десять нечетких правил. Компро-

мисс между диверсификацией и интенсификацией при решении задач опти-

мизации с использованием гравитационного алгоритма достигается измене-

нием значения ускорения, для этого авторы [124] применяют нечеткую си-

стему типа 2. Системы этого же типа используются в [125] для регулировки

параметров алгоритма летучих мышей, а в [126] для динамической адап-

тации параметров алгоритма пчелиной колонии.

Размер популяции параметр, присутствующий во всех роевых алгорит-

мах и влияющий на их эффективность. В [23] предложено адаптивное из-

менение размера популяции в зависимости от популяционного разнообразия;

29

максимальное количество итераций делится на равные периоды, каждый из

которых содержит равное количество итераций; в конце каждого периода вы-

числяется разнообразие популяции и в зависимости от его значения размер

популяции либо увеличивается, либо уменьшается.

Методы регулировки значений параметров включаются в исходный алго-

ритм, что приводит к увеличению вычислительной и временной сложности

алгоритма. Одним из вариантов решения этой проблемы является разработ-

ка роевых алгоритмов без параметров, но этот подход требует детального

изучения [6]. Существует еще ряд открытых вопросов, связанных с настрой-

кой и регулировкой параметров. Необходимо теоретическое обоснование су-

ществования зависимости эффективности роевого алгоритма от его парамет-

ров. Необходимы разработки схем адаптации параметров для сложных задач

оптимизации, таких как многоцелевая оптимизация, оптимизация с ограни-

чениями, крупномасштабная оптимизация, оптимизация в динамических и

неопределенных средах. Необходимы исследования применения методов ма-

шинного обучения для решения проблем настройки и регулировки парамет-

ров роевых алгоритмов, частично эта проблема рассматривается в разделе 8

обзора.

8. Гибридизация

Создатели метаэвристических алгоритмов сталкиваются с трудно разре-

шимой проблемой: как найти хороший баланс между диверсификацией и ин-

тенсификацией; в одном алгоритме практически невозможно сбалансировать

указанные компоненты [127]. Задачи оптимизации могут быть более эффек-

тивно решены путем гибридизации существующих алгоритмических струк-

тур. Основная цель гибридизации заключается в использовании уникальных

особенностей и преимуществ каждого алгоритма для достижения компромис-

са между диверсификацией и интенсификацией, а также для предотвращения

преждевременной сходимости путем использования сильных сторон каждого

из компонентов в соответствующем алгоритме. Однако создание эффектив-

ного гибридного алгоритма является сложным процессом, который требует

обширных знаний и большого опыта в создании систем оптимизации [128].

В [129] приведена следующая классификация гибридных алгоритмов:

1) портфельные алгоритмы это библиотека последовательно работаю-

щих алгоритмов поиска;

2) гиперэвристика это библиотека алгоритмов поиска, снабженная меха-

низмом координации, который выбирает и активирует различные алгоритмы

или генерирует специальные компоненты поиска;

3) меметические алгоритмы это структура, которая содержит основной

решатель и несколько алгоритмов локального поиска; 4) ансамбль алгорит-

мов алгоритмическая структура, в которую входят стратегии поиска и

общие компоненты решения проблем оптимизации.

Авторы [129] указывают на то, что классификация скорее отражает истори-

ческий путь гибридизации, чем выявляет алгоритмические различия в под-

ходах.

30

8.1. Меметические алгоритмы

Роевые алгоритмы показывают хорошие результаты на стадии диверси-

фикации, но существенно уступают традиционным методам на стадии интен-

сификации; при приближении к оптимуму метаэвристические методы усту-

пают градиентным. Комбинирование глобального поиска на уровне популя-

ции и локального поиска на уровне отдельного решения получило развитие

в области меметических алгоритмов [49]. Меметические алгоритмы класс

алгоритмов оптимизации, в структуру которых включены компоненты попу-

ляционных метаэвристик и процедуры локального поиска. Термин “мемети-

ческий алгоритм” вытекает из того факта, что процедура локального поиска

сродни мему, представляющему некоторую форму предметно-специфических

априорных знаний человека-эксперта о том, как можно улучшить решение.

В гибридных алгоритмах мемы воспринимаются как инструкции, правила,

стратегии, априорные знания [130].

Авторы [131] разделяют меметические алгоритмы на три основных класса:

1) алгоритмы с одним фиксированным мемом или локальным оператором

поиска, применяемым к решению, сформированному популяционной метаэв-

ристикой;

2) алгоритмы с пулом заданных локальных операторов поиска (мемов), ко-

торые конкурируют между собой; выбор мема может быть основан на различ-

ных критериях, таких как абсолютное значение целевой функции решений,

связанных с мемом, или улучшение значения целевой функции в результате

прошлых применений мема;

3) эволюционирующие мемы с априори неизвестным пулом мемов, которые

автоматически адаптируются к ландшафту целевой функции.

Процедура локального поиска, используемая в меметических алгоритмах,