Автоматика и телемеханика, № 10, 2022

© 2022 г. Е.Ю. МИНАЕВ, канд. техн. наук (eminaev@gmail.com),

Л.А. ЖЕРДЕВА (lara.zherdeva.taskina@gmail.com)

(Самарский университет),

В.А. ФУРСОВ, д-р техн. наук (fursov@ssau.ru)

(Институт систем обработки изображений филиал ФНИЦ

“Кристаллография и фотоника” РАН, Самара)

ВИЗУАЛЬНАЯ ОДОМЕТРИЯ ПО ИЗОБРАЖЕНИЯМ

ОПОРНОЙ ПОВЕРХНОСТИ С МАЛЫМИ

МЕЖКАДРОВЫМИ ПОВОРОТАМИ

В работе рассматривается задача визуальной одометрии по последова-

тельности видеокадров, которые формируются с использованием камеры,

направленной перпендикулярно вниз на опорную поверхность. Задача ре-

шается в предположении, что частота съемки велика, поэтому параметры

межкадрового поворота и сдвига невелики. Технология реализуется в ви-

де последовательности следующих этапов: определение сдвига и поворота

с точностью до целого числа пикселей с использованием корреляционно-

го метода, уточнение параметров сдвига и поворота методом оптического

потока и коррекция ошибок оценивания, связанных с неравномерностью

движения и флуктуациями расстояния камеры до опорной поверхности

путем оценки отклонений локальных калибровочных характеристик от

их средних значений. Приводятся результаты экспериментальных иссле-

дований технологии на тестовых траекториях, полученных путем моде-

лирования движения аппарата по опорной поверхности.

Ключевые слова: визуальная одометрия, опорная поверхность, последо-

вательность кадров, моделирование.

DOI: 10.31857/S0005231022100026, EDN: AJTRMC

1. Введение

Системы визуальной одометрии [1-4], в которых последовательность ви-

деокадров формируется с использованием камеры, направленной перпенди-

кулярно вниз (на опорную поверхность) в последние годы завоевывает все

большую популярность [5-10]. Возможно, это связано с тем, что не всегда

есть надежные ориентиры в окружающих сценах, в то время как опорная по-

верхность наблюдается непрерывно. Например, в работе [11] приведен пример

удачной реализации системы, основанной на корреляционном методе.

В [12] авторы настоящей работы предложили технологию визуальной одо-

метрии по последовательности изображений опорной поверхности, регистри-

руемых БПЛА с малой высоты. Технология включает три этапа: определение

сдвига и поворота с использованием корреляции фрагментов (1), уточнение

параметров сдвига и поворота методом оптического потока (2) и коррекция

ошибок оценивания траекторий, связанных с неравномерностью движения и

9

флуктуациями высоты (3). Предполагалось, что камера установлена в гиро-

подвесе и сохраняет ориентацию относительно глобальной системы координат

в течение всего полета.

Эксперименты подтвердили эффективность предложенной технологии.

Однако попытка реализации этой технологии в случае жестко закрепленной

на корпусе аппарата камеры натолкнулась на принципиальные трудности.

Дело в том, что в этом случае необходимо оценивать не только межкадровый

сдвиг, но и параметры поворота. Для их определения обычно строят после-

довательные оценки матриц сдвига и поворота по соответствующим точкам

соседних кадров. Для этого кадры должны иметь значительные перекрытия,

что достигается увеличением частоты съемки.

Известны различные подходы к решению задачи определения матрицы

сдвига и поворота. В частности, непрямые методы визуальной одометрии

[13-15] используют анализ соответствующих ключевых точек. По координа-

там этих точек определяется фундаментальная матрица и затем формируется

матрица сдвига и поворота. Известны также алгоритмы построения матри-

цы сдвига и поворота непосредственно по ключевым точкам. Этот подход в

рамках технологии, основанной на использовании изображений опорной по-

верхности, иногда оказывается неработоспособным, так как эти изображения

часто представляют собой некоторую текстуру без выделяющихся оригиналь-

ных ключевых точек.

В рамках прямых методов одометрии [16-18] параметры сдвига и поворо-

та определяются путем анализа плотного поля соответствий между кадрами

изображений. В рамках этого подхода наиболее популярным является метод

экстремальной корреляции. Исследования [12] также подтвердили эффектив-

ность этого метода в задаче оценивания траектории аппарата, у которого ори-

ентация камеры относительно глобальной системы координат не изменяется

в течение всего времени движения.

В случае жесткого закрепления камеры на аппарате реализация этого ме-

тода существенно усложняется. В данном случае для каждой пары кадров

нормированный коэффициент корреляции необходимо рассчитывать как для

всех возможных сдвигов, так и для различных относительных углов поворо-

та. При этом, если для повышения точности уменьшать шаг дискретизации,

существенно возрастает вычислительная сложность, что ставит под сомне-

ние возможность реализации такой системы оценки текущей траектории в

реальном времени.

В настоящей работе предлагается технология визуальной одометрии,

принципиальное отличие которой от системы, описанной в работе [12], состо-

ит в реализации метода корреляции на этапе определения межкадровых сдви-

гов и поворотов. Идея состоит в том, что для определения сдвига и поворо-

та используются два фрагмента изображения, находящиеся на значительном

удалении от центра изображения. Размеры фрагментов и их расстояния от

центра выбираются так, чтобы при максимально возможном относительном

повороте разность координат соответствующих точек не превышала полови-

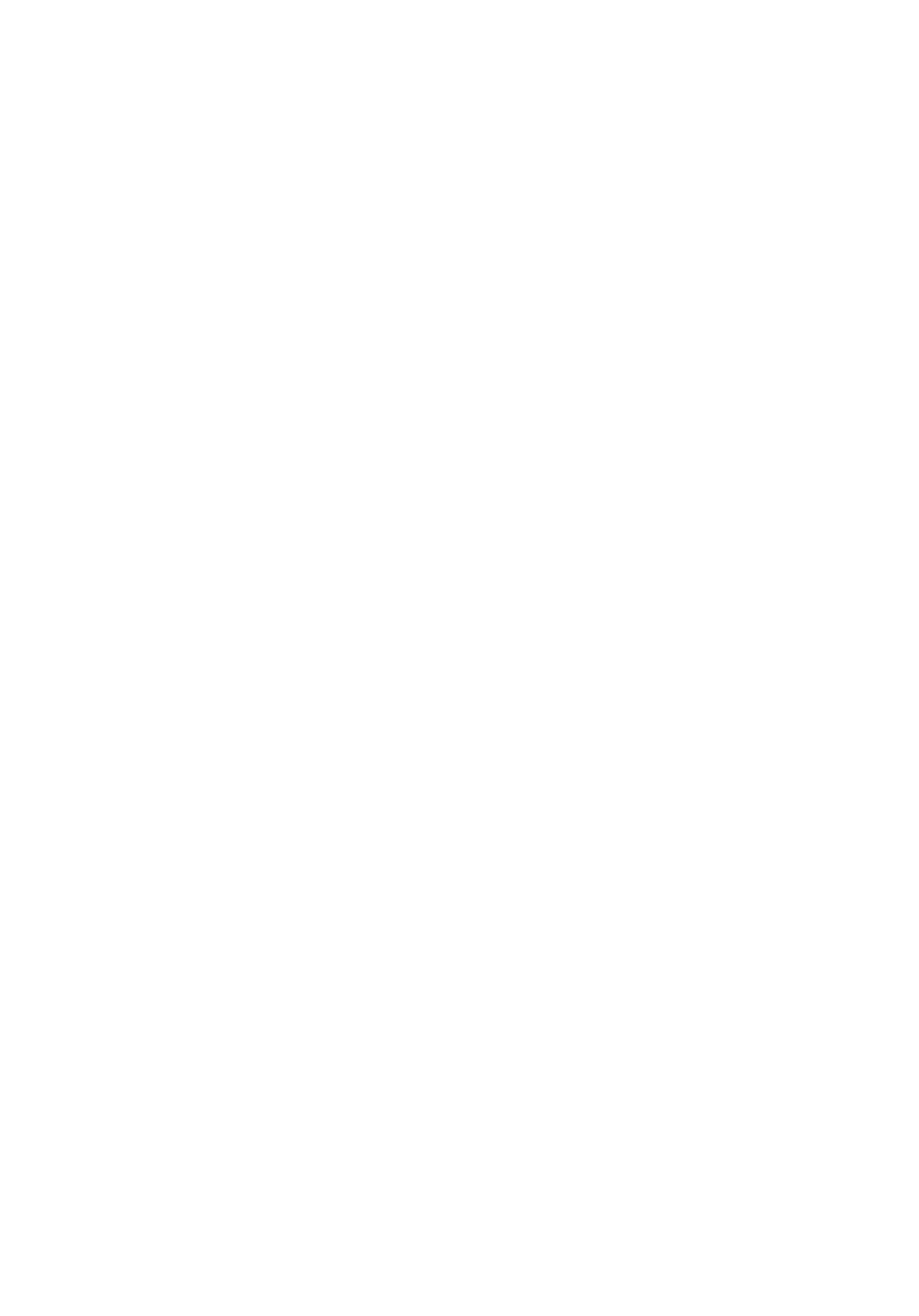

ны межпиксельного расстояния. Вид сверху на аппарат при его движении по

10

а

б

Текущее

изображение

X

Траектория

движения

Фрагмент 1

Камера

Y

Y

L

Фрагмент 2

X

Рис. 1. Схема движения аппарата (а) и схема расположения фрагментов на

кадре (б ).

траектории и схема расположения фрагментов на одном кадре изображения

показаны на рис. 1,а и 1,б соответственно.

В рамках описанной схемы съемки реализация основных этапов техно-

логии, применявшихся в работе [12], существенно изменена. Теперь первый

этап экстремальной корреляции и второй этап уточнение сдвигов мето-

дом оптического потока выполняются для каждого из указанных фрагментов

отдельно. Появляются также новые этапы оценка межкадрового и теку-

щего накопленного углов поворота аппарата, а также формирование оценок

траектории с использованием текущих оценок накопленного угла поворота.

Кроме того, на завершающем этапе технологии коррекция оценок траектории

осуществляется только по одной координате (OX) в направлении текущего

вектора скорости аппарата (см. рис. 1,а). Подчеркнем, что указанные новые

решения связаны с тем, что последовательность изображений формируется

камерой, жестко связанной с корпусом аппарата.

Цель настоящего исследования состоит в разработке методов и алгорит-

мов, реализующих перечисленные этапы технологии, а также в эксперимен-

тальной проверке достижимой точности сквозной технологии в целом, вклю-

чающей все указанные этапы.

2. Описание технологии

2.1. Основные предположения и обозначения

Рассматривается задача автономной навигации аппарата, движущегося по

земной (далее опорной) поверхности, с использованием последовательности

изображений этой поверхности. Изображения формируются камерой, направ-

ленной перпендикулярно вниз. Задача состоит в том, чтобы в каждой точке

траектории определить относительный сдвиг и поворот соседних кадров. По-

скольку расстояние от камеры до поверхности невелико, при определении

межкадровых сдвигов и поворотов можно пренебречь проективными иска-

жениями.

Для каждого кадра последовательности будем задавать локальную систе-

му координат. Для определенности примем, что прямоугольная система ко-

11

Y

2

2,1

n(y,1)

2,m

2,2

n(y,1)-n(y,2)

a

n(y,2)

a

O

1,2

1,m

1,1

1

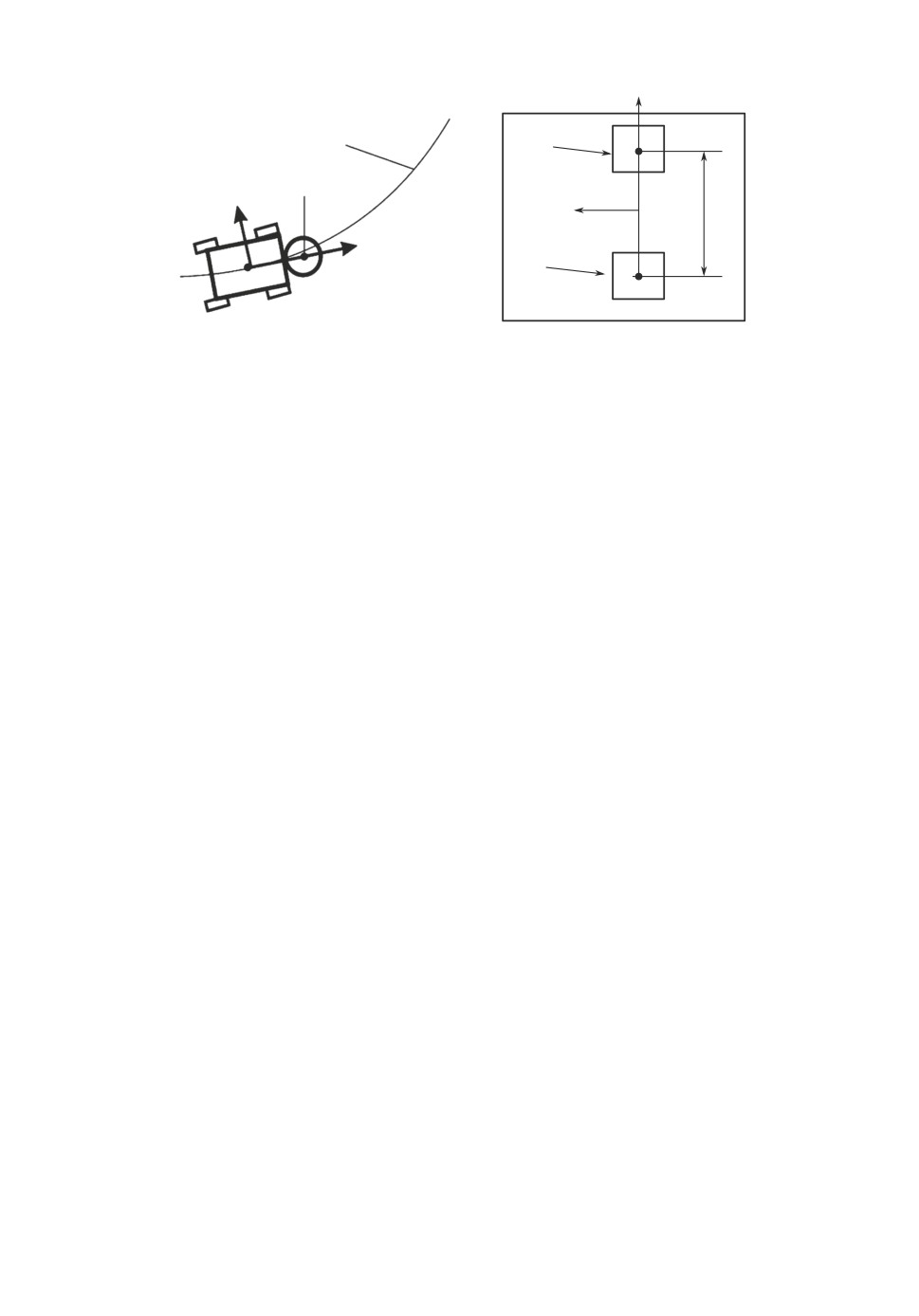

Рис. 2. Локальная система координат.

ординат связана с первым (по времени регистрации) изображением. Точка O

(начало системы координат) находится в центре кадра, а положительное на-

правление оси Ox совпадает с направлением движения аппарата (см. рис. 1).

На рис. 2 показана схема взаимного расположения двух кадров изображений,

обозначенных 1 и 2 (в кружках) в локальной системе координат, связанной с

первым изображением. Первая цифра в обозначениях точек означает номер

кадра, а вторая номер фрагмента в соответствии с нумерацией, показанной

на рис. 1. Например, 1.1 означает фрагмент 1 на первом кадре, 2.1 фраг-

мент 1 на втором кадре и т.д. Центральные точки кадров изображений 1 и 2

обозначены ¾1.m¿ и ¾2.m¿ соответственно.

2.2. Алгоритм экстремальной корреляции

Используется двухпозиционный алгоритм корреляции по двум фрагмен-

там с центрами в точках 1.1 и 1.2 на первом изображении и в точках 2.1

и 2.2 на втором изображении (см. рис. 2). Сдвиги определяются для пары

фрагментов 1.1-2.1 и для пары 1.2-2.2.

Для того, чтобы обеспечить возможность применения стандартной про-

цедуры корреляции на фрагментах, формулируется следующее требование.

Координаты соответствующих точек фрагментов, используемых для вычис-

ления нормированного коэффициента корреляции, должны различаться ме-

нее чем на половину межпиксельного расстояния при предельно возможных

относительных межкадровых поворотах. Ясно, что это требование будет вы-

полняться для всех точек фрагмента, если оно выполняется для точки наибо-

лее удаленной от центра фрагмента. Если фрагмент квадратный с размера-

ми N × N, достаточно сформулировать это условие для одной угловой точки

внешнего контура фрагмента.

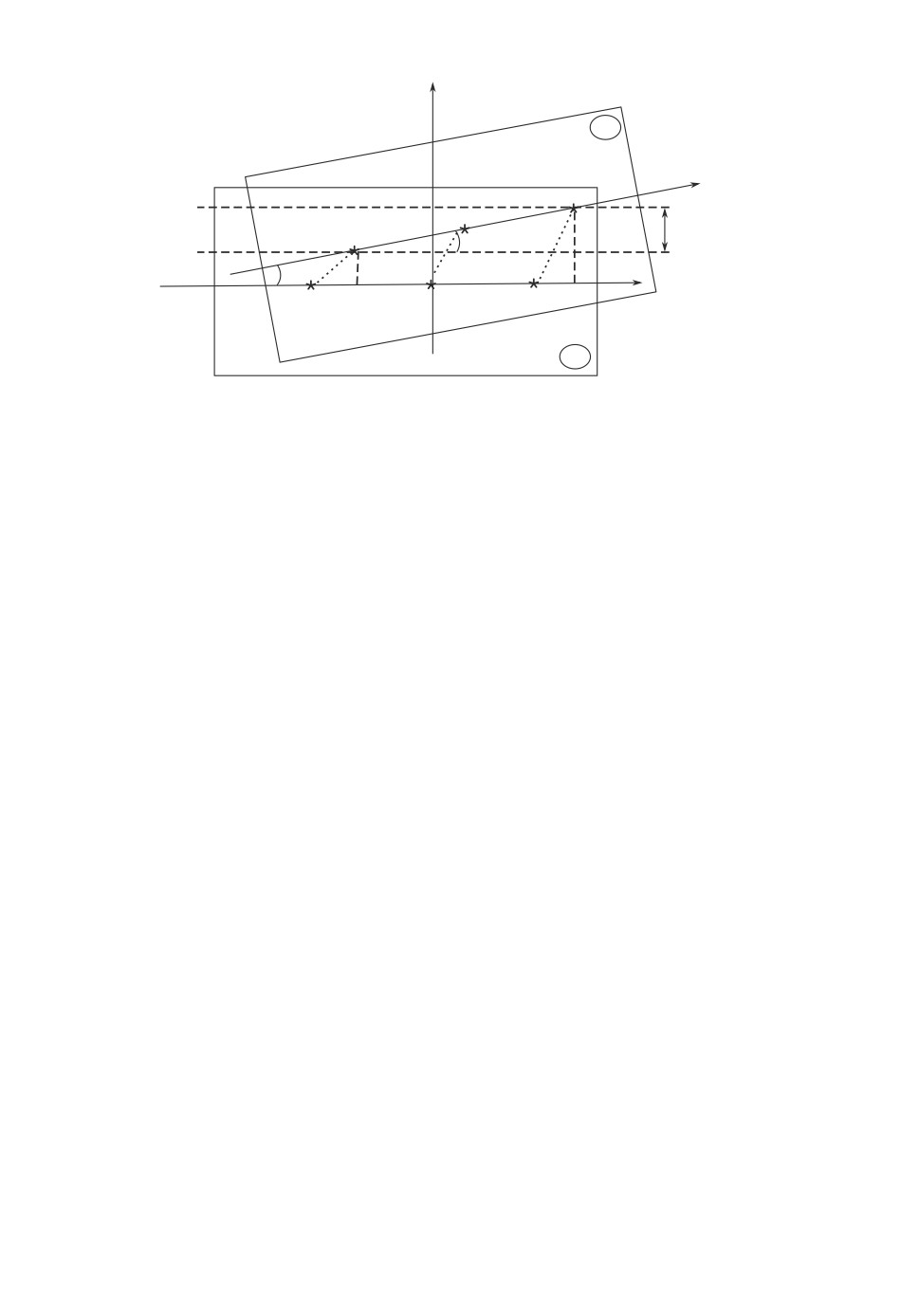

На рис. 3 приведена схема взаимного положения угловых точек одноимен-

ных фрагментов на соседних изображениях. Эта схема иллюстрирует связь

размеров фрагмента с максимально допустимым относительным углом пово-

рота изображений. Здесь α угол межкадрового поворота, l дуга, соеди-

12

2

I

1

R

R

a

o

Рис. 3. К обоснованию размеров фрагментов.

няющая наиболее удаленные (угловые) точки (1 и 2) фрагментов соседних

изображений; R расстояния от центральной точки совмещенных фрагмен-

тов до точек 1 и 2.

Длина дуги l не может быть меньше расстояния между точками 1 и 2.

Тогда полагая, что tg α= α, для квадратной N × N-области можно записать

условие, при котором это расстояние будет меньше половины межпиксельно-

го расстояния:

Δpix

(1)

N ≤

√

,

2

2·α

где α угол относительного поворота (в радианах), Δpix масштабный ко-

эффициент, зависящий от выбранной единицы измерения сдвига (Δpix = 1,

если сдвиг измеряется целым числом пикселей).

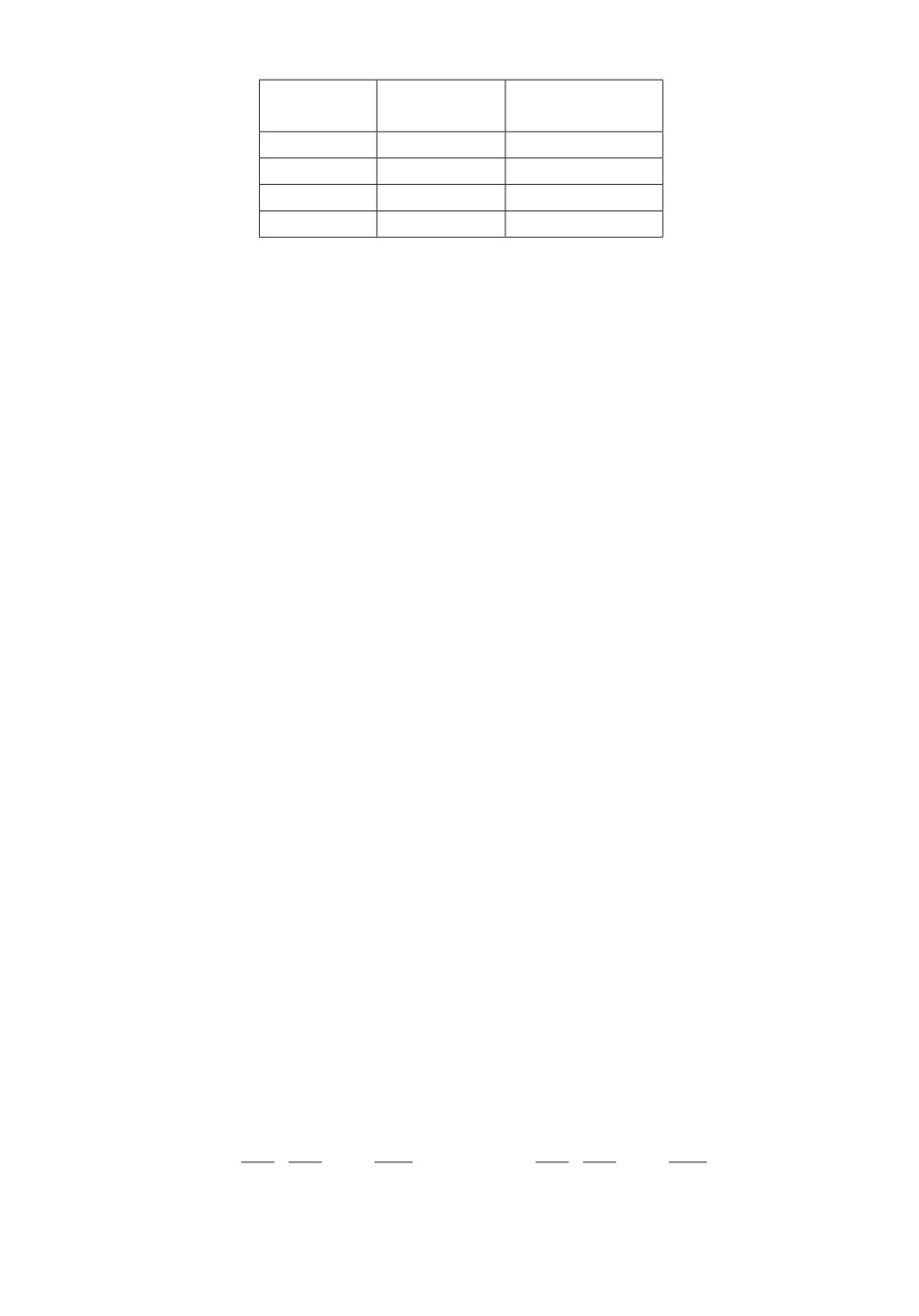

В таблице приведены предельные значения относительных поворотов для

некоторых широко используемых размеров областей, используемых при вы-

числении нормированного коэффициента корреляции. Заметим, что указан-

ные значения предельных углов обычно не создают проблем. Даже при срав-

нительно малой скорости регистрации 30 кадров в секунду и ограничении 3◦

угловая скорость аппарата на поворотах может достигать скорости 90 град/c,

т.е. четверть полного оборота за одну секунду. При этом область корреляции

11 × 11 содержит 121 точку, что вполне достаточно для получения надежного

результата.

Таким образом, первый этап технологии сводится к следующей последова-

тельности шагов. На соседних кадрах изображений задаются два фрагмента

(на рис. 2 центры этих фрагментов на первом кадре обозначены 1.1 и 1.2), раз-

несенные по возможности на достаточно большое расстояние L, при котором

фрагменты ¾видны¿ на обоих изображениях. Размеры фрагментов задаются

в соответствии с условием (1), при выполнении которого сдвиг одноименных

пикселей, соответствующих фрагментов на двух видах (здесь 1 и 2) не превы-

13

Предельные углы относительных поворотов

Размеры Предельный Предельный

фрагмента угол (рад.)

угол (град.)

5×5

0,1750

10,0250

7×7

0,1173

6,7213

9×9

0,0882

5,0511

11×11

0,0589

3,3723

шает половины межпиксельного расстояния при максимальном возможном

межкадровом повороте.

Далее задавая центры областей поиска в точках 2.1 и 2.2 второго кадра,

с использованием процедуры экстремальной корреляции, определяем цело-

пиксельные координаты сдвига точки 2.1 по отношению к точке 1.1

(2)

m1, n1

и точки 2.2 по отношению к точке 1.2

(3)

m2, n2.

Полученные методом корреляции сдвиги выражаются целыми числами пик-

селей. В задачах визуальной одометрии даже малые ошибки в пределах долей

пикселя вследствие накопления на длинных участках траектории могут при-

водить к значительным ошибкам в конечной точке. Поэтому важным этапом

технологии является субпиксельное уточнение полученных оценок.

2.3. Уточнение оценок сдвига методом оптического потока

Для уточнения оценок в пределах одного пикселя так же, как в [12], при-

меняется метод оптического потока. Важным отличием в данном случае яв-

ляется то, что уравнения оптического потока должны применяться отдельно

для каждого фрагмента. Таким образом, формируются две независимые си-

стемы

(4)

I1x,yΔ1 = I1t,

(5)

I2x,yΔ2 = I2t,

[

]

[

]

где I1x,y =

I1x,I1y

, I2x,y =

I2x,I2y

N ×2-матрицы для фрагментов 1 и 2 со-

ответственно, а фигурирующие здесь N × 1-матрицы I1x, I1y, I2x, I2y, I1t, I2t

определяются как

]T

]T

[∂I11

∂I12

∂I1N

[∂I11

∂I12

∂I1N

I1x =

,

,...,

,

I1y =

,

,...,

,

∂x

∂x

∂x

∂y

∂y

∂y

(6)

[

]T

I1t =

- ∂I11,-∂I12,... ,-∂I1N

,

14

]T

]T

[∂I21

∂I22

∂I2N

[∂I21

∂I22

∂I2N

I2

x

=

,

,...,

,

I2y =

,

,...,

,

∂x

∂x

∂x

∂y

∂y

∂y

(7)

[

]T

I2t =

- ∂I21,-∂I22,... ,-∂I2N

Размеры фрагментов, из отсчетов которых формируются уравнения

(4), (5), задаются так, что эти системы являются переопределенными, поэто-

му вычисляются параметры сдвига, оптимальные в среднеквадратическом

смысле:

[

]T

[

]-1

(8)

Δ1 = Δx,1,Δy,1

= I1x,yTI1x,y

I1x,yTI1t,

[

[

]-1

]T

(9)

Δ2 = Δx,2,Δy,2

= I2x,yTI2x,y

I2x,yTI2t.

Полученные субпиксельные смещения добавляются к найденным ранее

корреляционным методом целопиксельным относительным смещениям (2)

и (3):

(10)

mx,1 = m1 + Δx,1, ny,1 = n1 + Δy,1,

(11)

mx,2 = m2 + Δx,2, ny,2 = n2 + Δy,2.

Следует напомнить, что уравнения оптического потока формируются по

данным, которые являются линейными членами разложения функции яр-

кости в малой окрестности. Поэтому точность оценок существенным обра-

зом зависит от интервала аппроксимации. С учетом этого для повышения

точности оценок предварительно совмещаются соответствующие пары фраг-

ментов с использованием результатов определения целопиксельных сдвигов,

полученных методом корреляции. При этом оценки (8), (9) не могут превы-

шать одного межпиксельного расстояния. Указанное свойство может исполь-

зоваться в качестве одного из признаков плохой обусловленности или даже

вырожденности задачи. Здесь не затрагиваются эти проблемы, являющиеся

предметом специальных исследований.

2.4. Формирование текущих оценок координат траектории

В предположении, что камера жестко закреплена на корпусе аппарата,

далее вычисляем координаты центральных точек mx,0 и ny,0 обоих изобра-

жений:

(12)

mx,0 = (mx,1 + mx,2

) /2,

(13)

ny,0 = (ny,1 + ny,2

) /2

и определяем общий межкадровый сдвиг S центральных точек кадров 1 и 2

как евклидову норму сдвигов в направлении осей Ox, Oy локальной системы

координат:

√

(14)

S=W∗ m2x,0 +n2y,0,

15

где W коэффициент (¾цена¿ пикселя), определяемый на этапе калибровки

в метрических единицах.

Угол Δα межкадрового поворота в локальной системе координат, в соот-

ветствии с принятыми обозначениями, определяется как

(15)

Δα = arcsin (ny,1 - ny,2

) /L,

а текущее направление движения аппарата для любой точки траектории в

глобальной системе координат (далее угол α) является суммой углов Δαi,

i = 1,2,... локальных межкадровых поворотов всех предшествующих данной

точке пар кадров.

Для вычисленного в каждой точке траектории угла α, характеризующего

текущее направление движения аппарата, определяются приращения коор-

динат в глобальной системе координат:

(16)

Δx = S∗

cos α,

(17)

Δy = S∗

sin α.

Текущие координаты траектории в любой точке, как и текущий угол, явля-

ются суммой приращений, вычисленных в соответствии с (15), (16) на всех

предшествующих точках. Знаки приращений определяются текущими значе-

ниями накопленного угла α. Ясно, что координаты x0, y0 и угол α0 в началь-

ной точке глобальной системы координат, с которых ¾стартует¿ алгоритм

формирования текущих оценок параметров движения, должны быть заданы

точно.

2.5. Алгоритмы коррекции текущих оценок и общая схема технологии

Точность оценивания траектории в значительной степени зависит от ка-

чества калибровки. Если задана эталонная траектория, калибровка может

быть выполнена точно. Однако это не гарантирует высокого качества оцени-

вания траектории, так как параметры движения и установки камеры могут

отличаться от эталонных. Если эталонной траектории нет, ¾цена пикселя¿

определяется путем расчета по заданным параметров движения и конструк-

ции аппарата. Ясно, что в этом случае, тем более, возможны отличия от

заданных значений. Средние калибровочные характеристики можно коррек-

тировать по результатам предыдущих проездов. Однако кратковременные

отклонения вследствие неравномерности движения носят случайный харак-

тер и могут корректироваться только в процессе движения.

Здесь используется алгоритм эпизодической коррекции траектории по на-

блюдениям текущих отклонений калибровочных характеристик от средних

значений на коротких отрезках траектории. В отличие от [12] в данном случае

коррекции подвергается только составляющая перемещения в направлении

движения аппарата (в направлении оси Ox локальной системы координат).

Алгоритм корректировки оценок траектории состоит из следующих шагов.

С использованием найденных по формуле (14) межкадровых сдвигов цен-

тральных точек Sk, k = 1, K (здесь K число точек на отрезке коррекции)

16

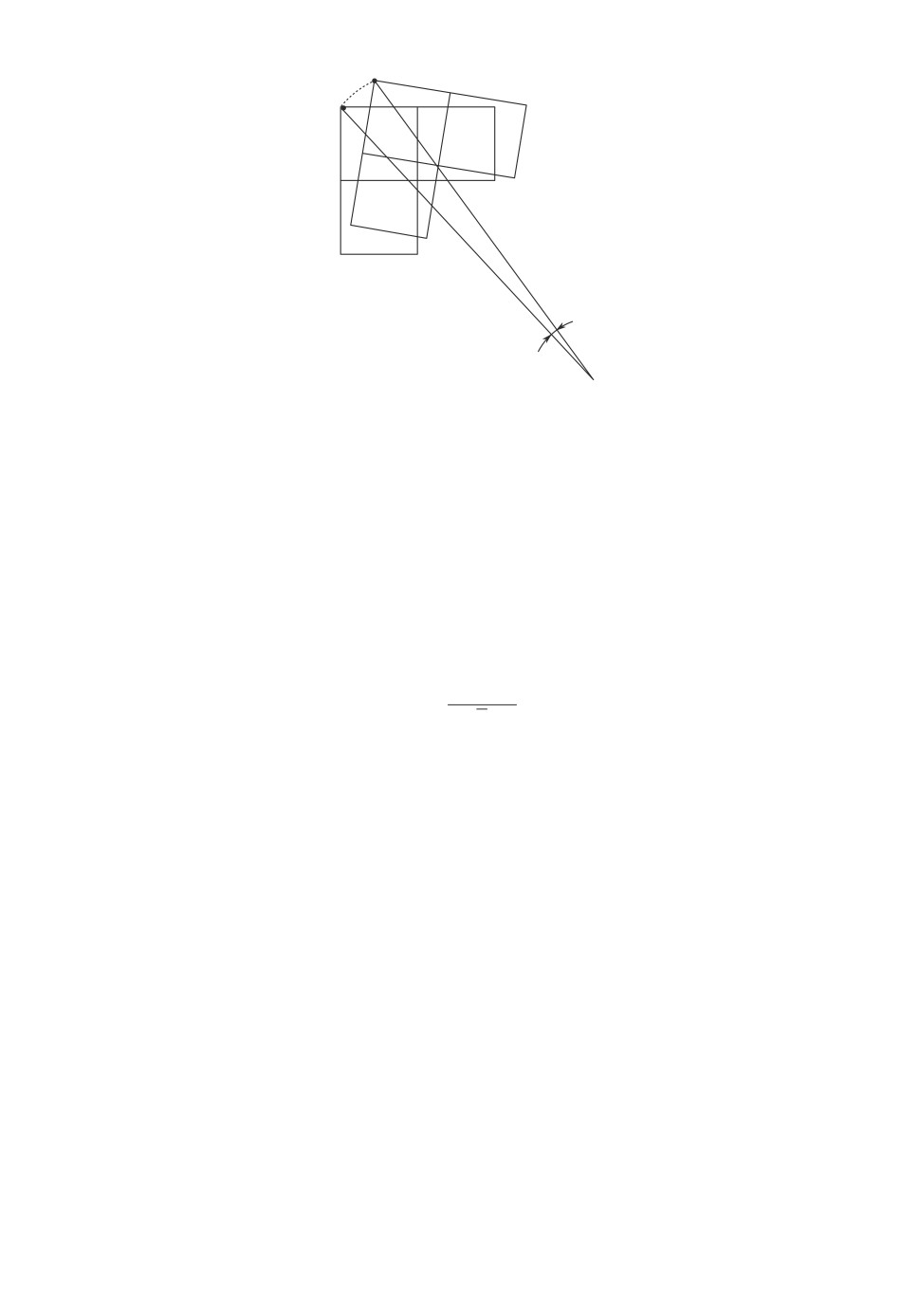

X0

Y0

S

5

7

8

N L

a

X Y

1

2

3

4

6

9

10

+

a0

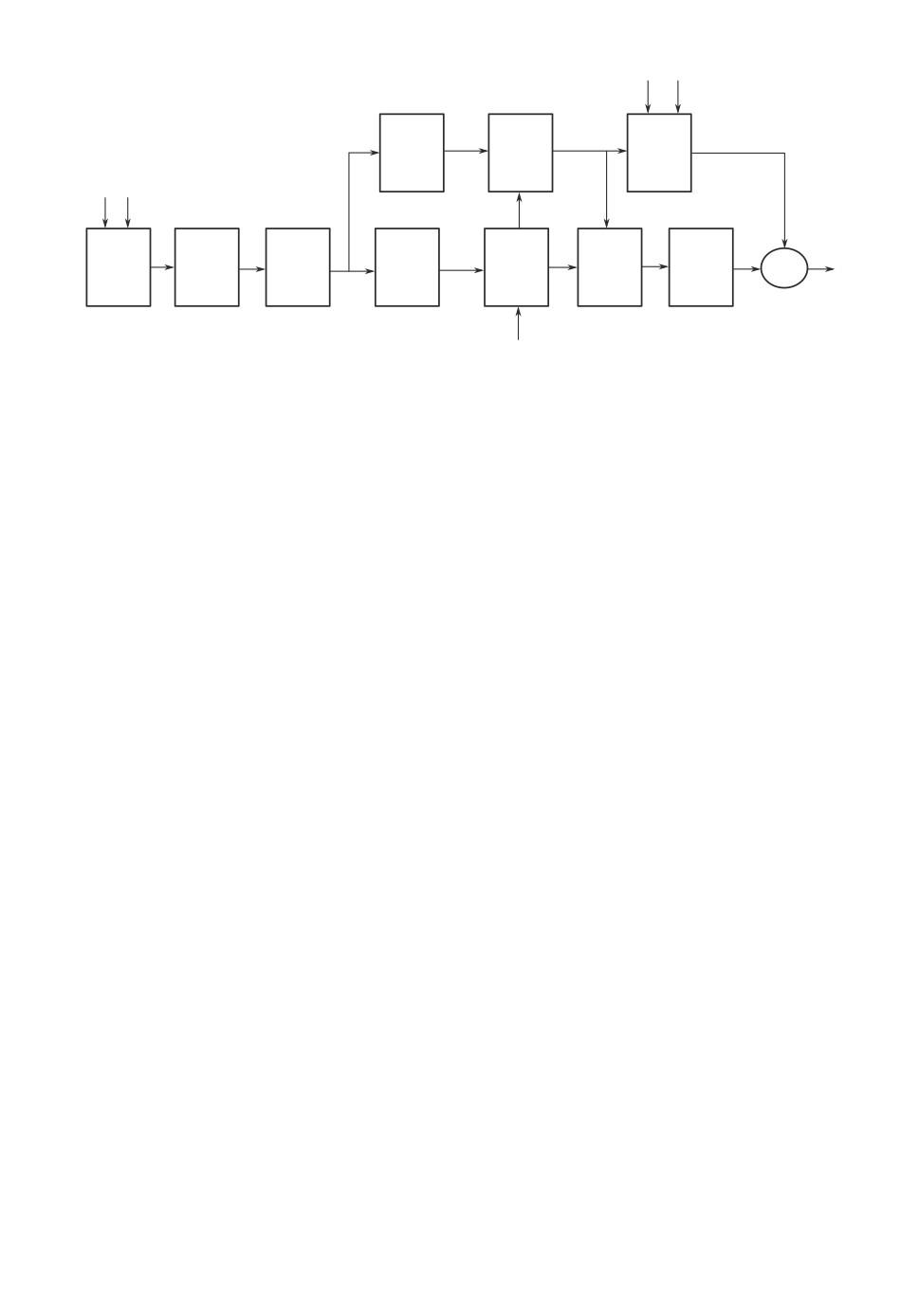

Рис. 4. Связь основных блоков системы визуальной одометрии, осуществляю-

щих вычисление: межкадровых сдвигов методом корреляции (1), субпиксель-

ных оценок методом оптического потока (2), координат центральных точек

кадров изображений (3), локального угла межкадрового поворота Δα (4), ло-

кального межкадрового сдвига центров кадров (5), угла α текущего направ-

ления в глобальной системе координат (6), локальных приращений коорди-

нат (7), текущих оценок координат траектории (8), суммарного приращения

координат на малом отрезке (9), корректирующих добавок координат (10).

определяем общий сдвиг SΣ на заданном локальном отрезке траектории:

∑

(18)

SΣ = Sk.

k=1

Далее определяем отношение отклонения общего сдвига от эталонного зна-

чения (вычисленного на этапе калибровки) к общему сдвигу на локальном

участке:

(19)

ΔSrelate = (SΣ - Setal) /SΣ.

Решающее правило корректировки состоит в проверке условий:

(20)

ΔSrelate < thrΔSrelat и

|ΔSΣ >| thrΔSΣ ,

где thrΔSrelat , thrΔSΣ

заданные пороговые значения. Если оба неравенства

выполняются, вычисляется корректирующая добавка

(21)

Δxkor = parΔSrelatesign(ΔSΣ

),

которая на следующем такте оценки траектории суммируется с текущей оцен-

кой.

Общая структурная схема описанной системы визуальной одометрии пред-

ставлена на рис. 4. Здесь в блоках 1-8 реализуется технология оценки те-

кущих координат траектории, включающая следующие этапы: определение

целопиксельных сдвигов методом экстремальной корреляции, субпиксельное

уточнение оценок методом оптического потока по соотношениям (4)-(11)

и формирование текущих оценок координат траектории по соотношениям

(12)-(17). Блоки 9, 10 реализуют алгоритм коррекции текущих оценок в со-

ответствии с соотношениями (18)-(21).

17

3. Экспериментальные исследования

3.1. Моделирование тестовых траекторий

К сожалению, в настоящее время в открытом доступе пока отсутствуют

тестовые последовательности изображений опорной поверхности, соответст-

вующие изучаемой схеме съемки. Поэтому первая часть экспериментов со-

стояла в моделировании эталонных траекторий для различных типов опор-

ных поверхностей. Моделирование проводилось на плоских горизонтальных

поверхностях. Это не является серьезным недостатком, так как траекторию

движения по заданному рельефу всегда можно восстановить по локальным

проекциям отрезков траектории на плоскость, касательную к каждой точке

рельефа.

Технология моделирования последовательностей изображений опорных

поверхностей строилась следующим образом. На основе игрового движка Un-

real Engine 4 [19] проектировалась виртуальная сцена с имитацией различного

типа подстилающей поверхности, в нулевых координатах которой располага-

лась модель робота с установленной камерой регистрации. В момент стар-

та симуляции робот проходил заданные траектории (прямая, окружность,

квадрат, восьмерка, не пересекающаяся и пересекающаяся поверхность) с за-

данной скоростью перемещения (2, 8 и 15 км/ч), повторяя итерацию для

каждого типа подстилающей поверхности. Камера, закрепленная на роботе

и направленная вниз, записывала изображения с частотой 60 кадров в секун-

ду. Последовательности изображений опорных поверхностей сформированы

для следующих типов поверхности: древесное, каменистое (гравий), почвен-

ное, бетонное и металлическое покрытия, а также песок, грязь и уличная

плитка. Последовательности изображений различной длины для указанных

типов опорных поверхностей размещены на сайте [20].

3.2. Эксперимент по оценке точности технологии

Для проверки качества разработанной технологии визуальной одометрии

использовалась тестовая траектория, включающая 2111 изображений опор-

ной поверхности типа гравий на отрезке времени 35,18 с и соответствующий

этой последовательности файл точных координат траектории.

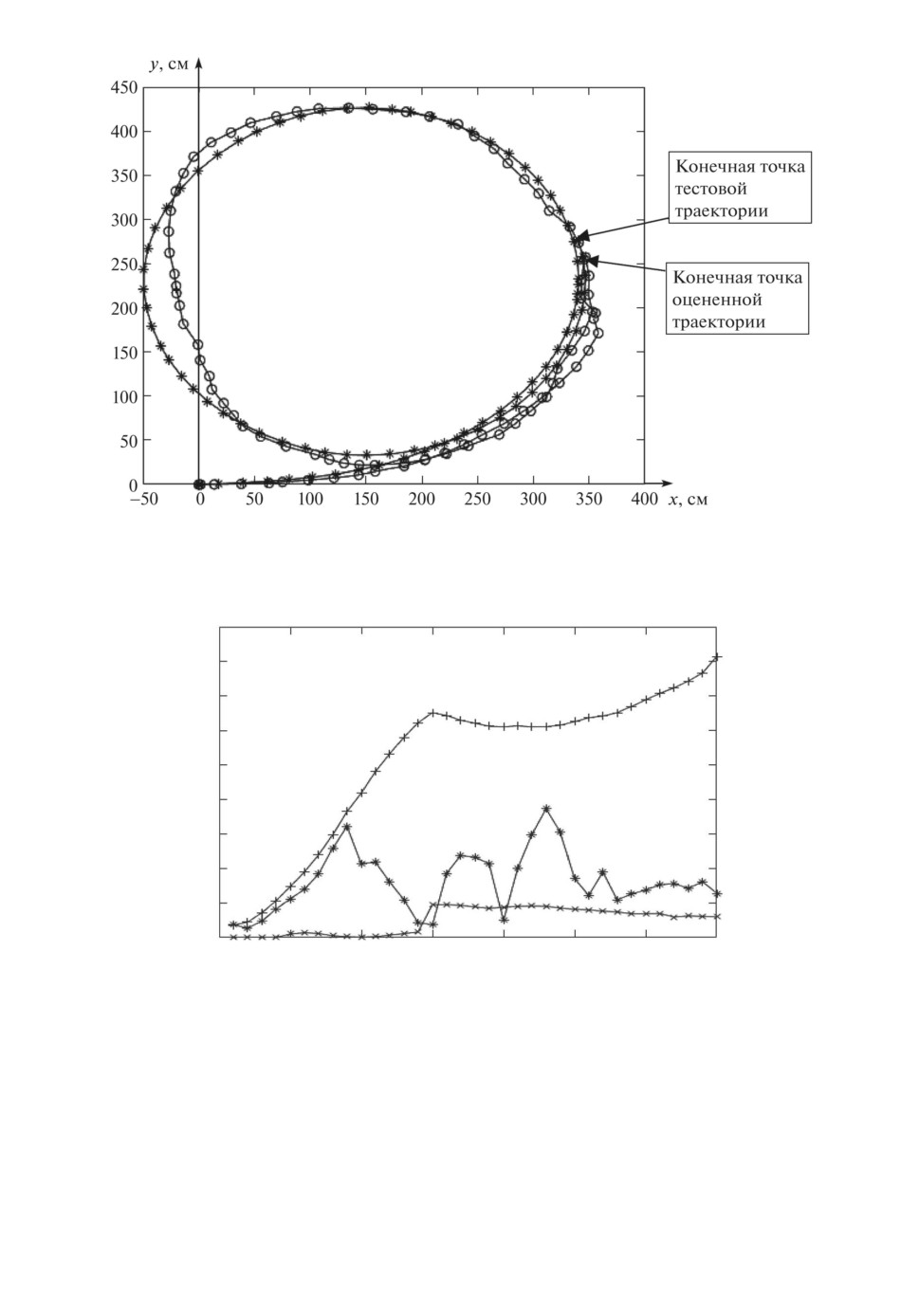

На рис. 5 приведены тестовая (отмечена символом *) и оцененная (сим-

вол о) траектории, полученные при следующих значениях параметров алго-

ритмов: размеры фрагментов

9×9; расстояние от центра кадра до фраг-

мента L/2 = 100 (пикселей), соответственно расстояние между фрагмен-

тами L = 200 (пикселей); среднее значение калибровочного коэффициента

W = 0,0782, длина участка для вычисления локальных калибровочных ко-

эффициентов

25 точек.

Тестовая траектория строилась по значениям, взятым из файла точных

координат. За время между соседними точками на траекториях обрабаты-

валось 25 кадров последовательности изображений. Координаты начальных

точек тестовой и оцененной траектории совпадали (точка

0).

На рис. 6 приведены графики ошибок оценивания угла (в рад.) и теку-

щих координат траектории (в см), полученные при указанных выше условиях

18

Рис. 5. Тестовая (*) и оцененная (o) траектории (общая точка старта

0).

см (+, *);

рад (´)

90

80

70

60

50

40

30

20

10

0

5

10

15

20

25

30

35

c

Рис. 6. Графики изменения во времени текущего угла α (×) (рад.) и евкли-

довой ошибки оценивания траектории (см): без коррекции (+), с коррекцией

оценок (*).

эксперимента и значениях параметров алгоритмов. При этом были получены

следующие относительные значения СКО:

по координате X

0,0647,

по координате Y

0,0491,

по евклидовой метрике

0,0569.

19

На графиках видно, что при отсутствии коррекции оценок (+) ошибка

одометрии возрастает при быстром изменении (возрастании) текущего уг-

ла (×). Ошибка существенно снижается в результате коррекции оценок тра-

ектории (*). Относительные ошибки в конечной точке траектории составили

менее 0,02 и 0,04 для координат X и Y соответственно.

4. Заключение

Предложена новая технология прямой визуальной одометрии по после-

довательности изображений опорной поверхности, регистрируемых камерой,

жестко закрепленной на корпусе аппарата. Технология включает следующие

основные этапы: определение межкадровых (целопиксельных) сдвигов мето-

дом экстремальной корреляции (1); субпиксельное уточнение оценок сдви-

га методом оптического потока (2); определение локальных межкадровых и

накопленного углов поворота аппарата (3); формирование текущих оценок

координат траектории с использованием локальных межкадровых сдвигов

и текущего угла поворота (4); коррекция текущих оценок координат путем

вычисления локальных тарировочных характеристик в процессе движения.

Важной особенностью разработанной технологии является определение

межкадровых сдвигов, как целопиксельных, так и субпиксельных отдельно на

двух разнесенных фрагментах каждого кадра. Для реализации этого подхо-

да наложены ограничения на размеры этих фрагментов, при которых сдвиг

соответствующих точек фрагментов не превышает половины межпиксель-

ного расстояния. Выполнение указанного требования позволило независимо

определить локальные межкадровые повороты, используя уже найденные ко-

ординаты центров фрагментов. Это обеспечило повышение точности оценок

траектории и существенное сокращение объема вычислений, так как отпала

необходимость на каждом такте вычислять матрицу поворота.

В рамках предложенной технологии реализован алгоритм коррекции те-

кущих оценок траектории путем вычисления отклонений локальных тариро-

вочных характеристик от их заданных средних значений. В данном случае

для жестко закрепленной камеры особенность состоит в том, что коррекция

осуществляется только в направлении оси OX локальной системы координат.

Приведенные результаты показывают возможность оценивания траектории в

реальном времени с высокой точностью.

СПИСОК ЛИТЕРАТУРЫ

1. Delmerico J., Scaramuzza D. A benchmark comparison of monocular visual-

inertial odometry algorithms for flying robots // IEEE International Conference

on Robotics and Automation (ICRA), Brisbane, Australia, 2018. P. 2502-2509.

2. He M., Zhu C., Huang Q., Ren B., Liu J. A review of monocular visual odometry //

Visual Comput. 2020. V. 36. P. 1053-1065.

3. Gao L., Su J., Cui J., Zeng X., Peng X., Kneip L. Efficient Globally-Optimal

Correspondence-Less Visual Odometry for Planar Ground Vehicles // IEEE In-

20

ternational Conference on Robotics and Automation (ICRA), Paris, France, 2020.

4.

Forster C., Zhang Z., Gassner M., Werlberger M., Scaramuzza D. SVO: Semidi-

rect visual odometry for monocular and multicamera systems // IEEE Transac. on

Robot. 2017. V. 33. No. 2. P. 249-265.

5.

Muller P., Savakis A. Flowdometry: An optical flow and deep learning based ap-

proach to visual odometry // IEEE Winter Conference on Applications of Computer

Vision (WACV), Santa Rosa, USA, 2017. P. 624-631.

6.

Gonzalez R., Rituerto A., Guerrero J.J. Improving robot mobility by combining

downward-looking and frontal cameras // Robotics. 2016. V. 5. No. 4. P. 25.

7.

Birem M., Kleihorst R., El-Ghouti N. Visual odometry based on the Fourier trans-

form using a monocular ground-facing camera // J. Real-Time Image Proc. 2018.

8.

Gilles M., Ibrahimpasic S. Unsupervised deep learning based ego motion estimation

with a downward facing camera // Vis Comput, 2021.

9.

Fu B., Shankar K.S., Michael N. RaD-VIO: Rangefinder-aided Downward Visual-

Inertial Odometry // International Conference on Robotics and Automation (ICRA),

Montreal, Canada, 2019, P. 1841-1847.

10.

Goecke R., Asthana A., Pettersson N., Petersson L. Visual Vehicle Egomotion Esti-

mation using the Fourier-Mellin Transform // IEEE Intelligent Vehicles Symposium,

11.

Nourani-Vatani N., Borges P.V.K. Correlation-based visual odometry for ground

vehicles // J. Field Robot. 2011. V. 28. No. 5. P. 742-768.

12.

Фурсов В.А., Минаев Е.Ю., Котов А.П. Оценивание параметров движения ап-

парата по наблюдениям опорной поверхности // АиТ. 2021. № 10. C. 124-139.

Fursov V.A., Minaev E.Y., Kotov A.P. Vehicle Motion Estimation Using Visual Ob-

servations of the Elevation Surface // Autom. Remote Control. 2021. V. 82. No. 10.

P. 1730-1741.

13.

Kitt B., Geiger A., Lategahn H. Visual odometry based on stereo image sequences

with ransacbased outlier rejection scheme // IEEE intelligent vehicles symposium,

14.

Pire T., Fischer T., Civera J., Cristoforis P.D., Berlles J.J. Stereo parallel track-

ing and mapping for robot localization // IEEE/RSJ International Conference on

Intelligent Robots and Systems (IROS), Hamburg, Germany, 2015. P. 1373-1378.

15.

Mur-Artal R., Tardos J.D. Orb-slam2: An open-source slam system for monocular,

stereo, and rgb-d cameras // IEEE Transac. Robot. 2017. V. 33. No. 5. P. 1255-1262.

16.

Newcombe R.A., Lovegrove S.J., Davison A.J. Dtam: Dense tracking and mapping

in real-time // International Conference on Computer Vision, Barcelona, Spain, 2011.

21

17. Engel J., Schops T., Cremers D. Lsd-slam: Large-scale direct monocular slam //

European conference on computer vision, Zurich, Switzerland, 2014. P. 834-849.

18. Kerl C., Sturm J., Cremers D. Dense visual slam for rgb-d cameras // IEEE/RSJ

International Conference on Intelligent Robots and Systems, Tokyo, Japan, 2013.

sual Odometry. 2021.

Статья представлена к публикации членом редколлегии А.А. Лазаревым.

Поступила в редакцию 23.01.2022

После доработки 14.04.2022

Принята к публикации 29.06.2022

22