Автоматика и телемеханика, № 12, 2022

© 2022 г. К.Я. ХРЫЛЬЧЕНКО (elightelol@gmail.com),

К.В. ВОРОНЦОВ, д-р физ.-мат. наук (vokov@forecsys.ru)

(ФИЦ ¾Информатика и управление¿ РАН, Москва)

ОПТИМИЗАЦИЯ ВЕСОВ МОДАЛЬНОСТЕЙ

В ТЕМАТИЧЕСКИХ МОДЕЛЯХ

ТРАНЗАКЦИОННЫХ ДАННЫХ1

Современные модели обработки естественного языка, такие как транс-

формеры, работают с мультимодальными данными. В данной работе ис-

следуются мультимодальные данные с помощью мультимодального те-

матического моделирования над транзакционными данными корпоратив-

ных клиентов банка. Предлагается определение важности модальности

для модели, на основе которого рассматриваются улучшения для двух

сценариев моделирования: сохранение максимального количества инфор-

мации с помощью балансирования модальностей и автоматический под-

бор весов модальностей для оптимизации вспомогательных критериев на

основе тематических представлений документов.

Предлагается модель добавления численных данных в тематические

модели в виде модальностей: каждой теме сопоставляется нормальное

распределение с обучаемыми параметрами. Демонстрируются существен-

ные улучшения по сравнению со стандартными тематическими моделя-

ми на задаче моделирования корпоративных клиентов банка. На основе

тематических представлений клиентов банка прогнозируется 90-дневная

просрочка по кредиту.

Ключевые слова: мультимодальное тематическое моделирование, тран-

закционные данные, классификация, прогноз просрочки по кредиту.

DOI: 10.31857/S0005231022120054, EDN: KRWGVF

1. Введение

Современные модели обработки естественного языка, такие как трансфор-

меры [1, 2], принимают на вход мультимодальные данные: последователь-

ность токенов, их позиций, а также сегментов в исходном тексте; для сессион-

ных рекомендаций [3, 4] в качестве модальностей также используется большое

количество дополнительной информации про активность пользователей. Мо-

дальность это отдельный тип метаданных, присутствующий в моделируе-

мых объектах, например, авторы или список литературы в статье. Несмотря

на распространенность мультимодальных данных, методы для объединения

мультимодальных данных в единое векторное представление объекта имеют

1 Работа выполнена при финансовой поддержке РФФИ (проект № 20-07-00936).

44

эвристический характер складываются векторы, сформированные для от-

дельных модальностей. Это разумно только в предположении, что векторы

модальностей находятся в едином семантическом векторном пространстве.

Другим вариантом является конкатенация векторов с последующим приме-

нением многослойного персептрона.

Примером теоретически обоснованного объединения модальностей, имею-

щего вероятностную интерпретацию, является мультимодальное тематиче-

ское моделирование. В данной работе с помощью тематической модели со-

ставляются векторные представления корпоративных клиентов банка на ос-

нове мультимодальных транзакционных данных.

Основной гиперпараметр в мультимодальных тематических моделях это

веса модальностей. С их помощью задается влияние каждой модальности на

итоговую тематическую модель. Плохо подобранные веса приводят к заглу-

шению одних модальностей и доминации других; в худшем случае мультимо-

дальная тематическая модель превращается в обычную тематическую модель

с одной доминирующей модальностью. В разделе 3 приводятся объяснения,

почему перебор весов модальностей плохо работает. В работе вводится опре-

деление важности модальности, на основе которого решаются следующие за-

дачи: балансировка модальностей с целью сохранения наибольшего количе-

ства информации в модели и автоподбор весов модальностей для решения

вспомогательной задачи, например, бинарной классификации для докумен-

тов. В работе доказывается, что мультимодальные тематические представле-

ния документов можно представить в виде выпуклой комбинации тематиче-

ских представлений, построенных для отдельных модальностей.

Предлагаемая в работе оценка оптимальных весов модальностей не тре-

бует перебора значений и повторных обучений тематической модели. Кроме

того, демонстрируется существенное превосходство предлагаемых техник по

сравнению с равными весами модальностей, являющимися, как правило, на-

чальной точкой в любых экспериментах с тематическими моделями. Для де-

монстрации превосходства предложенных методов решается задача прогноза

90-дневной просрочки выплат по кредиту у корпоративных клиентов банка.

В модели получаются интерпретируемые темы, которые можно сопоставить

с различными видами экономической деятельности.

Численные характеристики, такие как количество цитирований статьи,

обычно добавлются в модели с помощью различных эвристик. В нейронных

сетях численные значения преобразуют в векторы с помощью многослойного

персептрона, например, [4] преобразуют время совершения пользовательских

действий в векторы с помощью линейного слоя. В данной работе предлагается

интерпретируемый вероятностный метод для добавления численных данных

в тематические модели. Каждой теме сопоставляется нормальное распределе-

ние с обучаемыми параметрами. Полученная адаптация ЕМ-алгоритма для

гауссовых модальностей в тематических моделях похожа на ЕМ-алгоритм

для смеси гауссиан [5].

45

Статья содержит следующую структуру. В разделе 2 дается математиче-

ская постановка задачи. Раздел 3 посвящен решению проблемы балансирова-

ния модальностей. В разделе 4 предлагается метод добавления вещественной

информации в качестве модальностей в тематическую модель. Описание экс-

периментальной установки, а также результаты экспериментов содержатся в

разделе 5. В заключительном разделе 6 подведены итоги работы и намечены

дальнейшие исследования.

2. Тематическое моделирование

2.1. Обозначения

Тематическое моделирование позволяет сформировать интерпретируемые

векторные представления для больших коллекций документов. Модель дей-

ствует в предположении, что в данных присутствуют некоторые скрытые

переменные, называемые темами.

Пусть D = {d1, d2, . . . } это коллекция сущностей, являющихся основ-

ными объектами моделирования, далее называемых документами. В свою

очередь, документы состоят из токенов в некотором смысле более ¾мел-

ких¿, атомарных сущностей. Словарь W это множество всех уникальных

значений токенов.

Каждый документ d ∈ D представляется как мультимножество

{w1, . . . , wnd }, где wi ∈ W ∀i и nd количество токенов в документе d.

∑

Обозначим за n :=

nd суммарную длину коллекции; ndw количество

d∈D

раз, которое токен w встретился в документе d.

2.2. Вероятностный латентно-семантический анализ

Основную гипотезу тематического моделирования, предложенную Тома-

сом Хоффманом в модели PLSA [6], можно сформулировать следующим об-

разом: каждой паре (токен w, документ d) в коллекции можно сопоставить

некоторую тему t, при этом вероятность появления токена w в документе

зависит только от распределения документа по темам.

Появляется вероятностное пространство с множеством элементарных ис-

ходов Ω = W × D × T и некоторой вероятностной мерой P, где W, D, T

соответствующие множества токенов, документов и тем. Токены w и доку-

менты d являются наблюдаемыми переменными, а темы t скрытыми.

Тогда условие ¾наличие токена w в документе зависит только от распре-

деления документа по темам¿ представляется в виде гипотезы условной

независимости:

(1)

p(w | t, d) = p(w | t).

46

Распределение токена w ∈ W при условии документа d ∈ D принимает вид

∑

p(w | d) =

p(w | t, d)p(t | d) = {1} =

t∈T

∑

∑

= p(w |t)p(t|d) = φwtθtd,

t∈T

t∈T

где Φ ∈ R|W|×|T|, Θ ∈ R|T|×|D|

стохастические матрицы2, являющиеся па-

раметрами тематической модели.

Решение задачи максимизации логарифма правдоподобия наблюдаемой

коллекции документов приводит к оптимальным значениям параметров Φ, Θ

∑∑

∑

ndw log

φwtθtd → max,

Φ,Θ

t∈T

d∈Dw∈W

Φ,Θ стохастические матрицы.

Для решения используется ЕМ-алгоритм

[7]. Во время Е-шага с по-

мощью теоремы Байеса оценивается распределение скрытой переменной

p(t | d, w, Φ, Θ) для всех токенов w ∈ W и документов d ∈ D:

{

}

ptdw = p(t|d,w,Φ,Θ) =

теор. Байеса

=

(2)

p(w | t, Φ)p(t | d, Θ)

φwtθtd

=

=

∑

p(w | d, Φ, Θ)

φwsθsd

s∈T

На М-шаге решается задача Eptdw log p(w, d, t′, | Φ, Θ) → max

Φ,Θ

)

(∑

φwt = normw∈W

ndwptdw

,

d∈D

(3)

(

)

∑

θtd = normt∈T

ndwptdw

,

w∈W

где

f (x)

normx∈X f(x) :=

∑

f (x)

x∈X

Решение можно получить с помощью ККТ [8].

На практике во время обучения модели не принято конструировать тен-

зор ptdw целиком в памяти. Достаточно итерироваться по документам и ак-

кумулировать необходимые статистики. Такой алгоритм обучения тематиче-

ских моделей называется рациональным ЕМ-алгоритмом.

∑m

2 Матрица F ∈ Rm×n называется стохастической, если Fij ≥ 0 и

i=1

Fij = 1, столбцы

образуют вероятностные распределения.

47

2.3. Мультимодальное тематическое моделирование

Рассмотрим ситуацию, в которой документ включает в себя данные раз-

ной природы, т.е. содержит разные модальности. Например, статья состоит

из модальности слов и модальности авторов. Словарь для авторов состоит

из всех возможных авторов, встречающихся в данной коллекции статей. Мо-

дальность m задается словарем Wm и распределением p(w | t), w ∈ Wm, зада-

ваемым стохастической матрицей Φm = (φwt := p(w | t)).

Чтобы подобрать оптимальные значения параметров, необходимо макси-

мизировать взвешенную сумму логарифмов правдоподобия модальностей в

коллекции

∑

∑

∑

∑

λm

ndw log

φwtθtd → max,

Φ,Θ

t∈T

m∈Md∈Dw∈Wm

Φm ∀m, Θ стохастические матрицы,

где λm ≥ 0 веса модальностей. Для упрощения записи обозначим за Φ кон-

катенацию матриц Φm ∀m, в предположении, что словари модальностей не

пересекаются: Wi ∩ Wj = ∅, i = j.

Е-шаг и обновление матрицы Φ выглядят аналогично PLSA (3). Обновле-

ние векторных представлений документов θtd на М-шаге принимает вид

(

)

∑

∑

θtd = normt

λm

ndwptdw

m∈M w∈W

3. Взвешивание модальностей

При обучении мультимодальных тематических моделей распространена

практика ручного перебора весов модальностей изначально веса прирав-

нивают к единичным λm = 1 ∀m, затем веса определенных модальностей ите-

ративно увеличивают или уменьшают. У такого подхода две проблемы:

1. При изменении гиперпараметров необходимо переобучать модель. Бо-

лее того, оценка качества полученной тематической модели является

нетривиальной процедурой ручная оценка интерпретируемости по-

лученных тем или вычисление вспомогательного критерия на основе

полученных векторов, зачастую требующее решения некоторой вспомо-

гательной задачи. Простые процедуры, такие как вычисление перплек-

сии, при решении практических задач не помогают найти оптимальные

значения гиперпараметров.

2. Ручной подбор оптимальных весов модальностей крайне не эффек-

тивная процедура. В разделе 3.1 доказывается, что оптимальные веса

модальностей зависят от частотностей токенов модальностей в докумен-

тах. Например, если в модели две модальности, одна из которых имеет

в среднем сто токенов в документе, а другая один токен, необходимо

увеличить вес модальности с одним токеном в сотню раз для примерно

48

равного влияния обеих модальностей на модель. Примеры таких ча-

стотностей очень распространены текстовые модальности состоят из

сотен токенов в документах, в то время как категориальные признаки

кодируются одним токеном. Поэтому мультимодальные тематические

модели могут быть нечувствительны к небольшим изменениям весов

модальностей.

Так как проблема с долгим переобучением моделей несет исключительно

вычислительный характер, стоит более детально обсудить проблему домини-

рующих и заглушаемых модальностей. Доминирующая модальность это

модальность, у которой в среднем много больше токенов в документе, чем у

остальных модальностей. У заглушаемой модальности в среднем, наоборот,

меньше токенов. При этом и заглушаемые, и доминирующие модальности

могут содержать одинаково полезную информацию для тематической моде-

ли, а в некоторых ситуациях заглушаемая модальность может быть гораздо

важнее. При наличии доминирующей модальности мультимодальная тема-

тическая модель превращается в обычную тематическую модель с одной мо-

дальностью. Далее такие тематические модели с одной модальностью будут

называться унимодальными.

Инициализация весов модальности сбалансированными значениями, пред-

лагаемыми в данной работе, позволяет существенно улучшить тематическую

модель. Под сбалансированными весами модальностей имеются в виду веса,

при которых каждая модальность вносит равный вклад в векторные пред-

ставления документов, изменения которых влияют на тематическую модель.

В разделе 3.1 дается определение сбалансированных весов модальностей с

помощью мультимодального разложения и предлагаются методики для их

определения по статистикам исследуемой коллекции документов.

В отсутствие вспомогательной информации разумно предполагать, что вся

имеющаяся информация одинаково важна, т.е. все модальности одинаково

важны для модели вне зависимости от дальнейшего использования, будь то

анализ полученных в коллекции тем или пользовательской активности. На

практике часто доступна вспомогательная информация, с помощью которой

можно оценить модель, такие как возраст пользователя, факт продолжитель-

ного использования сервиса пользователем, просрочка клиента банка по кре-

диту. При этом тематические векторные представления моделируемых доку-

ментов можно использовать для решения вспомогательных задач, используя

их в качестве входных данных.

Задачи обучения с учителем, решаемые на основе тематических вектор-

ных представлений, далее называем целевыми задачами. Тематическое

моделирование с целевой задачей является наглядным примером признако-

ориентированного переноса обучения: модель предобучается на неразмечен-

ных данных, затем используется как один из блоков для построения целевой

модели, решающей целевую задачу. Разумно предположить, что важность

разных типов входных данных тематической модели, т.е. модальностей, за-

49

висит от рассматриваемой целевой задачи. При предсказании возраста или

половой принадлежности пользователя важна разная информация. Веса мо-

дальностей сильно влияют на итоговое качество решения целевой задачи.

Наивным подходом для автоподбора весов модальностей для целевой зада-

чи является жадная пошаговая стратегия. Изначально выбирается одна мо-

дальность, затем происходит последовательное добавление новых модально-

стей. Предположим, что ищутся оптимальные веса модальностей λ1, . . . , λ|M|

на симплексе Δ|M| = {λm ≥ 0 ∀ m ∈ M,

∑λm = 1}, оптимизируя вспомога-

тельный критерий J(λ). Пусть на шаге m зафиксированы веса первых m

модальностей: λ1, . . . , λm ∈ Δm. Тогда на шаге m + 1 при добавлении модаль-

ности m + 1 подбирается такое α ∈ [0, 1], что значения

λ1 := αλ1; ... ; λm := αλm; λm+1 := (1 - α)

являются оптимальными весами модальности для критерия J(λ(α)). Чтобы

вычислить J(λ(α)), необходимо обучить новую тематическую модель с веса-

ми модальностей λ(α). При наличии целевой задачи придется также переобу-

чать и целевую модель, чтобы получить значение J(α). Для подбора α можно

использовать неточный одномерный поиск, например, метод золотого сече-

ния; применить методы оптимизации первого порядка, такие как градиент-

ный спуск, нельзя из-за невозможности обратного распространения ошибки

через ЕМ-алгоритм.

Большая часть целевых задач могут быть сформулированы как задачи

оптимизации вспомогательного критерия J(Θ, w) → min, где w это пара-

метры целевой модели. Предлагается методика для автоподбора весов мо-

дальностей для решения целевой задачи с дифференцируемым критерием

во время М-шага, основанную на мультимодальном разложении (3.1). Дан-

ная методика не требует переобучения модели, неточного одномерного поиска

или каких-либо других субоптимальных жадных пошаговых стратегий.

3.1. Мультимодальное разложение

Предположим, что сделан Е-шаг (2) ЕМ-алгоритма. Другими словами, за-

фиксируем условное распределение ptdw скрытой переменной t. Пусть nmd

это количество токенов модальности m в документе d. Тогда

Теорема 1 (теорема о мультимодальном разложении). В мультимо-

дальной тематической модели на М-шаге векторные представления доку-

мента являются выпуклой комбинацией унимодальных3 векторных пред-

ставлений

∑

(4)

θtd =

τmdθmtd,

m∈M

3 Унимодальные представления получены с помощью М-шага для унимодальной тема-

тической модели с одной модальностью, при том же значении ptdw.

50

где

(

)

∑

λmnmd

τmd =

∑

,

θm

= normt

ndwptdw

td

λmnm

d

w∈Wm

m∈M

Из данной теоремы, доказательство которой приводится в Приложении, сле-

дует несколько утверждений:

Следствие 1. Вектор (θmtd)t∈T является унимодальным векторным

представлением документа d и модальности m. Его можно получить с по-

мощью М-шага (3) для стандартной тематической модели с одной модаль-

ностью. При |M| = 1 θtd = θmtd. Мультимодальное векторное представление

документа θtd является комбинацией унимодальных векторных представ-

лений θmtd.

Следствие 2. Коэффициент τmd задает влияние модальности на муль-

тимодальное представление документа d. При λm = 1∀m у τmd существует

вероятностная интерпретация это вероятность получить токен мо-

дальности m, если взять случайный токен из документа d.

∑

Следствие 3. Из того, что

τmd = 1, λm ≥ 0 следует, что τd ле-

m∈M

жит на симплексе. А значит, мультимодальное векторное представление

документа θtd является выпуклой комбинацией унимодальных векторных

представлений.

Следствие 4. Веса модальностей λm = (nmd )-1 уравнивают влияние

различных модальностей на векторное представление документа d; получа-

1

ются “равные вероятности” τmd для всех модальностей λm =

∀m ∈ M.

|M|

При использовании ¾небольшой¿ модальности вместе с ¾большой¿ мо-

дальностью, например, авторы и текст статьи, необходимо присваивать мо-

дальности автора в сотни раз больший вес, чем модальности текста статьи,

чтобы модальность авторов оказывала видимое влияние на векторные пред-

ставления документов.

Важности модальностей τmd задаются отдельно для каждого документа

d ∈ D в коллекции. Чтобы сбалансировать модальности для каждого доку-

мента, необходимо вводить новую постановку задачи оптимизации, при ко-

торой каждому документу d ∈ D соответствуют свои веса модальностей λmd,

m ∈ M, и присвоить этим весам модальностей значения λmd = (nmd )-1. Если

оставаться в рамках стандартной постановки задачи, то предлагается сле-

дующая схема взвешивания модальностей:

∑

nd

λm = Ep(d)(nmd)-1 =

∑ (nmd)-1.

nd

d∈D

d∈D

Стоит отметить, что математическое ожидание по p(d) увеличивает влияние

длинных документов на итоговые веса модальностей.

51

Алгоритм 1 (ЕМ-алгоритм с мультимодальным разложением).

1. Вход: Φk, Θk

2. вычислить ptdw для t ∈ T, d ∈ D, w ∈ W , используя формулу 2

3. для всех m ∈ M вычислить Φm и Θm, используя формулу 3

4. вычислить Θk+1 как функцию от Θm, с помощью мультимодального

разложения по формуле 4

5. вычислить Φk+1 как конкатенацию Φ1, . . . , Φm

6. Выход: Φk+1, Θk+1

3.2. Целевые задачи

Сбалансированные веса модальностей позволяют избежать потери инфор-

мации о менее частотных модальностях, нивелируя эффект их заглушения

доминирующими модальностями, который в данной работе был явно выра-

жен через мультимодальное разложение в теореме 1. Однако такие сбаланси-

рованные веса могут быть неоптимальными для целевых задач. Ниже предла-

гается метод для автоподбора весов модальностей, оптимальных для решения

целевой задачи.

Алгоритм 1 позволяет обучить мультимодальную тематическую модаль-

ность с помощью мультимодальной декомпозиции. Он полностью эквивален-

тен стандартному мультимодальному рациональному ЕМ-алгоритму с точки

зрения получаемых параметров модели, однако он вычислительно менее эф-

фективен: необходимо хранить векторные представления для всех модально-

стей Θ1, . . . , Θm, в то время как в рациональном алгоритме хранятся только

финальные, мультимодальные векторные представления документов Θ. Тем

не менее за счет разложения мультимодальных представлений в комбинацию

унимодальных векторных представлений появляется возможность корректи-

ровать веса модальностей, не обучая новую тематическую модель. Финаль-

ные мультимодальные представления документов для заданного набора ве-

сов модальностей λ вычисляются с помощью важностей модальностей τmd и

векторов θmtd как выпуклая комбинация.

Пусть J(Θ)

вспомогательный оптимизационный критерий, который

можно оптимизировать по λ, w:

J (Θ(λ), w) → min,

λ,w

λ ≽ 0,

w ∈ D,

где

∑

λmnmd

Θtd = θtd(λ) = {4} =

∑

θmtd,

λmnm

m=1

d

m∈M

λ = (λ1,...,λM)

веса модальностей, D

допустимое множество значе-

ний w, например, D = {w : 〈w, 1n〉 = 1, w ≽ 0}.

52

Рассмотрим в качестве целевой задачи бинарную классификацию доку-

ментов тематической модели. Каждый документ представляется как вероят-

ностное распределение (θtd)t∈T . Будем оценивать вероятность положительно-

го класса для документа d с помощью линейной модели

∑

∑

ŷd =

wtθtd,

wt = 1, wt ≥ 0.

t∈T

t∈T

Предположим, что вероятность положительного класса зависит только от

темы, тогда коэффициент wt это вероятность положительного класса для

темы t:

∑

∑

∑

p(yd = 1 | d) =

p(yd = 1 | d, t) p(t | d) =

p(yd = 1 | t) p(t | d) =

wtθtd.

t∈T

t∈T

t∈T

Используем мультимодальное разложение

∑

∑ ∑

λmnmd

ŷd =

wtθtd = {4} =

wt

∑

θmtd =

λmnm

t∈T

t∈T

m∈M

d

m∈M

∑

∑

λmnmd

=

∑

ŷmd =

τmdŷmd,

λmnm

d

m∈M

m∈M

m∈M

где ŷmd это вероятность положительного класса для документа d при нали-

чии в нем только модальности m.

Как было замечено в разделе 3, когда отсутствует информация о полезно-

сти тех или иных модальностей для решения целевой задачи, стоит считать

их равноважными и использовать сбалансированные веса модальностей. Без

балансировки модальности с большой средней мощностью4 будут иметь боль-

шее влияние на тематическую модель. В случае классификации документов

сбалансированные веса τmd = 1/|M| приводят к усреднению оценок вероятно-

сти положительного класса m ŷmd по всем модальностям m ∈ M. Получается,

что все модальности вносят равный вклад в предсказание; модальности с

небольшой средней мощностью будут влиять на данные предсказания также,

как и другие модальности, например авторы статьи и текст статьи.

В ситуации когда все-таки задан вспомогательный критерий J, подобрать

оптимальные λ и w можно путем минимизации кросс-энтропии

∑

[yd log ŷd + (1 - yd)log ŷd] → max,

λ,w

d∈D

∑

wt = 1, w ≽ 0,λ ≽ 0,

t∈T

ŷd = ŷd(λ, w).

4 Мощность модальности количество токенов этой модальности в документе.

53

Параметры λ, w можно подобрать для любого дифференцируемого критерия

J (λ, w) с помощью методов оптимизации первого порядка. В данной рабо-

те используется стохастический градиентный спуск. Преобразовать задачу в

безусловную оптимизацию можно следующими заменами:

λ = exp λ, w = softmax( ŵ).

При оптимизации попеременно делаются шаги спуска поλ и ŵ.

4. Численные модальности

Предположим, что доступен некоторый численный признак или мульти-

множество численных характеристик для документа, например, суммы тран-

закций компании или возраст клиента. Предлагается моделировать эти чис-

ленные значения с помощью нормального распределения.

Теорема 2 (теорема о гауссовых модальностях). Пусть каждой теме

t ∈ T в тематической модели сопоставлена гауссиана N(µt,σ2t) с обучаемы-

ми параметрами. Тогда ЕМ-алгоритм для обновления µ,σ2 и всей темати-

ческой модели выглядят следующим образом:

∑

∑ ndxptdx

µt =

∑ ∑

x,

ndxptdx

d∈D x∈R

d∈D x∈R

∑

∑ ndxptdx

σ2t =

∑ ∑

(x - µt)2,

ndxptdx

d∈D x∈R

d∈D x∈R

где ndx

это количество раз, которое значение x встретилось в доку-

менте d, и ptdx вычисляется во время Е-шага: ptdx = p(t|d,x,µt,σt). М-шаг

выглядит идентично М-шагу в стандартной мультимодальной тематиче-

ской модели.

Вывод ЕМ-алгоритма для мультимодальной тематической модели с гаус-

совыми модальностями приводится в Приложении. Далее мультимодальные

тематические модели с гауссовыми модальностями называются обобщенны-

ми мультимодальными тематическими моделями.

5. Эксперименты

5.1. Данные

Для экспериментов используются транзакционные данные корпоративных

клиентов ПАО Росбанк. Документ порождается транзакциями клиента на

заданном интервале времени. Товары и услуги, оказываемые в рамках тран-

закций, извлекаются из платежных поручений с помощью регулярных выра-

жений. Активность компаний делится на продажи и покупки. Формируются

семь различных модальностей: контрагенты (в двух ролях продавцы и по-

купатели), товары и услуги (также в двух ролях), а также бизнес сегмент

54

клиента. В отличие от задач, основанных на текстовых коллекциях, возника-

ют также численные модальности суммы транзакций покупки и продажи.

Предложенные методы тестируются на задаче классификации докумен-

тов: предсказывается 90-дневная просрочка выплат по кредиту на горизонте

года у корпоративных клиентов банка. В качестве признакового простран-

ства используются тематические векторные представления компаний, полу-

ченные из матрицы параметров тематической модели Θ. Количество тем в

тематической модели зафиксировано: |T | = 100.

В качестве алгоритма классификации используется lightgbm [9] с зафик-

сированными параметрами: шаг обучения, равный значению 0.1, количество

листьев, равное пяти, 50 шагов без улучшений до ранней остановки, и мак-

симальное количество деревьев, равно 10 000. В качестве метрики классифи-

кации используется ROC-AUC.

Используется двойная кросс-валидация: данные делятся на 10 равных ча-

стей, называемых внешними фолдами. Каждый внешний фолд использу-

ется как отложенная выборка при обучении на остальных девяти фолдах,

объединенных в одну обучающую выборку. Для ранней остановки градиент-

ного бустинга полученная из девяти фолдов обучающая выборка делится на

10 внутренних фолдов и обучается 10 lightgbm моделей, каждая из которых

использует свой внутренний фолд для ранней остановки. Стоит отметить,

что внешние фолды никак не используются при обучении отдельных моде-

лей или подбора гиперпараметров, поэтому полученные на них результаты

можно считать валидными. Полученные на 10 внешних фолдах метрики ка-

чества усредняются.

Каждый эксперимент повторяется 10 раз с разными зафиксированными

состояниями генератора случайности, результаты усредняются.

Кроме того, стоит еще раз отметить признако-ориентированный характер

экспериментов только для 83 тыс. документов в коллекции присутству-

ет разметка, в то время как остальные данные являются неразмеченными и

используются только для обучения тематической модели. При автоматиче-

ском подборе весов модальностей используется только разметка, попавшая в

обучение итоговой целевой модели, т.е. градиентного бустинга.

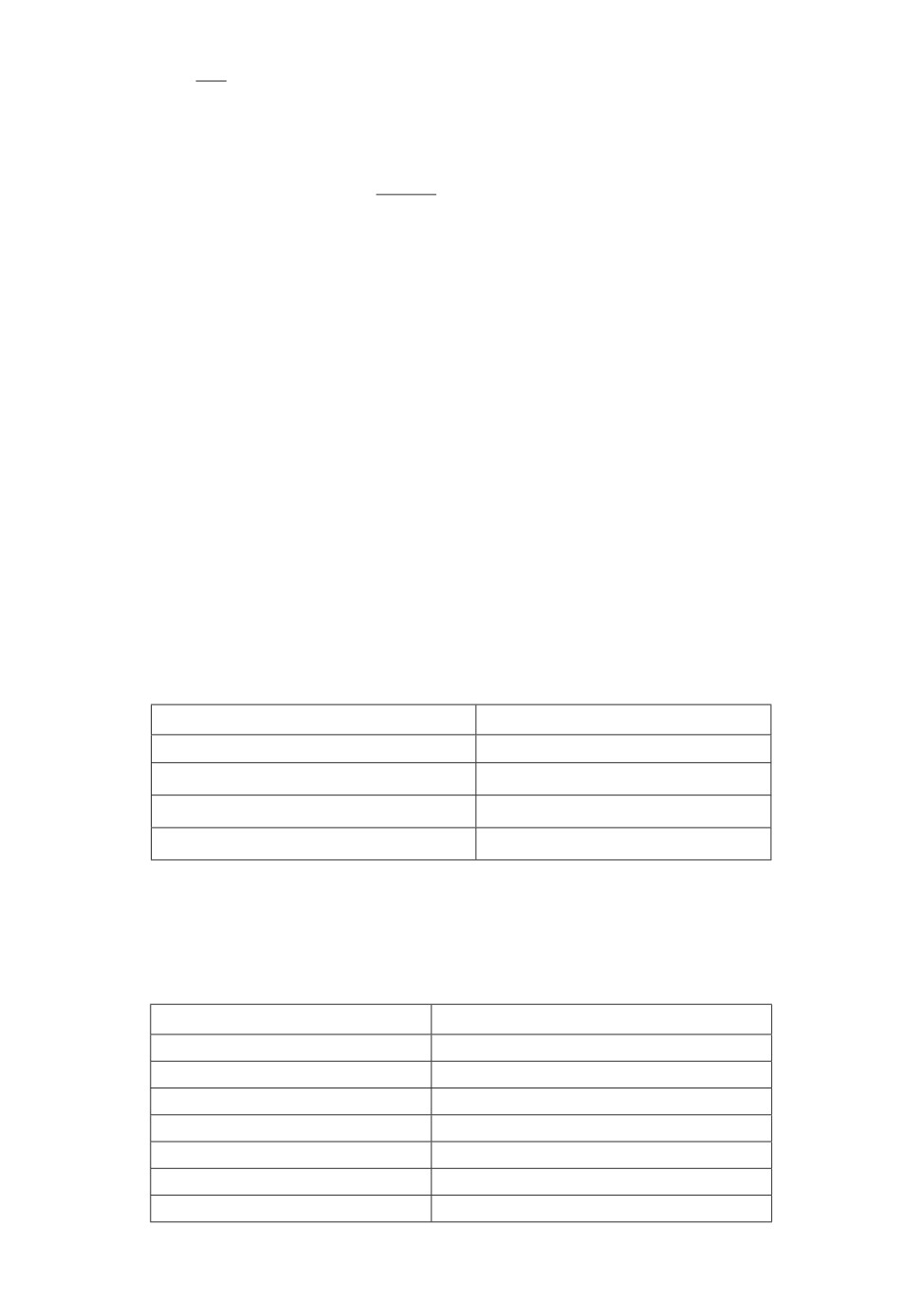

5.2. Балансирование модальностей

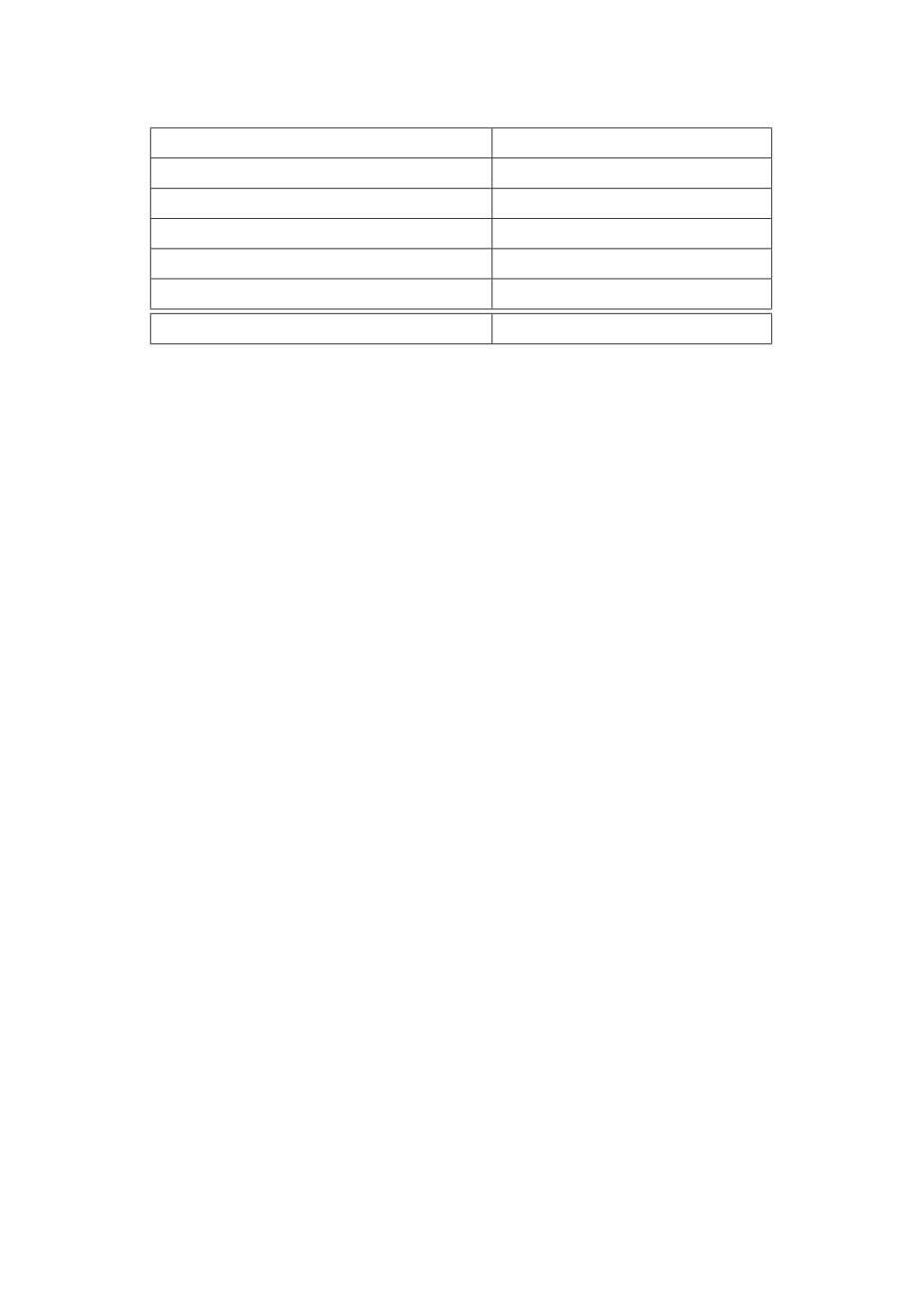

Таблица 1 демонстрирует три различных схемы взвешивания модально-

стей:

1. λmd = (nmd)-1. Чтобы составить полностью сбалансированные веса мо-

дальностей для всех документов, необходимо изменить постановку за-

дачи оптимизации и добавить веса λmd для каждой модальности m и

документа d и решить оптимизационную задачу

∑

∑

∑

m

λ

ndw log

φwtθtd → max

d

Φ,Θ

m∈M,

w∈Wm

t∈T

d∈D

55

∑

1

2. λm =

(nmd)-1. Данный подход предполагает усреднение обрат-

|D|

d∈D

ных мощностей модальностей по всем документам в коллекции.

3. λm = Ep(d)(nmd)-1 корректирует прошлый подход с помощью вероятно-

nd

стей документов p(d) =

∑

nd

d∈D

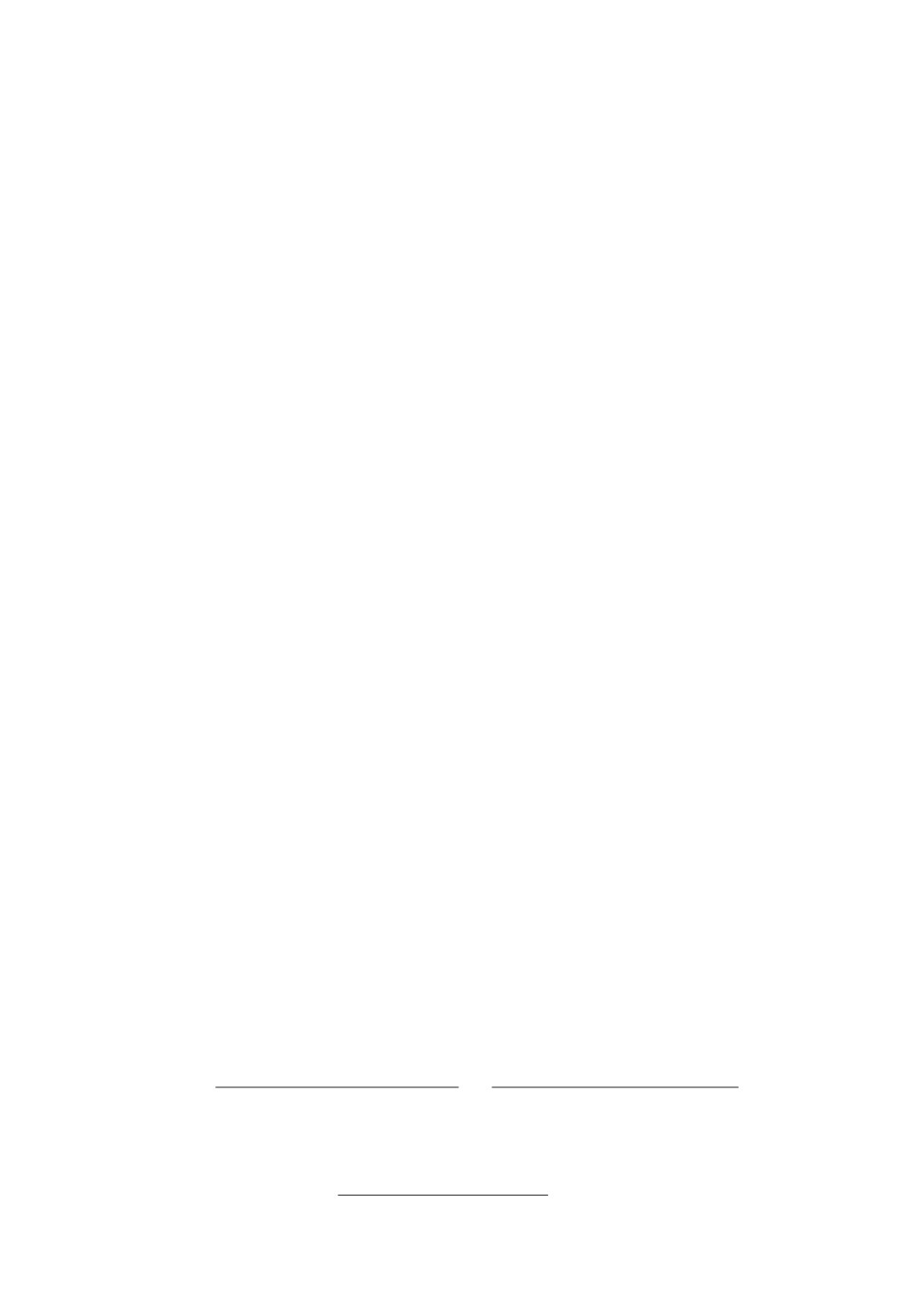

5.3. Численные модальности

Разумно предположить, что суммы транзакций покупок, которые являют-

ся, по сути, потраченными компанией деньгами, важны для целевой задачи

предсказания дефолта. Тем не менее результаты, представленные в табл. 4,

показывают, что использование всей имеющейся информации улучшает мет-

рики на целевой задаче по сравнению с лучшей унимодальной тематической

моделью, использующей толькой суммы покупок.

Таблица 2 демонстрирует три метода добавления численной информации

в модель:

1. Предложенные гауссовы модальности.

2. Счетчики. Во время М-шага (3), вместо использования частот ndw, мы

используем логарифмы сумм транзакций всех транзакций компании d,

в которых встречался токен w. Идея заключается в том, что важность

Таблица 1. Сравнение различных схем взвешивания модальностей

Веса модальностей

ROC-AUC

λm = 1

0,6153 ± 0,0108

λmd = (nmd)-1

0,6422 ± 0,0089

∑

λm =d∈D(nmd)-1/|D|

0,6546 ± 0,0102

λm = Ep(d)(nmd)-1

0,6686 ± 0,0064

Таблица 2. Сравнение различных методов добавления численной

информации. Стандартная модель не использует численную инфор-

мацию. Все модели используют балансировку весов модальностей

λm = Ep(d)(nmd)-1

Модель

ROC-AUC

стандартная

0,6686 ± 0,0064

счетчики

0,6716 ± 0,0084

150 корзин

0,6864 ± 0,0100

50 корзин

0,6936 ± 0,0122

100 корзин

0,6945 ± 0,0095

10 корзин

0,7082 ± 0,0130

гауссианы

0,126 ± 0,0109

56

токенов для документа может быть оценена с помощью сумм транзак-

ций, связанных с этим токеном.

3. Корзины. Все возможные значения численной характеристики разбива-

ются на n корзин, глядя на значения квантилей.

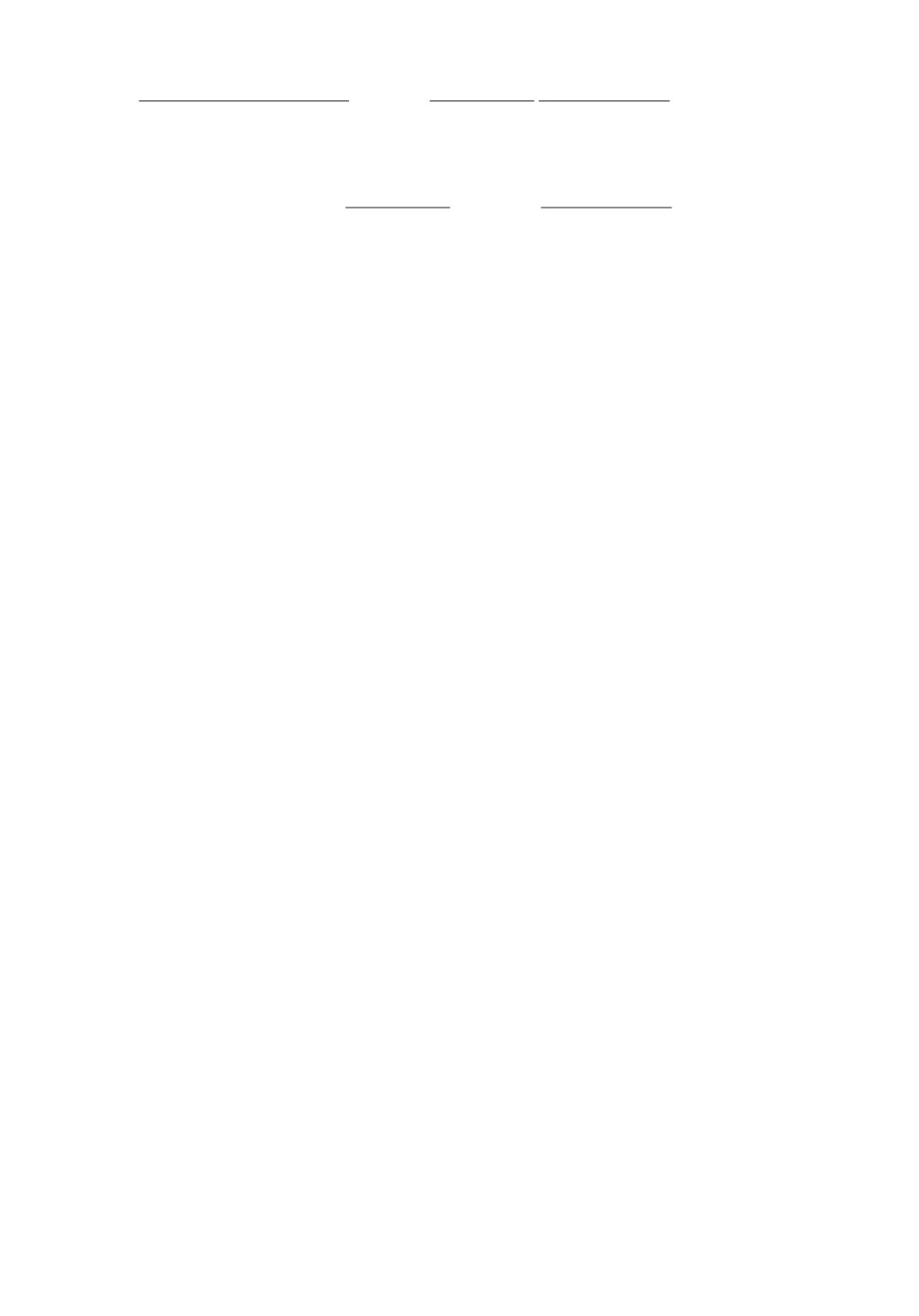

5.4. Решение целевой задачи

Во время М-шага, после вычисления векторных представлений θmtd для

каждой модальности m, происходит корректировка весов модальностей. Ис-

следуются два аспекта автоподбора:

1. Рестарты. Во время каждого М-шага мы переинициализируем веса мо-

дальностей. Отсутствие рестартов означает, что каждый М-шагов на-

чинает корректировку весов модальностей с подобранных на прошлой

итерации наилучших значений весов модальностей.

2. Инициализация. Перед автоподбором и, в случае рестартов, перед каж-

дым М-шагом можно инициализировать веса модальностей сбалансиро-

ванно λm = Ep(d), либо случайно, значениями из стандартного нормаль-

ного распределения N (0, 1).

Веса модальностей λ и параметры линейного классификатора w поперемен-

но оптимизируются шагами стохастического градиентого спуска. В качестве

имплементации градиентного спуска используется библиотека для обучения

нейросетей PyTorch [10], которая предоставляет возможность эксперименти-

ровать с более сложными классификаторами без необходимости собственно-

ручно вычислять градиенты по параметрам.

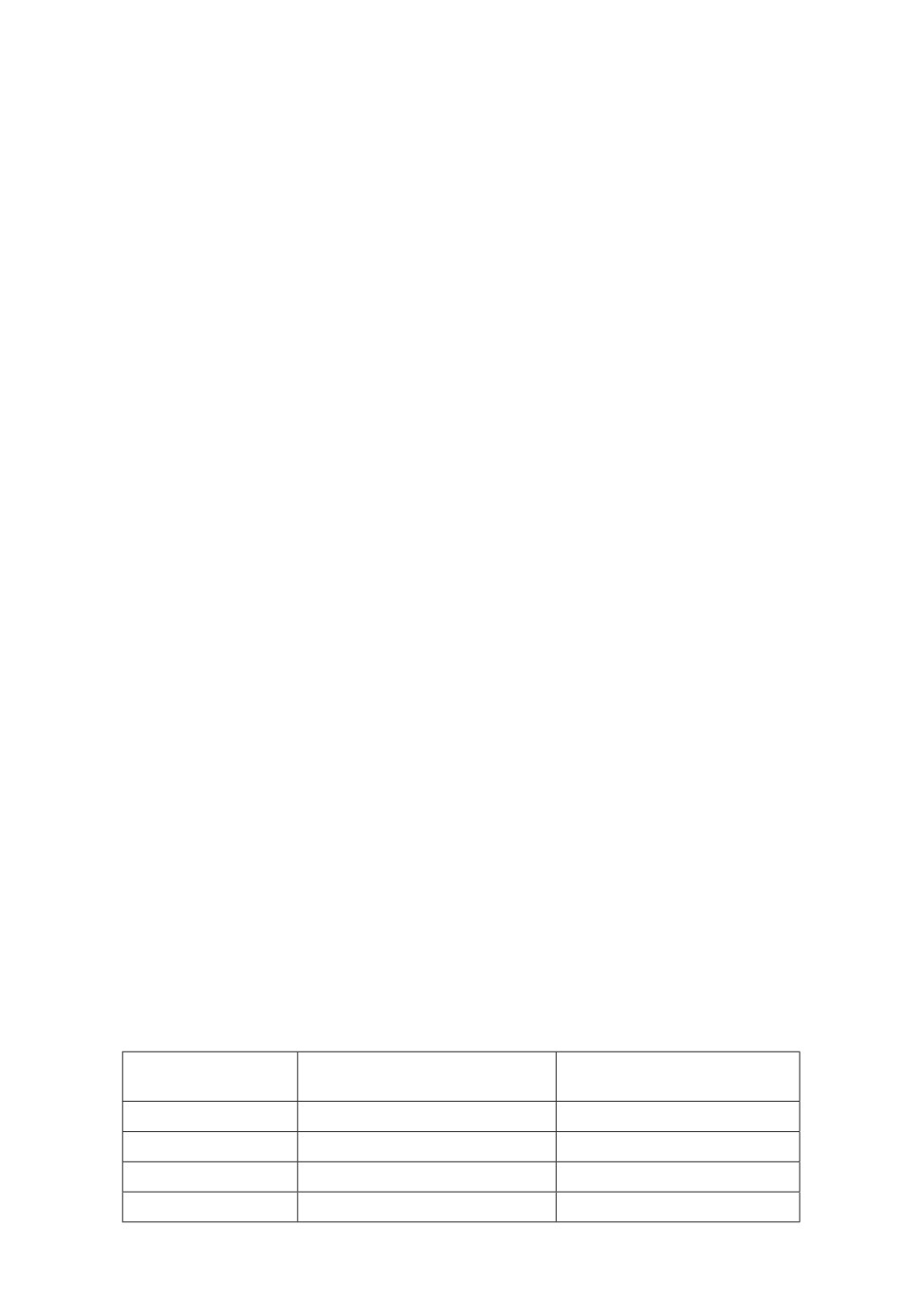

Результаты представлены в табл. 3.

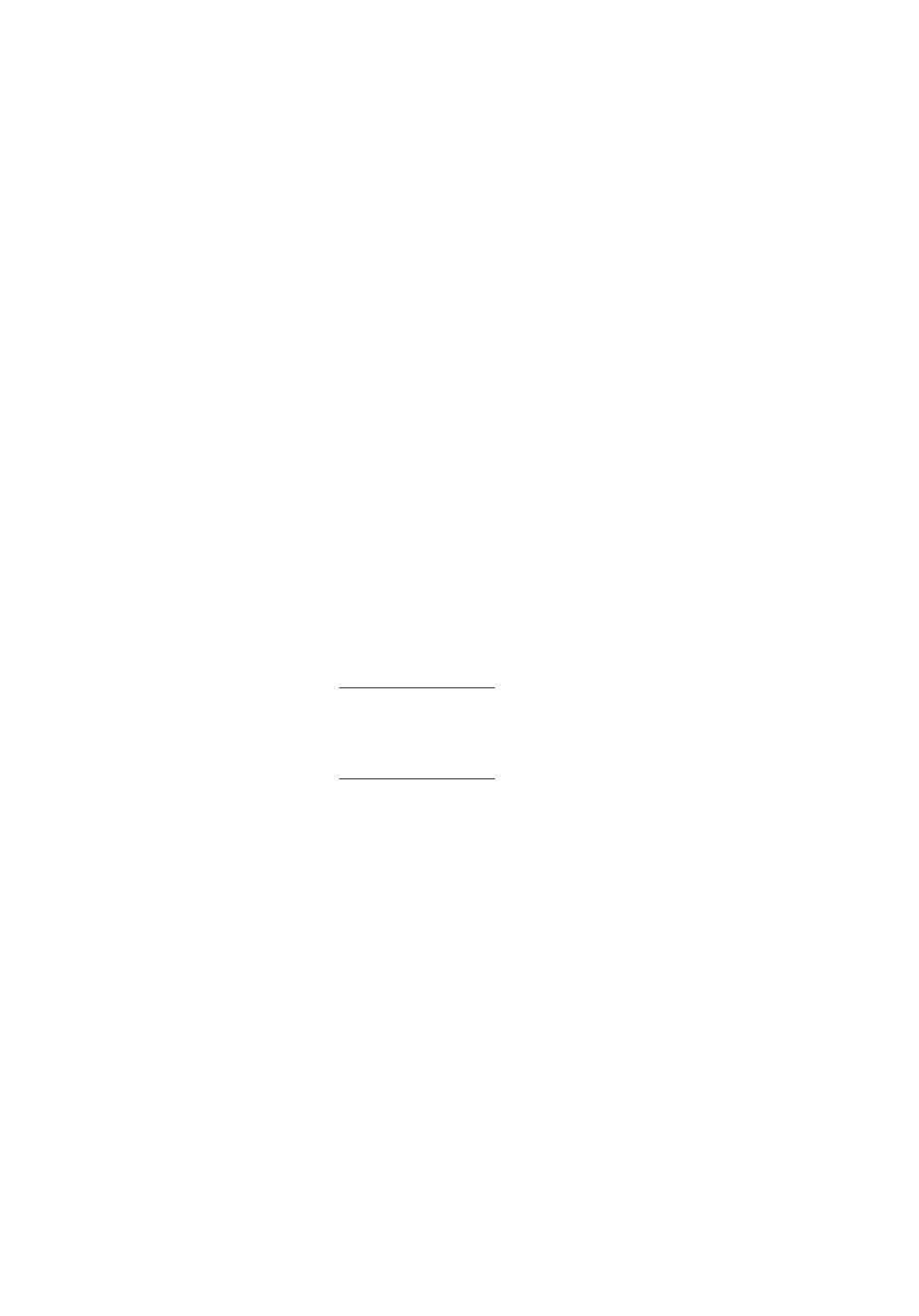

5.5. Результаты

Предлагаемые подходы сравниваются со стандартной мультимодальной

тематической моделью, с лучшей унимодальной тематической моделью,

а также с конкатенацией всех унимодальных моделей. Для каждой модаль-

ности обучается стандартная унимодальная тематическая модель. Лучшей

унимодальной тематической моделью для предсказания дефолта является

Таблица 3. Сравнение различных методик автоподбора весов модально-

стей для решения задачи бинарной классификации на основе тематических

векторных представлений

Сбалансированная

Рестарты

ROC-AUC

инициализация

-

-

0,7182 ± 0,0083

+

-

0,7225 ± 0,0111

−

+

0,7283 ± 0,0044

+

+

0,7356 ± 0,0055

57

Таблица 4. Сравнение стандартной мультимодальной тематической

модели, лучшей унимодальной модели, и конкатенации всех унимо-

дальных представлений с предлагаемыми в работе методами

Модель

ROC-AUC

Стандартная

0,6153 ± 0,0108

Сбалансированные веса

0,6686 ± 0,0064

Гауссовы модальности

0,7126 ± 0,0109

Лучшая унимодальная модель

0,7131 ± 0,0027

Автоподбор весов модальностей

0,7356 ± 0,0055

Унимодальная конкатенация

0,7427 ± 0,0057

гауссова модальность с суммами транзакций, в которых компания-документ

выступает как покупатель. Стоит отметить, что конкатенация унимодаль-

ных векторных представлений документов с точки зрения классификатора,

особенно градиентного бустинга над деревьями, избавлена от проблем муль-

тимодальной тематической модели. При конкатенации векторов сохраняется

информация обо всех модальностях, отсутствует проблема доминирующих и

заглушаемых модальностей. В то же время классификатор может использо-

вать всю полезную информацию из модальностей, так как каждая модаль-

ность представлена набором признаков и у классификатора при выборе оче-

редного признака для ветвления есть доступ к признакам всех модальностей.

Результаты, приведенные в табл. 4, приводят к следующим выводам:

1. Сбалансированные веса модальностей, численные модальности, авто-

подбор весов модальностей позволяют существенно повысить метрики

на целевой задаче.

2. Лучшая мультимодальная тематическая модель, использующая пред-

ложенные техники, существенно превосходит лучшую унимодальную

тематическую модель, что подчеркивает необходимость использования

мультимодальных данных.

3. Сравнительно с конкатенацией унимодальных векторных представле-

ний, предложенный подход сохраняет почти все качество, а значит и

всю полезную информацию для решения целевой задачи. В некотором

смысле мультимодальная тематическая модель это алгоритм сжа-

тия информации из матрицы совстречаемости токенов и документов

для разных модальностей, а унимодальная конкатенация это верх-

няя оценка на качество, которое можно сохранить при использовании

мультимодальных данных.

Тем не менее мультимодальное представление, размерность которого

в 7 раз меньше размерности конкатенации (100 против 700), представля-

ет большую практическую ценность современные масштабные системы

для анализа транзакционных данных требуют хранения заранее посчитан-

ных векторных представлений в быстрых key-value хранилищах, память в

58

которых является крайне ценным и ограниченным ресурсом. Кроме того, с

точки зрения исследовательской ценности, мультимодальное представление

имеет вероятностную интерпретацию и позволяет анализировать получив-

шийся набор тем, а также оценивать схожесть различных документов и токе-

нов с точки зрения различных векторных мер близости, в то время как кон-

катенация тематических представлений разных модальностей вероятностной

интерпретации не поддается, а также требует дополнительных доработок для

оценки близости различных элементов.

6. Заключение

В данной работе исследуется мультимодальность на примере тематических

моделей, а также построение тематических моделей на основе транзакцион-

ных данных. Основной теоретический результат работы, мультимодальное

разложение тематических представлений документов позволяет преобразо-

вать мультимодальные векторные представления в выпуклую комбинацию

унимодальных векторных представлений и оценить вклад модальностей в

тематическую модель при заданных весах модальностей.

В данной работе предлагаются существенные улучшения для мультимо-

дальных тематических моделей с помощью балансирования модальности и

автоматического подбора весов модальностей для решения целевых задач.

Вводится понятие численной модальности и демонстрируются существенные

улучшения по сравнению с базовыми методами добавления численной ин-

формации в тематические модели. Все предложенные методы тестируются

на задаче прогнозирования дефолта для корпоративных клиентов банка по

транзакционным данным.

В качестве дальнейших исследований можно выделить два основных на-

правления: регуляризацию весов модальностей, например, декорреляцию мо-

дальностей, а также расширение предложенных подходов для тематических

моделей с регуляризацией [11].

ПРИЛОЖЕНИЕ

Доказательство теоремы 1.

Покажем, что вероятность θtd темы t в документе d равна выпуклой ком-

бинации θmtd:

∑

∑

∑

∑

λm

ndwptdw

λm

ndwptdw

θtd

∑

∑

∑

∑

∑

=

λm

ndwptdw

λm

ndw ptdw

t∈T m∈M w∈Wm

m∈M w∈Wm t∈T

∑

∑

}

{

}

λm

ndwptdw

{∑

∑

=

ptdw

=1

∑

∑

=

ndw = nm

=

d

λm

ndw

t∈T

w∈Wm

m∈M w∈Wm

59

∑

∑

∑

λm

ndwptdw

ndwptdw

∑

∑

λmnmd

w∈Wm

=

m∈M w∈Wm∑

=

∑

=

τmdθmtd,

λmnm

λmnm

nm

d

d

d

m∈M

m∈M

m∈M

m∈M

∑

ndwptdw

λmnmd

где τmd =

∑

,

θmtd =w∈Wm

λmnmd

nm

d

m∈M

Теорема 1 доказана.

Доказательство теоремы 2.

Разделим оптимизационный критерий для стандартных, m ∈ Ms, и гаус-

совых, m ∈ Mg, модальностей:

∑

∑

∑∑

Ls(Φ,Θ) :=

λm

ndwptdw log φwtθtd,

m∈Ms t∈T d∈D w∈Wm

∑

∑

∑∑

Lg(µ,σ,Θ) :=

λm

ndxpmtdx log N(x|µmt,σ2mt)θtd.

m∈Mg t∈T d∈D x∈R

Тогда оптимизационная задача на М-шаге выглядит как:

Ls(Φ,Θ) + Lg(µ,σ,Θ) → max ,

Φ,Θ,µ,σ

Θ,{Φm |m ∈ Ms} стохастические матрицы,

σ ≽ 0

и может быть поделена на три оптимизационных задачи.

1. Оптимизационная задача для Θ:

∑

∑

∑

∑

∑

λm

ndwptdw +

λm ndxpmtdxlog θtd → max,

Θ

t∈T m∈Ms w∈Wm

m∈Mg x∈R

∑

d∈D;

θtd = 1,

t∈T

θtd ≥ 0, t ∈ T.

Решение задачи идентичной решению для стандартной мультимодаль-

ной тематической модели и выводится с помощью ККТ

∑

∑

∑

∑

θtd = normt∈T

λm

ndwptdw +

λm ndxpmtdx, t ∈ T, d ∈ D.

m∈Ms w∈Wm

m∈Mg x∈R

60

2. Задача для Φ. Для модальности m ∈ Ms и темы t ∈ T :

]

∑

[∑

ndwptdw log φwt → max,

Φm

w∈Wm d∈D

∑

φwt = 1,

w∈Wm

φwt ≥ 0, w ∈ Wm.

Решение задачи идентично решению задачи для стандартной мульти-

модальной тематической модели:

]

[∑

φwt = normw∈Wm

ndwptdw

,

w∈Wm.

d∈D

3. Нахождение оптимальных µt, σ2t. Для модальности m ∈ Mg и темы t ∈ T

∑∑

(

)

ndxpmtdx

- log σt - (x - µmt)2/(2σ2mt)

→ max

µ

mt,σmt

d∈Dx∈R

σmt > 0.

Достаточно приравнять производные к нулю и решить полученные

уравнения

∑

∑ ndxpmtdx

µmt =

∑ ∑

· x, t ∈ T, m ∈ Mg,

ndxpmtdx

d∈D x∈R

d∈D x∈R

∑

∑ ndxpmtdx

σ2mt =

∑ ∑

· (x - µt)2, t ∈ T, m ∈ Mg.

ndxpmtdx

d∈D x∈R

d∈D x∈R

Теорема 2 доказана.

СПИСОК ЛИТЕРАТУРЫ

1. Vaswani A., Shazeer N., Parmar N. et. al. Attention is All you Need // Advances

in Neural Information Processing Systems. 2017. V. 30.

2. Devlin J., Chang M., Lee K., Toutanova K. BERT: Pre-training of deep bidirectional

transformers for language understanding // Proceedings of the 2019 Conference of

the North American Chapter of the Association for Computational Linguistics: Hu-

man Language Technologies, Volume 1 (Long and Short Papers). 2019. P. 4171-4186.

3. Zhu W., Tao D., Cheng X. et. al. BERT4Rec: Sequential Recommendation with

Bidirectional Encoder Representations from Transformer // CIKM. 2019. P. 1441-

1450.

4. Pavlovski M., Gligorijevic J., Stojkovic I. et. al Time-Aware User Embeddings as a

Service // Proceedings of SIGKDD Conference on Knowledge Discovery and Data

Mining. 2020.

61

5. Reynolds D. Gaussian Mixture Models. Boston: Springer, 2009. P. 659-663.

6. Hoffman T. Probabilistic Latent Semantic Indexing // Proceedings of the 22nd An-

nual International ACM SIGIR Conference on Research and Development in Infor-

mation Retrieval (SIGIR ’99). 1999. P. 50-57.

7. Dempster A.P., Laird N.M., Rubin D.B. Maximum Likelihood from Incomplete Data

via the EM Algorithm // J. Royal Statist. Soc. 1977. Series B 39. P. 1-38.

8. Kuhn H.W., Tucker A.W. Nonlinear programming // Proceedings of the Second

Berkeley Symposium on Mathematical Statistics and Probability. 1950. P. 481-492.

9. Ke G., Meng Q., Finley Th. et. al. LightGBM: A Highly Efficient Gradient Boosting

Decision Tree // Advances in Neural Information Processing Systems. 2017. V. 30.

10. Paszke A., Gross S., Massa F. et. al. PyTorch: An Imperative Style, High-

Performance Deep Learning Library // Advances in Neural Information Processing

Systems. 2019. V. 30.

11. Vorontsov V., Potapenko A. Additive regularization of topic models // Mach. Learn.

101. 2015. P. 303-323.

Статья представлена к публикации членом редколлегии А.А. Лазаревым.

Поступила в редакцию 31.01.2022

После доработки 18.05.2022

Принята к публикации 29.06.2022

62