Автоматика и телемеханика, № 12, 2022

© 2022 г. В.Е. АНЦИПЕРОВ, канд. физ.-мат. наук

(antciperov@cplire.ru)

(Институт радиотехники и электроники

им. В.А. Котельникова РАН, Москва)

ГЕНЕРАТИВНАЯ МОДЕЛЬ АВТОКОДИРОВЩИКОВ,

САМООБУЧАЮЩИХСЯ НА ИЗОБРАЖЕНИЯХ,

ПРЕДСТАВЛЕHНЫХ ВЫБОРКАМИ ОТСЧЕТОВ1

В работе обосновывается концепция автокодировщиков, ориентирован-

ных на автоматическую генерацию сжатых изображений. Предлагается

решение задачи синтеза подобных автокодировщиков в контексте мето-

дов машинного обучения, понимаемого здесь как обучение по выборке из

самих же данных. Для этих целей разработано специальное представле-

ние изображений с помощью выборок отсчетов контролируемого размера

(выборочных представлений). Основываясь на специфике данного пред-

ставления формализуется порождающая (генеративная) модель автоко-

дировщиков, которая затем конкретизуется до вероятностной параметри-

ческой модели отсчетов в виде смеси компонент. На основе концепции ре-

цептивных полей обсуждается редукция общей модели смеси компонент

до сеточной модели финитных компонент экспоненциального семейства,

допускающего синтез реалистических с вычислительной точки зрения ал-

горитмов кодирования.

Ключевые слова: машинное обучение, автокодировщики, генеративная

модель, смеси распределений, EM алгоритм, рецептивные поля.

DOI: 10.31857/S0005231022120091, EDN: KSXBRK

1. Введение

Настоящее время характеризется как эпоха больших данных (Big Data).

Большие данные, содержащиеся, например, в сети интернет, включают запи-

си медицинских наблюдений, данные регистрации аудио-, фото- и видеопото-

ков, сканированные документы, графические презентации и т.д. Эти данные

поступают из разных источников, поэтому характеризуются высокой разно-

родностью (variety). Сверх того, более 80% этих данных являются неструк-

турированными, что сильно затрудняет их передачу, хранение и использова-

ние. Большинство изображений в глобальной сети также относятся к катего-

рии неструктурированных данных [1]. Учитывая, что сеть интернет является

крупнейшим мировым репозитарием изображений, можно только сожалеть о

том, что невозможно в полной мере воспользоваться имеющимися ресурсами.

1 Работа выполнена за счет бюджетного финансирования в рамках государственного

задания в ИРЭ им. В.А. Котельникова РАН (ГЗ “РЭЛДИС”).

108

Существует несколько подходов к преодолению означенной выше пробле-

мы больших данных [2]. Например, ввиду того, что исходные изображения

часто имеют высокое качество, а для многих приложений этого не требует-

ся, целесообразно передавать, хранить и использовать изображения в сжатом

виде. Эта нехитрая мысль объединяет тем не менее огромный пласт практи-

ческих исследований. Отметим, что объем этих исследований в последнее вре-

мя только возрос в связи с замечательными успехами в областях нейронных

сетей, глубокого обучения, искусственного интеллекта и т.д. (см. обзор [3]).

Вместе с тем, несмотря на целый ряд новых идей, привнесенных из области

машинного обучения в практику сжатия изображений, большинство новых

методов по-прежнему базируются на фундаментальных идеях Клода Шенно-

на, составляющих основу теории передачи данных с потерями (rate-distortion

theory) [4]. Последняя, по сути, посвящена фундаментальному компромиссу

между стремлением увеличить скорость передачи некоторого закодирован-

ного представления исходных данных и стремлением уменьшить искажения,

обусловленные возможными потерями части информации в процессе сжа-

тия / кодирования. Изначально полагалось, что цель теории состоит в том,

чтобы найти такой способ кодирования исходных (входных) данных, который

максимально минимизировал бы отклонение от них восстановленных (выход-

ных) данных при заданной скорости передачи. Однако известно, что в обла-

сти сжатия (кодирования) изображений минимизация отклонений сама по

себе не обязательно ведет к хорошему качеству восприятия восстановленных

изображений. Например, показано, что использование методов кодирования

в генеративно-состязательных сетях может приводить к заметному улучше-

нию качества восприятия изображения, хотя искажение исходного изобра-

жения может быть не минимальным [5]. В связи с этим в последнее время

был предпринят ряд попыток включения в теорию кодирования изображе-

ний дополнительных элементов, повышающих результирующее качество их

восприятия [6, 7].

Кардинальному пересмотру в новых подходах подверглись классические

методы оценивания качества изображений с помощью функций искажения

(distortion functions), которые определяются обычно как абсолютные или

квадратичные отклонения восстановленной версии изображения от оригина-

ла. Это связано с тем, что подобные простые функциональные метрики мало

адекватны особенностям восприятия изображений человеком, и по этим при-

чинам вплоть до недавнего времени визуальное качество изображений оцени-

валось специалистами, как правило, с помощью категориальных шкал, свя-

занных с субъективными оценками в группах зрителей. По этой причине пер-

вые попытки корректировки теории были направлены на поиски тех нетра-

диционных метрик, которые были бы объективно связаны с визуальным ка-

чеством. Основным требованием к таким метрикам была их высокая кор-

реляция с известными категориальными оценками качества. Среди наиболее

известных перцептивных метрик (perceptual metrics [2]) можно отметить мет-

рику структурного подобия (SSIM) [8] / метрику многомасштабного струк-

109

турного подобия (MS-SSIM) [9], метрику на основе визуальной информации

(VIF) [10], метрику на основе пространственного и временного наиболее оче-

видного искажения (MAD) [11].

Однако наибольших успехов в повышении качества восприятия восста-

новленных изображений удалось достичь не с помощью усовершенствова-

ния метрик искажений, а на пути пересмотра самой концепции искажений.

Речь идет о генеративном моделировании (generative modeling), набирающем

все большую популярность в машинном обучении [12]. Генеративные модели

рассматривают всю совокупность (входных / выходных) данных как набор

случайных переменных и в отличие от дискриминантных моделей (discrimi-

native models) ориентированы на их совместные вероятностные распределе-

ния, нежели на условные. К генеративным моделям, в частности, относятся

генеративно-состязательные сети (GAN) [13], вариационные автокодировщи-

ки (VAE) [14], глубокие сети доверия (DBN) [15] и т.д.

Практическая успешность генеративных моделей теоретически выяснена

не полностью, однако, часто приходится слышать суждение о том, что это

может быть связано с более адекватным моделированием особенностей есте-

ственного интеллекта [16]. Действительно, по мере развития перечисленных

выше подходов [13-15] каждый новый этап разработки добавлял новые эле-

менты, моделирующие особенности иерархической архитектуры коры, глубо-

кого обучения с подкреплением, рабочей памяти в рекуррентных корковых

сетях, долговременной памяти и т.д. В этой связи следует сделать особый

акцент на роли представлений данных. Моделирование функций и структу-

ры коры само в значительной степени предопределяют представления вход-

ных - промежуточных - выходных данных и их взаимосвязи. Вместе с тем

существует ряд примеров, когда именно удачный выбор представлений дан-

ных позволил существенно повысить эффективность реализуемых на их ос-

нове функций [13-15]. Исходя из этого вопросы выбора представлений дан-

ных должны по-видимому играть не последнюю роль в разработке новых

методов кодирования изображений, ориентированных на высокое качество

восприятия.

В данной работе, основываясь на генеративной модели обучения без учи-

теля [12], предлагается новый подход к задачам кодирования изображений

на основе данных самих же изображений посредством рекуррентных авто-

кодировщиков. Предлагаемый подход строится на основе ранее разработан-

ного специального представления изображений (входных данных) с помо-

щью выборки отсчетов контролируемого размера (выборочных представле-

ний) [17, 18]. Поскольку в рамках генеративной модели полное статистиче-

ское описание выборочных представлений задается произведением плотно-

стей распределения вероятностей отдельных отсчетов, в основе предлагае-

мого подхода лежит, по существу, статистическая проблема оценки плот-

ностей распределения вероятностей (density estimation) [19]. В данной ра-

боте ограничимся классом параметрических процедур оценивания [19], что

подразумевает задание некоторого параметрического семейства распределе-

110

ний вероятностей. В качестве последнего предлагается использовать модель

смеси компонент из семейства экспоненциальных распределений (exponen-

tial family distributions) [20]. Соответственно в качестве кодированных изоб-

ражений (выходных данных) используется совокупность оценок параметров

компонент и их весов, вычисляемых по выборочному представлению (вход-

ным данным). В данном контексте оптимальное кодирование синтезирует-

ся на основе метода максимального правдоподобия. Показано, что решение

уравнения максимального правдоподобия для модели смеси компонент при-

водит к рекуррентной процедуре кодирования, которая на каждой итерации,

подобно популярному EM-алгоритму [21], включает два шага. На первом ша-

ге (мягкого) разбиения выборки осуществляется стохастическая ассоциация

отсчетов с компонентами смеси, а на втором производится пересчет оценок.

Для целей алгоритмической (компьютерной) реализации процедуры коди-

рования вводится представление модели в виде системы рецептивных полей,

представляющих собой локальные плотности распределения вероятностей от-

счетов, покрывающих в совокупности все поле изображения. Предложенное

представление позволяет значительно снизить требования алгоритма коди-

рования к вычислительным ресурсам. Кроме того, за счет некоторого упро-

щения представления, подобного используемому, например, в вариационном

EM [22], процедура кодирования сводится к хорошо известным алгоритмам

брегмановской мягкой / жесткой сегментации [23], LBG алгоритму вектор-

ного квантования [24], K-means кластеризации [25] и самоорганизующимся

картам Кохонена [26]. Перечисленные взаимосвязи позволяют рассматривать

предлагаемую процедуру как обобщение по нескольким направлениям хоро-

шо известных методов машинного обучения. Теоретические аспекты пред-

ложенного подхода перцептивного сжатия изображений иллюстрируются по

ходу статьи результатами компьютерного моделирования.

2. Представление изображений выборками случайных отсчетов

В нескольких предыдущих работах (см., например, [17, 18]) было пред-

ложено представление изображений наборами случайных отсчетов (photon-

counting statistics [27]). Данное представление мотивировано, с одной сторо-

ны, прогрессом в развитии SPAD-матриц на основе однофотонных лавинных

диодов [28], а с другой стороны, постоянно растущей тенденцией моделиро-

вания механизмов зрительного восприятия в задачах цифровой обработки

изображений [29]. Отсчетное представление предполагает соответствующее

устройство формирования изображения (photon counting imaging system [27]),

содержащее большое число точечных детекторов, причем предполагается,

что последние настолько малы, что каждый из них может регистрировать

одиночные фотоны падающего излучения.

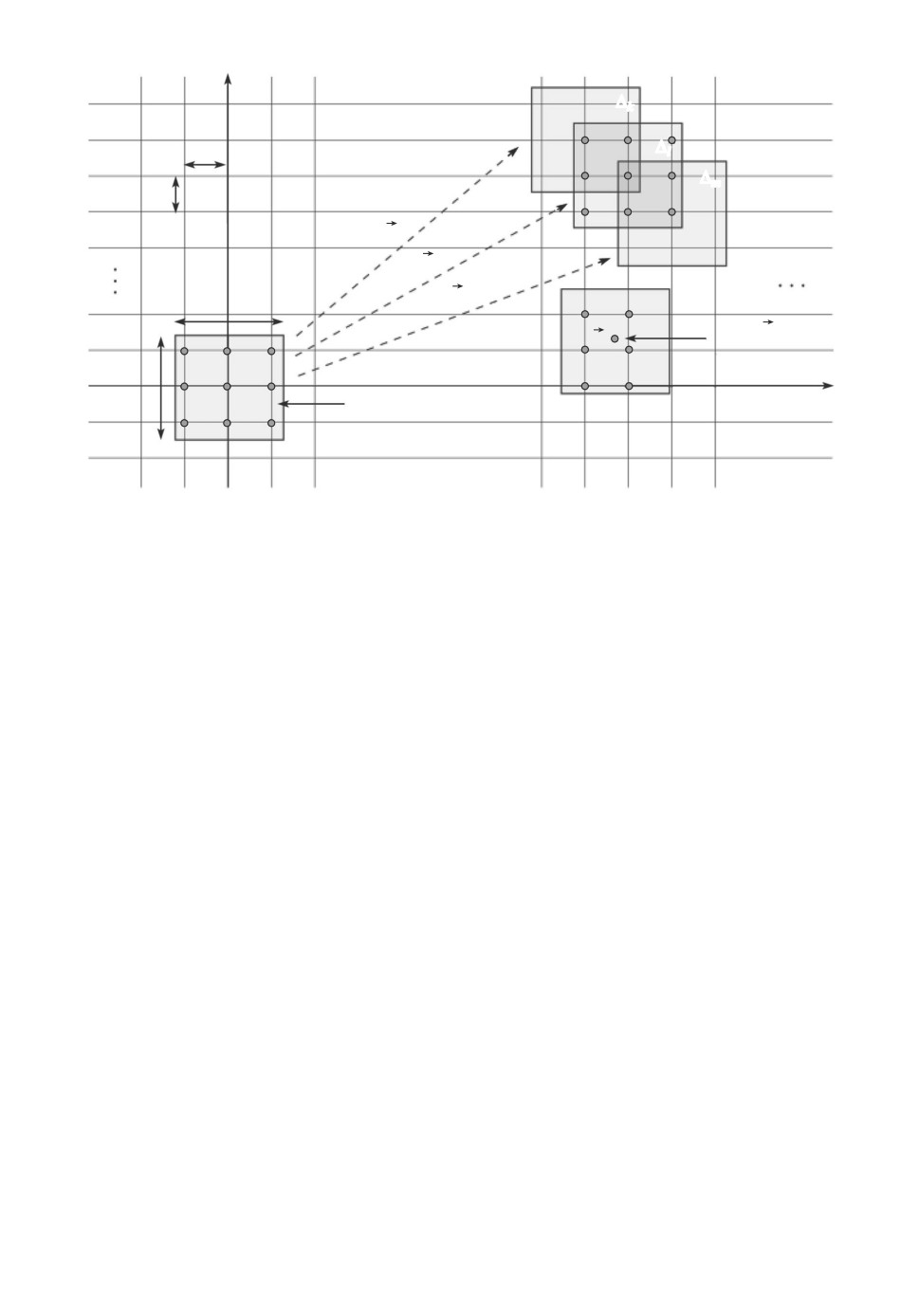

Формально под идеальным устройством формирования изображения бу-

дем понимать плоскую 2D-поверхность Ω, на которой вплотную друг к другу

расположены идентичные точечные детекторы, или “джоты” в терминах [28],

111

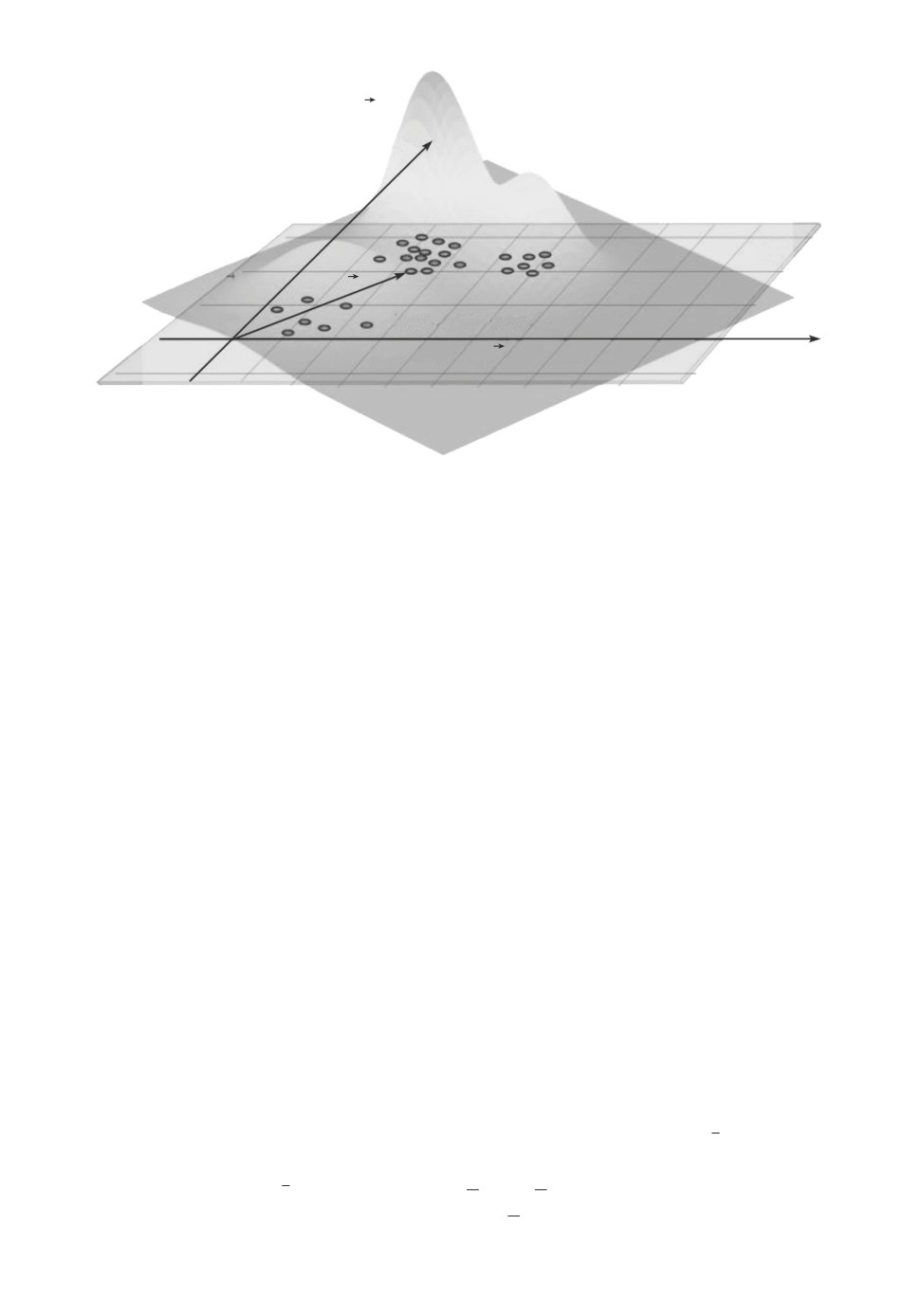

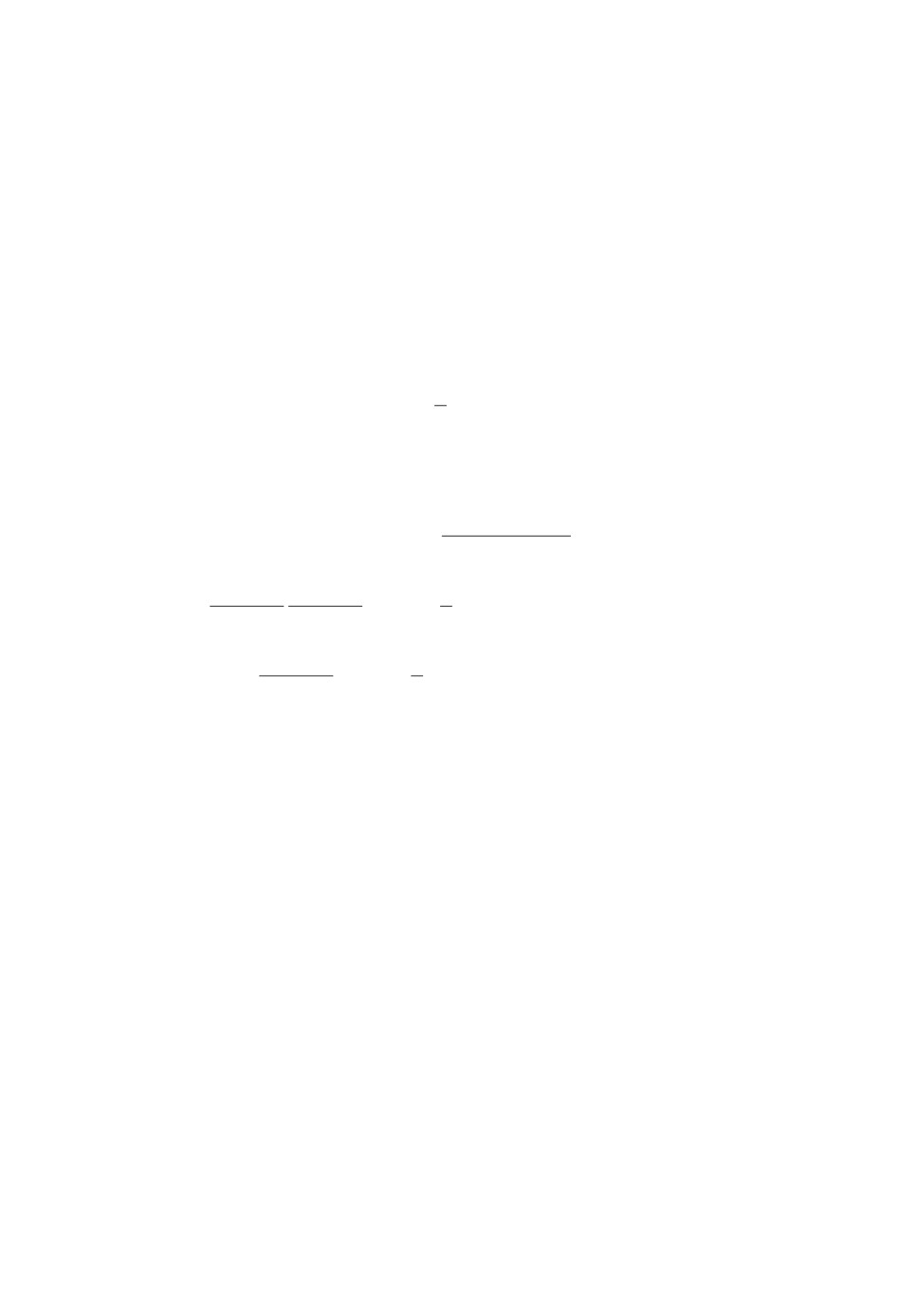

Падающая

интенсивность I(x)

x2

Идеальное устройство

формирования изображения

W

x

0

Регистрируемые

отсчеты xi

x1

Рис. 1. Идеальное устройство формирования изображения и результат реги-

страции падающего излучения интенсивности I(x) в виде набора фотоотсче-

тов X = (x1, . . .,xn).

(см. рис. 1), имеющие малую площадь ds светочувствительной поверхности.

Соответственно, общее количество детекторов будет N = S/ds, где S общая

площадь поверхности Ω. Идеально, в предположении, что S фиксирована,

а ds → 0, число детекторов N → ∞. Таким образом, идеальное устройство

формирования изображения это почти непрерывная чувствительная по-

верхность Ω с координатами x = (x1, x2), задающими положения идеальных

точечных детекторов, как это представлено на рис. 1.

Регистрация падающего на Ω излучения интенсивности I(x, t) проявляет-

ся, согласно современным физическим представлениям [30], в происходящих

на микроуровне случайных событиях, связанных с поглощением фотонов.

Эти события, в зависимости от типа используемых фотодетекторов, могут

состоять в высвобождении фотоэлектронов из p-n переходов полупроводни-

ковых детекторов, в изменении конформации молекул родопсина рецепторов

сетчатки, в образовании атомов металлического Ag из галогенидов сереб-

ра в фотопленках и т.д. Все подобные события обычно объединяются об-

щим термином фотоотсчеты, или просто отсчеты (по поводу терминологии

см. [27]). В модели идеального устройства формирования изображений от-

счеты являются событиями случайными в смысле классической теории веро-

ятностей и задаются пространственными координатами случайными век-

торами x ∈ Ω (совпадающими с координатами соответствующих точечных

детекторов) и случайными же моментами времени регистрации t ∈ (t, t + dt).

В полуклассическом приближении [30] вероятность отсчета за время dt → 0

равна P1(x) = αI(x, t)ds dt, где α = η(hν)-1, hν средняя энергия регистри-

руемого фотона (h постоянная Планка, ν характерная частота излуче-

112

ния), безразмерный коэффициент η < 1 является квантовой эффективностью

материала детектора.

На основе модели идеального устройства формирования изображений

можно сформулировать модель идеального изображения [17, 18]. Под иде-

альным изображением понимается (упорядоченный) набор X = (x1, . . . , xn)

n случайных отсчетов, регистрируемых идеальным устройством в течение

времени экспозиции T . Таким образом, идеальное изображение представляет

собой даже при заданной (детерминированной) интенсивности I(x, t) случай-

ный объект. При этом случайный характер идеального изображения опре-

деляется не только случайными координатами xi отсчетов, но и случайным

числом n их общего количества в наборе X.

Полное статистическое описание идеальных изображений в виде всех ко-

нечномерных плотностей распределений ρ(x1, . . . , xn, n|I(x, t)) может быть

получено в предположении условной независимости отсчетов xi (при за-

данной регистрируемой интенсивности I(x)). Стандартный вывод стати-

стического описания, опирающегося на пуассоновскую аппроксимацию при

ds → 0, N → ∞, Nds = S = const совместной вероятности большого ансам-

бля бернулиевских точечных детекторов (успех регистрация фотоотсче-

та с вероятностью P1(x), неудача отсутствие регистрации с вероятностью

P0(x) = 1 - P1(x)), можно найти, например, в [31]. Приведем здесь лишь

окончательный результат, отвечающий стационарному случаю (I(x, t) =

= I(x)):

ρ(x1, . . . , xn, n | I(x)) = ρ(x1, . . . , xn | n, I(x)) × Pn(I(x)) =

∏

= ρ(xi | I(x)) × Pn(I(x)),

(1)

i=1

∫∫

n

n

Pn(I(x)) =

exp(-n), n = αT

I(x)ds,

n!

Ω

где n среднее число всех отсчетов, ρ(xi | I(x))

плотность вероятности

отсчета:

I(x)

(2)

ρ(xi | I(x)) =

∫∫

I(x)ds

Ω

Отметим, что полное статистическое описание (1), (2) совпадает с рас-

пределением вероятностей событий 2D-точечного пуассоновского процесса

на Ω [31], интенсивность событий которого λ(x) с точностью до αT совпа-

дает с интенсивностью I(x) зарегистрированного излучения.

Из (2) следует, что плотность распределения вероятностей отсчета x ∈ Ω

при регистрации излучения идеальным устройством формирования изоб-

ражений совпадает с нормированной интенсивностью I(x) этого излучения

на Ω. Отметим в этой связи универсальный характер (2): условная плотность

113

распределения вероятностей не зависит ни от квантовой эффективности ма-

териала детекторов η, ни от спектра (в том числе характерной частоты ν

излучения), ни от времени экспозиции T . Более того, она не зависит и от

единиц измерения I(x), будь то абсолютные физические единицы или услов-

ные, полученные в результате оцифровки.

Модель идеального изображения и статистическое описание (1), (2) часто

используются при низких интенсивностях I(x) излучений, например, в об-

ластях флуоресцентной микроскопии, позитронно-эмиссионной томографии

(ПЭТ), однофотонной эмиссионной компьютерной томографии (ОФЭКТ),

оптической и инфракрасной астрономии и т.д. [32]. Однако при обычных

интенсивностях, соответствующих, например, дневному свету, практическое

использование модели идеального изображения оказывается проблематич-

ным. Дело в том, что потоки фотонов, например, от солнца в ясный день

огромны на площадке S ∼ 1mm2 на поверхности земли они составляют

n ∼ 1015-1016 фотонов/с. Очевидно, что работа с такими потоками данных

потребует в практических задачах слишком больших ресурсов. Поэтому для

задач представления изображений с помощью отсчетов желательно скоррек-

тировать приведенную выше модель идеального изображения.

Некоторое время назад было предложено следующее решение пробле-

мы отсчетных представлений [17]. Зафиксируем с самого начала некото-

рое приемлемое значение размеров представления k ≪ n и, рассматривая

идеальное изображение X = (x1, . . . , xn) как некоторую генеральную сово-

купность случайных отсчетов, осуществим из нее, в полном соответствии

с традициями классической статистики, случайную выборку в k отсче-

тов Xk = (xj1 , . . . , xjk ). Очевидно, такое “выборочное” представление по-

прежнему, хотя и при гораздо меньшем размере данных, представляет ис-

ходное изображение X. Назовем Xk представлением изображения выборкой

случайных отсчетов или, короче, выборочным представлением. Статистиче-

ское описание выборочных представлений легко следует из (1), (2) в резуль-

тате интегрирования ρ(x1, . . . , xn), n | I(x) по невыбранным в Xk отсчетам и

суммирования результатов по их числу l = n - k = 0, 1, . . . :

∏

ρ(Xk | I(x)) =

ρ(xj | I(x)) × Pn≥k(I(x)),

j=1

(3)

∑

Pn≥k(I(x)) =

Pk+l(I(x)),

l=0

где Pn≥k(I(x)) обозначает вероятность того, что в идеальном изображении

содержится более, чем k отсчетов. Учитывая пуассоновский характер веро-

ятностей Pn и их асимптотическое стремление при n → ∞ к гауссовому рас-

пределению со средним n, несложно показать, что в случае n ≫ 1 вероятность

Pn<k(I(x)) будет меньше ε, как только k < 2εn и, соответственно, Pn≥k(I(x))

будет отличаться от единицы менее, чем на ε. Считая далее, что для пред-

114

ставления изображений выборками случайных отсчетов Xk размеры послед-

них удовлетворяют k ≪ n и полагая Pn≥k(I(x)) = 1, с точностью до малого

ε = k/2n, получим из (3):

∏

(4)

ρ(Xk | I(x)) =

ρ(xj

| I(x)).

j=1

Заметим, что (4) формально следует из (2) в предположении, что иде-

альное устройство формирования изображений при регистрации излучения

интенсивности I(x) практически наверное содержит (гораздо) больше отсче-

тов, чем размер выборочного представления k. Именно, предполагая в этих

обстоятельствах условную независимость произвольных k отсчетов

xj ∈ Ω,

придем сразу же к (4), перемножив плотности распределений (2).

Статистическое описание

(4) для выборочных представлений Xk =

= (x1, . . . , xk) имеет ряд привлекательных свойств (новая нумерация соот-

ветствует номерам выбранных отсчетов, а не отсчетам идеального изоб-

ражения X, как это было выше). Это описание, во-первых, фиксирует

условную независимость и одинаковое условное распределение (iid свойство)

всех k отсчетов {xj}. Во-вторых, плотности распределений отдельных от-

счетов ρ(xj | I(x)) кратны распределению интенсивности I(x) по поверхно-

сти Ω изображения (см. (2)). И, в-третьих, как это было отмечено выше,

описание (4) также обладает свойством универсальности не зависит ни от

квантовой эффективности материала детекторов η, ни от спектра излучения,

ни от времени экспозиции T . Таким образом, перечисленные свойства выбо-

рочных представлений осуществляют удобную форму представления вход-

ных данных для многих хорошо разработанных статистических подходов и

методов машинного обучения, включая наивный байесов подход.

Более того, ввиду независимости распределений ρ(xj | I(x)) в (4) от аб-

солютных значений интенсивности (см. (2)) статистические описания выбо-

рочных представлений Xk также не зависят от единиц измерения интенсив-

ности I(x). В частности, если интенсивность зарегистрированного излучения

задана пикселами {mi} некоторого цифрового изображения, описание (4) не

зависит от величины порога квантования Q = ΔI, а будет определяться толь-

ко битовой глубиной пикселов υ (или числом уровней квантования 2υ).

В связи с последним замечанием отметим, что процедуру формирования

выборочного представления для цифровых изображений можно по существу

свести к нормировке πi = mi/Σmi значений пикселей mi ∼ Ii/Q изображения

и последующему семплированию k отсчетов из полученного распределения

вероятностей ρ(xj | I(x)) ≈ πi. Если учесть, что в области машинного обуче-

ния существует целый арсенал методов семплирования, объединенных общим

названием методов Монте-Карло [33], то формирование выборочных пред-

ставлений цифровых изображений можно с алгоритмической точки зрения

рассматривать как применение стандартных процедур.

115

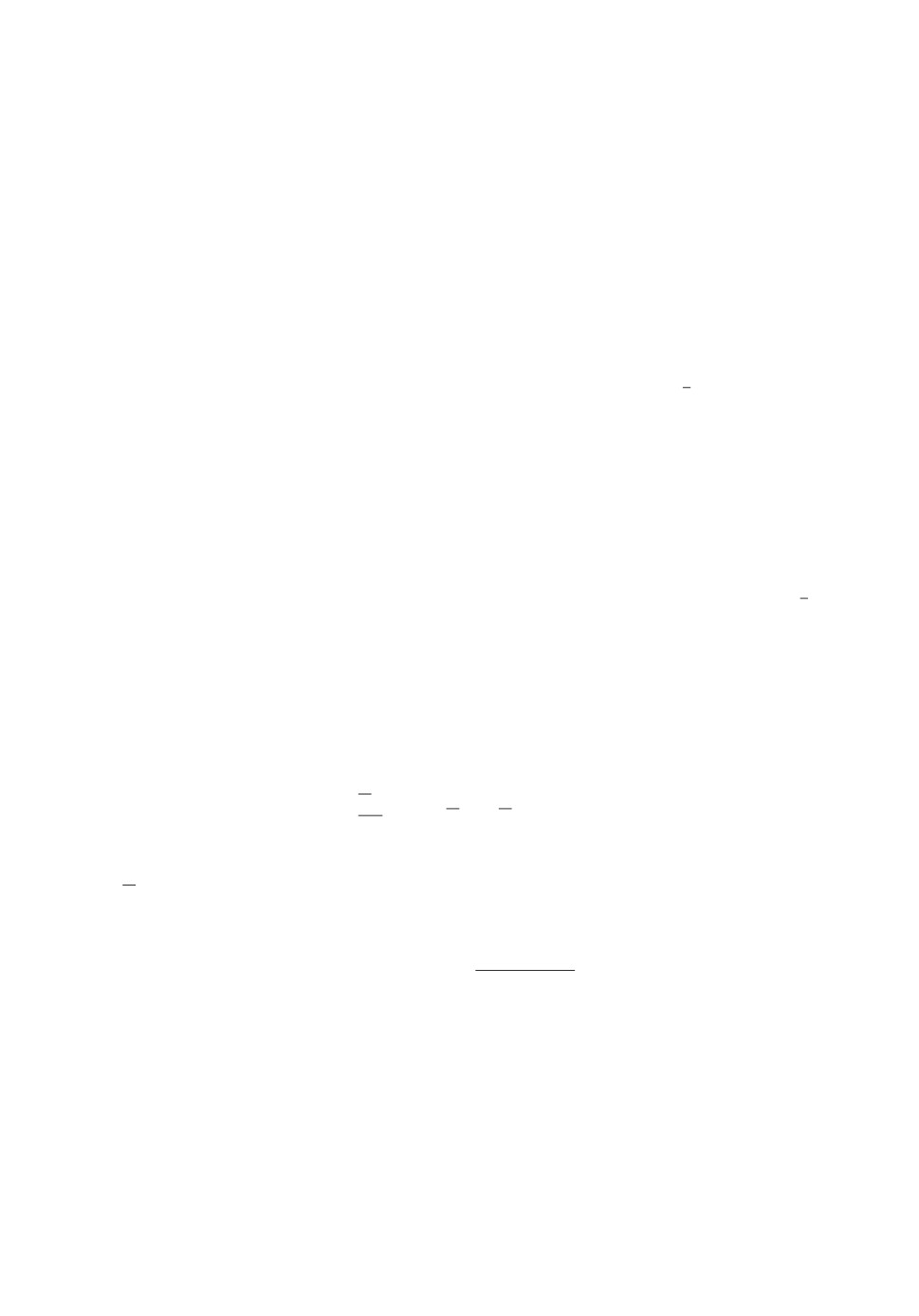

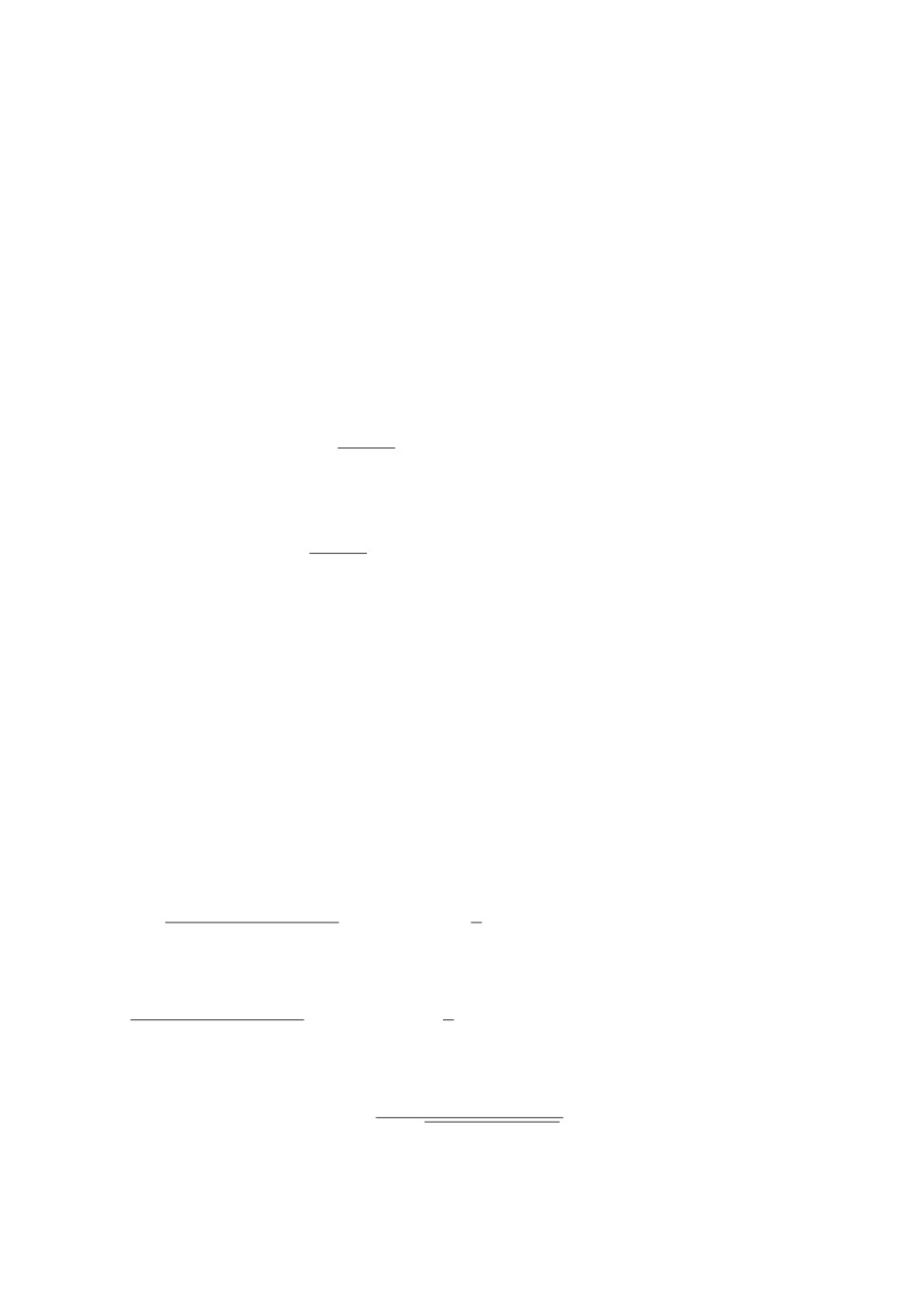

a

б

500 000

в

г

1000 000

5 000 000

Рис. 2. Представление изображения “Cameraman” выборками случайных от-

счетов: a исходное изображение в формате TIFF; б, в, г представления

выборками размеров, соответственно, 500 000, 1 000 000, 5 000 000 отсчетов.

Для примера на рис. 2 приведены представления выборками случай-

ных отсчетов стандартного тестового изображения

“Cameraman”, широ-

ко используемого в публикациях по обработке изображений. Изображение

“Cameraman” задано изначально в формате TIFF, имеет размеры s × s =

= 512 × 512 пикселей (72 dpi), серое, с глубиной цвета υ = 8 бит. Сем-

плирование выборочных представлений в k = 500 000, 1 000 000, 5 000 000 от-

счетов осуществлялось одним из самых простых методов

семплирова-

нием с отклонением (rejection sampling [33]) при равномерном вспомога-

тельном распределении g(x) = 1/s × s = 512-2 и верхнеграничной константе

M = 2υ/m = 256/m, где m = Σmi/s × s среднее значение пикселей изобра-

116

жения. Алгоритмическая реализация приведенной процедуры сводится, та-

ким образом, к случайному выбору равномерно распределенных на поверхно-

сти изображения Ω с координатами (x1, x2) числами с плавающей точкой

случайных векторов xj и включения их в выборку отсчетов Xk при выпол-

нении теста uj < mi , где i индекс содержащего xj пикселя изображения,

а uj реализация случайной, равномерно распределенной на (0,2υ) величи-

ны. Отметим, что для этой процедуры нормировка пикселей не требуется.

В связи с приведенным примером еще раз подчеркнем различие в при-

роде цифровых изображений и их выборочных представлений. Всякое циф-

ровое изображение, например растровое (bitmap), является детерминирован-

ным объектом, представляющим собой раз и навсегда зафиксированную ре-

ализацию (вообще говоря случайного) процесса регистрации излучения. Лю-

бая обработка такого изображения фильтрация, децимация, выравнивание

гистограммы и т.д. всегда будет приводить при заданном алгоритме к од-

ному и тому же результату. Наоборот, как отмечалось выше, выборочные

представления Xk = (x1, . . . , xk) являются случайными объектами и каждая

новая процедура их формирования будет давать реализацию, слегка отлич-

ную от предыдущих. Соответственно, обработка разных реализаций приве-

дет к несколько отличающимся результатам. Трактовать эти отличия следует

статистически, как это делается, например, в теории статистического оцени-

вания. В частности, при увеличении размера выборочного представления k

следует ожидать, что относительные отклонения по реализациям будут стре-

миться к нулю, демонстрируя проявление закона больших чисел. Некоторое

представление об асимптотическом поведении выборочных представлений да-

ет рис. 2.

3. Кодирование и декодирование изображений,

представленных выборками случайных отсчетов

В области машинного обучения автокодировщики (автоэнкодеры, АЭ) рас-

сматриваются как особый класс искусственных нейронных сетей [34], но для

целей данной работы желательно определить их с более общей точки зрения.

А именно, будем рассматривать АЭ как некоторый класс информационных

систем, понимая под последними интегрированные системы компонент для

сбора, хранения и обработки данных. В контексте настоящей работы под дан-

ными естественно подразумеваются изображения. Традиционно АЭ имеют

симметричную трехуровневую структуру вход внутреннее представление

(код) выход, симметрия подразумевает подобие выхода входу.

Пары соседних уровней составляют в АЭ две взаимные компоненты: ко-

дер, включающий уровни вход-код, и декодер, включающий уровни код-вы-

ход [35]. Цель AЭ

восстановить данные на выходе, соблюдая при этом

определенные ограничения, накладываемые на внутреннюю кодировку. Вви-

ду имеющихся ограничений не разрешается просто копировать данные со

ввода на выход. Типичные ограничения связаны с уменьшением размерно-

117

сти промежуточных данных z. В свете подходов машинного обучения коди-

рование z осуществляется на основе обучения АЭ без учителя (unsupervised

learning) [35]. Отметим, что термин “автокодировщик” часто используется как

синоним автоассоциативных, репликативных и др. нейронных сетей.

Для конкретизации АЭ в контексте данной работы возьмем за основу

формально-математическую структуру абстрактного АЭ [36]. Структура АЭ

включает множество G возможных изображений, полученных при регистра-

ции излучения интенсивности I(x) и множество F их внутренних (кодовых)

представлений. Также она включает классы операторов f : G → F (кодеры)

и g : F → G (декодеры), согласованные по размерностям с G и F и с заданны-

ми ограничениями. Кроме того, структура АЭ предполагает количественную

меру D(I(x), Ir(x)) расхождения (искажения) между изображением I(x) на

входе и некоторым его восстановленным вариантом Ir(x) на выходе. Обычно

эту меру называют функцией потерь [35]. В рамках приведенной структуры

задачей АЭ является минимизация функции потерь по отношению к опера-

торам f и g

(

)

(5)

{f∗, g∗} = arg min D

I(x), g ◦ f(I(x))

f,g

Любое решение f∗ уравнения (5) рассматривается как желаемое кодирова-

ние для последующего оптимального восстановления g∗ изображения. К со-

жалению, решение (5) в общем виде задача нереальная. Поэтому при изуче-

нии практических задач необходимо конкретизировать некоторые элементы

общей структуры АЭ. Различные виды АЭ могут быть получены в зависи-

мости от выбора множеств G и F , специальных классов операторов f и g,

явного вида функции потерь D, а также наличия дополнительных ограниче-

ний, таких как гладкость, размерность и пр.

В рамках данной работы входными данными АЭ являются k-выборки слу-

чайных отсчетов выборочные представления Xk = (x1, . . . , xk), порожден-

ные плотностью распределения вероятностей координат отсчетов ρ(x | I(x)),

кратной регистрируемой интенсивности I(x) (2). Таким образом, вполне ра-

зумно выбрать в качестве множества входных изображений G множество

плотностей распределения {ρ(x | I(x))}, x ∈ Ω. Это автоматически подводит

к порождающим (генеративным) моделям АЭ [35]. В отличие от дискрими-

нантных АЭ, которые наиболее естественно интерпретировать как регуляри-

зирующие операторы, автокодировщики в генеративной парадигме рассмат-

ривают внутренние данные (код) F как латентные переменные, а операцию

кодирования как процедуру статистического вывода (нахождения кодовых

представлений по заданному выборочному представлению Xk). В связи с

этим генеративные модели учатся скорее восстанавливать по обучающим вы-

борочным наблюдениям (выборочному представлению) Xk порождающие их

вероятностные распределения, нежели отображать входные данные в выход-

ные. В качестве примеров генеративных подходов отметим вариационные ав-

токодировщики (VAE) [14] и генеративные стохастические сети (GSN) [37].

118

Чтобы формализовать порождающую модель для выборочных представ-

лений изображений Xk = (x1, . . . , xk), рассмотрим множество G как некото-

рое параметрическое семейство G = {ρ(x |θ}, x ∈ Ω,θ ∈ Θ ⊂ Rp плотностей

распределения вероятностей отсчета x. Параметризация G является распро-

страненным подходом, упрощающим общую задачу функциональной опти-

мизации (5) до задачи оценки оптимальных параметров. Обучение без учи-

теля для генеративной модели АЭ заключается в нахождении тех оптималь-

ных параметровθ∗ ∈ Θ, которые определяют выход АЭ в виде плотности

ρ(x |θ∗) ∈ G наилучшим образом соответствующей представлению Xk как

выборке данных на входе.

Формально представление Xk не является элементом G и не может рас-

сматриваться как вход для АЭ, задаваемый некоторыми параметрамиθ (по-

средством ρ(x |θ) ∈ G). Однако, рассуждая в духе байесовского подхода,

предполагая некоторое распределение параметров ρ(θ | Xk) при заданной

выборке Xk, можно выразить связанное с обучением вероятностное распре-

деление в виде:

∫∫

(

)

(6)

ρ

x | Xk = (x1,...,xk)

= ρ(x |θ)ρ(θ | Xk)dθ

Θ

Далее, согласно (Π.8), из Приложения плотность распределения апостери-

орной вероятности ρ(θ | Xk) является, по крайней мере асимптотически, при

k ≫ 1 более узкой функцией θ, чем ρ(x | θ). Поскольку максимум ρ(θ | Xk)

приходится при этом на оценку максимального правдоподобияθML, плот-

ность ρ(x |θ) может быть вынесена из последнего интеграла в (6) как

ρ(x |θML), что приводит к следующему соотношению:

(

)

(

)

(7)

ρ

x | Xk = (x1,...,xk)

=ρ

x | θML (x1,...,xk)

Тем самым, предполагая что на входе имеется некоторая плотность рас-

(

)

пределения ρ

x|θ

, задачей АЭ является формирование таких парамет-

ровθ∗, максимально близких кθML, которые бы на выходе дали плотность

(

)

ρ

x|θ∗

максимально подобную, в соответствии с (7), входной. Другими сло-

вами, задача автокодировщика в генеративной парадигме сводится к реше-

нию уравнений максимального правдоподобия Р. Фишера [38]:

θML = arg max L(θ; Xk),

θ∈Θ

(8)

(

)

∏

∑

(

)

L(θ; Xk) = ln

ρ(Xk |θ)

= ln ρ(xj | θ) = ln

ρ(xj |θ)

,

j=1

j=1

где традиционно использована функция логарифмического правдоподобия

выборочного представления L(θ; Xk), которая представляет собой ввиду (4)

119

сумму функций логарифмического правдоподобия по всем отсчетам выбор-

ки Xk. Отметим, что формально (8) можно получить, если использовать в

качестве функции потерь D(. . .) (5) дивергенцию Кульбака-Лейблера [39]

между эмпирическим распределением ρ(x | Xk)

(6) и параметрическим

ρ(x |θ) ∈ G [19].

Кажущаяся элегантность сформулированной основной задачи АЭ (8) в

рамках генеративной модели связана с переносом акцента с проблемы ко-

дирования входных данных на проблему вычисления оценок максимального

правдоподобия. Последняя задача, известная более ста лет, начиная с осново-

полагающих работ Р. Фишера [38], в реальных приложениях может оказать-

ся не проще (с вычислительной точки зрения), чем синтез дискриминантных

кодировщиков. По этим причинам сделаем еще один шаг в уточнения гене-

ративной модели АЭ, основанной на специфических особенностях архитек-

туры, связанных с внутренними переменными z ∈ F , составляющими про-

межуточное представление данных на входе. Для этих целей уточним гене-

ративную модель автокодировщиков G = {ρ(x |θ)} как модель смеси компо-

нент, в которой внутренние (скрытые) переменные z возникают естественным

образом.

4. Генеративная модель автокодировщика

в виде семейства смеси компонент

Возьмем в качестве параметрического семейства

G = {ρ(x | θ},

x ∈ Ω,

θ∈ Θ ⊂ Rp

плотностей распределения вероятностей отсчета x семейство смесей из K

компонент [20] вида

∑

(9)

ρ(x |θ) =

wiρi(x |θ),

i=1

где {wi}, wi ≥ 0, i = 1, . . . , K являются нормированными весами компонент в

∑

смеси и связаны условием

wi = 1, а {ρi(x |θ)}, ρi(x |θ) ≥ 0, i = 1,... ,K

i=1

являются плотностями распределения вероятностей x ∈ Ω для каждой из

компонент. С точки зрения статистики, смесь (9) формально можно интер-

претировать как маргинальное распределение по x, если для всех отсчетов

наряду с координатами x ввести случайные скрытые (латентные) целочислен-

ные переменные z ∈ {1, . . . , K}, ассоциирующие отсчет с компонентой i = z

смеси. При этом, интерпретируя веса {wi} как априорное распределение ве-

роятностей z, a плотности ρi(x |θ) как условные распределения ρ(x | z = i,θ),

слагаемые wiρi(x |θ) = wiρ(x | z = i,θ) = ρ(x, z = i |θ) в (9) можно интерпре-

тировать как совместные распределения вероятностей “полных” наборов дан-

120

ных {x, z}, а ρ(x |θ) как маргинальное по отношению к нему распределение

ρ(x, z |θ) = wzρz(x |θ),

(10)

∑

ρ(x |θ) =

ρ(x, z |θ).

z=1

Обычно априорные вероятности {wi} являются частью множества пара-

метровθ смеси. В отношении же оставшихся параметров предполагается, что

они могут быть разбиты на K непересекающихся групп {νi}, i = 1, . . . , K,

νi ∈ Ξ ⊂ Rq так, что от параметров z-й группы, и только от них зависят услов-

ные распределения ρz(x |θ) = ρz(x |

νz) . Таким образом, полный набор пара-

метров моделиθ = {{wi}, {νi}} ∈ Θ ⊂ Rp, i = 1, . . . , K, p = K(q + 1) рассмат-

ривается как объединение наборов весов {wi} и параметров {νi} компонент.

Отметим, что вθ по крайней мере часть параметров

{wi} зависимы свя-

заны условием нормировки. В сделанных предположениях модель смеси (10)

уточняется посредством ρ(x, z |θ) = wzρz(x |

νz).

С учетом (10) задача нахождения максимума функции правдоподобия (8)

для смесей принимает вид (в предположении, что помимо условия нормиров-

ки для {wi} другие ограничения на параметры отсутствуют):

∑

(

)

∇⃗

∇

L(θ∗;Xk) =

θ ln

ρ(xj |θ∗)

=

θ

j=1

∑

∑

1

∇⃗

=

ρ(xj, zj |θ∗) =

θ

ρ(xj |θ∗

j=1

) zj=1

(11)

∑

(

)

∑ ρ(xj , zj | θ∗)

∇⃗

=

ln

ρ(xj , zj |θ∗)

=

θ

ρ(xj |θ∗)

j=1 zj=1

∑

∑

(

)

=

ρ(zj | xj ,θ∗)∇⃗ln

ρ(xj , zj |θ∗)

= λℑ,

θ

j=1 zj=1

где ρ(z | x,θ) = ρ(x, z |θ)/ρ(x |θ) апостериорная вероятность скрытых пе-

ременных z, а векторℑ является индикатором частных производных по

параметрам-весам: он состоит из нулей, кроме единиц, на местах соответ-

ствующих ∂L(θ∗; Xk)/∂wi в левой части (11). Кратныйℑ вектор λℑ возникает

при применении метода неопределенных множителей Лагранжа для условной

максимизации L(θ; Xk) с ограничением нормировки на {wi}. Cоответственно

∑

неопределенный множитель λ находится из условия w∗i(λ) = 1.

i=1

Уравнения максимального правдоподобия

(11) содержат в левой ча-

сти линейную комбинацию градиентов логарифмических функций прав-

∇⃗

доподобия отсчетов (функций вкладов

score functions)

l(θ; xj , zj ) =

θ

121

(

)

= ∇⃗θln

ρ(xj , zj |θ)

, которую обычно проще анализировать, чем саму лога-

рифмическую функцию правдоподобия L(θ; Xk). Действительно, используя

ρ(xj, zj |θ) = wzj ρzj (xj | νz) (см. (10) и далее), получим

∂l(θ∗;xj,zj)

δzjz

=

,

∂wz

w∗

(12)

zj

(

)

ρzj (xj | ν∗z

)

∇νz l(θ∗; xj , zj ) =∇νzj ln

j

δzjz,

где δzj z

символ Кронекера.

Подстановка (12) в (11) упрощает уравнения максимального правдоподо-

бия до:

∑

)

ρ(z | xj,θ∗

∂L(θ∗;Xk)

j=1

=

= λ,

∂wz

w∗z

(13)

∑

(

)

∇νz L(θ∗; Xk) =

ρ(z | xj ,θ∗)∇⃗νz ln

ρz(xj | ν∗z)

=0.

j=1

Домножая уравнения, содержащие λ каждое на w∗z и суммируя их по z,

получим, вследствие условий нормировки {w∗i} и апостериорных распреде-

лений ρ(z | x,θ), что значением неопределенного множителя является λ = k.

Это позволяет освободиться от λ в уравнениях (13) и придать им следующую

компактную форму: 0

z = 1,...,K,

∑

1

w∗z =

ρ(z | xj,θ∗),

k

(14)

j=1

∑

(

)

ρ(z | xj ,θ∗)∇⃗ν

ln

ρz(xj | ν∗z)

=0.

z

j=1

Дальнейшее уточнение уравнений (14) максимально-правдоподобного вос-

становления изображений по выборке Xk = (x1, . . . , xk) зависит от выбора ви-

да зависимости плотностей (условного) распределения вероятностей отсчетов

ρz(xj | νz) от параметров νz для каждой из z-компонент (от конкретизации

параметрической модели смеси (10)). Основная идея, лежащая в основе пред-

лагаемой ниже модели, связана с теорией рецептивных полей.

5. Генеративная модель автокодировщика

с компонентами смеси в виде рецептивных полей

Теория рецептивных полей позволяет использовать в задачах обработки

изображений современные представления о механизмах восприятия челове-

122

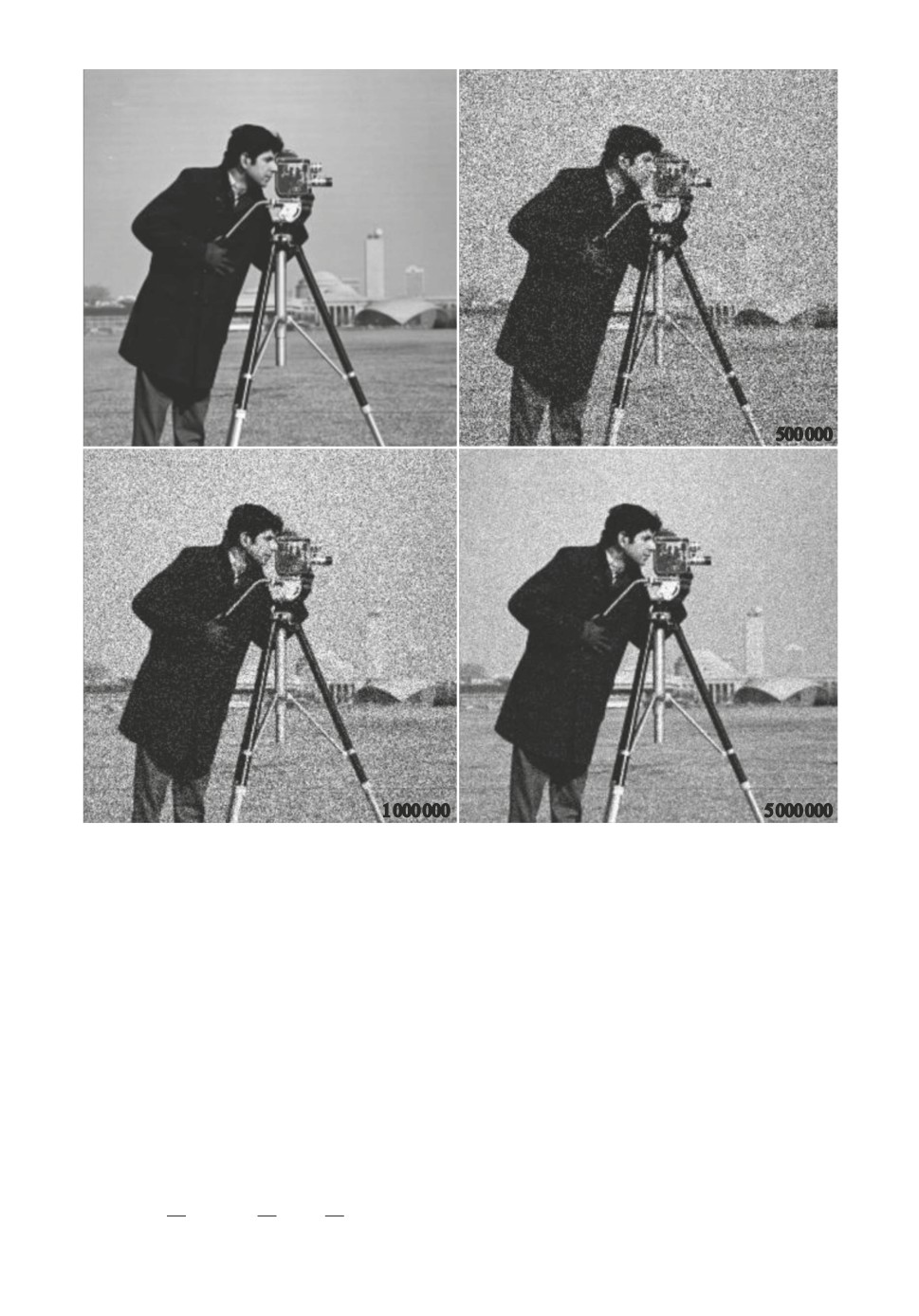

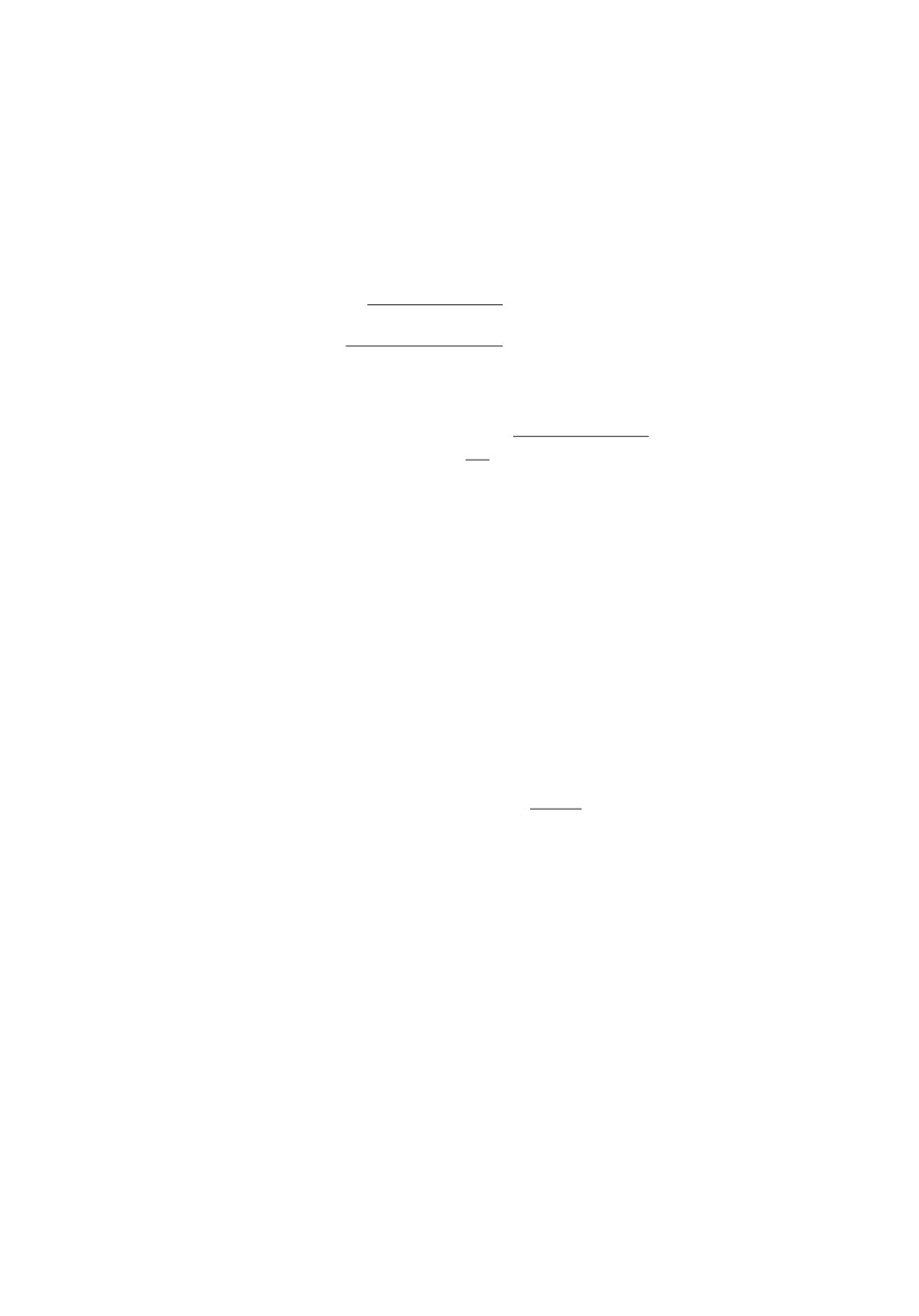

x2

компоненты

W

D

k

в узлах решетки

Dl

d

Dm

d

mk

ml

mm

D

D

отсчет x и его

x

D

D-окрестность

D

x1

базовый носитель

D > d

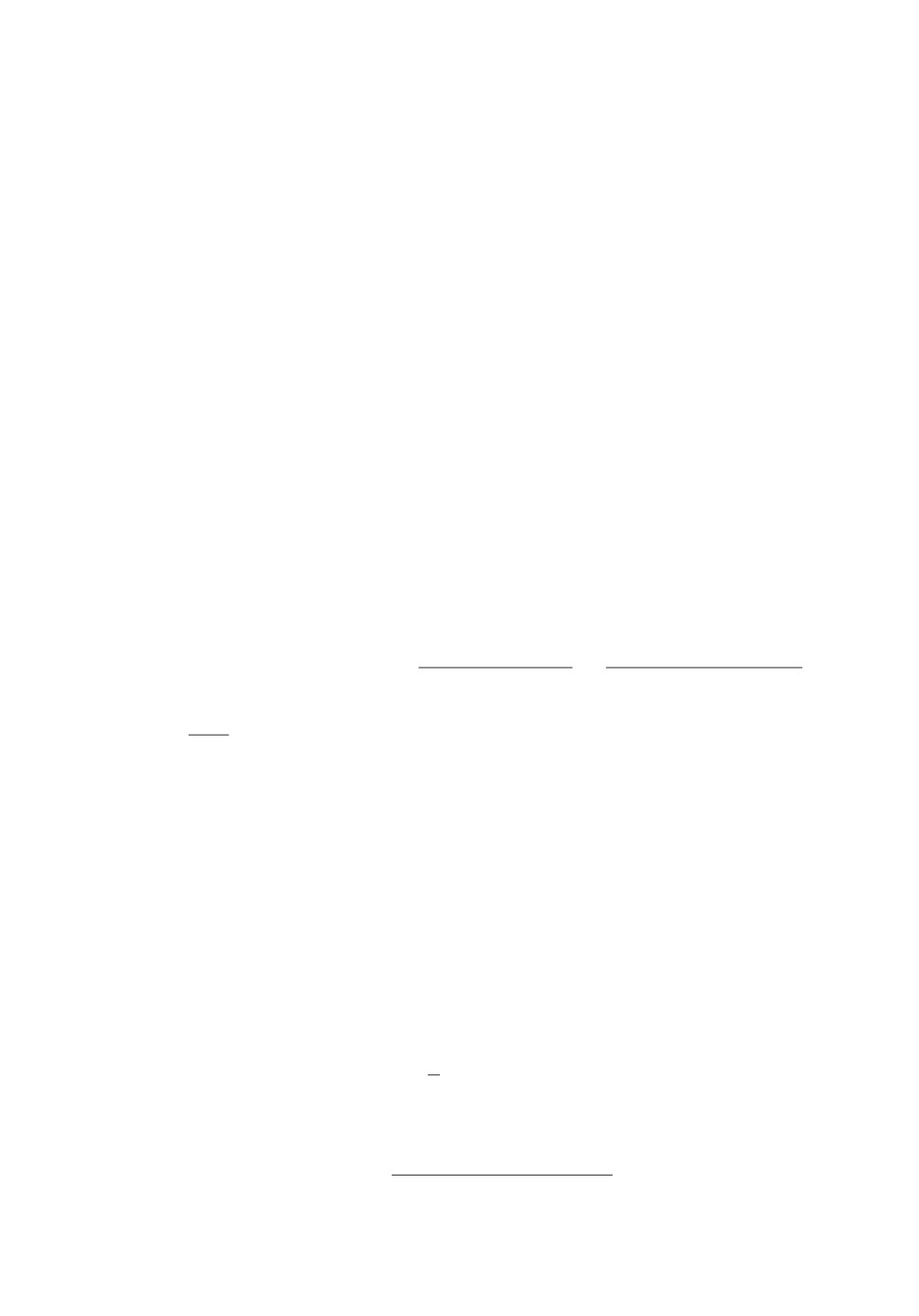

Рис. 3. Простейшая геометрия расположения носителей компонент {Δz } в уз-

лах {µz } прямоугольной сетки, покрывающей Ω. Показаны базовый носитель

Δ и Δ-окрестность произвольной точки x ∈ Ω с принадлежащими им узлами

сетки.

ком зрительных образов. Основная концепция теории заключаются в том, что

извлекаемая из изображений информация содержится не в значениях интен-

сивности, зарегистрированной отдельными рецепторами, а формируется на

основе анализа кооперативной активности рецеторов, составляющих опреде-

ленные локальные области [40, 41]. Основными доводами, согласно которым

необходимо анализировать интенсивность по областям изображения, а не по

отдельным точечным детекторам, являются, с одной стороны, необходимость

накопления стимула по группам рецепторов для формирования значимого

суммарного сигнала для выходных нейронов сетчатки, а с другой стороны,

необходимость сжатия полного потока данных от рецепторов ввиду ограни-

ченной пропускной способности зрительного канала. Подобные локальные

области, составляющие зоны ответственности отдельных выходных зритель-

ных нейронов, традиционно называют рецептивными полями. Функциональ-

ное описание рецептивных полей и способы их алгоритмического описания

можно найти в [42].

В соответствии с концепцией рецептивных полей примем, что компонен-

ты плотности совместных распределений ρz(x | νz) (10) имеют финитные,

не зависящие от параметров νz носители Δz = {x | ρz(x | νz) > 0}, располо-

женные в узлах µz некоторой воображаемой сетки, покрывающей область

изображения Ω (см. рис. 3). Предполагается, что совокупность всех носите-

⋃K

лей {Δz} составляет покрытие области изображения: Ω ⊂

Δz. Таким

z=1

123

образом, множество носителей компонент {Δz} играет роль совокупности ре-

цептивных полей.

Предположим далее для простоты, что набор компонент является одно-

родным в области Ω c точностью до расположений узлов {µz} все услов-

ные распределения {ρz (x | νz)} принадлежат одному общему параметриче-

скому семейству плотностей g = {η(ξ | ν)}, ν ∈ Ξ ⊂ Rq, так что ρz(x | νz) =

= η(x - µz | νz). В этом случае параметрическое семейство смесей (10) имеет

трансляционно-инвариантный по отношению к сетке вид

∑

(15)

ρ(x |θ) =

wzη(x - µz | νz

).

z=1

Предполагается также, что все элементы семейства g = {η(ξ | ν)} имеют

общий финитный носитель Δ, который будет в дальнейшем называться ба-

зовым носителем. Поскольку компоненты (15) являются перемещенными в

узлы сетки {µz} элементами семейства, их носители {Δz} также будут пе-

ремещенными в узлы сетки копиями базового носителя Δ. Сам же базовый

носитель, расположенный в окрестности начала координат R2, будет пред-

полагаться симметричным в том смысле, что вместе с каждой своей точкой

ξ ∈ Δ он содержит также и -ξ, в частности, содержит начало координат 0.

Характерный размер базового носителя обозначим как D. Примером сим-

метричного базового носителя является прямоугольный носитель Δ размеров

D × D на рис. 3.

Для перекрытия (носителей) соседних компонент необходимым условием

является D > d, где d шаг сетки. Это же условие необходимо для при-

нятого предположения о покрытии области Ω объединением носителей всех

компонент {Δz}. Отметим здесь, что для прямоугольной сетки в случае пря-

моугольной формы базового носителя условие D > d также и достаточно, для

√

круглой формы носителя достаточно D >

2d.

При покрытии Ω совокупностью носителей {Δz} каждая точка x ∈ Ω при-

надлежит хотя бы одному из носителей. Поэтому множество узлов сетки, но-

сители которых содержат x, не пусто. Обозначим множество индексов этих

узлов посредством δx = {z | x ∈ Δz} и назовем его сеточным окружением x.

Заметим, что в силу симметричности базового носителя Δ, в δx попадут те и

только те узлы сетки, которые содержатся в области, полученной смещением

в точку x базового носителя Δ (см. рис. 3). Поскольку в смеси (15) компо-

ненты, носители которых не содержат x, обращаются в ноль, представление

смеси с использованием сеточного окружения δx можно записать в сжатом

виде

∑

(16)

ρ(x |θ) =

wzη(x - µz | νz

),

z∈δx

где в отличие от (15) область суммирования по скрытым переменным z зави-

сит от x. При размерах сеточных окружений |δx| ≪ K в смеси (16) для каждой

124

точки x слагаемых будет намного меньше K (как формально предполагается

в (15)).

Последним предположением относительно параметрического семейства

смесей (16) является уточнение явного вида семейства g = {η(ξ | ν)}. Доста-

точно гибким и удобным с вычислительной точки зрения выбором представ-

ляется семейство экспоненциально-cкошенных распределений (family of ex-

ponentially tilted densities) [43]. Семейство экспоненциально-cкошенных рас-

пределений задается некоторой, не зависящей от параметров ν плотностью

распределения вероятностей ρ0(ξ) и ее экспоненциально-скошенными, зави-

сящими от параметров ν ∈ Ξ ⊂ R2 версиями:

(17)

η(ξ | ν) = exp{ξT ν - A(ν)}ρ0(ξ),

где T операция векторного транспонирования.

Отметим, что нормировка плотностей ρ0(ξ) и η(ξ | 0) в (17) ведет к усло-

вию A(0) = 0, или ρ0 = η(ξ | 0). Другими словами, определяющая семейство

плотность ρ0(ξ) сама является элементом семейства. Более того, как следу-

ет из (17), носитель ρ0(ξ) задает базовый носитель Δ для всего семейства.

В частности, ограниченность и симметрия Δ будут обеспечены, если ρ0(ξ),

финитная и симметричная плотность, что в дальнейшем предполагается вы-

полненным.

Функция параметров A(ν) в (17) обеспечивает нормировку плотностей

η(ξ | ν) при любых ν, что равносильно выполнению условия

∫

(18)

A(ν) = ln

exp(ξT ν)ρ0(ξ)dξ

Δ

Из (18) следует ввиду симметричности ρ0(ξ), что A(ν) также является

симметричной функцией. Далее, ввиду финитности ρ0(ξ), функция парамет-

ров A(ν) определена и аналитична на всей плоскости R2 (и даже на C2).

Из (18) также следует, что A(ν) является логарифмом двумерного преобра-

зования Лапласа от ρ0(ξ), что характеризует ее как производящую функцию

кумулянтов [44] для ρ0(ξ) (см. в этой связи Приложение (Π.9)). Впрочем,

через A(ν) достаточно просто выражается и производящая функция куму-

лянтов ψ(ν′) самого распределения η(ξ | ν) (17): ψ(ν′) = A(ν′ + ν) - A(ν),

что для первых моментовζ⃗ν и R⃗ν дает:

∫

∇ν ′ ψ(0) =∇A(ν) =ζν =

ξη(ξ | ν)dξ,

Δ

(19)

∫

∇ν ′∇ν ′ ψ(0) =∇∇T A(ν) = Rν =

(ξ -ζ⃗ν)(ξ -ζ⃗ν)T η(ξ | ν)dξ.

Δ

125

Как следует из (19), матрица Гесса∇∇T A(ν) при любых ν является корре-

ляционной матрицей Rν распределения (17), поэтому она всюду положитель-

но определена и, как следствие, всюду строго выпукла. Последнее обстоятель-

ство обеспечивает взаимную однозначность отображения ν →ζ⃗ν =∇A(ν).

Ввиду этой взаимной однозначности можно вместо параметров ν, называе-

мых в контексте экспоненциальных семейств натуральными (или канониче-

скими) [44], пользоваться параметрами среднихζ. Заметим, что в соответ-

ствии ν ↔ζ в силу симметрии A(ν) ноль отображается в ноль.

Переход к параметрам средних в (17) тесно связан с преобразованием Ле-

жандра [43] функции A(ν) (18):

(

)

(20)

A∗(ζ) = max

ζ Tν - A(ν)

ν∈Ξ

Максимум в (20) достигается на решении уравнения∇A(ν⃗ζ) =ζ, а его ве-

личина A∗(ζ) равна значению выраженияζT ν⃗

- A(ν⃗). Отметим, что для

ζ

ζ

симметричной A(ν) ее дуальная по Лежандру функция A∗(ζ) также симмет-

рична.

Если переобозначить в (20)ζ →ξ, можно с учетом явного вида дуальной

по Лежандру функции A∗(ζ) преобразовать показатель экспоненты в (17)

следующим образом:

ξTν - A(ν) = ξT(ν - ν⃗) - A(ν) + A(ν⃗) + A∗(ξ) =

ξ

ξ

(21)

= -BA(ν,ν⃗) + A∗(ξ),

ξ

где введена связанная с A(ν) дивергенция Брегмана (Bregman divergence) [45]:

(22)

BA(ν,ν′) = A(ν) - A(ν′) -∇T A(ν′)(ν - ν′

).

Аналогично дивергенции BA(. . .) (22) можно ввести дивергенцию Брегма-

на BA∗ (. . .), связанную с дуальной функцией A∗(ζ) (20). Оказывается, что

обе эти дивергенции также связаны соотношением дуальности BA(ν, ν′) =

= BA∗(ζ′,ζ), где предполагаетсяζ = ∇ A(ν), ζ′ = ∇ A(ν ′) [45]. Поэтому, на

основе (21), (22) семейство скошенных распределений (17) можно переписать

в параметрах средних в виде

(23)

η(ξ |ζ) = η(ξ | ν⃗) = exp{-BA∗(ξ,ζ)}exp{A∗(ξ)}ρ0(ξ).

ζ

Отметим, что хотя форма (23) распределений семейства не столь явно

как (17) выражает деформацию симметричной плотности ρ0(ξ), она также

содержит некоторую трактовку cкошенных распределений, ввиду следующей

из (19) интерпретацииζ как среднего отξ. Именно форма (23) представляет

плотности семейства как произведение факторов exp{-BA∗ (ξ,ζ)} купо-

ла-подобной функции, достигающей максимума вξ =ζ и exp{A∗(ξ)}ρ0(ξ)

126

симметричной функции, имеющей максимум в нуле. Эту трактовку можно

подчеркнуть еще больше, если воспользоваться приближенным выражени-

ем (Π.15) из Приложения для фактора exp{A∗(ξ)}ρ0(ξ) ≃ 1/2πD2, где D

стандартное отклонение для плотности ρ0(ξ), которое также можно интер-

претировать как характерный размер базового носителя Δ:

1

(24)

η(ξ |ζ) =

exp{-BA∗ (ξ,ζ)}.

2πD2

Приближенная форма (24) в еще большей степени подчеркивает интер-

претацию η(ξ |ζ) в параметрах средних как смещенное в точкуζ симметрич-

ное распределение ρ0(ξ). Отметим, что для (не финитных) симметричных

гауссовых плотностей, для которых Rν = R0 = D2E, форма (24) оказывается

точной.

Возвращаясь к системе уравнений максимального правдоподобия (14), вы-

разим входящие в эти уравнения градиенты логарифмических функций прав-

(

)

(

)

доподобия ln

ρz(x | νz)

= ln

η(x - µz | νz

через средние параметрыζz со-

гласно (23) и воспользуемся тем обстоятельством, чтоζz =∇A(νz ) и, следо-

вательно, ∥∇νz ζTz ∥ =∇∇T A(νz)

(

)

η(x - µz | νz

=∥∇νzζTz∥∇⃗

{-BA∗(x - µz,ζz)} =

∇νz ln

ζz

(25)

= -∇ ∇ TA(νz)∇ ⃗

BA∗(x - µz,ζz) = x - µz -ζz.

ζz

где учтено, что согласно (22)∇⃗BA∗(ξ,ζ) = -∇∇T A∗(ζ)(ξ -ζ) и матрицы

ζ

∇∇T A∗(ζ) и∇∇T A(ν) взаимнообратны. Отметим, что получившееся в ре-

зультате простое выражение в правой части (25) является главным аргумен-

том перехода к параметрам средних. Однако здесь следует сделать важное

замечание. На самом деле соотношения (25) выполняются не для всех x,

а только для тех, которые принадлежат носителю Δz данной компоненты.

Для прочих x целесообразно положить градиенты (25) равными нулю.

Подставляя (25) в (14), окончательно получим систему уравнений мак-

симального правдоподобия для нахождения оптимальных параметровθ∗ =

= {{w∗z}, {ν∗z}} ∈ Θ

z = 1,...,K,

∑

1

w∗z =

ρ(z | xj ,θ∗),

k

xj∈Δz

(26)

∑

)

(xj - µz)ρ(z | xj,θ∗

xj∈Δz

ζ∗

=

∑

,

z

ρ(z | xj,θ∗)

xj∈Δz

127

где при суммировании по отсчетам xj учтено, что плотность ρ(z | xj,θ∗) ∼

∼ ρ(xj, z | θ∗) отлична от нуля только в Δz.

Система уравнений (26) является относительно простой нелинейной си-

стемой, выражающей искомое решениеθ∗ через функцию от него же и от

отсчетов выборки (выборочного представления) Xk = {xj }:

(27)

θ∗ = H(θ∗, Xk

).

Простейшим методом решения уравнений вида (27) является метод по-

следовательных приближений (successive approximations) [46], который по

ν-приближениюθ(ν) итеративно находит следующее приближениеθ(ν+1) =

= H(θ(ν),Xk). Существует много методов численного решения подобных

уравнений [47]. Особенности каждого из этих методов определяются особен-

ностями итерирующей функции H(. . .).

В случае системы (26) особенностью функции H(θ, Xk) является то, что

она зависит отθ только через плотности апостериорных распределений

ρ(z | x,θ). Поэтому естественно разбить вычисления каждой итерации на два

шага: на первом вычислить все апостериорные распределения:

I

j = 1,...,k, z ∈ δxj

(

)

(

)

(

) wνzρz

xj |θ(ν)

wνzη

xj - µz | ζzν)

ρ(ν+1)j(z) = ρ z | xj,θ(ν)

=

=

=

P(ν)j

P(ν)

j

{

(

)}

wνz

=

exp

-BA∗

xj - µz,ζ(ν)

exp {A∗(xj - µz)} ρ0 (xj - µz) ,

(ν)

z

(28)

P

j

(

)

∑

(

)

P(ν)j = ρ

xj

|θ(ν)

= wνiη xj -µi | ζ(ν)

=

i

i∈δxj

∑

{

(

)}

= wνi exp

-BA∗

xj - µi,ζ(ν)

exp {A∗(xj - µi)} ρ0 (xj - µi) ,

i

i∈δxj

а уже на втором шаге пересчитать текущее приближение

II

z = 1,...,K

∑

1

w(ν+1)z =

ρ(ν+1)j(z),

k

xj∈Δz

(29)

∑

(z)

(xj - µz)ρ(ν+1)j

xj∈Δz

ζ(ν+1)

z

=

∑

ρ(ν+1)j(z)

xj∈Δz

128

Двухшаговая итеративная вычислительная схема I (28) и II (29) соответ-

ствует шагам E и M известного EM-алгоритма для смесей распределений

экспоненциального семейства [48]. Известно, что EM-алгоритм, когда число

компонент K относительно невелико (∼ 10-100) вполне стабилен и позволяет

в обозримое время находить максимально-правдоподобные оценкиθ∗. К со-

жалению, при больших объемах данных k и больших размерах моделей K,

например, для стандартных цифровых изображений, применение традици-

онного EM-алгоритма оказывается проблематичным. Проблемы эти связаны

с высокими требованиями к объему памяти k × K и соответственно с боль-

шим объемом вычислений, а также с низкой скоростью сходимости (линей-

ной) EM-алгоритма [21]. В предложенной нами модели рецептивных полей,

ввиду уменьшения требуемого объема памяти до k × |δ|, где |δ| ≪ K сред-

нее число узлов в решеточных окружениях отсчетов, и сокращения объема

вычислений ввиду ограниченного суммирования по компонентам в (28) и от-

счетам в (29), требования к ресурсам гораздо меньше, чем для EM-алгоритма

в общей версии, особенно при большом числе K компонент.

Вместе с тем, несмотря на очевидную экономию ресурсов, при очень боль-

ших K ∼ 104-106, представляющих интерес для реальных изображений, объ-

ем вычислений в предложенной схеме может оказаться по-прежнему высо-

ким. В этом случае можно несколько снизить объем памяти и вычислений,

если воспользоваться аппроксимацией (24). Используя ее, вычисления на ша-

ге I (28) можно организовать следующим образом:

I

j = 1,...,k, z ∈ δxj

{

}

wνz exp

-BA∗(xj - µz,

z

)

ρ(ν+1)(z) =

{

(

)} =

(30)

j

∑

wνi exp

-BA∗

xj - µi,ζ(ν)

i

i∈δxj

({

(

)

})

= softmaxz ln(wνi ) - BA∗

xj - µi,ζ(ν)

|i∈δxj

,

i

где softmaxz

z-компонента softmax-функции [49]. Вместе с шагом II (29)

шаг I (30) почти совпадает со схемой мягкой брегмановской кластеризации

(Bregman Soft Clustering), обсуждавшейся в [23]. Отличие состоит лишь в том,

что в I (30) для расчета апостериорных плотностей ρ(ν+1)j(z) используются

брегмановские дивергенции между локальными по отношению к компонен-

те z координатами отсчетов xj - µz и локальными же координатами центрои-

да

z

тех отсчетов xj, которые принадлежат носителю Δz этой компоненты

∑

(z)

xjρ(ν)j

xj∈Δz

ζ(ν)

(31)

=

-µz.

z

∑

ρ(ν)j(z)

xj∈Δz

129

В схеме же мягкой брегмановской кластеризации [23] используются брег-

мановские дивергенции BA∗ (x,Mz) между собственно координатами отсче-

тов x и их несмещенными центроидами

Mz =

z

+ µz. Поскольку в об-

щем случае дивергенция Брегмана не является трансляционно-инвариантной

функцией: BA∗ (xj - µz,

z

)=BA∗(xj,

z

+ µz), обсуждаемые схемы вы-

числений не тождественны. Они совпадают только в одном частном случае

квадратичных по разности аргументов дивергенций Брегмана, соответству-

ющих случаю гауссовских компонент. Таким образом, предложенная схема

вычисления максимально-правдоподобных оценок параметровθ∗ отличается

свойством локальности обучения в отличие от известных процедур мягкой

брегмановской кластеризации [23].

Оказывается, можно еще более сэкономить вычислительные ресурсы, если

воспользоваться “жестким” приближением значений softmax функции в (30),

аппроксимировав нулями все ее z-компоненты кроме максимальной, для ко-

торой выбирается значение 1. При этом шаг I (30) сведется к задаче макси-

мизации:

I

j = 1,...,k, z ∈ δxj

{

(

)}

i∗ = arg max ln(wνi) - BA∗

xj - µi,ζ(ν)

,

i

(32)

i∈δxj

ρ(ν+1)j(z) = δi∗z.

Жесткая аппроксимация ρ(ν+1)j(z) (32) приводит к однозначной ассоциа-

ции отсчетов xj c узлами сетки µi∗ , или, что эквивалентно, разбиению отсче-

{

тов выборки Xk = (x1, . . . , xk) на K непересекающихся подгрупп

X(ν+1) =k

z

(

)}

=

xj1,... ,xjkz

, где kz

число отсчетов xj объединенных в группу X(ν+1)k

z

согласно ассоциации ρ(ν+1)j(z) = 1 (некоторые из X(ν+1) могут быть пустыми).k

z

В терминах результирующего разбиения вычисления на шаге II (29) также

упрощаются и принимают вид

II

z = 1,...,K

kz

w(ν+1)z =

,

(33)

k

∑

1

ζ(ν+1)

=

(xj - µz).

z

kz

xj∈X(ν+1)

kz

Интересно в этой связи отметить, что если исключить веса {wz} из числа

параметровθ, предписав им равномерное распределение wz = 1/K, то схема

130

жестких вычислений I (32)-II (33) принимает форму:

I

j = 1,...,k, z ∈ δxj :

{ (

)}

z = arg min BA∗

xj - µi,ζ(ν)

,

i

i∈δxj

⋃

kz = kz + 1, X(ν+1)k

=X(ν+1)k

xj,

z

z

(34)

II

z = 1,...,K :

∑

1

ζ (ν+1)

=

xj - µz,

z

kz

xj∈X(ν+1)

kz

kz = 0, X(ν+2) = ∅.k

z

Схема (34) практически совпадает (с точностью до нюансов, обсужденных

выше) с алгоритмом жесткой Брегмановской кластеризации (Bregman Hard

Clustering) [23]. Интересно отметить, что там же приводится замечание о том,

что при конкретных выборах дивергенции Брегмана BA∗ (ξ,ζ) получаются по-

пулярные методы кластеризации. Именно, классический алгоритм K-средних

(K-means), алгоритм LBG [24] и алгоритм теоретико-информационной кла-

стеризации [50] являются частными случаями жесткой кластеризации, когда

BA∗(ξ,ζ) имеет вид квадрата евклидова расстояния, расстояния Итакуры-

Сайто или дивергенции Кульбака-Лейблера [39].

С целью продемонстрировать возможности кодирования и восстановления

предложенными в работе генеративными автокодировщиками заданных вы-

борочными представлениями изображений, был использован пример простых

рецептивных полей гауссовского типа [42] (см. (24)):

{

}

{

}

1

η(ξ |ζ) =

exp

-(ξ -ζ)2/2D2

= exp

ξTν - A(ν) ρ0(ξ),

2πD2

(35)

{

}

1

ρ0(ξ) =

exp

-ξ2/2D2

, A(ν) = D2ν2/2,

ζ= D2ν.

2πD2

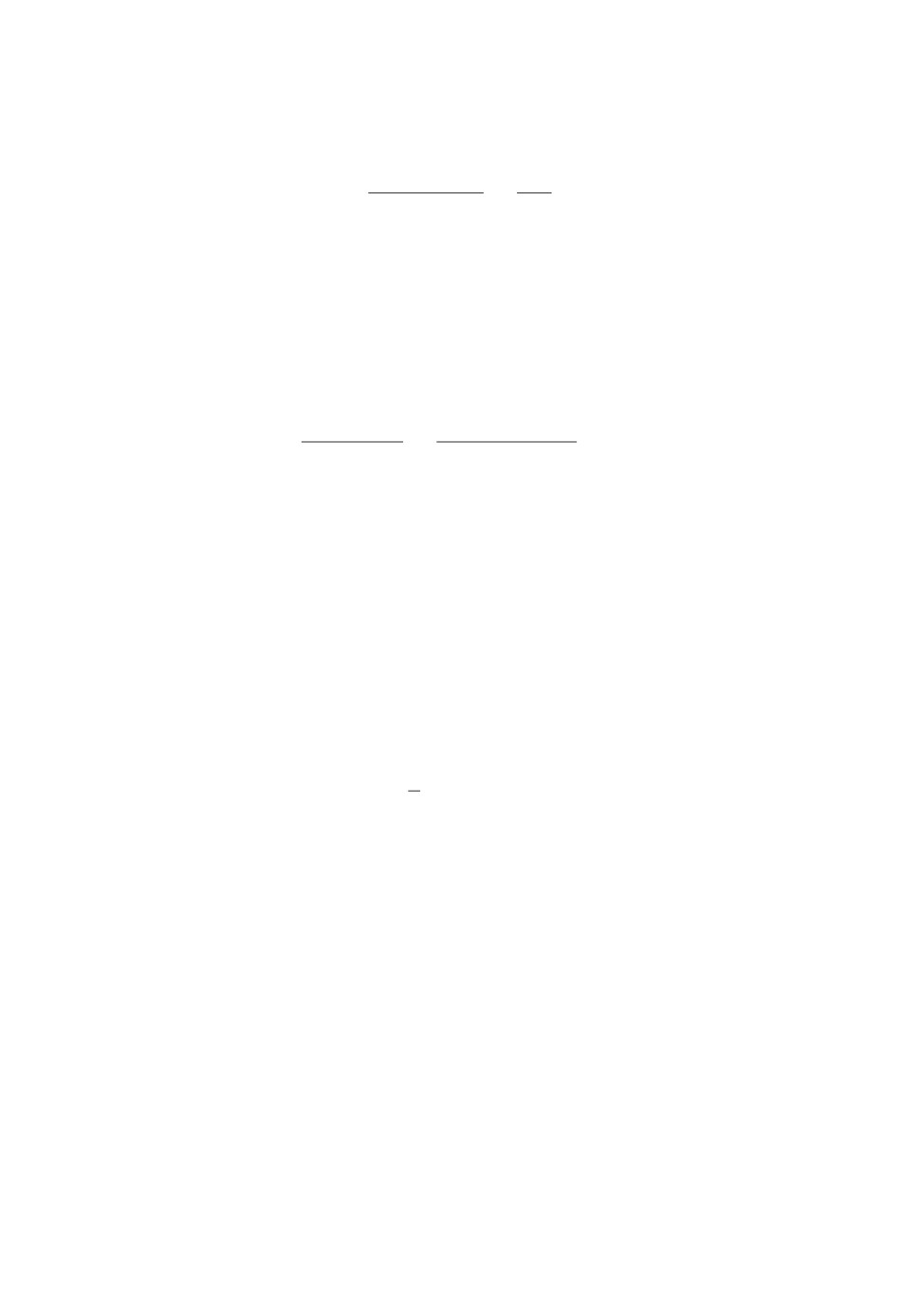

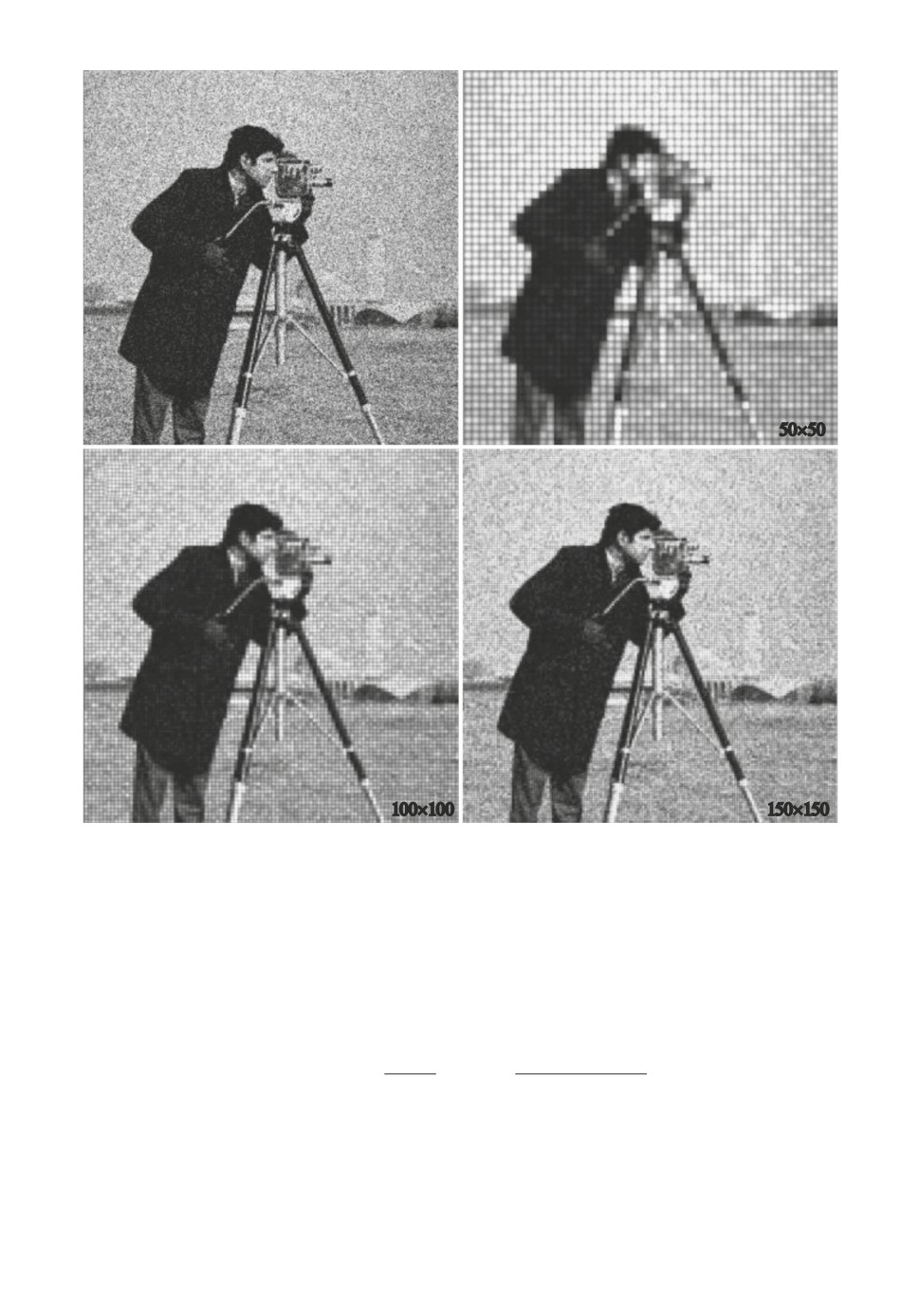

На рис. 4 приведены результаты кодирования-восстановления изображе-

ния “Cameraman”, содержащего 1 000 000 отсчетов (рис. 2). Кодирование осу-

ществлялось по схеме жесткой аппроксимации вычислений I (32) II (33)

с разбиением выборочного представления Xk = (x1, . . . , xk) на K = l × l непе-{

}

ресекающихся сеточных кластеров X(ν)

⊂ Δz , соответствующих узлам

kz

прямоугольной сетки, размерами l узлов по вертикали и l узлов по гори-

зонтали изображения Ω (рис. 3). Число итераций схемы полагалось равным{

{

}}

∗

νmax = 10. По вычисленным в результате параметрамθ∗ =

{w∗z},

ζ

z

вос-

становление плотности распределения вероятностей отсчета x ∈ Ω (совпадаю-

щей с нормированной интенсивностью I(x) излучения на Ω в данном случае

131

a

б

50´50

в

г

100´100

150´150

Рис. 4. Результаты кодирования-восстановления выборочного представле-

ния изображения “Cameraman”: a

выборочное представление размером

1 000000 отсчетов как на рис. 2; б, в, г восстановленные изображения, соот-

ветствующие сеткам в 50×50, 100×100 и 150×150 узлов.

с нормированной битмап-картой исходного изображения “Cameraman”, см.

рис. 2), осуществлялось в соответствии с (16), (24)

{

}

∑

w∗i

(x - µi

ζ∗z)2

(36)

ρ(x,θ∗) =

exp

-

2πD2

2D2

i∈δx

6. Заключение

Предложенная в работе концепция автокодировщиков, предназначенных

для автоматической генерации сжатых изображений, оказалась содержатель-

132

ной в отношении открывающихся с еe помощью новых возможностей по син-

тезу реальных алгоритмов кодирования-восстановления изображений. Разра-

ботанное для этих целей специальное представление изображений с помощью

выборок отсчетов (выборочных представлений) позволяет, с одной стороны,

избежать связанных с идеальными изображениями проблем вычислительных

ресурсов, а с другой стороны, открывает широкие возможности по адаптации

методов машинного обучения к задачам, подобным рассмотренным в работе.

Основываясь на специфике выборочных представлений, удалось сформу-

лировать генеративную (порождающую) модель автокодировщиков, которая

почти автоматически выводит на такие разделы машинного обучения, как на-

ивный байесов подход, методы максимального правдоподобия, итеративные

алгоритмы типа EM-алгоритма поиска оценок максимально-правдоподобных

оценок для смесей, алгоритмы кластеризации типа K-means, LBG алгоритмы

векторного квантования и т.д. В этой связи в работе представлено несколько

различающихся по сложности примеров итеративных алгоритмических схем

кодирования-восстановления изображений.

Особенностью предложенных схем является активно используемая в них

концепция рецептивных полей. Она позволяет эффективно обходить извест-

ные трудности итеративных алгоритмов, обрабатывающих смеси с большим

числом компонент, например порядка 104-106, что по порядку соответствует

числу рецептивных полей в сетчатке глаза. Апелляция к зрительному вос-

приятию здесь не случайна, поскольку, как подчеркнуто в работе, качеству

восприятия изображений и адаптации механизмов зрительного восприятия

человека к задачам цифровой обработке изображений сегодня уделяется по-

вышенное внимание.

В связи с изложенным выше отметим, что практически все приведенные

в работе алгоритмы были численно апробированы, проведенные эксперимен-

ты подтвердили их эффективность по отношению к памяти и времени вы-

числения. К примеру, выбранные для иллюстрации отсчетные изображения

“Cameraman” (см. рис. 2) потребовали на вычисление восстановленных изоб-

ражений времени менее секунды даже в случае наиболее плотной сетки в

150 × 150 узлов (22 500 компонент).

В целом, основываясь на полученных результатах, хотелось бы выразить

надежду, что предложенные в работе подходы найдут в ближайшее время

как дальнейшее теоретическое развитие, так и плодотворное использование

в прикладных задачах.

ПРИЛОЖЕНИЕ

Асимптотический вид апостериорного распределения параметров

для выборки k независимых, одинаково распределенных (iid) отсчетов

Пусть дана выборка из k независимых одинаково распределенных (iid) слу-

чайных отсчетов Xk = (x1, . . . , xk), плотность распределения вероятностей

133

каждого из ко

{

}

семейства G = ρ(x |θ)

, x ∈ Ω, θ ∈ Θ ⊂ Rp. Пусть существует точка θML ∈

∈ Θ, в которой имеет место максимум по θ логарифма функции правдоподо-

бия совместной плотности распределения отсчетов Xk

∇⃗L(θML;Xk) = 0,

θ

(Π.1)

(

)

∏

L(θ; Xk) = ln

ρ(Xk |θ)

= ln ρ(xj | θ) .

j=1

Запишем в окрестностиθML тейлоровское разложение логарифма функ-

ции правдоподобия (Π.1):

(

)

∂2L(θML;Xk)

(Π.2)

L(θ;Xk) = L(θML;Xk)+1(θ-θML)T

(θ-θML

)+

2

∂θp∂θq

На основании (Π.1) для матрицы вторых частных производных в (Π.2)

можно записать следующее представление

(

)

∑

∂2L(θML;Xk)

∂2 ln ρ(xj |θML)

(Π.3)

.

∂θp∂θq

k

∂θp∂θq

j=1

Рассматривая вторые производные ∂2 ln ρ(xj |θML)/∂θp∂θq в (Π.3) как слу-

чайные величины функции от случайных xj, можно асимптотически при

k ≫ 1 заменить выборочное среднее в правой части (Π.3) соответствующим

средним по распределению ρ(x |θ)

∫

∑

1

∂2 lnρ(xj |θML)

(Π.4)

≃ ρ(x |θ)∂2 lnρ(x|θML)

dx.

k

∂θp∂θq

∂θp∂θq

j=1

Если учесть асимптотическую несмещенностьθML ∼θ, то нетрудно заме-

тить, что правая часть (Π.4) представляет собой с точностью до знака инфор-

мационную матрицу Фишера ℑ(θ) распределения ρ(x |θ). Подставляя (Π.4)

в (Π.3), а затем в (Π.2), получаем следующую форму разложения логариф-

мической функции правдоподобия

(Π.5)

L(θ; Xk) ≃ L(θML; Xk) -k(θ -θML)T ℑ(θ)(θ -θML

).

2

Экспонирование (Π.5) дает асимптотику самой функции правдоподобия

{

}

k

(Π.6)

ρ(Xk |θ) ≃ ρ(Xk |θML) exp

-

(θ -θML)T ℑ(θ)(θ -θML)

2

134

Отθ в правой части (Π.6) зависит только экспоненциальный сомножи-

тель, посколькуθML в первом сомножителе является функцией от Xk =

= (x1, . . . , xk) и отθ не зависит. Следовательно, поведение ρ(Xk | θ) в за-

висимости отθ определяется только квадратичной формой в экспоненте с

большим коэффициентом k ≫ 1. Отсюда асимптотически ρ(Xk |θ) имеет ост-

рый пик в точкеθML, что может быть использовано для вычисления других

распределений. Например, предполагая некоторое априорное распределение

параметров P (θ), более широкое, чем ρ(Xk |θ), можно последовательно найти

∫

ρ(Xk) = ρ(Xk |θ)P (θ)dθ ≈ ρ(Xk |θML)C(θML)P (θML),

Θ

(Π.7)

∫

{

}

k

C(θML) = exp

-

(θ -θML)T ℑ(θ)(θ -θML) dθ,

2

Θ

а затем

ρ(θ | Xk) =ρ(Xk |θ)P(θ)

≈

ρ(Xk)

{

}

1

P(θ)

k

(Π.8)

≈

exp

-

(θ -θML)T ℑ(θ)(θ -θML)

≈

2

C(θML) P(θML)

{

}

1

k

≈

exp

-

(θ -θML)T ℑ(θ)(θ -θML)

,

C(θML)

2

что представляет собой узкое, гауссова типа распределение, стремящееся к

δ(θ -θML)-функции Дирака при k → ∞.

Приближение седловой точки для аппроксимации плотности

распределения вероятностей случайной векторной величины

Приближение седловой точки является хорошо известным инструментом в

статистике и достаточно широко используется при асимптотической аппрок-

симации поведения выборочного среднего большого числа k независимых,

одинаково распределенных случайных величин [51]. Для анализа распреде-

лений отдельных случайных величин данное приближение используется су-

щественно реже [43]. Ниже, с целью адаптации к рассматриваемым задачам

метода седловой точки в случае одной (векторной) случайной величины, при-

водятся основные шаги обоснования этого приближения.

Пусть случайный векторξ задан на некоторой области Δ ⊂ R2, являю-

щейся носителем плотности распределения вероятностей ρ0(ξ). Для простоты

будем пол{гать плотно}ь симметричной, финитной функцией, так что носи-

тель Δ =

ξ | ρ0(ξ) > 0 является открытым, ограниченным, симметричным

относительно начала координат множеством в R2. В этом случае для любых

135

(в том числе комплексных) векторов ν ∈ C2 существует двумерное преобра-

зование Лапласа плотности ρ0(ξ) [52], которое может быть представлено в

виде

∫

∫

(Π.9)

F (ν) = exp(-ξT ν)ρ0(ξ)dξ = exp(ξT ν)ρ0(ξ)dξ,

Δ

Δ

где использован тот факт, что для симметричных ρ0(ξ) и Δ преобразование

Лапласа F (ν) также симметрично.

Плотность ρ0(ξ) в свою очередь может быть выражена с помощью обрат-

ного преобразования Лапласа [52] от F (ν) (Π.9)

∫

∫

1

ρ0(ξ) =

exp(ξT ν)F (ν)dν =

(2πi)2

-i∞ -i∞

(Π.10)

∫

∫

1

=

exp(A(ν) -ξT ν)dν,

(2πi)2

-i∞ -i∞

гдеi

мнимая единица, A(ν) = ln F (ν) производящая функция кумулян-

тов. В (Π.10) также использован факт симметричности ρ0(ξ).

Интеграл в (Π.10) можно приближенно найти с помощью метода седловой

точки, если деформировать путь интегрирования так, чтобы он прошел через

(седловую) точку ν⃗

, обращающую градиент (A(ν)-ξT ν) в ноль: ∇A(ν⃗) = ξ.

ξ

ξ

При этом, разлагая показатель экспоненты в (Π.10) с точностью до членов

второго порядка по (ν - ν⃗), можно получить следующий приближенный ре-

ξ

зультат:

∫

∫

}

exp(A(ν⃗)-ξTν⃗)

[

]

ξ

ξ

{1

ρ0(ξ)≈

exp

(ν - ν⃗)T

∇∇TA(ν⃗)

(ν - ν⃗) dν =

ξ

ξ

ξ

(2πi)2

2

−i∞ -i∞

∫

∞

∫

∞

{

}

[

]

exp(A(ν⃗ξ) -ξT ν⃗ξ)

1

=

exp

-

(η +iν⃗)T

∇∇TA(ν⃗)

(η +iν⃗) dη =

ξ

ξ

ξ

(2π)2

2

−∞ -∞

{

}

(Π.11)

exp A(ν⃗ξ) -ξTν⃗ξ

=

√

,

2π det ∇∇T A(ν⃗)

ξ

где переход к гауссовому интегралу осуществлен в результате замены пере-

менных интегрирования ν =iη.

136

Учитывая, что выражение в числителе (Π.11) с точностью до знака сов-

падает со значением сопряженной по Лежандру к A(ν) функции A∗(ξ) [43]

(Π.12)

A∗(ξ) =ξT ν⃗ξ - A(ν⃗ξ),

∇A(ν⃗ξ) =ξ,

и тот факт, что A(ν) и A∗(ξ) имеют взаимно обратные матрицы Гесса:

∇∇T A∗(ξ) = [∇∇T A(ν⃗)]-1 получим приближение седловой точки для плот-

ξ

ности ρ0(ξ) [43]

√

{

}

det ∇∇T A∗(ξ)

(Π.13)

ρ0(ξ) ≈

exp

-A∗(ξ)

2π

Соотношение (Π.13) можно переписать в эквивалентном виде

{

}

√

1

(Π.14)

ρ0(ξ)exp A∗(ξ) ≈

det ∇∇T A∗(ξ),

2π

который позволяет записать приближенное выражение для левой части через

квадратный корень из определителя матрицы Гесса ∇∇T A∗(ξ).

Дальнейшее приближение может быть получено, если вспомнить, что

A(ν) является производящей функцией кумулянтов для ρ0(ξ). Это значит,

что ∇∇T A(0) = R0 корреляционная функция ρ0(ξ), определитель кото-

[

]-1

рой приближенно равен кварату площади Δ. Тем самым det ∇∇T A∗(0)

=

= det∇∇T A(0) = detR0 ≈ |Δ|2 ≈ D4, где D характерный размер Δ. Пола-

гая det ∇∇T A∗(ξ) ≈ det ∇∇T A∗(0) ≈ D-4, можно приблизить правую часть

(Π.14) следующим выражением:

{

}

1

(Π.15)

ρ0(ξ)exp A∗(ξ) ≈

2πD2

СПИСОК ЛИТЕРАТУРЫ

1. Ezhilraman V., Srinivasan S. State of the art in image processing & big data ana-

lytics: issues and challenges // International J. of Engineering & Technology. 2018.

2. Bull D.R., Zhang F. Intelligent image and video compression: communicating pic-

tures. 2nd ed. London: Academic Press, 2021.

3. Zeyu Y., Fei W., Rendong Y., et al. On Perceptual Lossy Compression: The Cost

of Perceptual Reconstruction and An Optimal Training Framework // Proc. of the

38-th International Conference on Machine Learn., PMLR. 2021.

4. Shannon C.E. Coding Theorems for a Discrete Source with a Fidelity Criterion -

Institute of Radio Engineers, International Convention Record. V. 7, 1959 // in

C.E. Shannon: Collected Papers. 1993. P. 325-350.

137

5.

Tschannen M., Agustsson E., Lucic M. Deep Generative Models for Distribution-

Preserving Lossy Compression // Proc. of the 32nd International Conference on

Neural Inform. Processing Systems (NIPS). 2018. P. 5933-5944.

6.

Blau Y., Michaeli T. Rethinking Lossy Compression: The Rate-Distortion-

Perception Tradeoff // Proc. of the 36th International Conference on Machine

Learn., PMLR. 2019. V. 97. P. 675-685.

7.

Matsumoto R. Introducing the perception-distortion tradeoff into the rate-distortion

theory of general information sources // IEICE Commun. Express.

2018. V. 7.

8.

Wang Z., Bovik A., Sheikh H., Simoncelli E. Image quality assessment: from error

visibility to structural similarity // IEEE Trans. Image Process. 2004. V. 13. No. 4.

9.

Wang Z., Bovik A. Video quality assessment based on structural distortion mea-

surement // Signal processing. Image commun. 2004. V. 19. No. 2. P. 121-132.

10.

Sheikh H., Bovik A., de Veciana G. An information fidelity criterion for image quality

assessment using natural scene statistics // IEEE Trans. on image processing. 2005.

11.

Larson E.C., Chandler D.M. Most apparent distortion: full-reference image quality

assessment and the role of strategy // J. Electron. Imaging. 2010. V. 19. No. 1.

12.

Bishop C.M., Lasserre J. Generative or Discriminative? Getting the Best of Both

Worlds // Bayes. Statist. 2007. V. 8. P. 3-24.

13.

Goodfellow I., Pouget-Abadie J., Mirza M., et al. Generative Adversarial Net-

works // Commun. ACM. 2020. V. 63. No. 11. P. 139-144.

14.

Kingma D.P., Welling M. Auto-Encoding Variational Bayes // arXiv:1312.6114.

arxiv.org. 2013.

15.

Hinton G.E., Osindero S., The Y.-W. A Fast-Learning Algorithm for Deep Belief

Nets // Neural Computation. 2006. V. 18. No. 7. P. 1527-1554.

16.

Hassabis D., Kumaran D., Summerfield C., Botvinick M. Neuroscience-Inspired

Artificial Intelligence // Neuron. 2017. V. 95. No. 2. P. 245-258.

17.

Antsiperov V.E. Representation of Images by the Optimal Lattice Partitions of

Random Counts // Patt. Recogn. and Image Anal. 2021. V. 31. No. 3. P. 381-393.

18.

Antsiperov V.E., Kershner V.A. Image Coding by Count Sample, Motivated by the

Mechanisms of Light Perception in the Visual System // Commun. Comput. Inform.

19.

Scott D.W. Multivariate Density Estimation. Hoboken: John Wiley & Sons, Inc.

20.

Rufo M.J., Martin J., Perez C.J. Bayesian analysis of finite mixture models of dis-

tributions from exponential families // Comput. Statist.

2006. V. 21. No. 3-4.

138

21.

McLachlan G.J., Krishnan T. The EM Algorithm and Extensions. 2nd ed. Hoboken:

John Wiley & Sons, Inc. 2007.

22.

Tzikas D., Likas A., Galatsanos N. The variational approximation for Bayesian in-

ference // IEEE Signal Proc. Magazine. 2008. V. 25. No. 6. P. 131-146.

23.

Banerjee A., Merugu S., Dhillon I.S., Ghosh J. Clustering with Bregman Diver-

gences // J. Machine Learn. Res. 2005. V. 6. P. 1705-1749.

24.

Linde Y., Buzo A., Gray R.M. An algorithm for vector quantizer design // IEEE

Trans. Commun. 1980. V. 28. No. 1. P. 84-95.

25.

Lloyd S. Least squares quantization in PCM // IEEE Trans Inform. Theory. 1982.

26.

Kohonen T. Self-Organized Formation of Topologically Correct Feature Maps // Bi-

27.

Barrett H.H., Myers K.J. Foundations of image science. Hoboken: John Wiley &

Sons, Inc. 2004.

28.

Fossum E. The Invention of CMOS Image Sensors: A Camera in Every Pocket //

2020 Pan Pacific Microelectronics Symposium (Pan Pacific). 2020. P. 1-6.

29.

Gabriel C.G., Perrinet L., Keil M. Biologically Inspired Computer Vision: Funda-

mentals and Applications. Weinheim: Wiley-VCH. 2015.

30.

Fox M. Quantum Optics: An Introduction. Oxford, New York: Oxford University

Press, 2006.

31.

Streit R.L. Poisson Point Processes. Imaging, Tracking and Sensing. New York:

Springer. 2010.

32.

Bertero M., Boccacci P., Desidera G., Vicidomini G. Image deblurring with Poisson

data: from cells to galaxies // Inverse Problems. 2009. V. 25. No. 12. P. 123006.

33.

Robert C.P., Casella G. Monte Carlo Statistical Methods.

2nd ed. New York:

34.

Hinton G.E., Zemel R.S. Autoencoders, minimum description length and Helmholtz

free energy // Proc. of the 6th International Conference on Neural Inform. Process-

ing Systems (NIPS’93). 1993. P. 3-10.

35.

Goodfellow I., Bengio Y., Courville A. Autoencoders // Deep Learning. MIT Press.

2016.

36.

Baldi P. Autoencoders, unsupervised learning and deep architectures // JMLR:

Workshop and Conference Proceedings. 2012. V. 27. P. 37-49.

37.

Alain G., Bengio Y., Yao L., et.al. GSNs: Generative Stochastic Networks //

arXiv:1503.05571. arXiv.org. 2015.

38.

Aldrich J. R.A. Fisher and the Making of Maximum Likelihood 1912-1922 // Sta-

tistical Science. 1997. V. 12. No. 3. P. 162-176.

39.

Van Erven T.T., Harremoes P. Renyi Divergence and Kullback-Leibler Divergence //

IEEE Trans. on Inform. Theory. 2014. V. 60. No. 7. P. 3797-3820.

139

40.

Schiller P.H., Tehovnik E.J. Vision and the Visual System // Oxford: Oxford Uni-

41.