Автоматика и телемеханика, № 8, 2022

Стохастические системы

© 2022 г. А.С. АРХИПОВ (ege3145@yandex.ru),

К.В. СЕМЕНИХИН, д-р физ.-мат. наук (siemenkv@rambler.ru)

(Московский авиационный институт)

МНОГОМЕРНАЯ ЧЕБЫШЕВСКАЯ ГРАНИЦА

ТИПА СЕЛБЕРГА

Определена точная верхняя грань вероятности того, что случайный

вектор с заданными математическим ожиданием и ковариационной мат-

рицей окажется вне шара. Данная вероятностная граница определяется

через решение скалярного уравнения, а в случае единичной ковариацион-

ной матрицы дается аналитическим выражением, которое представляет

собой многомерное обобщение границы из неравенства Селберга. Пока-

зано, что при малых значениях вероятности более типична ситуация, ко-

гда искомая граница определяется новым выражением в сравнении с из-

вестной верхней оценкой из неравенства Маркова. Полученный результат

применен к решению задачи о проверке гипотез с использованием общей

альтернативы.

Ключевые слова: многомерная чебышевская граница, проблема момен-

тов, неравенство Селберга, проверка гипотез.

DOI: 10.31857/S0005231022080037, EDN: AGMYRT

1. Введение

Об актуальности робастных оптимизационных моделей, учитывающих

неопределенность в задании распределений случайных параметров и возму-

щений, можно судить по недавнему обзору [1]. В нем описаны теоретические

основы и приложения оптимизационных постановок, в которых гарантиро-

ванное значение целевой функции риска (потерь, ошибки и т.п.) определя-

ется в результате максимизации по множеству распределений из некоторо-

го класса. Весомую часть этих постановок составляют различные варианты

проблемы моментов Маркова задачи о нахождении супремума вероятност-

ного функционала при ограничениях на моментные характеристики вектора,

включающего все случайные параметры модели [2, 3].

Для указанных задач, рассматриваемых в многомерной формулировке,

наиболее естественным выглядит задание класса распределений с известны-

ми (или частично известными) вектором математического ожидания и ко-

вариационной матрицей [4]. К таким постановкам можно отнести задачи ро-

бастной оптимизации инвестиций с критериями в виде квантили [5] и матема-

тического ожидания [6], задачи минимаксного оценивания с вероятностными

38

критериями [7, 8], робастные версии задач стохастического программирова-

ния [9], в том числе с вероятностными ограничениями [10].

В данной статье рассматривается задача о нахождении верхней границы

для вероятности того, что случайный вектор с фиксированными моментами

второго порядка окажется вне шара. Такая постановка возникает при вычис-

лении наихудшего значения вероятности ошибки в задаче векторного мини-

максного оценивания [7], при построении робастных квадратичных класси-

фикаторов [11], при определении гарантированной надежности доверитель-

ного эллипсоида, построенного на выборочной ковариационной матрице [12].

Алгоритмическое решение указанной задачи (и даже более общей, когда со-

бытие задается системой квадратичных неравенств) получено в [13] путем

сведения к задаче полуопределенного программирования. Однако явного вы-

ражения из полученного результата не следует даже для случая единичной

ковариационной матрицы.

Принципиальной особенностью рассматриваемой в данной статье задачи

является то, что математическое ожидание смещено относительно центра ша-

ра. К этой постановке наиболее близка работа [14], в которой получен аналог

неравенства Селберга [2]. Однако в многомерном случае полученное неравен-

ство дает лишь верхнюю оценку для искомой вероятностной границы. В [15]

решалась аналогичная задача, но на более узком классе распределений, обра-

зованных смесями гауссовских векторов со случайной ковариационной мат-

рицей. Вместе с тем вид искомой границы в несмещенном случае очевиден:

он дается неравенством Маркова.

Отметим также, что точная верхняя грань вероятности попадания в шар,

а равно и в любое другое выпуклое множество, получается по единой фор-

муле Маршалла-Олкина [4]. Этот результат можно обобщить на случай объ-

единения нескольких непересекающихся выпуклых множеств [16]. Поэтому

вычисление верхней грани вероятности выхода за границы выпуклого мно-

гогранного множества может быть сведено к эффективной алгоритмической

процедуре даже в том случае, если на распределение случайного вектора

дополнительно накладывается условие унимодальности [17]. Без условий на

моментные характеристики, но с ограниченным носителем унимодального

распределения максимум вероятности непопадания в выпуклое множество

достигается на равномерном распределении [18-20].

Тем самым данная статья посвящена получению точной вероятностной

границы, явное выражение для которой до сих пор неизвестно.

Статья организована следующим образом: в разделе 2 приведены форму-

лировка проблемы и предварительные замечания; в разделе 3 изложен вывод

искомой вероятностной границы и дана формулировка основного результа-

та; в разделе 4 представлен сравнительный анализ способов вычисления и

оценки искомой границы; в разделе 5 рассмотрено приложение полученно-

го результата к задаче проверки гауссовской гипотезы против альтернативы

39

с произвольным распределением; в Приложении даны доказательства вспо-

могательных утверждений.

2. Постановка задачи и предварительные замечания

Рассмотрим класс всевозможных распределений P(µ, R) случайного век-

тора X ∈ Rn с заданными математическим ожиданием и ковариационной

матрицей

(1)

MX = µ, cov{X,X} = R.

Матрица R предполагается положительно определенной: R ≻ O.

Цель данной работы определить точную верхнюю грань вероятности

того, что вектор c неизвестным распределением и указанными моментными

характеристиками окажется вне шара

Bt = {x: ∥x∥ ≤ t},

где ∥ · ∥ евклидова норма.

Задача 1. Для заданных t > 0, µ ∈ Rn и R ≻ O определить

(2)

pt(µ,R) = sup P{X ∈ Bt

}.

X∼P(µ,R)

Указанную границу принято называть чебышевской по аналогии с нера-

венством Чебышева, которое дает неулучшаемую верхнюю оценку для веро-

ятности выхода за границы интервала

P{|X - µ| ≥ t} ≤ min{σ2/t2, 1}

для скалярных случайных величин X ∼ P(µ, σ2).

Если же интервал смещен относительно математического ожидания µ, то

известно неравенство Селберга [2]

(

)

σ2/

σ2 + (t - r)2

,

σ2 + r2 ≤ rt,

(i)

(3)

P{|X| ≥ t} ≤ s(1)t(r, σ) =

(σ2 + r2)/t2,

rt ≤ σ2 + r2 ≤ t2, (ii)

1,

σ2 + r2 ≥ t2,

(iii)

которое определяет точную вероятностную границу на том же классе распре-

делений P(µ, σ2), где r = |µ|.

Для случайных векторов X ∼ P(µ, R) аналог неравенства Чебышева (2)

имеет вид соотношения

P{∥X - µ∥ ≥ t} ≤ M∥X - µ∥2/t2 = tr R /t2,

которое получается применением неравенства Маркова к величине ∥X - µ∥.

40

Следовательно, при µ = 0 граница (2) известна:

{

}

pt(0,R) = min

tr R/t2, 1

(см. также лемму 3 из [7], где построено распределение, на котором достига-

ется указанная граница).

Однако при µ = 0 неравенство Маркова описывает лишь верхнюю оценку

{(

)∕

}

(4)

pt(µ,R) ≤ min

tr R + ∥µ∥2

t2, 1

,

о которой неизвестно, является ли она точной.

Если шар Bt заменить на эллипсоид

Et = {x ∈ Rn : ∥Ax∥ ≤ t},

где A невырожденная квадратная матрица, то в силу эквивалентности

условий X ∼ P(µ, R) и AX ∼ P(Aµ, ARA∗) проблема нахождения наиболь-

шей вероятности выхода вектора X за границы эллипсоида приводится к за-

даче 1

sup P{X ∈ Et} = pt(Aµ,ARA∗).

X∼P(µ,R)

Точная верхняя грань вероятности попадания внутрь шара при тех же

условиях на моменты случайного вектора (1) вычисляется по известной фор-

муле Маршалла Олкина (см., например, [2, теорема 13.8.2] и [16, теоре-

ма 6.1]):

1

sup

P{X ∈ Bt} =

,

X∼P(µ,R)

1+δ2

где величина δ2 определяется двумя эквивалентными способами

{

}

δ2 = inf

R-1x,x :x+µ∈Bt

=

x∈Rn

{

}

= sup

〈Ra,a〉-1

: 〈a, x〉 ≥ 1 ∀ x: x + µ ∈ Bt

a∈Rn

При этом шар Bt можно заменить на любое выпуклое множество.

Важно отметить, что задача о поиске чебышевской границы для веро-

ятности попадания в множество, задаваемое несколькими квадратичными

ограничениями, решена в [13] алгоритмически путем сведения к задаче по-

луопределенного программирования (SDP). Благодаря этому, при неболь-

шой размерности случайного вектора численное решение задачи 1 может

быть получено эффективными программными средствами [21, 22]. Вместе

с тем запись в виде SDP не позволяет ответить на вопрос о точности

41

неравенства Маркова (4). Кроме того, открытым остается вопрос о при-

менимости решения в виде SDP к задачам, где определение искомой че-

бышевской границы является лишь подзадачей в более общей постанов-

ке. К таким постановкам относится, например, задача минимаксного оце-

нивания: в ней наихудшую вероятность ошибки необходимо максимизиро-

вать на множестве неопределенных характеристик модели наблюдения, а

затем минимизировать на классе рассматриваемых оценок [7]. Даже если

указанная вероятность вычисляется явно через среднеквадратичную ошиб-

ку, применение метода SDP к задаче минимаксного оценивания является

нетривиальным [23].

3. Вывод общего решения и основные подзадачи

Будем рассматривать задачу 1 как проблему моментов. Для этого введем

обозначения: M+ семейство всех неотрицательных конечных борелевских

мер на Rn, I{. . . } индикаторная функция, а также

)

(

)

∗

(1

x

1

0

Γ(x) =

и diag [1, R] =

x xx∗

0

R

Тогда границу (2) можно записать в виде

pt(µ,R) = sup P{X + µ ∈ Bt} =

X∼P(0,R)

{∫

∫

}

= sup

I{x + µ ∈ Bt} Q(dx): Γ(x) Q(dx) = diag [1, R]

,

Q∈M+

где интегралы берутся по всему Rn.

Если ввести сопряженную переменную произвольную симметричную

матрицу

)

∗

(λ0 λ

(5)

M=

,

λ0 ∈ R, λ ∈ Rn, Λ ∈ Rn×ns,

λ Λ

то получаем максиминное выражение:

∫

(6) pt(µ, R) = sup

inf

I{∥x + µ∥ ≥ t} Q(dx) +

M

Q∈M+

[

(

∫

)]

+ tr M diag [1, R] - Γ(x) Q(dx)

В силу предположения R ≻ O матрица diag [1, R] представляет собой внут-

реннюю точку множества моментов

{∫

}

Γ(x) Q(dx): Q ∈ M+

42

в пространстве симметричных матриц Rsn+1)×(n+1) [2, c. 497]. Тогда по тео-

реме 12.2.1 из того же источника получаем, что супремум и инфимум в (6)

можно поменять местами. Дальше нужно заметить, что супремум по Q от

∫

интеграла

... dQ равен нулю, только если подынтегральное выражение

меньше или равно нулю, а в противном случае супремум равен +∞. Это

позволяет включить ограничение на подынтегральную функцию в задачу

минимизации:

pt(µ,R) = inf

{λ0 + tr [ΛR]: I{∥x + µ∥ ≥ t} ≤ q(x|M) ∀ x},

λ0,λ,Λ

где обозначено

q(x|M) = tr [MΓ(x)] = λ0 + 2〈λ, x〉 + 〈Λx, x〉.

Теперь заметим, что ограничение снизу на квадратичную форму q(x|M)

гарантирует ее неотрицательность, что равносильно условию неотрицатель-

ной определенности матрицы: M ≽ O. Это видно из соотношения

〈M x, x〉 = x20 q(x/x0|M) ≥ 0

при любом x = col [x0, x], таком что x0 ∈ R \ {0}, x ∈ Rn.

Поэтому с учетом обозначений (5) и

(7)

qt(M) = inf

{q(x|M): ∥x + µ∥ ≥ t}

x∈Rn

получаем

(8)

pt(µ,R) = min

{λ0 + tr [ΛR]: qt

(M) ≥ 1} ,

M≽O

где минимум достигается в силу замкнутости и ограниченности множества

{M ≽ O: qt(M) ≥ 1, λ0 + tr [ΛR] ≤ 1}, в которое дополнительное введено огра-

ничение согласно pt(µ, R) ≤ 1.

Наименьшее значение q0(M) квадратичной формы q(x|M) на всем про-

странстве достигается в точках x, удовлетворяющих уравнению

(9)

Λx + λ = 0.

Это уравнение разрешимо в силу условия M ≽ O, которое для блочной мат-

рицы имеет вид [24, раздел 9.1.6]:

Λ ≽ O, λ ∈ im[Λ],

〈Λ+λ, λ〉 ≤ λ0,

где im образ линейного оператора (пространство столбцов матрицы).

Если матрица Λ вырожденная, то уравнение (9) описывает аффинное под-

пространство, которое заведомо пересекается с областью {x: ∥x + µ∥ ≥ t}.

43

Поэтому qt(M) = q0(M) = λ0 - 〈Λ+λ, λ〉, что по условию должно быть боль-

ше или равно единице. Тогда значение минимизируемой в (8) функции тоже

оценивается снизу единицей

λ0 + tr [ΛR] ≥ 1 + Λ+λ,λ + tr [ΛR] ≥ 1.

Следовательно, при pt(µ, R) < 1 случай вырожденной матрицы Λ можно за-

ведомо исключить из оптимизации, т.е. определен минимум

(10)

pt

(µ, R) =

{

}

= min

λ0 + tr [ΛR]: 1 - qt(M) ≤ 0, Λ-1λ,λ -λ0 ≤0

λ0,λ∈Rn,Λ≻O

Оба ограничения в (10) удовлетворяют условию Слейтера, т.е. неравен-

ства выполнены строго при определенном выборе переменных: например,

при Λ = I, λ = 0 и достаточно большом λ0. Кроме того, функции в левой

части обоих неравенств являются выпуклыми по блочной матричной пере-

менной M, такой что Λ ≻ O. Действительно, функция 1 - qt(M) представля-

ет собой супремум линейных форм, а надграфик функции 〈Λ-1λ, λ〉 - λ0 = y

описывается линейным матричным неравенством M + diag [y, O] ≽ O.

Если pt(µ, R) < 1, то в силу (10) по теореме Куна-Таккера о седловой

точке [25, с. 85] получаем

(11) pt(µ, R) =

{

(

)}

= max

inf

λ0 + tr [ΛR] + k(1 - qt(M)) + ℓ

Λ-1λ,λ -λ0

k≥0, ℓ≥0

λ0,λ∈Rn,Λ≻O

Первая задача, возникающая на пути нахождения pt(µ, R), состоит в ми-

нимизации квадратичной формы на дополнении к шару (7). Решение дано

в следующей лемме.

Лемма 1. Для любых λ0 ∈ R, λ ∈ Rn и Λ ≻ O точная нижняя грань (7)

равна

{

}

(12)

qt(M) = qt(-µ|M) + sup t2c - (Λ - cI)-1 ν,ν

,

c∈[0,σΛ)

где ν = λ - Λµ, а σΛ минимальное собственное значение матрицы Λ.

Доказательство леммы 1 дано в Приложении.

Благодаря тому, что в (11) перед qt(M) стоит отрицательный коэффициент,

включим супремум по c во внутреннюю задачу минимизации, а также учтем

замену переменной λ = ν + Λµ, где ν пробегает все пространство Rn:

{

pt(µ,R) = max

inf

λ0 + tr [ΛR] +

k≥0, ℓ≥0

λ0,ν,Λ≻cI,c≥0

[

]

+ k 1 - λ0 + 2〈ν + Λµ,µ〉 - 〈Λµ,µ〉 - t2c + (Λ - cI)-1 ν,ν

+

}

[

]

+ℓ

Λ-1 (ν + Λµ),ν + Λµ - λ0

44

Поскольку λ0 входит линейно и пробегает всю действительную ось, точная

нижняя грань по λ0 будет равна нулю только при условии, что соответствую-

щий коэффициент равен нулю: 1 - k - ℓ = 0. В противном случае инфимум

будет равен -∞, откуда

{

pt(µ,R) = max

inf

tr [ΛR] +

0≤k≤1

ν,Λ≻cI,c≥0

[

]

+ k 1 - t2c + 〈Λµ,µ〉 + 2〈µ,ν〉 + (Λ - cI)-1 ν,ν

+

}

+ (1 - k) Λ-1 (ν + Λµ) , ν + Λµ

Выражение, стоящее под знаком inf и рассматриваемое как функция пе-

ременной ν, представляет собой положительно определенную квадратичную

форму, которая без учета свободного коэффициента имеет вид

〈Aν, ν〉 + 2〈µ, ν〉, где A = k(Λ - cI)-1 + (1 - k)Λ-1 ≻ O.

Поэтому ее минимум равен -〈A-1µ, µ〉. Тогда

{

(

)

}

pt(µ,R) = max

inf

k - kt2c + tr[ΛR] +

Λ-A-1

µ,µ

,

0≤k≤1

Λ≻cI,c≥0

где

(

)

Λ - A-1 = kc I + (1 - k)c(S + kcI)-1

Если обозначить S = Λ - cI, то инфимум по Λ от выражения, стоящего

в фигурных скобках, будет равен

(

)

(13) k + c

tr R - kt2 + k∥µ∥2

+

{

}

+ inf tr [SR] + k(1 - k)c2 (S + kcI)-1 µ, µ

S≻O

Для дальнейшего нахождения искомой границы понадобится следующий

факт.

Лемма 2. Для заданных R ≻ O, b ∈ Rn и γ > 0 верно равенство

{

}

(14)

inf tr [SR] + (S + γI)-1 b, b

=

S≻O

∥b∥2/γ,

R-1b,b ≤γ2,

= (I - ξ2 (R + ξI)-2 )b,b ∕γ,R-1b,b

>γ2,

где ξ

единственное положительное решение уравнения

(15)

R (R + ξ I)-2 b, b =γ2.

45

Доказательство леммы 2 дано в Приложении.

Если обозначить bb∗ = k(1 - k)c2µµ∗, γ = kc и

(16)

d0 = R-1

µ,µ ,

то по лемме 2 получаем, что точная нижняя грань в (13) равна

(1 - k)c∥µ∥2,

k ≥ d0/(d0 + 1),

(1 - k)cf(k/(1 - k)),

0 < k < d0/(d0 + 1),

где f(δ) функция положительного аргумента, определяемая по правилу

(

)

(17)

f (δ) =

I - ξ2 (R + ξI)-2

µ,µ

с учетом того, что ξ это решение уравнения

(18)

R (R + ξI)-2

µ,µ

= δ.

Если еще учесть случай k = 0, то искомая граница

{

}

(19)

pt(µ, R) = max

0, p(1), p(2)

выражается через

{

(

)}

(20)

p(1) =

sup

inf

k+c

tr R - kt2 + ∥µ∥2

,

c≥0

k∈[d0/(d0+1),1]

{

(

)

}

(21)

p(2) =

sup

inf

k+c

tr R - kt2 + k∥µ∥2

+ (1 - k)cf(k/(1 - k))

c≥0

k∈(0,d0/(d0+1))

В обоих выражениях инфимум по c будет либо равен нулю (когда соот-

ветствующий коэффициент неотрицателен), либо равен -∞. Поэтому если

ограничения

{

(

)

}

(22)

d0/(d0 + 1) ≤ k ≤ min

1,

tr R + ∥µ∥2

/t2

совместны, то p(1) равно правой части; если же нет, то p(1) = -∞. Аналогич-

но, p(2) равно точной верхней грани тех чисел k ∈ (0, d0/(d0 + 1)), которые

удовлетворяют

(

)

(23)

tr R - k

t2 - ∥µ∥2

+ (1 - k)f(k/(1 - k)) ≥ 0.

Дальнейшие сведения об этом неравенстве даны в следующей лемме.

Лемма 3. Обозначим

(

)

(24)

p=

tr R + ∥µ∥2

/t2

и dξ = R(R + ξI)-2

µ,µ

и допустим, что p < 1 и µ = 0, тогда:

46

(i)

(ii)

d0

p

p

-----

-----

1 - p

1 - p

d0

ˆ

h

x

h

x

x

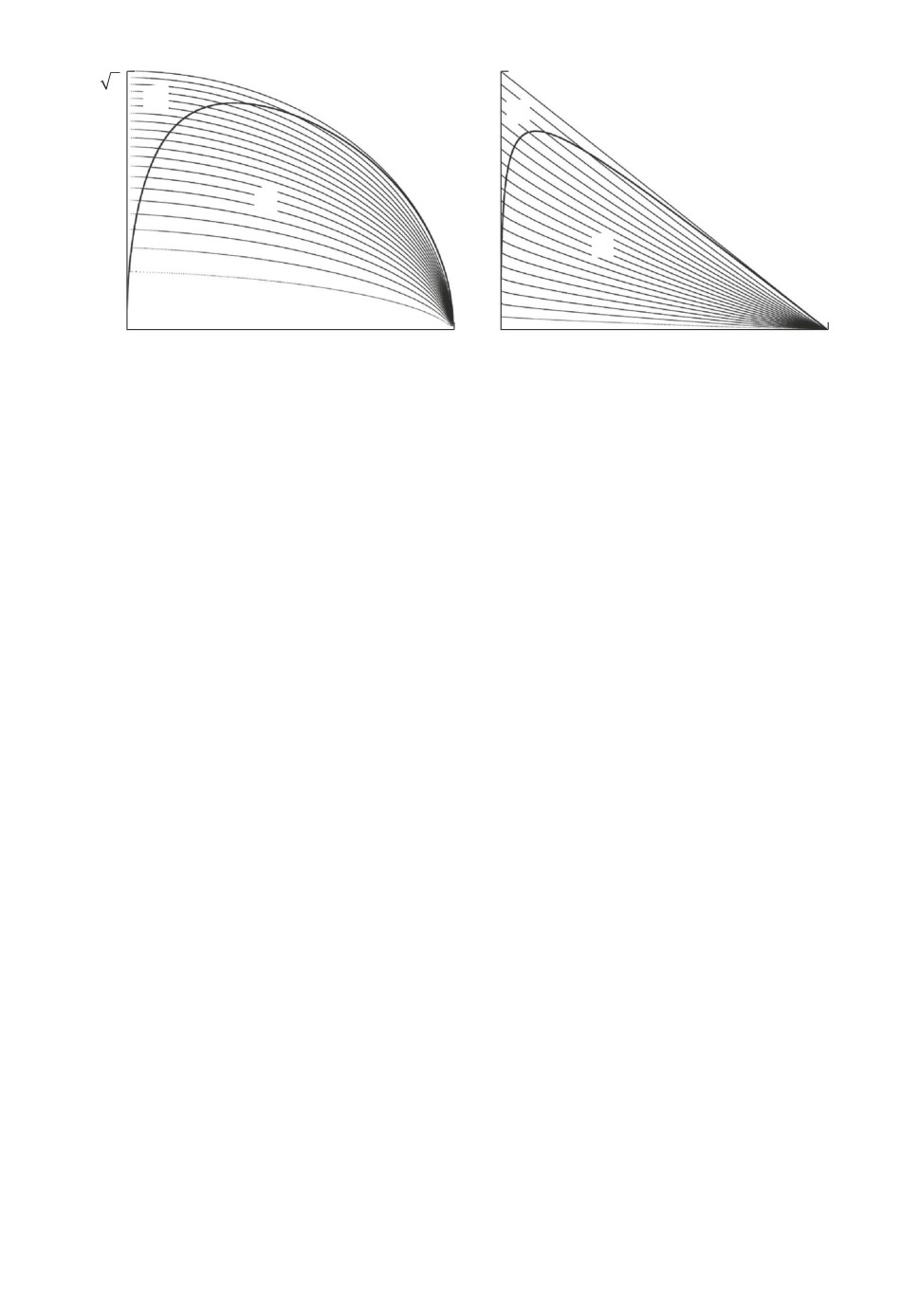

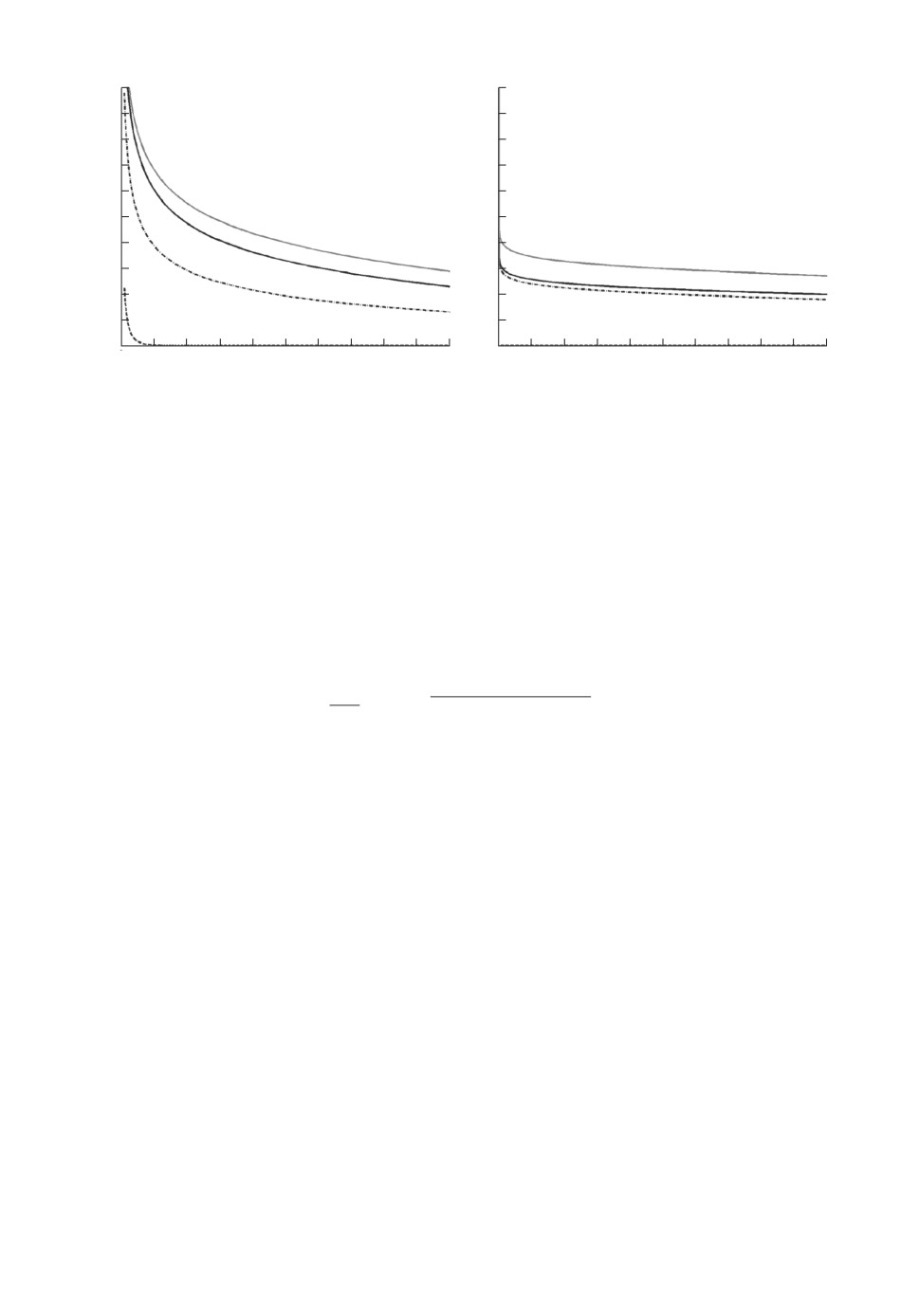

Рис. 1. Левая часть уравнения (25) как функция переменной ξ в случае (i)

(слева) и в случае (ii) (справа).

(i) если ограничения (22) несовместны, то множество решений нера-

венства (23) имеет вид (0,k], гдеk

единственное число k, на кото-

ром (23) обращается в равенство на интервале (0, d0/(d0 + 1)); это число

равноk = dξ/(1 + dξ), где ξ единственное решение уравнения

(

(

)

)

(25)

R+

ξ2/η

I

(R + ξ I)-2

µ,µ

= p/(1 - p)

при

0 < ξ < η = t2(1 - p);

левая часть этого уравнения является гладкой убывающей функцией;

(ii) если же ограничения (22) совместны, то (23) выполнено для всех

k ∈ (0,d0/(d0 + 1)).

Доказательство леммы 3 дано в Приложении.

Графическая иллюстрация утверждения леммы 3 представлена на рис. 1.

Итак, при p < 1 в случае (i) в силу p(1) = -∞ имеем pt(µ, R) = p(2) =k, где

k описано в лемме 3, а в случае (ii) p(1) = p и p(2) = d0/(d0 + 1) ≤ p, откуда

в силу (19) искомая граница совпадает с p. В случае p ≥ 1 из (22) следует

pt(µ,R) = p(1) = 1.

Отметим, что в случае (i) при p ↑ d0/(d0 + 1) решение ξ уравнения (25)

стремится к нулю, откуда предел dξ/(dξ + 1) при ξ ↓ 0 совпадает со значением

искомой границы, вычисленной в случае (ii) при p = d0/(d0 + 1). Тем самым

этот пограничный случай можно отнести к обеим ветвям решения (i) и (ii).

Теперь можно сформулировать окончательный результат о виде вероят-

ностной границы (2).

Теорема 1. При произвольных t > 0, µ ∈ Rn и R ≻ O вероятностная

граница (2) в обозначениях (16) и (24) имеет вид

dξ/(dξ + 1),

p ≤ d0/(d0 + 1),

(i)

(26)

pt(µ,R) =

p,

d0/(d0 + 1) ≤ p ≤ 1, (ii)

1,

p ≥ 1,

(iii)

где ξ > 0 находится из решения уравнения (25).

47

t/

n

t2/n

(ii)

(iii)

(ii)

(iii)

(i)

s2

s

(i)

0

r

t

0

r2

t2

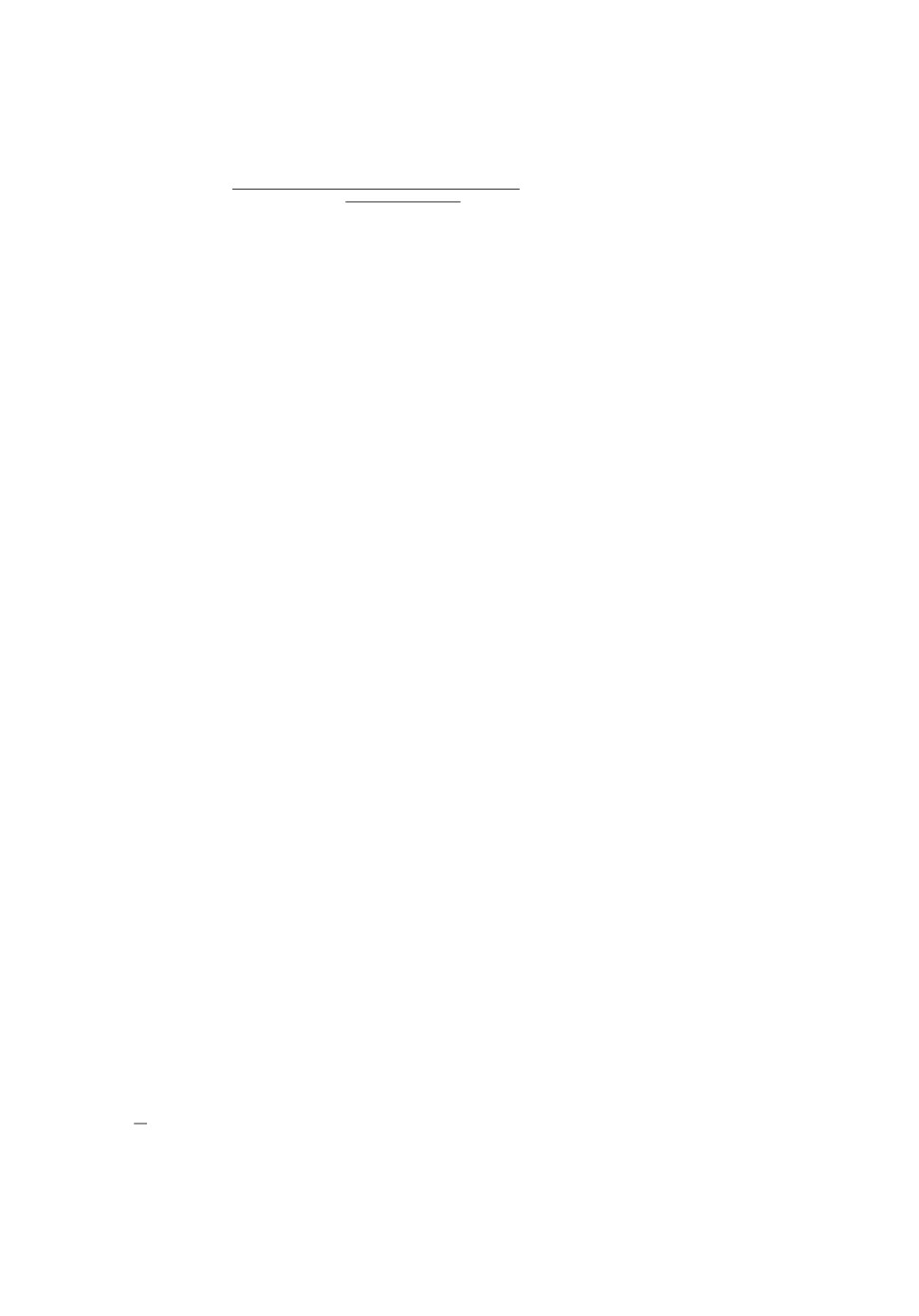

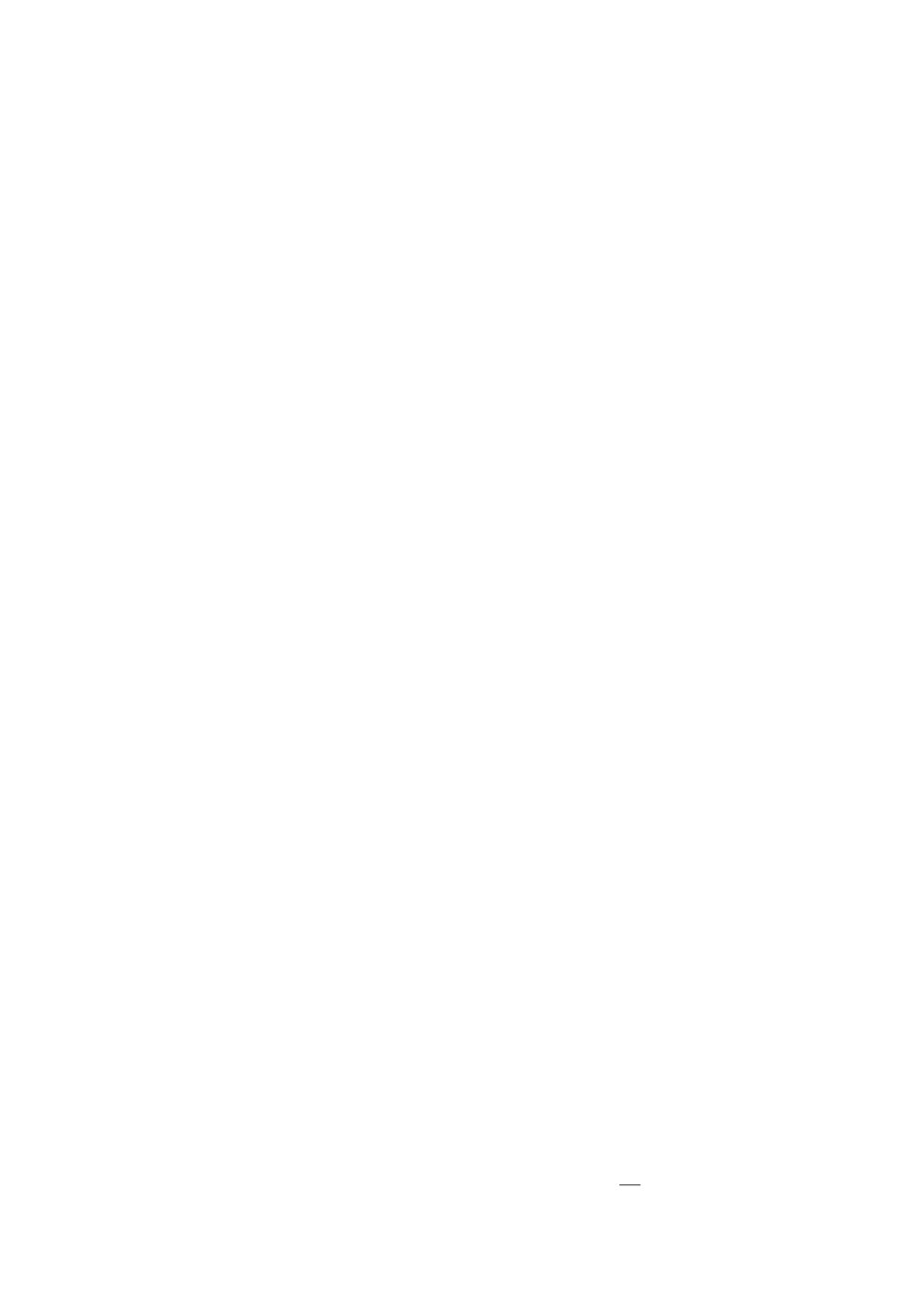

Рис. 2. Линии уровня вероятностной границы s(n)t(r, σ) = k/20 для k = 1, . . . , 20

в переменных r, σ (слева) и в переменных r2, σ2 (справа).

При достаточно большом радиусе, т.е. при

(

)(

)

t2 >

1 + 1/〈R-1µ,µ〉

tr R + ∥µ∥2

,

дробь p = ( tr R + ∥µ∥2)/t2, будучи правой частью неравенства Маркова (4),

определяет для вероятностей P{∥X∥ ≥ t}, X ∼ P(µ, R), завышенную оценку

по сравнению с точной границей (26), (i). Вместе с тем в случае (ii) неравен-

ство Маркова дает неулучшаемую границу для указанных вероятностей.

Формула (19) позволяет получить для найденной границы простую оценку

снизу

{

tr R/(t2 - ∥µ∥2), t2 ≥ tr R + ∥µ∥2,

(27)

pt(µ,R) ≥

1,

t2 ≤ tr R + ∥µ∥2.

Действительно, каждое из выражений, стоящих в (20) и (21) под знаком

supinf, больше или равно величине k + c(tr R - kt2 + k∥µ∥2), которая после

взятия операции sup

inf дает правую часть (27).

c≥0

k∈(0,1]

Как верхняя оценка (4), так и нижняя оценка (27) оказываются меньше

единицы при одном и том же условии:

t2 > tr R + ∥µ∥2.

Если случайный вектор состоит из некоррелированных величин одина-

ковой дисперсии, то при наихудшем выборе его распределения вероятность

выхода за границы шара определяется явными соотношениями, поскольку

уравнение (25) имеет аналитическое решение.

Следствие 1. В случае ∥µ∥ = r и R = σ2In вероятностная граница (26)

равна

pt(µ,R) = s(n)t(r,σ),

48

где

(28) s(n)t(r, σ) =

σ2n2

(

)

(

)2 ,

p≤r2/

r2 + σ2

,

(i)

√

σ2n2 + t

p + n(1 - p) - r

(

)

=p,

r2/

r2 + σ2

≤ p ≤ 1, (ii)

1,

p ≥ 1,

(iii)

с учетом обозначения

(

)

p=

nσ2 + r2

/t2.

Доказательство следствия дано в Приложении.

Таким образом, для случайного вектора X ∼ P(µ, σ2In) имеет место

неулучшаемая оценка P{∥X∥ > t} ≤ s(n)t(r, σ), которую можно считать мно-

гомерным аналогом неравенства Селберга (3).

Линии уровня многомерной границы Селберга s(n)t(r, σ) изображены на

рис. 2 (для случая n = 50). Самая нижняя линия уровня соответствует веро-

ятности 0,05, выше

0,1, еще выше

0,15 и т.д. Из представленных графиков

можно сделать вывод, что при малых уровнях вероятности случай (i), соот-

ветствующий ранее не известной границе, является более типичным в сравне-

нии со случаем (ii), описывающим привычную границу из неравенства Мар-

кова.

4. Сравнительный анализ полученной

вероятностной границы

4.1. Сравнение с методом SDP

Сравним аналитический способ определения вероятностной границы (см.

теорему 1) с алгоритмическим методом, основанным на применении техники

линейных матричных неравенств [13].

В указанной работе для искомой вероятностной границы предлагаются

две эквивалентные формулировки в виде задач полуопределенного програм-

мирования:

а) нижняя граница

{

(Z z)

(R + µµ∗ µ)}

(29)

p

(µ, R) = sup

λ: tr[Z] - t2λ ≥ 0, O ≼

≼

,

t

z∗ λ

µ∗

1

Z,z,λ

где

Z ∈ Rn×ns, z ∈ Rn, λ ∈ R;

49

б) верхняя граница

{

(30) pt(µ, R) = inf

tr [(R + µµ∗)P ] + 2〈µ, q〉 + s:

P,q,s,τ

(

)

(

)

(

)

}

P q

τIn

0

P q

≽

,

≽ O, τ ≥ 0

,

q∗ s

0

1-τt2

q∗ s

где

P ∈ Rn×ns, q ∈ Rn, s,τ ∈ R.

Заметим, что если в (29) убрать ограничения на переменную z, то нера-

венства на две другие переменные примут вид:

O ≼ Z ≼ R + µµ∗ и 0 ≤ λ ≤ min{trZ/t2,1}.

Следовательно, максимум достигается на правых частях этих соотношений,

что дает границу Маркова (4). Если же в (30) ввести дополнительное ограни-

чение 1 - τt2 ≥ 0, то останется только первое матричное неравенство. Тогда

с учетом этого неравенства минимизация по переменным P,q,s дает выра-

жение τ tr [R + µµ∗] + 1 - τt2, минимум которого по τ ∈ [0, 1/t2] снова равен

границе Маркова.

Несмотря на то что указанные преобразования не являются эквивалент-

ными (из них следует лишь оценка сверху для обеих границ), приведенные

рассуждения свидетельствуют о том, что сведение задачи 1 к SDP не дает

возможности получить явное решение элементарными методами.

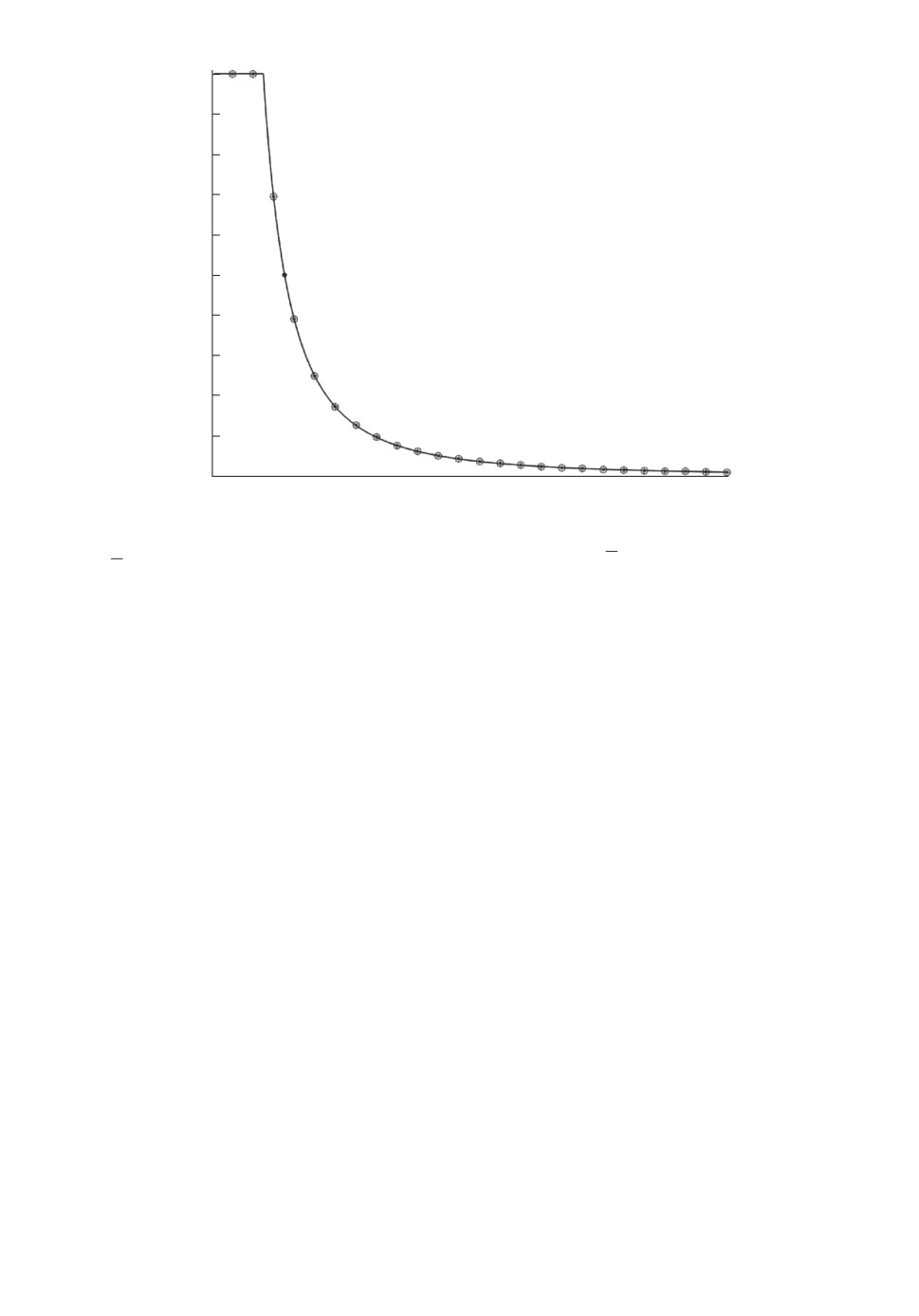

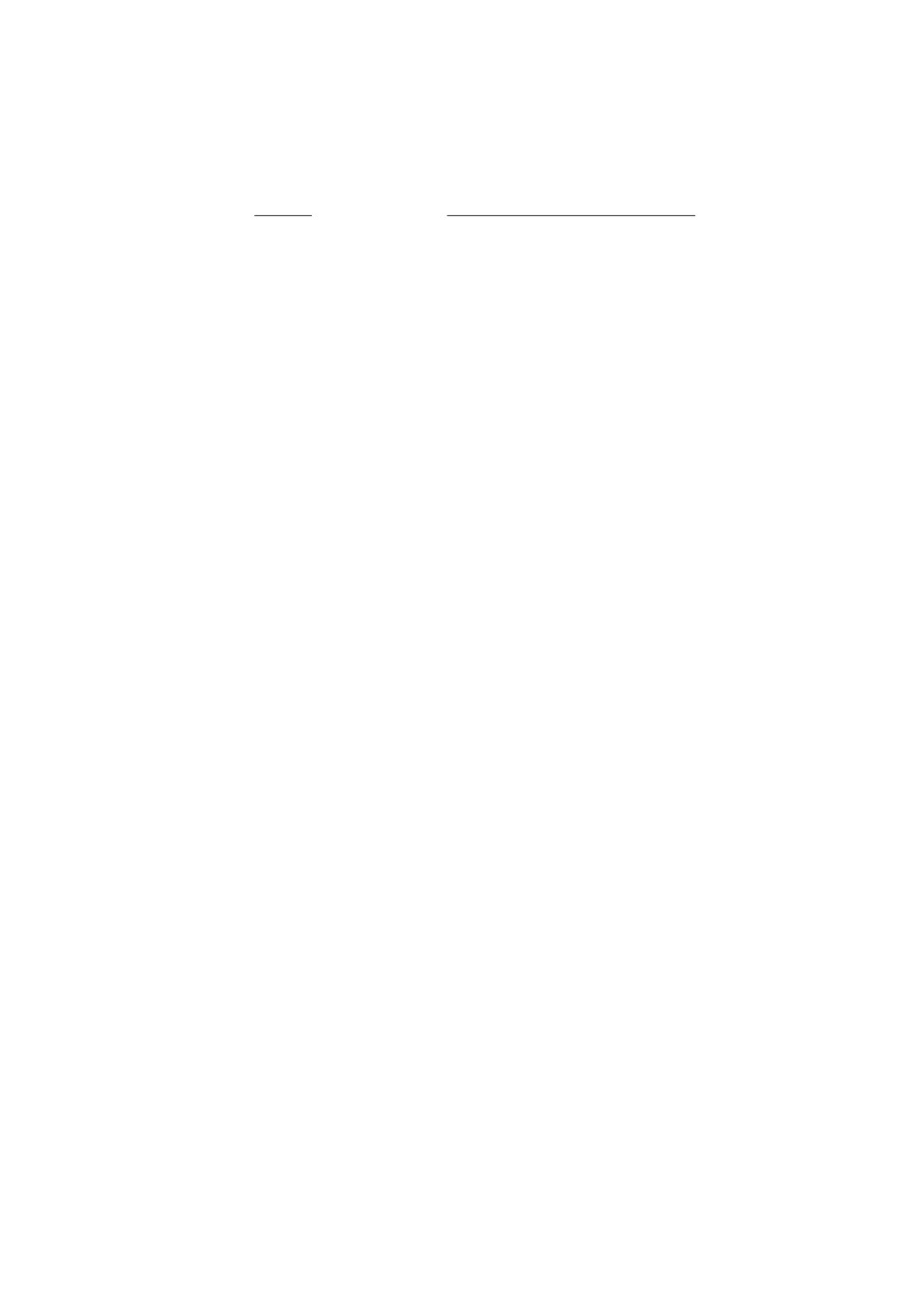

Рисунок 3 демонстрирует идентичность границы pt(µ, R), найденной с по-

мощью теоремы 1, границам p

(µ, R) и pt(µ, R), определяемым через решение

t

задач полуопределенного программирования (29) и (30). Участок кривой, со-

ответствующий новому выражению (не совпадающему с границей Маркова),

расположен правее жирной точки.

Вычисления были проведены для размерности n = 30, вектора математи-

ческого ожидания µ с одинаковыми компонентами и ковариационной матри-

цы R = σ2In, где σ = ∥µ∥.

4.2. Анализ чувствительности доверительного эллипсоида

Для сравнения точной границы pt(µ, R) с известными верхними оценками

рассмотрим задачу о расчете гарантированной надежности доверительного

эллипсоида.

Предположим, что для неизвестного вектора параметров θ ∈ Rn имеется

точечная оценкаθ, с помощью которой построен доверительный эллипсоид

{

}

(31)

Θt = θ ∈ Rn : 〈K-10(θ -θ), θ -θ〉 ≤ t2

50

1,0

0,9

0,8

0,7

0,6

0,5

0,4

0,3

0,2

0,1

0

t

Рис. 3. Вероятностные границы pt(µ, R) (сплошная), p

(µ, R) (звездочки) и

t

pt(µ, R) (кружочки).

из расчета на некоторую номинальную ковариационную матрицу K0 и задан-

ный размер эллипсоида t > 0. При этом оценкаθ является смещенной, т.е.

b = Mθθ- θ = 0, а истинная ковариационная матрица cov{θ, θ} = K отлича-

ется от номинальной K0.

Задачу о расчете гарантированной надежности доверительного эллип-

соида можно сформулировать так: определить нижнюю грань вероятно-

стей Pθ{θ ∈ Θt} при условии, что оценка

θ имеет указанные выше мо-

ментные характеристики. Тогда искомая гарантированная надежность равна

1 - αt(b,K), где

{

}

(

)

αt(b,K) = sup P 〈K-10Y,Y 〉 > t2

= pt K-1/20b,K-1/20KK-1/2

0

Y ∼P(b,K)

Пример 1. В качестве номинального случая возьмем K0 = In, что можно

интерпретировать двумя способами. В задачах оценивания регрессии вектор

X = θ- θ играет роль вектора остатков с ковариационной матрицей, близкой

к единичной. В задачах фильтрации компоненты вектора X имеют смысл

процесса невязки, который в номинальном случае должен быть стандартным

белым шумом.

Требуется определить, насколько чувствителен доверительный эллипсо-

ид (31) по отношению к отклонению смещения b и ковариационной матри-

цы K от номинального случая 0 и In соответственно. В качестве показателя

чувствительности возьмем гарантированное значение вероятности, противо-

51

положной надежности:

(32)

αt(b,K) = sup P{∥X∥ > t} = pt

(b, K).

X∼P(b,K)

Способ вычисления характеристики (32) предлагается сравнить с двумя

другими методами ее оценки из [14, 15].

Первый из них получен в предположении, что случайный вектор описыва-

ется смесью нормальных распределений со случайной ковариационной мат-

рицей. С учетом обозначений [15] имеем

√

√

X =

A(

SZ - a),

где Z стандартный нормальный вектор, S не зависящая от него слу-

чайная матрица с симметричными положительно определенными значения-

ми, такая что MS = Σ, а параметры A ≻ O и a ∈ Rn должны удовлетво-

√

рять условиям MX = b и cov{X, X} = K. Нетрудно проверить, что -

Aa = b,

√

√

AΣ

A = K, откуда

〈Aa, a〉 = ∥b∥2, tr [ΣA] = tr K,

〈AΣAa, a〉 = 〈Kb, b〉.

Тогда в силу [15, теорема 2] получаем

(33) P{∥X∥ > t} ≤ pmixt(b, K) =

{

(

)

}

Cn

t

〈Kb, b〉

= min

tr K

-

, 1

,

t2 - ∥b∥2

t - ∥b∥

∥b∥2 + t∥b∥

где Cn известный коэффициент (например, C10 ≈ 0,50781, C100 ≈ 0,74381 и

C1000 ≈ 0,89215).

Второй способ оценки вероятности P{∥X∥ > t} получен в [14, теорема 2.2]

так же, как в настоящей статье на основе знания только двух моментов век-

тора X, т.е. на классе P(b, K), но дает возможность указать верхнюю границу

(34) P{∥X∥ > t} ≤ pupt(b, K) =

(

)

tr K/ tr K + (t - ∥b∥)2 , tr K + ∥b∥2 ≤ t∥b∥,

(i′)

(

)

=

tr K + ∥b∥2

/t2,

tr K + ∥b∥2 > t∥b∥, (ii′)

1,

tr K + ∥b∥2 ≥ t2,

(iii′)

которая в многомерном случае не является точной.

Для анализа чувствительности рассмотрим отдельно два случая, которые

определяют, что будет варьироваться, смещение или ковариационная мат-

рица.

Пусть в случае а) имеются три варианта значения нормы смещения

√

r = ∥b∥: 0) номинальное (т.е. нулевое) r = 0, 1) умеренное r =

2n и 2) боль-

√

шое смещение r = 2

2n. Сам вектор смещения b зададим в виде гармониче-

ского сигнала bk = c cos(νk + ν0), k = 1, . . . , n, где частота ν = 10π/n и сдвиг

52

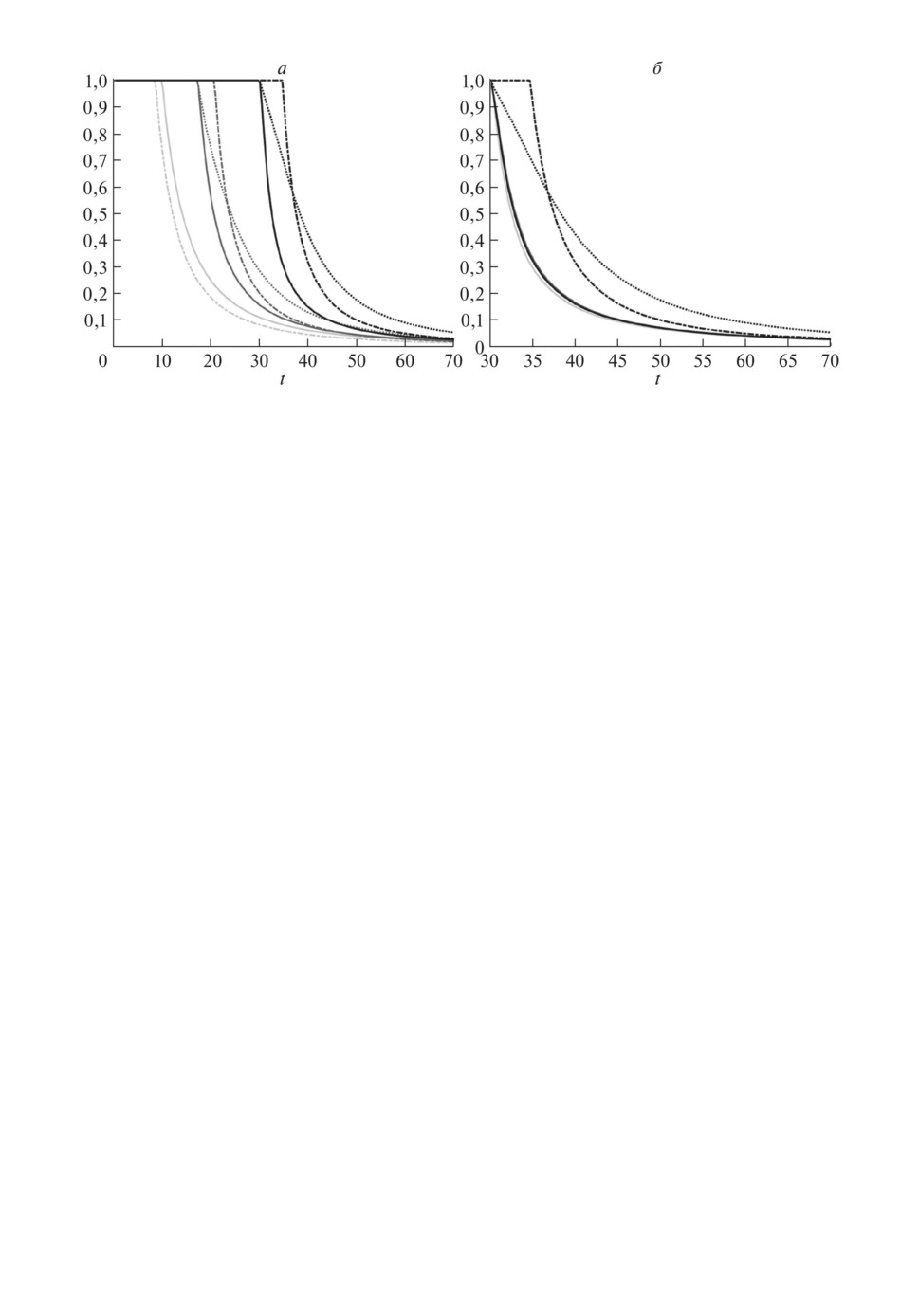

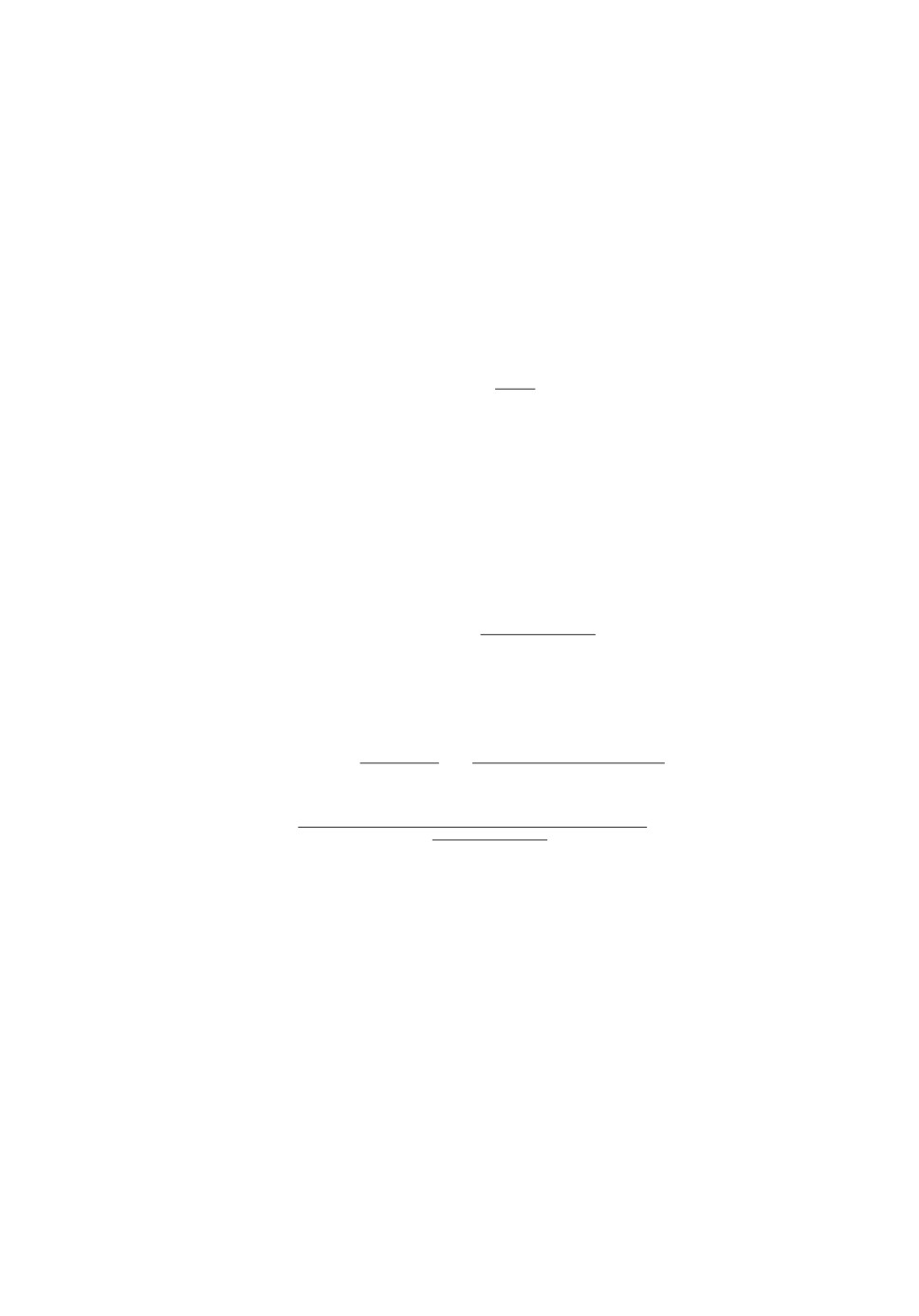

Рис. 4. Показатели чувствительности pt(b, K) (сплошные), pmixt(b, K) (штрихпунк-

тирные) и pupt(b, K) (пунктирные) для трех вариантов данных: 0) - светло-серые,

1) - темно-серые, 2) - черные: случай а) - слева; случай б) - справа.

ν0 = -π/4 фиксированы, а амплитуда c варьируется в зависимости от вариан-

тов 0), 1), 2). При этом ковариационная матрица соответствует номинальному

случаю: K = In.

В случае б) возьмем ковариационную матрицу K = {Kk,l}k,l=1,...,n, состав-

ленную из значений автокорреляционной функции процесса авторегрессии

первого порядка: Kk,l = a|k-l|, где a коэффициент авторегрессии. Рассмот-

рим три варианта его значений: 0) нулевая корреляция a = 0, что соответ-

ствует белому шуму, т.е. номинальному случаю K = In; 1) слабая корреляция

a = 0,5; 2) сильная корреляция a = 0,9. Вектор b здесь предполагается таким

же, как в случае а) при умеренной величине смещения.

Оба случая а) и б) рассматриваются для размерности n = 100.

Рисунок

4

описывает зависимость показателя

(32) и двух его оце-

нок (33), (34) от выбора параметра t (размера доверительного эллипсоида).

Эти зависимости изображены сплошными, штрихпунктирными и пунктирны-

ми линиями соответственно. Светло-серые кривые определяют то, что будет

для номинального варианта данных (b = 0 или K = In). Темно-серые кривые

соответствуют умеренному смещению (график слева) или слабой корреля-

ции (график справа). Черным цветом изображены кривые, которые построе-

ны для случая большого смещения (график слева) или сильной корреляции

(график справа).

Левый график свидетельствует о сильной чувствительности надежности

доверительного эллипсоида к величине смещения. Правый же график пока-

зывает обратную картину: наличие даже сильной корреляции мало влияет

на гарантированное значение надежности.

Важно отметить, что при наличии даже умеренного смещения но-

вая вероятностная граница pt(b, K) существенно точнее, чем ее верхняя

53

граница pupt(b, K). Только в случае нулевого смещения они совпадают:

pt(0,K) = pupt(0,K). Граница pmixt(b,K), которая построена для более узко-

го класса распределений, весьма чувствительна к увеличению смещения ∥b∥,

поэтому только при его малой величине, оказывается pt(b, K) > pmixt(b, K), а

с ростом ∥b∥ неравенство меняется на обратное. В этом случае при малых t

может оказаться, что pmixt(0, K) = 1 в то время, как pt(b, K) ≪ 1. Отметим

еще одну особенность границ (33) и (34): они не зависят (или почти не за-

висят) от корреляций. Поэтому на правом графике все три варианта данных

как для (33), так и для (34) представлены одной кривой.

Таким образом, новая вероятностная граница 1 - pt(b, K) дает наиболее

точную нижнюю оценку надежности доверительного эллипсоида.

5. Использование вероятностной границы

в задаче проверки гипотез

Предположим, что случайный вектор X ∈ Rn содержит эксперименталь-

ные данные, по которым необходимо принять решение об их соответствии

одной из двух конкурирующих гипотез H0 или H1. Особенностью рассмат-

риваемой постановки является то, что в случае альтернативы распределение

вектора X имеет заданные моментные характеристики, но в остальном явля-

ется полностью неопределенным.

Пример 2. Рассмотрим пару конкурирующих гипотез

(

)

(

)

HN0 : X ∼ N

0, σ20I

и H1: X ∼P

µ,σ2I

, µ∈Sr,

где Sr = {x ∈ Rn : ∥x∥ = r}, r = h√n, а σ0, σ, h заданные положительные

параметры. Тем самым согласно нулевой гипотезе HN0 вектор X состо-

ит из независимых центрированных гауссовских величин {Xi, i = 1, . . . , n}

с дисперсией D0Xi = σ20, в то время как альтернатива H1 описывается весь-

ма общими предположениями: совместное распределение величин {Xi} яв-

ляется неопределенным с точностью до задания первых двух моментов,

а именно, математические ожидания M1Xi = µi имеют ¾средний сдвиг¿

√(

)

h=

µ21 + ... + µ2n

/n (это верно, например, при µi = ±h), дисперсии оди-

наковы D1Xi = σ2, ковариации нулевые, т.е. cov1{Xi, Xj } = 0 при i = j (усло-

вие независимости не накладывается).

Будем исходить из того, что σ0 > σ. Поэтому статистический вывод в поль-

зу альтернативы можно интерпретировать как свидетельство о том, что

в данных присутствует сдвиг, который нельзя списать на наличие большей

дисперсии.

Для задания критического множества воспользуемся результатом приме-

нения критерия отношения правдоподобия к задаче проверки исходной гипо-

тезы HN0 против гауссовской альтернативы

(

)

HN1 : X ∼ N

µ,σ2I

,

µ∈Sr.

54

Если f0(x), f1(x, µ) плотности распределений N (0, σ20I) и N (µ, σ2I) со-

ответственно, то статистика отношения правдоподобия

T (x) = sup f1(x, µ)/f0(x), x ∈ Rn,

µ∈Sr

позволяет задать критическое множество в виде

(35)

K = {x ∈ Rn: T(x) > τα

},

где число τα определяется из условия на заданный уровень ошибки первого

рода P0{X ∈ K} = α. Проверим, что критическое множество имеет форму

шара.

Условие T (x) > τα равносильно тому, что для некоторой константы будет

верно

{

}

(36)

max

-∥x - µ∥2/σ2 + ∥x∥2/σ20

> const.

µ: ∥µ∥=r

Указанный максимум равен (1/σ20 - 1/σ2)∥x∥2 + 2r∥x∥/σ2 с точностью до ад-

дитивной постоянной. Если обозначить a = 1 - σ2/σ20 > 0, то при подходящем

выборе числа c неравенство (36) эквивалентно следующему:

(37)

a∥x∥2

− 2r∥x∥ - c < 0.

При неотрицательных c (и только при них) множество решений (37) имеет{

}

√

вид ограничения ∥x∥ < t, где t = r +

r2 + ac

/a. Следовательно, критиче-

ское множество (35) принимает форму шара K = Bt, если t ≥ 2r/a, т.е.

√

(38)

t≥2

n h/a.

Тогда вероятность ошибки первого рода равна

{

}

(

)

αNt = P0{∥X∥ < t} = P0

∥X/σ0∥2 < (t/σ0)2

(t/σ0)2

,

= Fχ2(n)

где Fχ2(n)(·) функция распределения хи-квадрат c n степенями свободы.

В случае гауссовской альтернативы X ∼ N (µ, σ2I) ошибка второго рода

определяется как

βNt = sup P1{∥X∥ > t}.

µ∈Sr

Используя представление X = σ U + µ, где U ∼ N (0, I), получаем

{

}

P1{∥X∥ > t} = P

∥U + µ/σ∥2 > (t/σ)2

,

откуда

(

)

βNt = 1 - Fχ2(n;(r/σ)2)

(t/σ)2

,

55

где Fχ2(n;δ)(·)

функция нецентрального распределения хи-квадрат c n сте-

пенями свободы и параметром нецентральности δ.

Выражение для ошибки второго рода относительно альтернативы H1 да-

ется формулой (28):

βt = sup

sup P1{∥X∥ > t} = s(n)t(r,σ).

µ∈Sr X∼P(µ,σ2I)

Для сравнения приведем еще два варианта вычисления ошибки второго

рода: с помощью неравенства Маркова

{

}

{

}

(39)

βMt = sup min

M1∥X∥2/t2, 1

= min

n(h2 + σ2)/t2, 1

µ∈Sr

и с помощью границы (33)

(

)

(40)

βmixt = sup pmixt

µ,σ2In

,

µ∈Sr

предложенной в

[15] для более узкого по сравнению с семейством

⋃

P(µ, σ2In) класса распределений.

µ∈Sr

Отметим, что при всех способах вычисления ошибки второго рода опера-

ция максимизации по µ ∈ Sr может быть опущена.

Чтобы отделить вероятности обеих ошибок от единицы, предположим, что

M0∥X∥2 > t2 и M1∥X∥2 < t2, т.е. r2 + nσ2 < t2 < nσ20, откуда

√

(41)

n (h2 + σ2) < t <

√n σ0.

Тем самым ограничение

h2 < σ20 - σ2

можно считать условием различимости пары конкурирующих гипотез, кото-

рое означает, что наличие неопределенного по направлению сдвига можно

установить лишь при относительно небольшой его величине.

Теперь радиус t критической области K = Bt можно рассматривать в ка-

честве независимой переменной из диапазона (41) c учетом (38). Построим

параметрические кривые (αNt , βt) и (αNt , βNt ), отражающие взаимную зависи-

мость вероятностей ошибок первого и второго рода для двух альтернатив H1

и HN1 (см. рис. 5). Для сравнения на тех же графиках изображены кривые

(αNt , βMt ) и (αNt , βmixt), в которых вероятность ошибки второго рода оценива-

ется с помощью выражений (39) и (40). Рисунки построены при следующем

соотношении между параметрами: σ/σ0 = 0,3, h/σ = 0,7 (для случая n = 10

и n = 100).

Из представленных рисунков можно сделать вывод о том, что на различи-

мость гипотез кардинально влияет наличие условия независимости. Напри-

мер, относительно гауссовской альтернативы HN1 ошибка второго рода βNt

56

b

b

a

б

0,50

0,50

0,45

0,45

0,40

0,40

0,35

0,35

0,30

0,30

0,25

0,25

0,20

0,20

0,15

0,15

0,10

0,10

0,05

0,05

0

0,1

0,2

0,3

0,4

0,5

0

0,1

0,2

0,3

0,4

0,5

a

a

Рис. 5. Вероятности ошибок: (αNt , βt) (сплошная черная), (αNt , βNt ) (штрихо-

вая), (αNt , βMt ) (сплошная серая), (αNt , βmixt) (штрихпунктирная) для размер-

ности n = 10 (слева) и n = 100 (справа).

быстро стремится к нулю при увеличении размерности n, которая здесь

имеет смысл числа независимых наблюдений. Однако в случае общей аль-

тернативы H1 увеличение n не ведет к статистической избыточности, по-

скольку минимально возможное значение ошибки второго рода βt отделено

от нуля:

1

lim

βtn ≥

,

n→∞

(σ0/σ)2 - (h/σ)2

где tn любой критический уровень из диапазона (41).

Отметим, что такое положение дел остается в силе и для более узких клас-

сов распределений, например для смеси нормальных распределений со слу-

чайной ковариационной матрицей. Судя по рис. 5, на таком классе распреде-

лений известная граница ведет себя лишь немногим лучше, чем многомерная

граница Селберга.

6. Заключение

В статье решена задача о точной верхней грани вероятности непопадания

случайного вектора в шар при условии, что распределение произвольное,

моментные характеристики первого и второго порядков заданные, а сме-

щение математического ожидания относительно центра шара ненулевое.

Если компоненты случайного вектора имеют одинаковую дисперсию и

некоррелированы, то искомая чебышевская граница описывается аналити-

чески и в одномерном случае совпадает с выражением, известным из нера-

венства Селберга. Для ковариационной матрицы общего вида решение по-

ставленной задачи сводится к определению корня скалярного уравнения.

57

Если смещение достаточно мало, то вероятностная граница совпадает с из-

вестной верхней оценкой из неравенства Маркова, т.е. суммой вторых момен-

тов, деленной на квадрат радиуса шара. Однако данная ситуация имеет место

при весьма ограничительных условиях, что наиболее четко проявляется при

сравнительно небольших дисперсиях. Поэтому более типичным оказывается

случай, в котором искомая вероятностная граница определяется новым вы-

ражением, дающим существенно меньшее значение в сравнении с границей

Маркова.

Полученные теоретические результаты подтверждены численными расче-

тами с использованием известного решения, основанного на технике линей-

ных матричных неравенств. Для найденной вероятностной границы пока-

зано, что она может быть значительно точнее, чем известные ранее верх-

ние оценки. Кроме того, приведены два примера ее использования: в за-

даче о гарантированной надежности доверительного эллипсоида и в зада-

че о проверке нормальной гипотезы против альтернативы с неопределенным

распределением.

ПРИЛОЖЕНИЕ

Доказательство леммы 1. Заметим сначала, что q(x|M) → ∞ при

∥x∥ → ∞ в силу Λ ≻ O. Поэтому в задаче (7) минимум достигается. Теперь

сделаем замену переменных u = x + µ:

qt(M) = min

{λ0 + 2 〈λ, u - µ〉 + 〈Λ (u - µ) , u - µ〉} =

u: ∥u∥≥t

= q (-µ|M) + min

{〈Λu, u〉 + 2〈ν, u〉} ,

u: ∥u∥≥t

где ν = λ - Λµ.

Если {uk} и {νk} координаты векторов u и ν в разложении по соб-

ственному ортонормированному базису матрицы Λ, а {ℓk} ее собственные

значения, то

∑(

)

∑(

)

〈Λu, u〉 + 2〈ν, u〉 =

ℓku2k + 2νkuk

≥

ℓku2k - 2|νk||uk|

,

k=1

k=1

где нижняя оценка получается при sign uk = -sign νk.

Воспользуемся равенством Парсеваля ∥u∥2 = u21 + . . . + u2n и сделаем за-

мену переменных p = col [p1, . . . , pn], pk = u2k. Тогда рассматриваемая задача

минимизации превращается в задачу выпуклого программирования

{

}

∑

∑

min

{〈Λu, u〉 + 2〈ν, u〉} = min

(ℓkpk - 2|νk|√pk) :

pk

≥t2

,

u: ∥u∥≥t

p≥0

k=1

k=1

58

к которой можно применить теорему Куна-Таккера о седловой точке:

min

{〈Λu, u〉 + 2〈ν, u〉} =

u: ∥u∥≥t

{

(

)}

∑

∑

= max

inf

(ℓkpk - 2|νk|√pk ) + c t2

- pk

c≥0

p≥0

k=1

k=1

Точная нижняя грань равна сумме t2c и n слагаемых следующего вида:

-ν2k/(ℓk - c), c < ℓk,

inf

{(ℓk - c)pk - 2|νk|√pk} =

0,

c = ℓk, νk = 0,

pk≥0

-∞,

c = ℓk, νk = 0 или c > ℓk.

Достаточно рассматривать только c < σΛ = min ℓk, а если максимум при-

ходится на c = σΛ, то это можно учесть с помощью взятия точной верхней

грани

{

}

∑

min

{〈Λu, u〉 + 2〈ν, u〉} = sup t2c -

ν2k/(ℓk - c)

u: ∥u∥≥t

0≤c<σΛ

k=1

После перехода к матричным обозначениям получаем (12), что и требова-

лось.

Доказательство леммы 2. В силу непрерывности функции

G(S) = tr [SR] + (S + γI)-1 b, b

ее точная нижняя грань на множестве {S : S ≻ O} будет такой же, как на за-

мкнутом множестве Rn×n+, на котором минимум достигается благодаря тому,

что G(S) → ∞ при tr S → ∞.

В силу гладкости необходимое условие минимума в точк

S имеет вид

[

]

tr

∇G

S)(S

S)

≥0

∀S≽O,

где ∇G(S) = R - (S + γI)-1bb∗(S + γI)-1 градиент. Если H любая сим-

метричная матрица с нормой меньше минимального положительного соб-

ственного значени

S, а

P ортопроектор на im

S], то S

S

P

P ≽O.

Поэтому необходимое условие приводит к равенств

P ∇G

S

P = O, т.е.

P

P

P (S + γI)-1bb∗(S + γI)-1

P.

Но в правой части стоит матрица ранга не выше единицы, а слева ранг мат-

рицы равен размерности im

S] в силу im[R] = Rn. Следовательно, искомая

матриц

S будет иметь ранг один (т.е

S = aa∗, a = 0) или будет нулевой.

Поэтому достаточно искать минимум функции

g(a) = G(aa∗) = 〈Ra, a〉 + 〈(aa∗ + γI)-1b, b〉, a ∈ Rn.

59

С помощью леммы об обращении матрицы

(

)

1

(aa∗ + γI)-1 = γ-1 I -

aa∗

∥a∥2 + γ

получим

2

∥b∥

〈a, b〉2

g(a) =

+ 〈Ra, a〉 -

γ

γ(∥a∥2 + γ)

и

∇g(a)

〈a, b〉b

〈a, b〉2a

= Ra -

+

2

γ(∥a∥2 + γ)

γ(∥a∥2 + γ)2

Равенство градиента нулю дает систему уравнений

√

2

〈a, b〉

a=

ξ/γ (R + ξ I)-1b,

ξ=

,

γ(∥a∥2 + γ)2

у которой есть тривиальное решение: a = 0, ξ = 0. Но если a = 0, то ξ > 0 и

второе уравнение оказывается замкнутым относительно этой переменной:

(R + ξ I)-1b, b = ξ (R + ξI)-2b,b +γ2,

что равносильно уравнению (15).

Левую часть (15) можно представить через собственные значения {rk}

матрицы R и координаты {bk} вектора b в собственном ортонормальном ба-

зисе:

∑

2

rkb

k

(rk + ξ)2

k=1

Следовательно, левая часть уравнения (15) является непрерывной убываю-

щей функцией, причем ее предельные значения при ξ ↓ 0 и ξ ↑ ∞ равны со-

ответственно 〈R-1b, b〉 и нулю. Поэтому в случае, когда правая часть урав-

нения (15) находится между этими значениями, решение ξ > 0 существует и

определено единственным способом.

Таким образом, если γ2 < 〈R-1b, b〉, то функция g(a) имеет две критиче-

ские точки: нулевую и найденную выше a = 0, причем

g(0) = ∥b∥2/γ > g(a) = (I - ξ2(R + ξ I)-2)b, b /γ.

Если же 〈R-1b, b〉 ≥ γ2, то уравнение (15) не имеет положительных решений,

поэтому ноль единственная критическая точка.

Итак, в обоих случаях получаем, что искомая нижняя грань определяется

выражением (14), что и требовалось доказать.

60

Доказательство леммы 3. Сделаем в (23) замену k = dξ/(1 + dξ),

которая является взаимно однозначной в силу того, что dξ убывает по ξ > 0.

Поэтому ограничение k ∈ (0, d0/(d0 + 1)) равносильно условию ξ ∈ (0, ∞).

С учетом (17) и (18) неравенство (23) преобразуется к виду

dξ

∥µ∥2 - ξ2〈(R + ξ I)-2µ, µ〉

tr R +

(∥µ∥2 - t2) +

≥0

dξ + 1

dξ + 1

или, что то же самое,

(dξ + 1)( tr R + ∥µ∥2) - dξt2 - ξ2〈(R + ξ I)-2µ, µ〉 ≥ 0.

C использованием обозначений (24) и η = t2 - ( tr R + ∥µ∥2) получим равно-

сильное неравенство

tr R + ∥µ∥2 ≥ (ηR + ξ2I)(R + ξ I)-2µ, µ ,

которое принимает вид G(ξ) ≤ p/(1 - p), где G(ξ)

левая часть уравне-

ния (25).

Предел G(ξ) при ξ ↑ ∞ равен ∥µ∥2/η, что меньше p/(1 - p). Предел G(ξ)

при ξ ↓ 0 равен d0, что больше p/(1 - p) тогда и только тогда, когда ограни-

чения (22) несовместны.

Рассмотрим этот случай. Тогда G(0) > p/(1 - p) > G(∞), что в силу глад-

кости G(ξ) позволяет утверждать, что уравнение (25) имеет решение на ин-

тервале (0, ∞).

Проверим, что оно будет единственным. Для этого вычислим производ-

ную:

D{

}

E

(

)

G′(ξ) =

2ξη-1(R + ξ I)-2 - 2

R+ξ2η-1I

(R + ξI)-3 µ,µ

=

(

)

=2

ξη-1 - 1

(R + ξ I)-3Rµ, µ ,

с помощью которой получаем, что левее точки η функция G(ξ) убывает,

а правее возрастает. Следовательно, G(η) < G(∞) < p/(1 - p), что с учетом

G(0) > p/(1 - p) позволяет утверждать, что точк

ξ, дающая решение уравне-

ния G(ξ) = p/(1 - p), принадлежит интервалу (0, η) и является единственной.

Отсюда следует {ξ > 0: G(ξ) ≤ p/(1 - p)} =

ξ,∞). Тогда множество ре-

шений неравенства (23) имеет вид (0,k], гдеk = dˆξ/(dˆξ + 1) в силу обратной

монотонности замены переменной.

Остается рассмотреть случай, когда ограничения (22) совместны. В этом

случае G(0) ≤ p/(1 - p), откуда G(ξ) ≤ p/(1 - p) для всех ξ > 0, что равно-

сильно тому, что неравенство (23) выполнено при любых k ∈ (0, d0/(d0 + 1)).

Лемма доказана.

Доказательство следствия. Заметим сначала

(

)

(

)2

p=

nσ2 + r2

/t2, d0 = r2/σ2, dξ = σ2r2/

σ2 + ξ

61

Достаточно разобрать только случай (i). Согласно (26) он реализуется при

p(σ2 + r2) < r2. При этом условии запишем уравнение (25)

(

)(

r2

σ2 + ξ2/η

σ2 + ξ

)-2 = p/(1 - p), 0 < ξ < η = t2(1 - p).

Перепишем его в виде r2((1 - p)σ2 + ξ2/t2) = p(σ2 + ξ)2 и преобразуем к квад-

ратному уравнению

(

)

n/t2

ξ2 + 2pξ + pσ2 - (1 - p)r2 = 0.

Его свободный коэффициент отрицателен по условию. Следовательно, оба

корня вещественные и разного знака. Тогда

√

ξ = t2(-p +

D/4)/n

искомый положительный корень, где

(

)(

)

D/4 = p2 -

n/t2

pσ2 - (1 - p)r2

=

(

)

=p2 -

p - r2/t2

p + (1 - p)nr2/t2 = (p + (1 - p)n)r2/t2,

откуда получаем

{

√

}

σ2 + ξ =

-r2 + rt

p + (1 - p)n

/n.

Теперь остается подставить это выражение в (26), (i):

1

1

pt(µ,σ2In) =

=

=

1 + 1/dξ

1 + (σ2 + ξ)2/(σ2r2)

1

=

{

}2

√

1+

-r + t

p + (1 - p)n

/(σ2n2)

Полученное выражение совпадает с (28), (i), что и требовалось доказать.

СПИСОК ЛИТЕРАТУРЫ

1. Lin F., Fang X., Gao Z. Distributionally robust optimization: A review on theory

and applications // Numerical Algebra, Control & Optimization. 2022. V. 12. No. 1.

P. 159-212.

2. Карлин С., Стадден В. Чебышевские системы и их применение в анализе и

статистике. М.: Наука, 1976.

3. Крейн М.Г., Нудельман А.А. Проблема моментов Маркова и экстремальные за-

дачи. М.: Наука, 1973.

4. Marshall A.W., Olkin I. Multivariate Chebyshev inequalities // Ann. Math. Stat.

1960. V. 31. No. 4. P. 1001-1014.

62

5.

El Ghaoui L., Oks M., Oustry F. Worst-case value-at-risk and robust portfolio op-

timization: A conic programming approach // Operations Research. 2003. V. 51.

No. 4. P. 543-556.

6.

Popescu I. Robust mean-covariance solutions for stochastic optimization and appli-

cations // Operations Research. 2007. V. 55. No. 1. P. 98-112.

7.

Панков А.Р., Семенихин К.В. О минимаксном оценивании по вероятностному

критерию // АиТ. 2007. № 3. С. 66-82.

Pankov A.R., Semenikhin K.V. Minimax Estimation by Probabilistic Criterion //

Autom. Remote Control. 2007. V. 68. No. 3. P. 430-445.

8.

Семенихин К.В. Минимаксность линейных оценок неопределенно-стохастиче-

ского вектора по обобщенным вероятностным критериям // АиТ. 2007. № 11.

С. 88-104.

Semenikhin K.V. Minimax Nature of the Linear Estimates of the Indefinite Stochas-

tic Vector from the Generalized Probabilistic Criteria // Autom. Remote Control.

2007. V. 68. No. 11. P. 1970-1985.

9.

Delage E., Ye Y. Distributionally robust optimization under moment uncertainty

with application to data-driven problems // Operations Research. 2010. V. 58.

P. 595-612.

10.

Zymler S., Kuhn D., Rustem B. Distributionally robust joint chance constraints with

second-order moment information // Math. Program. 2013. V. 137. P. 167-198.

11.

Kitahara T., Mizuno S., Nakata K. Quadratic and convex minimax classifica-

tion problems // J. Operations Research Society Of Japan. 2008. V. 51. No. 2.

P. 191-201.

12.

Stellato B., Van Parys B.P.G., Goulart P.J. Multivariate Chebyshev inequality

with estimated mean and variance // American Statistician. 2017. V. 71. No. 2.

P. 123-127.

13.

Vandenberghe L., Boyd S., Comanor K. Generalized Chebyshev bounds via semidef-

inite programming // SIAM Review. 2007. V. 49. No. 1. P. 52-64.

14.

Csiszar V., Fegyverneki T., Mori T.F. Explicit multivariate bounds of Chebyshev

type // Annales Univ. Sci. Budapest., Sect. Comp. 2014. V. 42. P. 109-125.

15.

Csiszar V., Mori T.F. A Bienaymé-Chebyshev inequality for scale mixtures of the

multivariate normal distribution // Math. Inequalities & Applications. 2009. V. 12.

No. 4. P. 839-844.

16.

Bertsimas D., Popescu I. Optimal inequalities in probability theory: A convex opti-

mization approach // SIAM J. Optimization. 2005. V. 15. No. 3. P. 780-804.

17.

Van Parys B.P.G., Goulart P.J., Kuhn D. Generalized Gauss Inequalities via

Semidefinite Programming // Math. Program. 2016. V. 156. P. 271-302.

18.

Barmish B.R., Lagoa C.M. The Uniform Distribution: A Rigorous Justification for

Its Use in Robustness Analysis // Math. Control Signal. Syst. 1997. V. 10. P. 203-222.

19.

Кибзун А.И. О наихудшем распределении в задачах стохастической оптимиза-

ции с функцией вероятности // АиТ. 1998. № 11. С. 104-116.

Kibzun A.I. On the Worst-Case Distribution in Stochastic Optimization Prob-

lems with Probability Function // Autom. Remote Control. 1998. V. 59. No. 11.

P. 1587-1597.

63

20. Кан Ю.С. Об обосновании принципа равномерности в задаче оптимизации ве-

роятностного показателя качества // АиТ. 2000. № 1. С. 54-70.

Kan Yu.S. On the Justification of the Uniformity Principle in the Optimization of

a Probability Performance Index // Autom. Remote Control. 2000. V. 61. No. 1.

P. 50-64.

21. Sturm J.F. Using SeDuMi 1.02, a MATLAB toolbox for optimization over symmetric

cones // Optimization Methods & Software. 1999. V. 11. No. 12. P. 625-653.

22. Grant M.C., Boyd S.P. The CVX Users’ Guide. Release 2.1. CVX Research, Inc.

23. Платонов Е.Н., Семенихин К.В. Методы синтеза минимаксных оценок при на-

личии поэлементных ограничений на ковариационную матрицу // АиТ. 2016.

№ 5. С. 82-108.

Platonov E.N., Semenikhin K.V. Methods for Minimax Estimation under Elemen-

twise Covariance Uncertainty // Autom. Remote Control. 2016. V. 77. No. 5.

P. 817-838.

24. Алберт А. Регрессия, псевдоинверсия и рекуррентное оценивание. М.: Наука,

1977.

25. Иоффе А.Д., Тихомиров В.М. Теория экстремальных задач. М.: Наука, 1974.

Статья представлена к публикации членом редколлегии А.И. Кибзуном.

Поступила в редакцию 03.02.2022

После доработки 17.03.2022

Принята к публикации 28.04.2022

64