ПРОБЛЕМЫ ПЕРЕДАЧИ ИНФОРМАЦИИ

Том 56

2020

Вып. 2

УДК 621.391.1 : 519.72

© 2020 г.

А. Макур, Л. Чжэн

СРАВНЕНИЕ КОЭФФИЦИЕНТОВ СЖАТИЯ ДЛЯ f-ДИВЕРГЕНЦИЙ1,2

Коэффициенты сжатия - это зависящие от распределений константы, ис-

пользующиеся для улучшения стандартных неравенств об обработке данных

для f-дивергенций (или относительных f-энтропий) и приводящие к так назы-

ваемым “сильным” неравенствам об обработке данных. Для любого двумерного

совместного распределения, т.е. пары, состоящей из вектора вероятностей и сто-

хастической матрицы, известно, что коэффициенты сжатия для f-дивергенций

ограничены сверху единицей, а снизу - коэффициентом сжатия для χ2-дивер-

генции. Мы показываем, что верхняя граница достигается, когда совместное

распределение разложимо, а нижней можно достичь, устремляя f-дивергенции

на входе для коэффициентов сжатия к нулю. Затем устанавливается линей-

ная верхняя граница на коэффициенты сжатия совместных распределений для

некоторого класса f-дивергенций через коэффициенты сжатия для χ2-дивер-

генции, причем эта граница уточняется для выделенного специального случая

дивергенции Кульбака- Лейблера (КЛ-дивергенции). Далее дается альтерна-

тивное доказательство того факта, что коэффициенты сжатия для КЛ- и χ2-ди-

вергенций совпадают для двумерных гауссовских распределений (где для пер-

вого коэффициента может налагаться ограничение на второй момент). Наконец,

обобщается известный результат о том, что коэффициенты сжатия для стоха-

стических матриц (после вычисления экстремума по всевозможным векторам

вероятностей) для всех нелинейных операторно выпуклых f-дивергенций рав-

ны. В частности, доказывается, что так называемый предпорядок “меньшего

искажения” на стохастических матрицах эквивалентным образом характеризу-

ется любой нелинейной операторно выпуклой f-дивергенцией. Как приложение

этой характеризации, выводится также обобщение сильного неравенства Само-

родницкого об обработке данных.

Ключевые слова: коэффициент сжатия, f-дивергенция/относительная f-энтро-

пия, сильное неравенство об обработке данных, предпорядок меньшего искаже-

ния, максимальная корреляция.

DOI: 10.31857/S0555292320020011

§ 1. Введение

Коэффициенты сжатия для f-дивергенций (или относительных f-энтропий) ши-

роко изучались в теории информации [1-8], статистике [9-13], анализе цепей Марко-

ва в теории вероятностей [14-16], а также в теории матриц [17-19], причем особен-

но важными частными случаями являются расстояние по вариации, дивергенция

Кульбака - Лейблера (КЛ-дивергенция) и взаимная информация, а также χ2-дивер-

генция. Как будет показано на примерах, эти коэффициенты - зависящие от распре-

1 Работа выполнена при финансовой поддержке фонда NSF (грант 1216476) и стипендии компа-

нии Хьюлетт-Паккард.

2 Весьма предварительная версия настоящей статьи была представлена в докладе [1].

3

делений константы, использующиеся для улучшения обычных неравенств об обра-

ботке данных для f-дивергенций и приводящие к так называемым “сильным” нера-

венствам об обработке данных. Коэффициенты сжатия для f-дивергенций бывают

двух типов: относящиеся к парам из вектора вероятностей и стохастической матри-

цы, т.е. совместным распределениям, и относящиеся только к стохастическим мат-

рицам, т.е. условным распределениям. Цель настоящей статьи в широком смысле -

изучить различные неравенства и равенства между коэффициентами сжатия в обеих

постановках. В постановке, связанной с совместными распределениями, мы главным

образом устанавливаем общие границы на коэффициенты сжатия для определенных

классов f-дивергенций, а также выводим специфические границы на коэффициен-

ты сжатия для КЛ-дивергенции через коэффициенты сжатия для χ2-дивергенции

(или квадрата максимальной корреляции Хиршфельда - Гебелейна - Реньи). С дру-

гой стороны, в постановке, связанной со стохастическими матрицами, мы обобщаем

известную эквивалентность некоторых определенных коэффициентов сжатия, до-

казывая эквивалентность характеризации предпорядка “меньшего искажения” (less

noisy preorder) на стохастических матрицах [20].

Более точно, настоящая статья включают в себя следующее:

1.

Полностью независимый обзор результатов о коэффициентах сжатия в § 2 (в ко-

тором мы в основном рассматриваем свойства коэффициентов сжатия, а не их

применения).

2.

Обобщения известных свойств коэффициентов сжатия для совместных распре-

делений, такие как результат о разложимости в теореме 1 (или в п. 3 предложе-

ния 3), мета-сильное неравенство об обработке данных в п. 6 предложения 3 и

характеризация коэффициента сжатия для χ2-дивергенции через коэффициен-

ты сжатия для f-дивергенций при стремлении f-дивергенции на входе к нулю

в теореме 2 (что явно объясняет интуитивное понимание нижней границы на

максимальную корреляцию в п. 7 предложения 3).

3.

Зависящие от распределений нижние границы на КЛ-дивергенцию и некоторые

классы f-дивергенций через χ2-дивергенцию в леммах 2 и 5 соответственно (эти

границы используются для доказательства дальнейших линейных верхних гра-

ниц на коэффициенты сжатия).

4.

Линейные верхние границы на коэффициенты сжатия совместных распределе-

ний для КЛ-дивергенции и некоторые классы f-дивергенций через коэффициент

сжатия для χ2-дивергенции в теоремах 3, 4 и следствии 1.

5.

Альтернативное доказательство известной эквивалентности между коэффициен-

тами сжатия для КЛ- и χ2-дивергенций двумерных гауссовских распределений

в §5, которое также устанавливает эквивалентность при дополнительном огра-

ничении на среднюю мощность (или второй момент) - см. теорему 5.

6.

Эквивалентные характеризации предпорядка меньшего искажения на стохасти-

ческих матрицах через нелинейные операторно выпуклые f-дивергенции в тео-

реме 6. Эта теорема обобщает известный из литературы важный результат о том,

что коэффициенты сжатия для всех нелинейных операторно выпуклых f-дивер-

генций для заданной стохастической матрицы равны (см. предложение 6).

7.

Применения наших основных результатов, такие как обобщение сильного нера-

венства Самородницкого об обработке данных на нелинейную операторно вы-

пуклую f-информацию в теореме 7, а также простое доказательство в предло-

жении 7 того факта, что скорость сходимости к стационарному состоянию для

КЛ-дивергенции определяется коэффициентом сжатия для χ2-дивергенции для

эргодической обратимой цепи Маркова.

Структура статьи. Кратко обрисуем дальнейшее изложение. Вначале в § 2 при-

веден обзор все разрастающейся литературы по коэффициентам сжатия. В этом па-

раграфе собраны формальные определения и важнейшие свойства обоих вышеупо-

мянутых вариантов коэффициентов сжатия, а также вкратце описано их появление

4

в изучении эргодичности. Затем в § 3 сформулированы и пояснены наши основные

результаты и рассмотрена относящаяся к этому литература. В § 4 представлены

некоторые полезные границы, связывающие f-дивергенции и χ2-дивергенцию, ко-

торые будут использованы для вывода линейных верхних границ на коэффициенты

сжатия совместных распределений для некоторого класса f-дивергенций и КЛ-ди-

вергенции. В продолжение этого сюжета в § 5 доказана эквивалентность некоторых

коэффициентов сжатия двумерных гауссовских распределений. В § 6 доказывает-

ся эквивалентность характеризаций предпорядка меньшего искажения на стохасти-

ческих матрицах через нелинейные операторно выпуклые f-дивергенции, а затем

выводится обобщение сильного неравенства Самородницкого об обработке данных.

Наконец, в § 7 даются заключительные замечания и намечаются направления даль-

нейших исследований.

§2. Обзор результатов по коэффициентам сжатия

Здесь мы определим коэффициенты сжатия для f-дивергенций и изложим неко-

торые известные факты о них. Вначале в п. 2.1 вводятся предварительные опре-

деления и обозначения, относящиеся к f-дивергенциям, а в последующих пунктах

вкратце изложим первые необходимые сведения о коэффициентах сжатия и сильных

неравенствах об обработке данных.

2.1. f-дивергенция. Рассмотрим дискретное пространство элементарных собы-

тий X ≜ {1, . . . , |X |} мощности 2 ≤ |X | < +∞, элементы которого будем без огра-

(

ничения общности считать натуральными числами. Через PX ⊆

R|X|)∗ обозначим

(

вероятностный симплекс в

R|X|)∗, состоящий из всех вероятностных мер на X , где

(

R|X|)∗ - двойственное к R|X | векторное пространство, состоящее из всех векторов-

строк длины |X |. Мы понимаем PX как множество всевозможных распределений

случайной величины X со значениями X , и будем представлять каждую вероят-

ностную меру PX ∈ PX в виде вектора-строки

(

PX = (PX(1), . . . , PX(|X|)) ∈

R|X|)∗.

Через

P◦X ≜ {PX ∈ PX : ∀x ∈ X, PX(x) > 0}

обозначим относительную внутренность множества PX . Популярным “расстоянием”

между вероятностными мерами в теории информации и статистике является по-

нятие f-дивергенции, независимо введенное в [21, 22] и в [23]. (Это понятие также

независимо появлялось в [24], [25] и [26, 27].)

Определение 1 (f-дивергенция [21-23]). Для заданной выпуклой функции

f : (0,∞) → R, такой что f(1) = 0, f-дивергенцией вероятностной меры PX ∈ PX

относительно вероятностной меры RX ∈ PX называется величина

[

∑

(RX(x))

(RX(X))]

Df (RX ∥PX) ≜

PX(x)f

=EPX f

,

(1)

PX(x)

PX(X)

x∈X

где через EPX [ · ] обозначено математическое ожидание относительно PX и в силу

непрерывности и некоторых других соображений (подробнее см. в [28, § 3]) приня-

ты соглашения f(0) = lim f(t) (в том числе, возможно, равный бесконечности),

t→0+

0f(0/0) = 0 и 0f(r/0) = lim

pf(r/p) = r lim pf(1/p) для всех r > 0 (этот предел

p→0+

p→0+

также может быть равен бесконечности).

5

Понятие f-дивергенции обобщает несколько известных мер расхождения (дивер-

генции), используемых в теории информации, статистике и теории вероятностей.

Приведем несколько примеров:

1

1.

Расстояние по вариации: Для f(t) =

|t - 1| соответствующая f-дивергенция

2

является расстоянием по вариации (total variation (TV) distance):

1

∥RX - PX∥TV ≜ max|RX (A) - PX (A)| =

∥RX - PX∥1 ,

(2)

A⊆X

2

∑

где PX (A) =

PX(x) для любой A ⊆ X, через ∥·∥p обозначена ℓp-норма,

x∈A

p ∈ [1,∞], причем второе равенство, как и некоторые другие характеризации

расстояния по вариации, доказано в [29, гл. 4].

2.

Дивергенция Кульбака - Лейблера (КЛ-дивергенция)[30, § 2]: Для функции f(t) =

= tlog(t), где log(·) здесь и далее - натуральный логарифм (по основанию e), со-

ответствующая f-дивергенция является КЛ-дивергенцией (или относительной

энтропией):

∑

(RX(x))

D(RX ∥ PX ) ≜

RX(x)log

(3)

PX(x)

x∈X

3.

χ2-дивергенция (Неймана) [31]: Для f(t) = (t -1)2 или f(t) = t2 - 1 соответству-

ющая f-дивергенция является χ2-дивергенцией:

∑

(RX (x) - PX (x))2

χ2(RX ∥PX) ≜

(4)

PX(x)

x∈X

Существуют и другие варианты χ2-дивергенции - см., например, [32], где описа-

ны варианты Пирсона и Вайды, а также их связь с f-дивергенциями.

4.

Дивергенция Хеллингера порядка α ∈ (0, ∞) \ {1} [33, определение 2.10]: Для

tα - 1

f (t) =

соответствующая f-дивергенция является дивергенцией Хеллинге-

α-1

ра (или дивергенцией Цаллиса) порядка α:

)

1

(∑

Hα(RX ∥PX) ≜

RX(x)αPX(x)1-α - 1 ,

(5)

α-1

x∈X

1

где

H1(RX ∥PX) - квадрат расстояния Хеллингера,H2(RX ∥PX) = χ2(RX ∥PX)

2

2

– это χ2-дивергенция, а случай α = 1 в смысле аналитического продолжения

соответствует КЛ-дивергенции H1(RX ∥PX) = D(RX ∥PX) (см. [34, § II]).

5.

Дивергенция Винце - Ле Кама порядка λ ∈ (0, 1) [35-37]: для функции f(t) =

2

(t - 1)

= λ(1-λ)

соответствующая f-дивергенция - это дивергенция Винце -

λt + (1 - λ)

Ле Кама порядка λ:

∑

(RX (x) - PX (x))2

LCλ(RX ∥PX) ≜ λ(1 - λ)

=

λRX (x) + (1 - λ)PX (x)

x∈X

)

( λ

=

χ2(RX ∥λRX + (1 - λ)PX),

(6)

1-λ

1

где частный случай при λ =

известен как расстояние Винце -Ле Кама (или

2

triangular discrimination).

6

Хотя в общем случае f-дивергенции не являются метриками3, они обладают

несколькими полезными свойствами. Для изложения некоторых из эти свойств обо-

значим через Y ≜ {1, . . . , |Y|} другой дискретный алфавит, где 2 ≤ |Y| < +∞,

и введем соответствующий вероятностный симплекс PY возможных вероятностных

мер для случайной величины Y со значениями в Y. Кроме того, пусть PY|X - множе-

ство всех |X|×|Y| стохастических по строкам матриц в пространстве R|X|×|Y|. Всюду

далее мы отождествляем условное распределение Y при заданном X (или “дискрет-

ный канал”) PY|X со стохастической по строкам матрицей вероятностей перехода

W ∈ PY|X (т.е. PY |X = W), где x-й строкой матрицы W для любого x ∈ X является

условная вероятностная мера PY|X=x ∈ PY . Мы интерпретируем W : PX → PY как

отображение, переводящее вероятностные меры PX ∈ PX на входе в вероятност-

ные меры PY = PX W ∈ PY на выходе путем умножения слева. Ниже перечислены

некоторые хорошо известные свойства f-дивергенций (см. [21, 22]):

1. Неотрицательность и рефлексивность: Для любых RX, PX ∈ PX справедливо

Df (RX ∥PX) ≥ 0 (согласно неравенству Йенсена), причем при RX = PX име-

ет место равенство. Кроме того, если f строго выпукла в единице, т.е. λf(x) +

+ (1 - λ)f(y) > f(1) для всех x, y ∈ (0, ∞) и λ ∈ (0, 1), таких что λx+ (1 - λ)y = 1,

то равенство имеет место тогда и только тогда, когда RX = PX. (Заметим, что

во всех приведенных выше примерах f-дивергенции функция f строго выпукла

в единице.)

2. Аффинная инвариантность: Рассмотрим любую аффинную функцию α(t) =

= a(t - 1), где a ∈ R. Ясно, что Dα(RX ∥PX) = 0 для любых RX, PX ∈ PX . Сле-

довательно, f и f + α задают одну и ту же f-дивергенцию, т.е. Df+α(RX ∥ PX ) =

= Df(RX ∥PX) для любых RX,PX ∈ PX (где f + α определяется поточечным

сложением).

3. Двойственность Чисара: Для функции f рассмотрим ее сопряженную по Чисару

функцию

)

(1

f∗ : (0, ∞) → R, f∗(t) = tf

,

t

которая также выпукла, строго выпукла в единице тогда и только тогда, ко-

гда f строго выпукла в единице, и удовлетворяет равенству f∗∗ = f. Тогда

Df∗(PX ∥RX) = Df (RX ∥PX) для любых RX, PX ∈ PX .

4. Совместная выпуклость: Отображение (RX, PX) → Df (RX ∥PX) выпукло по

паре вероятностных мер на входе.

5. Неравенство об обработке данных (см. [23,24]): Для любой W ∈ PY|X и любых

RX, PX ∈ PX справедливо (в силу выпуклости соответствующих функций)

Df (RXW ∥PXW) ≤ Df (RX ∥PX),

(7)

где равенство имеет место, если Y является достаточной статистикой для X,

позволяющей делать выводы о паре (RX , PX ) (см. [28, определение 5]). Кроме

того, если f строго выпукла и Df (RX ∥PX) < ∞, то равенство имеет место тогда

и только тогда, когда Y - достаточная статистика для X, позволяющая делать

выводы о паре (RX , PX ) (см., например, [28, теорема 14; 38, п. 3.1]).

Хотя в [22] и [39, § 2] представлено оригинальное изложение этих свойств, боль-

шей дидактикой обладает изложение в [38, § 6]. Заметим, что в силу свойства 2 мы

рассматриваем f-дивергенции только для нелинейных функций f.

Теперь определим понятие “информации” между случайными величинами, со-

ответствующее произвольной f-дивергенции, для которой также справедливо нера-

3 Мы зачастую выделяем f-дивергенции, являющиеся метриками, называя их “расстояниями”

(например, расстояние по вариации, расстояние Хеллингера) и оставляя термин “дивергенция” для

тех f-дивергенций, которые метриками не являются (например, КЛ-дивергенция, χ2-дивергенция).

7

венство об обработке данных. Для случайных величин X и Y с совместной вероят-

ностной мерой PX,Y , состоящей из (PX , W ), взаимная f-информация между X и Y

определяется [19] (см. также [8, формула (V.8); 40, формула (11)]) как

∑

If (X; Y ) ≜ Df (PX,Y ∥ PX PY ) =

PX(x)Df (PY|X=x ∥PY ),

(8)

x∈X

где через PX PY обозначено произведение распределений, определяемых маргиналь-

ными вероятностными мерами PX и PY , и при этом используется соглашение, что

PX(x)Df (PY|X=x ∥PY ) = 0, если PX(x) = 0. Для f(t) = t log(t) взаимная f-информа-

ция соответствует стандартной взаимной информации (в смысле определения Фано,

см. [41, п. 2.3; 38, п. 2.3]):

I(X; Y ) ≜ D(PX,Y ∥ PX PY ).

Более того, взаимная f-информация обладает некоторыми естественными свойства-

ми информационных мер. Например, если X и Y независимы, то If (X; Y ) = 0, и

верно обратное, если f строго выпукла в единице.

Пусть теперь U - еще одна случайная величина с дискретным алфавитом U ≜

≜ {1, . . ., |U|}, такая что 2 ≤ |U| < +∞. Если (U, X, Y ) имеют совместное распреде-

ление и образуют цепь Маркова U → X → Y , т.е. U условно независима от Y при

заданном X, то они удовлетворяют неравенству об обработке данных [39]

If (U; Y ) ≤ If (U; X),

(9)

где равенство имеет место, если Y - достаточная статистика для X, позволяющая

делать выводы об U (т.е. U → Y → X также образуют цепь Маркова). Более того,

если f строго выпукла и If (U; X) < ∞, то равенство имеет место тогда и только

тогда, когда Y - достаточная статистика для X, позволяющая делать выводы об

U. Заметим, что хотя Чисар в [39] изучал несколько другое понятие, известное как

f-информативность, соотношение (9) можно извлечь из доказательства предложе-

ния 2.1 в [39].

Не стоит и говорить, что неравенства об обработке данных (7) и (9) являются

обобщениями более известных неравенств об обработке данных для КЛ-диверген-

ции и взаимной информации (см., например, [30, теорема 4.1; 41]). Наконец, заметим,

что хотя по поводу неравенств об обработке данных (7) и (9) мы ссылаемся на рабо-

ты [21-24] и [39], соответственно, оба этих неравенства были независимо доказаны

в [26,27]. В частности, в [27] изучались обобщенные информационные функционалы,

и частный случай из [27, теорема 5.1] дает Df (PU PY ∥ PU,Y ) ≤ Df (PU PX ∥ PU,X ) для

любой цепи Маркова U → X → Y . По двойственности Чисара для f-дивергенций

отсюда вытекает (9).

В заключение этого пункта вкратце опишем “локально квадратичное поведение”

f-дивергенций. Локальные аппроксимации f-дивергенций важны с геометрической

точки зрения, поскольку они преобразуют окрестности стохастических многообра-

зий с определенными f-дивергенциями в качестве метрики в пространства со ска-

лярным произведением, где метрика задается информацией Фишера - Рао [42-44].

Рассмотрим некоторую выделенную вероятностную меру PX

∈ P◦X (задающую

“центр локальной окрестности” рассматриваемых вероятностных мер) и любую дру-

гую вероятностную меру RX ∈ PX . Определим вектор сферического возмущения

меры RX относительно PX :

(√

KX ≜ (RX - PX)diag

PX

)-1,

(10)

где

√· означает поэлементное извлечение квадратного корня из компонент векто-

ра, а через diag(·) обозначена диагональная матрица с соответствующими компо-

8

нентами вектора на главной диагонали. С помощью вектора KX можно построить

траекторию сферически возмущенных вероятностных мер:

(√

)

R(ε)X = PX + εKX diag

PX

=

(11)

= (1 - ε)PX + εRX ,

(12)

параметризованную параметром ε ∈ (0, 1), которая соответствует выпуклым ком-

бинациям RX и PX . Заметим, что KX задает направление траектории (11), а па-

раметр ε контролирует близость между R(ε)X и PX . Равенство (11) объясняет, поче-

му KX называется вектором “сферического возмущения”; вектор KX пропорциона-

√

(ε)

лен члену первого порядка по ε → 0 возмущения между векторами

R

и

√PX,

X

являющимися вложениями вероятностных мер R(ε)X и PX в единичную сферу в про-

(

странстве

R|X|)∗.

Теперь предположим, что функция f : (0, ∞) → R, задающая рассматриваемую

f-дивергенцию, дважды дифференцируема в единице и f′′(1) > 0. Тогда с помощью

формулы Тэйлора можно показать, что эта f-дивергенция локально пропорциональ-

на χ2-дивергенции (см. [45, § 4], или [41] для случая КЛ-дивергенции):

(

)

f′′(1)

Df

R(ε)X ∥PX

=

ε2χ2(RX ∥PX) + o(ε2) =

(13)

2

f′′(1)

=

ε2 ∥KX∥22 + o(ε2),

(14)

2

где используется стандартная o-символика Бахмана - Ландау. Локальная аппрокси-

мация в (14) несколько более удобна, чем в (13). Действительно, можно построить

(

траекторию (11) с помощью сферического вектора возмущения KX ∈

R|X|)∗, ко-

торый удовлетворяет условию ортогональности

√PX KTX = 0, но не имеет вид (10).

Для достаточно малого ε = 0 (зависящего от PX и KX ), векторы R(ε)X, определен-

ные в (11), на самом деле являются вероятностными мерами в PX .4 Таким обра-

зом, аппроксимация в (14) оставется верной, поскольку она относится к режиму,

когда ε → 0.

Непосредственной проверкой можно также убедиться, что f-дивергенции, для

которых f′′(1) > 0, локально симметричны, т.е.

(

)

(

)

Df

R(ε)X ∥PX

=Df

PX ∥R(ε)X

+ o(ε2).

Поэтому они напоминают стандартную евклидову метрику в “окрестности” вероят-

ностных мер вокруг заданной вероятностной меры в P◦X . Отметим, что преимуще-

ство использования сферических возмущений

{

}

(

√

KX ∈

R|X|)∗ :

PXKTX = 0

вместо аддитивных возмущений (например, RX -PX ) состоит в том, что они образу-

ют пространство со стандартным евклидовым скалярным произведением. Это позво-

ляет видоизменить (13) с использо(√ние) ℓ2-нормы KX вместо взвешенной ℓ2-нормы

аддитивного возмущения KX diag

PX

. Это позволяет сделать обозначения более

удобными и упростить вычисления - см. наше доказательство теоремы 2. Наконец,

заметим, что идеи возмущения, подобные (11), использовались ранее в различных

контекстах, некоторые примеры этого можно найти в [42, 43, 46, 47].

4 Хотя компоненты вектора R(ε)X в сумме всегда равны 1, поскольку√PXKTX = 0, для больших

(по абсолютной величине) значений ε некоторые из его компонент могут быть отрицательными.

9

2.2. Коэффициенты сжатия совместных распределений. Неравенства об обработ-

ке данных (7) и (9) можно максимально усилить до так называемых сильных нера-

венствах об обработке данных (СНОД), вводя в них некоторые константы, извест-

ные как коэффициенты сжатия. Как было отмечено выше, имеется два варианта

коэффициентов сжатия: первый зависит от пары, состоящей из вектора вероятно-

стей и стохастической матрицы, т.е. совместного распределения, а второй - только

от стохастической матрицы, т.е. условного распределения. В этом пункте мы введем

коэффициенты первого типа, а коэффициенты второго типа обсудим позже.

Определение 2 (коэффициент сжатия для совместного распределения [1,6,8,

11,15]). Для любой вероятностной меры на входе PX ∈ PX и любой стохастической

матрицы PY|X = W ∈ PY|X коэффициентом сжатия для фиксированной f-дивер-

генции называется

Df (RXW ∥PXW)

ηf (PX, PY|X) ≜

sup

,

Df (RX ∥PX)

RX∈PX

0<Df (RX ∥PX )<+∞

где супремум берется по всем вероятностным мерам RX , удовлетворяющим ограни-

чению 0 < Df (RX ∥ PX ) < +∞. При этом, если X или Y постоянна почти наверное

(п.н.), полагаем ηf (PX , PY|X ) = 0.

Используя определение 2, из неравенства об обработке данных для f-диверген-

ций (7) можно вывести следующее СНОД:

Df (RXW ∥PXW) ≤ ηf (PX, PY|X)Df (RX ∥PX),

(15)

справедливое для всех RX ∈ PX при фиксированных PX ∈ PX и W ∈ PY|X . Следу-

ющее предложение показывает, что неравенство об обработке данных для взаимной

f-информации можно улучшить таким же образом.

Предложение 1 (коэффициент сжатия для взаимной f-информации [8, тео-

рема V.2]). Для любой вероятностной меры на входе PX ∈ PX, любой стоха-

стической матрицы PY|X ∈ PY|X и любой выпуклой дифференцируемой функции

f : (0,∞) → R с равномерно ограниченной производной в некоторой окрестности

единицы, такой что f(1) = 0, имеет место равенство

If (U; Y )

ηf (PX, PY|X) =

sup

,

PU|X : U→X→Y

If (U; X)

0<If (U;X)<+∞

где супремум берется по всем стохастическим матрицам PU|X ∈ PU|X и конеч-

ным алфавитам U случайной величины U, таким что U → X → Y образуют

цепь Маркова. (Заметим, что в этой экстремальной задаче достаточно взять

|U| = 2.)

Предложение 1 доказано в [8, теорема V.2]. Частный случай этого результата

для КЛ-дивергенции был доказан в [4] (для случая конечного алфавита) и в [6]

(для произвольного алфавита). Интуитивно вариационная задача в предложении 1

определяет вероятностную модель, которая делает Y как можно более близкой к до-

статочной статистике для X относительно U (см. комментарий после формулы (9)).

Кроме того, этот результат показывает, что при условиях регулярности коэффици-

ент сжатия для любой f-дивергенции изящным образом объединяет неравенства об

обработке данных для f-дивергенции и соответствующей взаимной f-информации,

будучи наилучшим множителем, который можно добавить в каждое из них. Дей-

ствительно, когда случайные величины U → X → Y образуют цепь Маркова, можно

10

записать СНОД-версию неравенства (9):

If (U; Y ) ≤ ηf (PX , PY |X )If (U; X),

(16)

справедливую для любого условного распределения PU|X ∈ PU|X при фиксирован-

ных PX ∈ PX и PY|X ∈ PY|X . Заметим, что даже если условия предложения 1 не

выполнены, неравенство (16) по-прежнему справедливо (хотя ηf (PX , PY|X ) может

уже не быть наилучшей возможной мультипликативной константой в (9)).

Два коэффициента сжатия будут особенно важны для нас. Первый - это коэф-

фициент сжатия для КЛ-дивергенции:

D(RX W ∥ PX W )

ηKL(PX, PY|X) =

sup

(17)

D(RX ∥ PX )

RX∈PX

0<D(RX ∥PX)<+∞

Эта величина связана с фундаментальным понятием гиперсжимаемости в тео-

рии вероятностей и статистике [15]. Гиперсжимаемостью называется явление, когда

некоторые операторы условного математического ожидания являются сжимаемы-

ми, даже если функциональное пространство входов имеет (вероятностную) Lq-нор-

му, в то время как функциональное пространство выходов имеет (вероятностную)

Lp-норму, где 1 ≤ q < p (см., например, [5]). Это понятие находит применения

в теории информации, поскольку гиперсжимаемые величины часто обладают свой-

ствами тензоризации, что позволяет получать однобуквенные характеризации для

них. В [5, 15] показано, что величину ηKL(PX , PY|X ) можно определить как наклон

секущей нижней границы области гиперсжимаемости (соответствующей совместной

вероятностной мере PX,Y ) на бесконечности.

Коэффициент сжатия для КЛ-дивергенции объясняет поразительную дихото-

мию между экстремальными задачами в определении 2 и предложении 1. Чтобы

пояснить этот контраст, вначале рассмотрим частный случай предложения 1 для

КЛ-дивергенции и стандартной взаимной информации [4,6]:

I(U; Y )

ηKL(PX, PY|X) =

sup

,

(18)

PU ,PX |U : U→X→Y

I(U; X)

I(U;X)>0

где оптимизация проводится (что эквивалентно) по всем PU ∈ PU , таким что U =

= {0, 1} (без ограничения общности, см. [6, Приложение B]), и всем PX|U ∈ PX|U ,

таким что для маргинальных распределений PX = PU PX|U . Теперь напомним при-

мер из работы [4], где U = {0, 1}, X ∼ Bernoulli(1/2) (т.е. PX = (1/2, 1/2)), а PY|X -

матрица “асимметричного канала со стиранием”. В этом численном примере супре-

{

мум в (18) достигается на последовательностях вероятностных мер

P(k)X|U=0 ∈ PX :

}

{

}

{

}

k ∈ N

,

P(k)X|U=1 ∈ PX : k ∈ N

и

P(k)U ∈ PU : k ∈ N

, где N ≜ {0, 1, 2, . . .},

удовлетворяющим условиям

lim

P(k)U(1) = 0,

(19)

k→∞

(

)

(

)

lim

D

P(k)X|U=0 ∥PX

= 0 < liminf

D

P(k)X|U=1 ∥PX

,

(20)

k→∞

k→∞

(

)

(

)

D

P(k)

∥PY

D

P(k)

∥PY

Y |U=0

Y |U=1

lim sup

(

) < ηKL(PX,PY |X) = lim

(

),

(21)

k→∞ D

P(k)X|U=0 ∥PX

k→∞ D

P(k)

∥PX

X|U=1

где PY = PX PY|X и P(k)Y|U=u = P(k)X|U=uPY|X для u ∈ U. Этот пример показывает, что

в общем случае, хотя максимум в (18) достигается [2] при I(U; X) → 0, супремум

11

в (17) часто достигается на последовательности вероятностных мер

{

}

R(k)X ∈ PX \ {PX} : k ∈ N

,

которая не стремится к PX (из-за невыпуклости этой экстремальной задачи). На

первый взгляд, это противоречит интуиции, поскольку неравенство об обработке

данных (7) обращается в равенство при RX = PX . Однако в теореме 2 (приведенной

в п. 3.1) будет показано, что максимизация отношения КЛ-дивергенций с ограниче-

нием D(RX ∥ PX ) → 0 на самом деле позволяет достичь ηχ2(PX , PY|X ), что зачастую

строго меньше [4], чем ηKL(PX, PY|X). Поэтому имеется резкий контраст между по-

ведением оптимизационных задач в (17) и (18).

Второй важный коэффициент сжатия - это коэффициент сжатия для χ2-дивер-

генции:

χ2(RXW ∥PXW)

ηχ2 (PX, PY|X) =

sup

,

(22)

RX∈PX

χ2(RX ∥PX)

0<χ2(RX ∥PX )<+∞

тесно связанный с обобщением коэффициента корреляции Пирсона между X и Y ,

известным как максимальная корреляция Хиршфельда - Гебелейна - Реньи, или про-

сто максимальная корреляция [9-12]. Дадим определение максимальной корреля-

ции, которая является мерой статистической зависимости, удовлетворяющей семи

естественным аксиомам (некоторые из них будут приведены ниже в предложении 3),

которым должны удовлетворять такие меры [12].

Определение 3 (максимальная корреляция [9-12]). Для двух совместно рас-

пределенных случайных величин X ∈ X и Y ∈ Y максимальной корреляцией между

X и Y называется

ρ(X; Y ) ≜

sup

E[f(X)g(Y )],

f : X→R, g: Y→R

E[f(X)]=E[g(Y )]=0

E[f(X)2]=E[g(Y )2]=1

где супремум берется по всем (измеримым по Борелю) функциям f и g с нулевым

средним и единичной дисперсией. При этом, если X или Y постоянна п.н., то не

существует функций f и g, удовлетворяющих этим условиям, и по определению

полагаем ρ(X; Y ) = 0.

Можно показать, что коэффициент сжатия для χ2-дивергенций в точности равен

квадрату максимальной корреляции [11]:

ηχ2 (PX, PY|X) = ρ(X; Y )2.

(23)

Кроме того, следующее предложение показывает, что максимальную корреляцию

можно описать как некоторое сингулярное число; впервые это было показано в [9,12]

в несколько других видах (см. также [1, 4, 13, 40] и [48, теорема 3.2.4]).

Предложение

2 (максимальная корреляция как сингулярное число [9, 12]).

Для заданных случайных величин X ∈ X и Y ∈ Y с совместной вероятностной

мерой PX,Y , состоящей из (PX, W), можно определить матрицу дивергенций пе-

реходов (МДП )

(√

)

(√

)†

B ≜ diag

PX

W diag

PY

,

(24)

где через † обозначено псевдообращение Мура - Пенроуза. Тогда максимальная кор-

реляция ρ(X; Y ) равна второму по величине сингулярному числу матрицы B.

12

Для полноты изложения доказательство этого предложения приведено в Прило-

жении A. Из предложения 2 и равенства (23) видно, что коэффициент сжатия для

χ2-дивергенции на самом деле равен квадрату второго собственного числа МДП B.

Используя принцип минимакса Куранта - Фишера - Вейля (см. [49, теоремы 4.2.6

и 7.3.8]), это можно представить в виде

BT x2

2

ηχ2 (PX, PY|X) = max

,

(25)

x∈R|X|\{0}√

∥x∥2

2

PXx=0

где через 0 обозначен нулевой вектор соответствующей размерности, а

√PXT - пра-

вый сингулярный вектор матрицы BT , соответствующий ее максимальному сингу-

лярному числу, равному единице (см. Приложение A).

Разложения по сингулярным числам для МДП и их связь с χ2-дивергенцией хо-

рошо изучены в статистике. Например, в области анализа соответствий, основан-

ной Хиршфельдом в 1935 г. [9], рассматриваются зависимости между категорными

случайными величинами. В частности, в простом анализе соответствий двумерные

вероятностные меры PX,Y рассматриваются как факторная таблица, и зависимость

между X и Y раскладывается по так называемым главным компонентам инерции

с помощью разложения по сингулярным числам матрицы B, см. работы [50; 51, § 2]

и библиографию в них. В [9] с помощью этого наблюдения было получено модаль-

ное разложение взаимной χ2-информации (или среднеквадратичной сопряженно-

сти Пирсона χ2(PX,Y ∥ PX PY )). Хотя в прошлом анализ соответствий использовался

просто как техника визуализации данных, теперь он является частью более широ-

кого инструментария геометрического анализа данных. Недавно в [40] в контексте

теории информации и теории оценивания были изучены главные компоненты инер-

ции, являющиеся собственными значениями матрицы Грама BT B. Они обобщают

первые главные компоненты инерции (т.е. квадраты максимальной корреляции) до

величины, известной как k-корреляция, k ∈ {1, . . ., min{|X|, |Y|}-1}, которая равна

(k+1)-норме Ки Фаня матрицы BT B минус 1. Там же доказаны некоторые свойства

k-корреляции, такие как выпуклость и неравенство об обработке данных [40, § II],

и представлены некоторые приложения. В альтернативном направлении в [52] иссле-

дованы нейронные сети, позволяющие приближенно выполнить анализ соответствий

в больших масштабах.

В то время как в анализе соответствий рассматриваются категорные случайные

величины, зависимость между общими (некатегорными) случайными величинами

изучается в близкой области исследований - анализе и идентификации так называ-

емых распределений Ланкастера [53,54]. Для заданного совместного распределения

PX,Y на произведении измеримых пространств X ×Y пусть PX и PY - маргинальные

распределения на X и Y соответственно, PX PY - произведение этих распределений,

а L2(X, PX) (соответственно, L2(Y, PY )) - гильбертово пространство интегрируемых

с квадратом вещественнозначных функций на X (соответственно, на Y) со скаляр-

ным произведением, заданным распределением PX (соответственно, PY ). Предполо-

жим, что χ2(PX,Y ∥ PX PY ) < ∞, откуда следует, что PX,Y абсолютно непрерывно от-

носительно PX PY , и пусть dPX,Y /dPX PY - производная Радона - Никодима от PX,Y

относительно PXPY . Для такой постановки в [53] доказано, что существуют ортонор-

мированные базисы {fj ∈ L2(X , PX ) : 0 ≤ j < |X |} и {gk ∈ L2(Y, PY ) : 0 ≤ k < |Y|}

и некоторая последовательность {σk ≥ 0 : 0 ≤ k < min{|X |, |Y|}} неотрицательных

корреляций, такие что PX,Y является распределением Ланкастера, для которого

справедливо разложение

dPX,Y

∑

(x, y) =

σkfk(x)gk(y).

(26)

dPX P

Y

k=0

13

Если X и Y конечны, разложение (26) в точности повторяет структуру разложения

по сингулярным числам матрицы B, соответствующей PX,Y . Дальнейшие ссылки по

этой довольно общей области можно найти в [55; 56, п. II-D].

Еще одно направление исследований состоит в изучении вычислительных аспек-

тов разложений МДП. Известным методом вычисления разложений по сингулярным

числам МДП является алгоритм чередующихся условных математических ожида-

ний (ACE) (см. оригинальный алгоритм в контексте параметрической регрессии

в [57] и его вариант в контексте выделения признаков и понижения размерности

в [58]). По сути, алгоритм ACE использует степенной метод, или, в более общем

виде, метод ортогональных итераций (см. [59, п. 7.3.2; 60, п. 4.4.3; 61, п. 4.4]), для

оценки сингулярных векторов МДП. Оказывается, что такие сингулярные векторы,

соответствующие наибольшим сингулярным числам, можно выделять как “более ин-

формативные” функции вклада. Этот подход был использован в [62] для получения

результатов о скрытых марковских моделях в контексте обработки изображений,

a в [63] он был описан как средство универсального выделения признаков. В работах

[61, п. 4.5; 63] можно найти дальнейшие подробности о связях между разложения-

ми по сингулярным числам МДП и другими известными понятиями в статистике и

машинном обучении, такими как метод главных компонент [64, 65], анализ кано-

нической корреляции [66] и отображения диффузии [67].

После того как мы ввели необходимые нам коэффициенты сжатия, приведем

теперь несколько свойств коэффициентов сжатия для f-дивергенций; многие из них

хорошо известны либо легко доказываются, но некоторые, насколько нам известно,

ранее в литературе не встречались.

Предложение

3 (свойства коэффициентов сжатия совместных распределе-

ний). Коэффициент сжатия для f-дивергенции обладает следующими свойства-

ми:

1. (Нормировка): Для любой совместной вероятностной меры PX,Y , состоящей

из PX ∈ PX и PY|X ∈ PY|X , выполнено 0 ≤ ηf (PX, PY|X) ≤ 1;

2. (Независимость): Рассмотрим случайные величины X и Y с совместной вероят-

ностной мерой PX,Y , состоящей из PX ∈ PX и PY|X = W ∈ PY|X . Если X и Y

независимы, т.е. W имеет единичный ранг, то ηf (PX, PY|X) = 0. Наоборот,

если f строго выпукла в единице и ηf (PX , PY|X ) = 0, то X и Y независимы;

3. (Разложимость): Рассмотрим произвольную совместную вероятностную меру

PX,Y , маргинальные вероятностные меры которой таковы, что PX ∈ P◦X и

PY ∈ P◦Y, и пусть f дважды дифференцируема в единице, причем f′′(1) > 0. Если

мера PX,Y разложима, то ηf (PX, PY|X) = 1. Наоборот, если f также строго

выпукла, f(0) < ∞ и ηf (PX , PY|X ) = 1, то PX,Y разложима. (Это свойство

описано в теореме 1 в п. 3.1, где также определено понятие “разложимости”.)

4. (Выпуклость [8, предложение III.3]): Для любой фиксированной PX ∈ P◦X функ-

ция PY|X ∋ PY|X → ηf (PX , PY|X ) выпукла по стохастической матрице PY|X ;

5. (Тензоризация [8, теорема III.9]): Если f порождает субаддитивную и однород-

ную f-энтропию (где f-энтропия любой неотрицательной случайной величи-

ны Z, такой что E[f(Z)] < ∞, определяется как Entf (Z) ≜ E[f(Z)] - f(E[Z]),

см. [8, § II]), и при этом

{

}

и PYi ∈ P◦ при i ∈ {1,...,n}Y

PXi,Yi : PXi ∈ PXi

i

- независимые совместные вероятностные меры, то

(

)

ηf

PXn

,PYn

= max

1

1

|Xn1

ηf (PXi , PYi |Xi),

1≤i≤n

где Xn1 = (X1, . . . , Xn) и Yn1 = (Y1, . . . , Yn);

14

6. (Субмультипликативность): Если U → X → Y - дискретные случайные величи-

ны с конечным числом значений, образующие цепь Маркова, то

ηf (PU , PY|U ) ≤ ηf (PU , PX|U )ηf (PX, PY|X).

При этом для любой фиксированной совместной вероятностной меры PX,Y ,

такой что X - не постоянная п.н., справедливо

ηf (PU , PY|U

)

ηf (PX, PY|X) =

sup

,

PU|X : U→X→Y

ηf (PU , PX|U )

ηf (PU ,PX|U )>0

где супремум берется по всевозможным конечным множествам значений U

случайной величины U и по всем условным распределениям PU|X ∈ PU|X , таким

что U → X → Y образуют цепь Маркова;

7. (Нижняя граница максимальной корреляции [1, теорема 5; 8, теорема III.3; 7,

теорема 2]): Рассмотрим произвольную совместную вероятностную меру PX,Y ,

маргинальные вероятностные меры которой таковы, что PX ∈ P◦X и PY ∈ P◦Y .

Если f дважды дифференцируема в единице и f′′(1) > 0, то

ηχ2 (PX, PY|X) = ρ(X; Y )2 ≤ ηf (PX, PY|X).

(Усиление этого свойства приведено в теореме 2 в п. 3.1.)

В Приложении B приведены некоторые доказательства, а также соответству-

ющие ссылки, уточняющие эти результаты. Теперь сделаем несколько замечаний.

Во-первых, насколько нам известно, п. 3 предложения ранее не появлялся в литера-

туре в такой общности; были известны лишь случаи ηχ2 и ηKL (см. [13,15]).

Во-вторых, так как пп. 1-3 предложения 3 показывают, что коэффициенты сжа-

тия являются нормализованными мерами статистической зависимости между слу-

чайными величинами, можно рассматривать субмультипликативность из п. 6 как

мета-СНОД для коэффициентов сжатия по аналогии с (16). На самом деле, п. 6

также показывает, что коэффициентом сжатия в СНОД для ηf является сама ве-

личина ηf . Этот аспект пункта 6, хотя и довольно простой, также, насколько нам

известно, никогда в явном виде не встречался в литературе в такой степени общно-

сти; лишь случай ηχ2 был представлен в [68, лемма 6].

В-третьих, вариант неравенства об обработке данных для ηKL, приведенный в [15]

(см. также [5, п. II-A]) справедлив и для общих ηf . Действительно, если U

→

→ X → Y → V - дискретные случайные величины с конечными множествами

значений, образующие цепь Маркова, то немедленным следствием пп. 1 и 6 предло-

жения 3 является следующее свойство монотонности:

ηf (PU , PV|U ) ≤ ηf (PX, PY|X).

(27)

В-четвертых, нижняя грань максимальной корреляции в п. 7 предложения 3 до-

стигается. Например, пусть f(t) = t log(t), и рассмотрим две равномерные бернулли-

евские случайные величины (X, Y ) с PX = (1/2, 1/2) и с условным распределением

PY|X, заданным матрицей “двоичного симметричного канала”

0

1

[

]

1-α α

PY|X =0

,

(28)

1

α

1-α

где α ∈ [0, 1] - вероятность ошибки в канале. В [15] доказано, что в этом случае

нижняя грань максимальной корреляции выполнена с равенством:

ηKL(PX, PY|X) = ηχ2(PX, PY|X) = (1 - 2α)2,

(29)

15

где ηχ2 (PX , PY|X ) = (1 - 2α)2 можно легко вычислить с помощью характеризации

максимальной корреляции через сингулярные числа из предложения 2. Еще один

пример: пусть PY|X = Eβ ∈ PX∪{e}|X -матрица “|X |-ичного канала со стиранием”

с вероятностью стирания β ∈ [0, 1] и символом стирания e:

X

e

Eβ =

X

[

(1 - β)I β1 ],

(30)

где I ∈ R|X|×|X| - единичная матрица, а 1 ∈ R|X| - вектор-столбец из всех единиц.

Непосредственной проверкой легко убедиться, что

Df (RXEβ ∥PXEβ) = (1 - β) × Df(RX ∥PX)

для любых RX , PX ∈ PX . Поэтому для любой вероятностной меры на входе PX ∈ PX

и любой f-дивергенции имеем ηf (PX , PY|X ) = 1 - β.

Наконец, отметим, что хотя п. 7 предложения 3 был независимо доказан авто-

рами ранее в [1, теорема 5] с помощью идеи аппроксимации f-дивергенции, эта же

идея использовалась в [8, теорема III.3; 7, теорема 2] для доказательства этого ре-

зультата. Кроме того, эта идея вытекает из доказательства теоремы 5.4 работы [17]

(приведенной далее в п. 6 предложения 5).

2.3. Коэффициенты эргодичности. Прежде чем перейти к обсуждению коэффи-

циентов сжатия, зависящих только от стохастических матриц, вкратце опишем бо-

лее общее понятие коэффициентов эргодичности. Впервые они возникли в контексте

изучения эргодичности и скоростей сходимости неоднородных (по времени) цепей

Маркова с конечными пространствами состояний (см. [69, § 1]). Они определяются

следующим образом.

Определение 4 (коэффициент эргодичности [16, определение 4.6]). Коэффи-

циентом эргодичности называется непрерывная скалярная функция η : PY|X →

→ [0, 1], где PY|X имеет фиксированную размерность (и снабжено стандартной то-

пологией, индуцированной нормой Фробениуса). Этот коэффициент называется соб-

ственным, если для любого W ∈ PY|X равенство η(W) = 0 выполнено тогда и толь-

ко тогда, когда W = 1PY для некоторой вероятностной меры PY ∈ PY (т.е. W имеет

единичный ранг).

Полезным свойством собственных коэффициентов эргодичности является взаи-

мосвязь со слабой эргодичностью. Рассмотрим последовательность стохастических

по строкам матриц {Wk ∈ PX|X : k ∈ N}, задающих неоднородную цепь Маркова

на пространстве состояний X . Введем обозначение для последовательного произве-

дения этих матриц в количестве r ≥ 1, начиная с номера p ∈ N:

∏

T(p,r) ≜

Wp+i.

(31)

i=0

Цепь Маркова {Wk ∈ PX|X : k ∈ N} называется слабо эргодической (в смысле

Колмогорова), если для всех x1, x2, x3 ∈ X и всех p ∈ N [16, определение 4.4]

(

)

lim

= 0.

(32)

[T(p,r)]x1,x3 - [T(p,r)]x2,x3

r→∞

Это определение формализует интуитивное представление, что для эргодической це-

пи Маркова строки таких произведений должны становиться равными при r → ∞.

(Отметим, что если предельная строка стохастической матрицы lim

T(p,r) суще-

r→∞

ствует для всех p ∈ N, то цепь Маркова называется сильно эргодической [16, опре-

деление 4.5].) В следующем предложении утверждается, что слабую эргодичность

16

можно эквивалентным образом определить через собственные коэффициенты эрго-

дичности.

Предложение 4 (слабая эргодичность [16, лемма 4.1]). Пусть η: PX|X →

→ [0, 1] - собственный коэффициент эргодичности. Тогда неоднородная цепь Мар-

кова {Wk ∈ PX|X : k ∈ N} слабо эргодична тогда и только тогда, когда

∀p ∈ N, lim

η(T(p,r)) = 0.

r→∞

Чтобы пояснить интуитивный смысл этого результата, заметим, что для слабо

эргодической цепи Маркова T(p,r) становится (приблизительно) матрицей единич-

ного ранга при r → ∞. Таким образом, следует ожидать, что lim

η(T(p,r)) = 0,

r→∞

поскольку собственный коэффициент эргодичности непрерывен и равен нулю, ко-

гда его аргумент имеет единичный ранг. Формальное доказательство предложения 4

можно найти в [16, лемма 4.1]. О дальнейшем развитии подобных идей см. работы

[69; 16, гл. 3 и 4; 70; 71, гл. 3] и библиографию в них.

Одним из первых и наиболее примечательных примеров собственных коэффи-

циентов эргодичности являются коэффициенты сжатия Добрушина5. Для заданной

стохастической по строкам матрицы PY|X = W ∈ PY|X ее коэффициент сжатия

Добрушина определяется как константа Липшица отображения PX ∋ PX → PX W

относительно ℓ1-нормы (или расстояния по вариации) [14]:

∥RXW - PXW∥TV

ηTV(W) ≜ sup

=

(33)

RX,PX ∈PX

∥RX - PX∥TV

RX=PX

= max

∥vW∥1 =

(34)

v∈(R|X|)∗

∥v∥1=1, v1=0

= max

∥RXW - PXW∥TV =

(35)

RX,PX ∈PX

= max

PY|X=x - PY|X=x′

=

(36)

TV

x,x′∈X

∑

{

}

= 1 - min

min

PY|X(y |x), PY|X(y |x′)

,

(37)

x,x′∈X

y∈Y

где различные эквивалентные характеризации (34), (35), (36) (двухточечная харак-

теризация Добрушина [14]) и (37) (характеризация аффинности [73; 29, форму-

ла (4.13)]) определения (33) можно либо найти в работе [16, гл. 4.3], либо легко

ввести из ее результатов. Формула (37) показывает, что ηTV(W) < 1 тогда и только

тогда, когда W является скремблирующей матрицей (т.е. никакие две строки W не

ортогональны) [16, c. 82]. (Из этого также следует, что ηTV(W ) < 1 тогда и только

тогда, когда пропускная способность с нулевой ошибкой для PY|X равна нулю [74].)

Вдобавок к свойствам собственных коэффициентов эргодичности величина ηTV

обладает также следующими свойствами:

1. Непрерывность по Липшицу [70, теорема 3.4, замечание 3.5]: Для любых V, W ∈

∈ PY|X справедливо неравенство |ηTV(V )-ηTV(W)| ≤ ∥V - W∥∞, где через ∥·∥∞

обозначена индуцированная ℓ∞-норма, или максимальная сумма модулей по стро-

ке применительно к матрице;

5 Следуя библиографической дискуссии в [16, с. 144-147], авторами коэффициента сжатия Доб-

рушина (или, эквивалентно, коэффициента эргодичности Добрушина) можно также считать (по

крайней мере, частично) Дёблина и Маркова. В литературе этот коэффициент встречался под

названием коэффициент сжатия Дёблина и возникал в лемме Маркова о сжатии (см., напри-

мер, [72, c. 619]).

17

2. Субмультипликативность [16, лемма 4.3]: Для любых V ∈ PX|U и W ∈ PY|X

справедливо неравенство ηTV(V W ) ≤ ηTV(V )ηTV(W );

3. Граница субдоминантного собственного числа [69, c. 584, формула (9)]: Для лю-

бой W ∈ PX|X неравенство ηTV(W) ≥ |λ| справедливо для любого субдоминант-

ного собственного числа λ = 1 матрицы W .

Благодаря двум последним свойствам ηTV становится удобным инструментом для

исследования неоднородных цепей Маркова. Как указано в [70, § 1], для однородной

цепи Маркова W ∈ PX|X со стационарной вероятностной мерой π ∈ PX хорошо из-

вестно, что модуль второго по абсолютной величине собственного значения матри-

цы W , обозначаемый через μ(W ), отвечает за скорость сходимости к стационарному

состоянию. Действительно, если μ(W) < 1, то μ(Wn) = μ(W)n, и lim Wn = 1π со

n→∞

скоростью, определяемой величиной μ(W ). Однако для неоднородной цепи Марко-

∏

ва в общем случае {Wk ∈ PX|X : k ∈ N}, μ(T(0,n)) =

μ(Wi), поскольку модуль

i=0

второго собственного числа не мультипликативен. Последние два свойства ηTV пока-

зывают, что эта величина является адекватной заменой модуля второго собственного

числа при изучении неоднородных цепей Маркова, поскольку

∏

μ(T(0,n)) ≤ ηTV(T(0,n)) ≤

ηTV(Wi).

i=0

2.4. Коэффициенты сжатия стохастических матриц. Коэффициенты сжатия сто-

хастических матриц для f-дивергенций образуют широкий класс коэффициентов

эргодичности. Они определяются аналогично формуле (33), но с использованием

других f-дивергенций вместо расстояния по вариации.

Определение 5 (коэффициент сжатия стохастической матрицы [14-17]). Для

любой стохастической матрицы PY|X = W ∈ PY|X ее коэффициент сжатия для

заданной f-дивергенции равен

Df(RXW ∥PXW)

ηf (PY|X) ≜

sup

= sup ηf (PX, PY|X),

RX,PX ∈PX

Df(RX ∥PX)

PX∈PX

0<Df (RX ∥PX )<+∞

где супремум берется по всем вероятностным мерам RX и PX , таким что 0 <

< Df(RX ∥PX) < +∞. Если при этом Y постоянна п.н., то по определению полагаем

ηf (PY|X) = 0.

Из этого определения немедленно вытекают СНОД для коэффициентов сжатия

стохастических матриц, аналогичные неравенствам (15) и (16). Кроме того, для ко-

эффициентов сжатия стохастических матриц также справедлив вариант предложе-

ния 1. Действительно, из определения 5 и предложения 1, получаем, что для любой

стохастической матрицы PY|X ∈ PY|X и любой выпуклой дифференцируемой функ-

ции f : (0, ∞) → R с равномерно ограниченной производной в некоторой окрестности

единицы, такой что f(1) = 0, справедливо

If (U; Y )

ηf (PY|X) =

sup

,

(38)

PU,X : U→X→Y

If (U; X)

0<If (U;X)<+∞

где супремум берется по всем совместным вероятностным мерам PU,X (состоящим

из PU ∈ PU и PX|U ∈ PX|U ) и конечным алфавитам U случайной величины U,

такой что U → X → Y образуют цепь Маркова. Частный случай этого результата

для КЛ-дивергенции можно найти в [75, c. 345, задача 15.12] (случай конечного

алфавита) и [7] (общий случай).

18

Имеется два важных примера коэффициентов сжатия стохастических матриц:

коэффициент сжатия Добрушина для расстояния по вариации (определенный в (33))

и коэффициент сжатия для КЛ-дивергенции. Как и выше, для заданной PY|X ∈

∈ PY|X обозначаем через ηTV(PY |X), ηKL(PY |X), и ηχ2(PY |X) коэффициент сжатия

PY|X для расстояния по вариации, КЛ-дивергенции и χ2-дивергенции соответствен-

но. В [15] доказано, что для любой стохастической матрицы PY|X ∈ PY|X верно

равенство

ηKL(PY|X) = ηχ2 (PY|X).

(39)

Таким образом, при изучении коэффициентов сжатия стохастических матриц не

требуется рассматривать ηKL и ηχ2 по отдельности. Заметим, что альтернативное

доказательство равенства (39) (справедливое для общих измеримых пространств)

дано в [7, теорема 3]. Кроме того, менее известное наблюдение состоит в том, что

правильное обобщение на произвольную размерность техники доказательства из [76,

лемма 1, теорема 1] (где аналитически вычисляется ηKL для любой стохастической

матрицы размера 2 × 2) также позволяет доказать равенство (39). Следует отме-

тить, что основным результатом работы [76] является индуктивный подход к оцен-

ке сверху для ηKL в байесовских сетях (или направленных ациклических графах).

Суть этого подхода прекрасно изложена в [7], где также приведены доказательства

его обобщения на расстояние по вариации (с помощью представления Гольдштейна

расстояния по вариации между двумя совместными распределениями через одно-

временное максимальное склеивание [77]) и описана его связь с задачей перколяции

узлов.

Теперь перечислим некоторые известные свойства коэффициентов сжатия стоха-

стических матриц.

Предложение 5 (свойства коэффициентов сжатия стохастических матриц).

Коэффициент сжатия для f-дивергенции обладает следующими свойствами:

1. (Нормировка): Для любой стохастической матрицы PY|X ∈ PY|X справедливо

неравенство 0 ≤ ηf (PY|X) ≤ 1;

2. (Независимость [17, § 4]): Рассмотрим стохастическую матрицу PY|X ∈ PY|X .

Если PY|X имеет единичный ранг, т.е. X и Y независимы, то ηf (PY|X ) = 0.

Наоборот, если f строго выпукла в единице и ηf (PY|X ) = 0, то PY|X имеет

единичный ранг;

3. (Скремблирование [17, теорема 4.2]): Для заданной стохастической матрицы

PY|X ∈ PY|X матрица PY|X является скремблирующей тогда и только тогда,

когда ηf (PY|X ) < 1;

4. (Выпуклость [17, § 4; 8, предложение III.3]): Функция PY|X ∋ PY|X → ηf (PY|X)

выпукла;

5. (Субмультипликативность [17, § 4]): Если U → X → Y

- дискретные случай-

ные величины с конечными множествами значений, образующие цепь Маркова,

т.е. стохастические матрицы условных распределений таковы, что PY|U =

= PX|UPY |X, то

ηf (PY|U ) ≤ ηf (PX|U )ηf (PY|X);

6. (Нижняя граница χ2-дивергенции [17, теорема 5.4; 19, предложение II.6.15]): Рас-

смотрим стохастическую матрицу PY|X ∈ PY|X . Если f дважды дифференци-

руема в единице и f′′(1) > 0, то

ηχ2 (PY|X) ≤ ηf (PY|X);

19

7. (Верхняя граница расстояния по вариации [17, теорема 4.1; 19, предложение

II.4.10]): Для любой стохастической матрицы PY|X ∈ PY|X справедливо нера-

венство

ηf (PY|X) ≤ ηTV(PY|X).

Доказательства этих результатов мы опускаем, поскольку они либо аналогич-

ны соответствующим доказательствам в предложении 3, либо даны в указанных

ссылках. Пункты 1, 2 и 4 предложения 5 означают, что коэффициенты сжатия сто-

хастических матриц для f-дивергенций часто являются собственными коэффициен-

тами эргодичности. (Действительно, из выпуклости отображения PY|X → ηf (PY|X )

в п. 4 предложения 5 следует, что это отображение непрерывно на внутренней об-

ласти PY|X .) Заметим, что п. 3 показывает, что ηf (PY|X ) = 1 тогда и только тогда,

когда ηTV(PY|X ) = 1 [17, теорема 4.2], и непосредственной проверкой легко убе-

диться, что ηf (PY|X ) = 1 тогда и только тогда, когда пропускная способность при

нулевой ошибке для PY|X строго положительна [74]. Отметим также, что результат

об экстремальном значении, аналогичный п. 6 предложения 3, хотя и менее содер-

жательный, можно вывести из п. 5 предложения 5.

В то время как соотношение (39) показывает, что в п. 6 предложения 5 легко

может достигаться равенство, неравенство в п. 7 часто бывает строгим. Например,

когда PY|X = W - стохастическая матрица размера 2 × 2 с параметрами a, b ∈ [0, 1]

[

]

1-a a

W =

,

(40)

b

1-b

непосредственной проверкой легко убедиться, что ηKL(PY|X ) ≤ ηTV(PY|X ), где нера-

венство обычно бывает строгим, поскольку

(√

√

)2

ηKL(PY|X) = 1 -

a(1 - b) +

b(1 - a)

,

(41)

ηTV(PY|X) = |1 - a - b|,

(42)

где равенство (41) доказано в [76, теорема 1], а (42) легко получить с помощью (36).

Более того, в частном случае, где PY|X имеет вид (28), получаем [15]

ηKL(PY|X) = (1 - 2α)2 ≤ |1 - 2α| = ηTV(PY|X).

(43)

С другой стороны, как показано в конце п. 2.2, ηf (PY|X ) = 1 - β для любой f-ди-

вергенции, когда PY|X = Eβ ∈ PX∪{e}|X .

Ввиду п. 6 и равенства (39) естественно задаться вопросом, существуют ли другие

f-дивергенции, коэффициенты сжатия которых (для стохастических матриц) также

равны ηχ2 . Следующий результат из [18, теорема 1], обобщающий соотношение (39),

дает ответ на этой вопрос.

Предложение 6 (коэффициенты сжатия для операторно выпуклых f-дивер-

генций [18, теорема 1; 19]). Для любой нелинейной операторно выпуклой функции

f : (0,∞) → R, такой что f(1) = 0, и любой стохастической матрицы PY |X ∈

∈ PY|X справедливо равенство

ηf (PY|X) = ηχ2 (PY|X).

Доказательство теоремы 1 из [18] основано на элегантном интегральном пред-

ставлении операторно выпуклых функций (см. п. 6.1). Такие представления явля-

ются мощным инструментом для доказательства неравенств между коэффициен-

тами сжатия, и мы воспользуемся ими для обобщения предложения 6 в п. 3.4. На

20

самом деле, п. 7 предложения 5 также можно доказать с помощью интегрального

представления (см. [8, теорема III.1]).

В заключение этого пункта укажем на дополнительный обзор по коэффициентам

сжатия [7, § 2], где, в частности, имеются ссылки на различные приложения этих

идей в существующей литературе.

§ 3. Основные результаты и их обсуждение

В настоящей статье мы в основном будем сравнивать между собой различные

коэффициенты сжатия. В частности, мы будем интересоваться следующими основ-

ными вопросами:

1.

Когда коэффициенты сжатия совместных распределений достигают своей

верхней границы, равной единице? В теореме 1 (п. 3.1) мы покажем, что это про-

исходит, когда совместные распределения разложимы.

2.

Можно ли достичь нижней границы максимальной корреляции из п. 7 пред-

ложения 3 путем наложения дополнительных ограничений в экстремальной

задаче, определяющей коэффициенты сжатия совместных распределений? Да,

можно потребовать, чтобы f-дивергенция на входе была малой, как показано

в теореме 2 (п. 3.1).

3.

Обычно мы оцениваем ηKL(PX, PY|X) снизу через ηχ2(PX, PY|X) (предложение 3,

п. 7), а сверху - через ηTV(PY|X) (предложение 5, п. 7). Существует ли простая

верхняя граница на ηKL(PX, PY|X) через ηχ2 (PX, PY|X)? Да, две такие границы

приведены в следствии 1 и теореме 4 в п. 3.2.

4.

Можно ли обобщить эту верхнюю границу для КЛ-дивергенции на другие f-ди-

вергенции? Да, более общая граница представлена в теореме 3 (п. 3.2).

5.

Когда X и Y совместно гауссовские, с помощью характеризации взаимной ин-

формации, данной в (18), можно установить [2, теорема 7], что

ηKL(PX, PY|X) = ηχ2(PX, PY|X).

Существует ли простое доказательство этого результата, опирающееся непо-

средственно на определение ηKL? Выполняется ли это равенство, если на-

ложить дополнительное ограничение по мощности в экстремальной задаче

для ηKL? Да, в п. 3.3 мы рассмотрим гауссовский случай, и в теореме 5 дока-

жем это равенство для ηKL с ограничением по мощности. Наше доказательство

также устанавливает это известное равенство с помощью определения ηKL через

КЛ-дивергенцию.

6.

Коэффициенты сжатия стохастических матриц тесно связаны с предпорядком

меньшего искажения на стохастических матрицах [7, § 6]. Можно ли обобщить

результат предложения 6 и получить новые сведения о предпорядке меньше-

го искажения? Да, в п. 3.4 мы вводим предпорядок меньшего искажения, и в

теореме 6 получаем целый класс его эквивалентных характеризаций. Мы также

приводим пример применения теоремы 6 в теореме 7, обобщающей СНОД Само-

родницкого.

Границы, которые мы выведем в ответ на вопросы 3-5, имеют вид верхней границы в

ηχ2 (PX, PY|X) ≤ ηf (PX, PY|X) ≤ Cηχ2 (PX, PY|X),

(44)

где первое неравенство - это просто нижняя граница максимальной корреляции из

п. 7 предложения 3, а константа C зависит от PX,Y и f; заметим, что C = 1 в по-

становке вопроса 5. Будем называть такие границы линейными границами между

коэффициентами сжатия совместных распределений. Наши основные результаты

сформулированы в нескольких следующих пунктах.

21

3.1. Свойства коэффициентов сжатия совместных распределений. В этом пункте,

как и в п. 3.2, мы будем предполагать, что заданы случайные величины X ∈ X и

Y ∈ Y с совместной вероятностной мерой PX,Y , состоящей из PX ∈ PX и PY |X =

= W ∈ PY|X, причем маргинальные вероятностные меры таковы, что PX ∈ P◦X

и PY = PXW ∈ P◦Y. В этом пункте приведены два результата. В первом из них

переформулирован п. 3 предложения 3.

Начнем с необходимого определения: совместная вероятностная мера PX,Y назы-

вается разложимой, если существуют функции h: X → R и g: Y → R, такие что

h(X) = g(Y ) п.н. и Var(h(X)) > 0, где через Var(·) обозначена дисперсия. Эквива-

лентным образом, PX,Y разложима тогда и только тогда, когда неориентированный

двудольный граф с непересекающимися множествами вершин X и Y и множеством

ребер {(x, y) ∈ X × Y : PY|X (y | x) > 0} имеет две или более компоненты связно-

сти (см. [15, § 1]). Эта комбинаторная характеризация разложимости имеет место,

поскольку h и g существуют тогда и только тогда, когда матрица W имеет блочно-

диагональную структуру после соответствующей перестановки ее строк и столбцов

(где блоки определяются множествами прообразов h и g), и эти блоки соответствуют

компонентам связности ассоциированного двудольного графа.

С помощью понятия разложимости можно описать, когда коэффициенты сжатия

совместных распределений равны единице.

Теорема 1 (свойство разложимости). Пусть задана дважды дифференцируе-

мая в единице выпуклая функция f : (0, ∞) → R, такая что f(1) = 0 и f′′(1) > 0.

Тогда справедливо следующее:

1. Если PX,Y разложима, то ηf (PX, PY|X) = 1;

2. Если f строго выпукла и удовлетворяет условию f(0) = lim f(t) < ∞, то из

t→0+

равенства ηf (PX , PY|X ) = 1 следует, что PX,Y разложима.

Теорема 1 доказана в Приложении C. Как отмечалось выше, этот результат был

ранее известен только для случаев ηχ2 и ηKL [13, 15]. Заметим также, что в слу-

чае ηf (PX , PY|X ) = 1 можно проверить, что пропускная способность при нулевой

ошибке для PY|X строго положительна [74].

Наш второй результат - уточнение п. 7 предложения 3, он показывает, что при

стремлении f-дивергенции на входе к нулю общие коэффициенты сжатия превра-

щаются в коэффициенты сжатия для χ2-дивергенции.

Теорема 2 (локальная аппроксимация коэффициентов сжатия). Пусть дана

выпуклая функция f : (0, ∞) → R, строго выпуклая в единице и дважды дифферен-

цируемая в единице, такая что f(1) = 0 и f′′(1) > 0. Тогда

Df (RXW ∥PXW)

ηχ2 (PX, PY|X) = lim

sup

δ→0+

Df (RX ∥PX)

RX∈PX

0<Df (RX ∥PX )≤δ

Доказательство приведено в Приложении D; заметим, что частный случай тео-

ремы 2 для КЛ-дивергенции был представлен вместе с наброском доказательства

в [1, теорема 3]. Теперь уместно сделать несколько замечаний. Во-первых, отметим,

что в доказательстве п. 7 предложения 3 в Приложении B (как и в независимых

доказательствах в [8, теорема III.2] и [7, теорема 2]) уже содержится идея о том, что

оптимизация ηf (PX , PY|X ) по локальным возмущениям PX дает ηχ2(PX , PY|X ) в си-

лу (14) и (25). Однако это доказательство (с незначительными видоизменениями)

показывает лишь, что величина ηχ2 (PX , PY|X ) ограничена сверху правой частью ра-

венства из теоремы 2. Хотя интуитивно может быть и ясно, что эта верхняя грани

достигается с равенством, формальное доказательство содержит несколько техни-

ческих деталей, как показано в Приложении D.

22

Во-вторых, теорема 2 очевидным образом показывает, что нижняя граница мак-

симальной корреляции в п. 7 предложения 3 может быть достигнута, когда в задаче

оптимизации для ηf (PX , PY|X ) наложено дополнительное ограничение, что f-ди-

вергенция на входе мала. Поэтому из теоремы 2 вытекает нижняя граница мак-

симальной корреляции. Эта идея оказалась важна при сравнении ηχ2 (PX , PY|X )

и ηKL(PX, PY|X) в статистическом контексте [78, с. 5].

В-третьих, теорему 2 можно рассматривать как минимаксную характеризацию

ηχ2 (PX, PY|X), поскольку супремум отношения f-дивергенций является невозраста-

ющей функцией δ, и поэтому предел (при δ → 0+) можно заменить на инфимум (по

всем δ > 0).

В-четвертых, при выполнении условий предложения 1 и теоремы 2 непосред-

ственной проверкой легко убедиться, что

If (U; Y )

ηχ2 (PX, PY|X) = lim

sup

,

(45)

δ→0+ PU|X : U→X→Y

If (U; X)

0<If (U;X)≤δ

где супремум берется по всем стохастическим матрицам PU|X ∈ PU|X , таким что

U = {0,1}, U ∼ Bernoulli(1/2) и U → X → Y образуют цепь Маркова. Таким об-

разом, ограничение на малость f-дивергенции на входе в определении ηf (PX , PY|X )

через f-дивергенцию соответствует условиям малой If (U; X) и U ∼ Bernoulli(1/2)

в (45).

Наконец, рассмотрим траекторию вероятностных мер на входе

(√

)

R(ε)X = PX + εK∗X diag

PX

,

(

где ε > 0 достаточно мало, а K∗X ∈

R|X|)∗ - левый сингулярный вектор, соответ-

ствующий второму по величине сингулярному числу МДП B (см. (25)). Как по-

казывает доказательство в Приложении D, эта траектория удовлетворяет условию

(

)

lim

Df

R(ε)X ∥PX

= 0 и достигает значения ηχ2(PX,PY |X) в теореме 2:

ε→0

(

)

Df

R(ε)W∥PXW

X

lim

(

)

= ηχ2 (PX , PY |X

).

(46)

ε→0

Df

R(ε)

∥PX

X

Соответствующей траекторией условных распределений для (45) является P(ε)X|U ∈

∈ PX|U со строками

{

}

(√

)

P(ε)X|U=u = PX + (2u - 1)εK∗X diag

PX

: u ∈ {0,1} ,

где ε > 0 достаточно мало. Эта траектория удовлетворяет условию

lim

If (U; X(ε)) = 0

ε→0

и достигает значения ηχ2 (PX , PY|X ) в (45):

If (U; Y(ε))

lim

= ηχ2 (PX , PY |X ),

(47)

ε→0 If (U; X(ε))

где U ∼ Bernoulli(1/2), U → X(ε) → Y(ε) - случайные величины, образующие цепь

(

)

Маркова с совместной вероятностной мерой

PU , P(ε)X|U , PY|X

, P(ε)Y|U

= P(ε)X|UPY|X,

а маргинальная вероятностная мера для X(ε) равна PX .

23

3.2. Линейные границы между коэффициентами сжатия. Напомним, что мы рас-

сматриваем заданную совместную вероятностную меру PX,Y с маргинальными ве-

роятностными мерами PX ∈ P◦X и PY ∈ P◦Y . Наш следующий результат описывает

линейную верхнюю границу на ηf (PX , PY|X ) через ηχ2 (PX , PY|X ) для определенного

класса f-дивергенций.

Теорема

3

(граница на коэффициенты сжатия). Пусть задана выпуклая

функция f : (0, ∞) → R, трижды дифференцируемая в единице, такая что f(1) = 0,

f′′(1) > 0 и f(0) < ∞, удовлетворяющая условию (75) для любого t ∈ (0,∞)

(см. п. 4.1). Предположим также, что разностное отношение g : (0, ∞) → R, опре-

f(t) - f(0)

деляемое как g(t) =

, выпукло вверх. Тогда

t

f′(1) + f(0)

ηf (PX, PY|X) ≤

ηχ2 (PX, PY|X).

f′′(1)minPX(x)

x∈X

Теорема 3 доказана в п. 4.2. Условия на f гарантируют, что получаемая f-дивер-

генция обладает свойствами КЛ-дивергенции, требуемыми в доказательстве теоре-

мы 4 (см. ниже). Таким образом, аналогичная техника доказательства работает и

для теоремы 3. Непосредственным частным случаем для КЛ-дивергенции, впервые

доказанным в [1, теорема 10], является

Следствие 1 (граница на КЛ-коэффициенты сжатия [1, теорема 10]). Спра-

ведливо неравенство

)

ηχ2 (PX, PY|X

ηKL(PX, PY|X) ≤

minPX(x)

x∈X

Следствие 1 можно вывести из теоремы 3, убедившись, что функция f(t) =

= tlog(t) удовлетворяет условиям теоремы 3 (см. [79]). Подробное доказательство

см. в Приложении E. Константу в верхней границе на ηKL(PX , PY|X ) из следствия 1

можно улучшить, как показывает следующая

Теорема 4 (улучшенная граница на КЛ-коэффициенты сжатия). Справедливо

неравенство

)

2ηχ2 (PX , PY|X

ηKL(PX, PY|X) ≤

(

)

,

ϕ maxmin{PX (A), 1 - PX (A)} minPX(x)

A⊆X

x∈X

где функция ϕ: [0, 1/2] → R определена в (68) (см. п. 4.1).

Теорема 4 также доказана в п. 4.2, и в силу соотношения (70) в п. 4.1 эта граница

точнее, чем граница из следствия 1. Теперь уместно сделать несколько замечаний

по поводу следствия 1 и теорем 3 и 4.

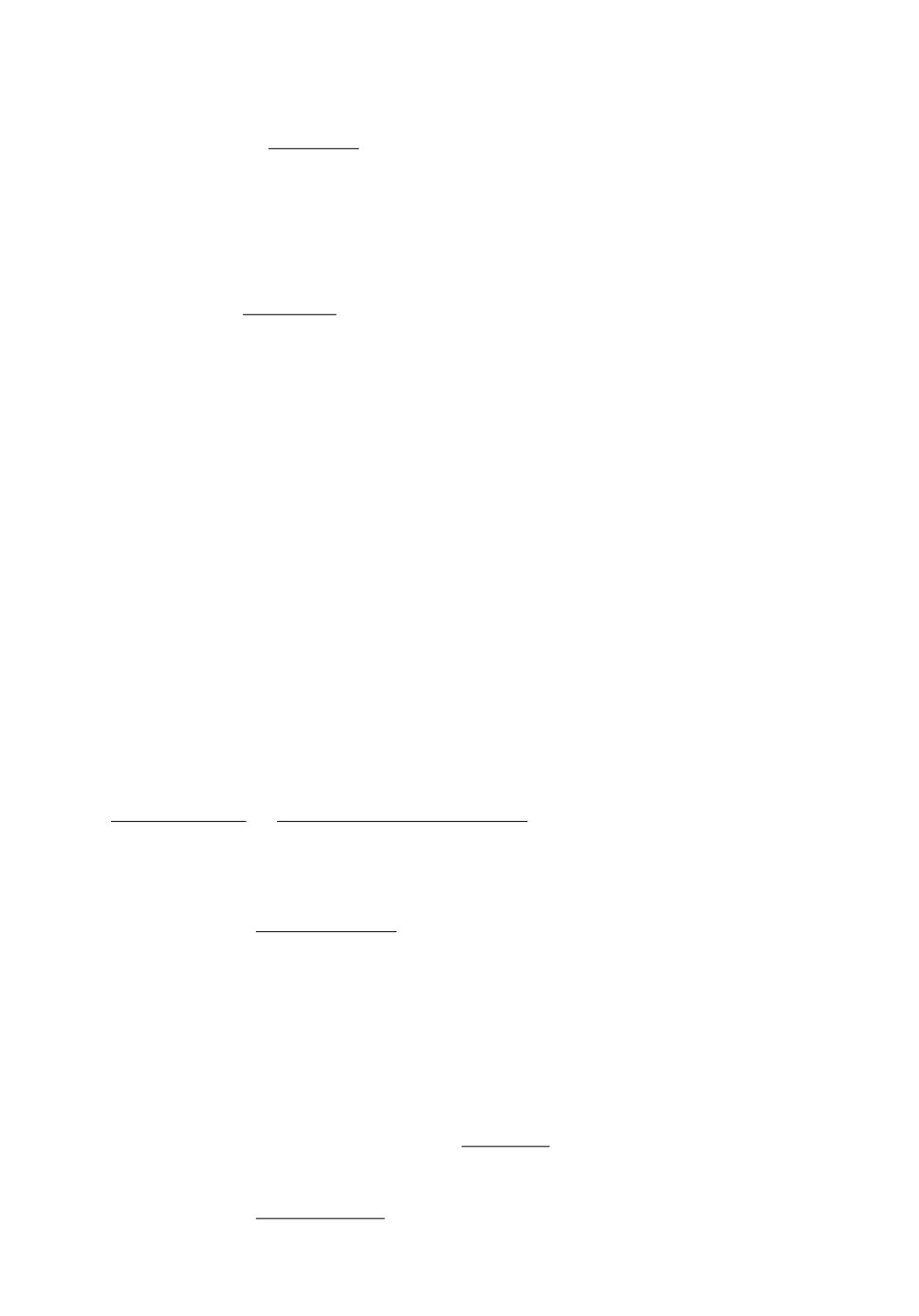

Во-первых, как показано на рис. 1a, верхние границы из этих утверждений мо-

гут быть строго меньше тривиальной верхней границы, равной единице. Например,

когда (X, Y ) - равномерные бернуллиевские случайные величины с PX = (1/2, 1/2)

и PY |X, описанные в (28), для некоторого α ∈ [0,1] (что соответствуетсечению вдоль

PX(1) = 1/2 на рис. 1a), верхние границы из следствия 1 и теоремы 4 обе равны

2ηχ2 (PX , PY|X )

ηχ2 (PX, PY|X)

(

)

=

= 2(1 - 2α)2,

(48)

minPX(x)

ϕ maxmin{PX (A), 1 - PX (A)} minPX(x)

x∈X

A⊆X

x∈X

24

1

0,8

0,6

1

0,4

0,8

0,2

0,6

0,4

0

0

0,2

PX(1)

0,1

0,2

0,3

0,4

0,5

0,6

0,7

0,8

0

0,9

1

α

(a) Графики функций ηχ2 (PX , PY |X ) (нижняя сетка), ηKL(PX , PY |X ) (вторая снизу) и

линейных верхних границ на ηKL(PX, PY |X). Верхняя сетка соответствует верхней границе

из следствия 1, а вторая сверху - более точной верхней границе из теоремы 4.

8

7

6

5

4

3

2

1

1

0,8

0

0,6

0,4

0

0,1

0,2

0,3

0,4

0,5

0,2

0,6

0,7

α

0,8

0,9

1

0

PX(1)

(b) Графики верхних границ на отношение ηKL(PX, PY |X)/ηχ2 (PX, PY |X), соответству-

ющее нижней сетке. Границе 1/ min PX(x) из следствия 1 соответствует верхняя сетка,

x∈X

( (

)

)

а более точной границе 2/ ϕ maxmin{PX (A), 1 - PX (A)} min PX (x) из теоремы 4 -

A⊆X

x∈X

вторая сверху.

Рис. 1. Графики границ на коэффициенты сжатия из следствия 1 и теоремы 4 для

двух бернуллиевских случайных величин (X, Y ) с совместной вероятностной мерой,

состоящей из PX = (PX (0), PX (1)) и PY |X , заданных в (28), для вероятности пере-

хода в канале α ∈ [0, 1].

что следует из (29) и того факта, что

1

maxmin{PX (A), 1 - PX (A)} =

A⊆X

2

25

Эта верхняя граница точнее, чем тривиальная граница, равная 1, когда

√

√

2-

2

2+

2

2(1 - 2α)2 < 1

⇐⇒

<α<

(49)

4

4

Заметим также, что эта верхняя граница не достигается с равенством при таком

сценарии, поскольку (1-2α)2 = ηKL(PX , PY|X ) = ηχ2 (PX , PY|X ), как показано в (29).

Во-вторых, наши доказательства теорем 3 и 4 опираются на обобщения хорошо

известного неравенства Пинскера (или неравенства Чисара - Кемпермана - Кульба-

ка - Пинскера; см. [80, § V]), оценивающие сверху расстояние по вариации через

КЛ-дивергенцию и другие f-дивергенции. Таким образом, возникает естественный

вопрос: являются ли эти границы более точными, чем граница расстояния по вариа-

ции из п. 7 предложения 5? Как показывает следующий пример, в некоторых режи-

мах наши границы точнее. Пусть (X, Y ) - равномерные бернуллиевские случайные

величины с PX = (1/2, 1/2) и PY|X, заданными в (28), для некоторого α ∈ [0, 1]. То-

гда (48) задает верхние границы из следствия 1 и теоремы 4, и граница расстояния

по вариации имеет вид

ηKL(PX, PY|X) ≤ ηKL(PY|X) ≤ ηTV(PY|X) = |1 - 2α|

(50)

с учетом определения 5, п. 7 предложения 5 и соотношения (43). Следовательно,

наша граница (48) точнее, чем граница через ηTV, когда

1

1

1

3

2(1 - 2α)2 < |1 - 2α|

⇐⇒

<α<

или

<α<

(51)

4

2

2

4

Поскольку наши верхние границы могут быть больше единицы (см. (49)), мы не

можем надеяться превзойти границу через ηTV (≤ 1) во всех режимах. С другой

стороны, преимуществом наших верхних границ является то, что они “подходят” к

нижней границе через ηχ2 в п. 7 предложения 3; полезное применение этого будет

показано в п. 4.3.

В-третьих, интуитивно можно ожидать, что граница между коэффициентами

сжатия должна зависеть от мощности |X | или |Y|. Поскольку минимальная вероят-

ность во всех наших верхних границах соответствует 1/minPX(x) ≥ |X|, на первый

x∈X

взгляд можно было бы интерпретировать ее как “моделирующую” |X|. К сожалению,

эта интуитивная догадка неверна. Численные результаты, представленные графи-

чески на рис. 1b, показывают, что отношение

ηKL(PX, PY|X)/ηχ2 (PX, PY|X)

значительно увеличивается возле граничного значения PX , когда любая из компо-

нент PX близка к нулю. Этот эффект, хотя и неудивительный с учетом поведения

вероятностных симплексов в их граничных точках относительно КЛ-дивергенции

в качестве расстояния, адекватно учитывается верхними границами в следствии 1

и теореме 4, поскольку величина 1/minPX(x) возрастает, когда любая из компонент

x∈X

вероятностной меры на входе стремится к нулю (см. рис. 1b). Очевидно, линейные

верхние границы на ηf (PX, PY|X), выражаемые только через |X| или |Y|, этот эф-

фект отражать не могут. Это подтверждает необходимость присутствия минималь-

ной вероятности в наших линейных границах.

Наконец, заметим, что неравенство 1/minPX(x) ≥ |X| не препятствует возмож-

x∈X

ности того, что 1/ minPX(x) будет гораздо больше, чем |X|. Таким образом, при

x∈X

больших |X| наши границы могут стать слабыми (см. пример в п. 4.4). В результате

границы из теоремы 3, следствия 1 и теоремы 4, как правило, представляют интерес

в следующих случаях:

26

1.

|X | и |Y| малы: рис. 1 показывает, что наши границы могут быть весьма точными,

когда |X | = |Y| = 2;

2. Слабая зависимость, т.е. I(X; Y ) мала: такая ситуация естественным образом

возникает при анализе эргодичности цепей Маркова - см. п. 4.3;

3. Произведение распределений: если соответствующая совместная вероятностная

мера является произведением, можно использовать свойство тензоризации коэф-

фициентов сжатия (п. 5 предложения 3) - см. п. 4.4.

3.3. Коэффициенты сжатия совместно гауссовских случайных величин. В этом

пункте рассмотрим коэффициенты сжатия для КЛ- и χ2-дивергенций, соответству-

ющие двумерным гауссовским распределениям. Пусть X и Y - совместно гауссов-

ские случайные величины. Их совместное распределение имеет один из трех воз-

можных видов:

1. Величины X или Y постоянны п.н., и коэффициенты сжатия определяются как

ηKL(PX, PY|X) = ηχ2(PX, PY|X) = 0;

2. aX + bY = c п.н. для некоторых констант a, b, c ∈ R, таких что a = 0 и b = 0.

Тогда непосредственной проверкой легко убедиться, что ρ(X; Y )=1, откуда по-

лучаем ηKL(PX , PY|X ) = ηχ2 (PX , PY|X ) = 1, поскольку определения 3, (23) и п. 7

предложения 3 справедливы для общих случайных величин (см. [7, формулы (9)

и (13)]);

3. Существует совместная плотность распределения PX,Y относительно меры Ле-

бега на R2. Если X и Y независимы, то ηKL(PX, PY|X) = ηχ2(PX, PY|X) = 0,

поскольку п. 2 предложения 3 справедлив в общем случае. Поэтому будем пред-

полагать, что X и Y зависимы.

Нас будет интересовать последний невырожденный случай. Для простоты будем

также предполагать, что X и Y имеют нулевое среднее. Тогда совместное распре-

деление величин X и Y можно представить в “инновационном виде”: Y = γX + W

для некоторой константы γ = 0 и гауссовской случайной величины W с нулевым

средним и ненулевой дисперсией, не зависящей от X. Так как для любой плотности

распределения RX справедливо Df (RX ∥ PX ) = Df (RγX ∥ PγX ), то ηKL(PX , PY|X ) =