ЯДЕРНАЯ ФИЗИКА, 2022, том 85, № 6, с. 477-489

ЭЛЕМЕНТАРНЫЕ ЧАСТИЦЫ И ПОЛЯ

МЕТОДОЛОГИЯ ПРИМЕНЕНИЯ ГЛУБОКИХ НЕЙРОННЫХ СЕТЕЙ

В ПОИСКЕ “НОВОЙ ФИЗИКИ” НА КОЛЛАЙДЕРАХ

И СТАТИСТИЧЕСКАЯ ИНТЕРПРЕТАЦИЯ

ОЖИДАЕМЫХ РЕЗУЛЬТАТОВ

©2022 г. Э. Э. Абасов1)*, М. И. Белоброва1), П. В. Волков1), Г. А. Воротников1),

Л. В. Дудко1), А. Д. Заборенко1), М. А. Перфилов1), Е. С. Сивакова1)

Поступила в редакцию 01.07.2022 г.; после доработки 01.07.2022 г.; принята к публикации 02.07.2022 г.

В настоящей статье описываются методы применения нейронных сетей к поиску “новой физики” в

коллайдерных экспериментах. Рассмотрены механизмы отбора наблюдаемых, оптимизации гипер-

параметров, построения каскадов глубоких нейронных сетей. Приведены методы статистического

анализа дискриминантов нейронных сетей в пакетах theta и CombinedLimit с учетом различных

неопределенностей.

DOI: 10.31857/S0044002722060022

1. ФОРМУЛИРОВКА ЗАДАЧИ

процессов и на основании отклонений в сечении,

состояний поляризации или других наблюдаемых

Одними из важнейших задач современной фи-

свойств сделать заключение о возможном откло-

зики элементарных частиц являются проверка и

нении от предсказаний СМ. Существуют три под-

анализ предсказаний Стандартной модели (СМ).

хода при поиске “новой физики”. Первый под-

Создаваемые и существующие коллайдеры ТэВных

ход предполагает точное моделирование нужного

энергий призваны дать ответ о границах примени-

процесса в рамках конкретной теории и прямой

мости СМ и о том, какая “новая физика” может

поиск такого процесса. Второй подход основыва-

лежать за ее пределами. Современные статисти-

ется на модельно-независимом описании целого

ческие методы позволяют существенно повысить

класса теоретических моделей, параметризуемых

точность анализа данных, получаемых на коллай-

в рамках эффективной теории поля (EFT), или

дерах. В данной статье приведен краткий обзор

введении конкретных дополнительных членов в

методологии применения глубоких нейронных се-

лагранжиан взаимодействия. Третий подход фор-

тей при поиске “новой физики” в коллайдерных

мулируется в терминах поиска аномалий в дан-

экспериментах. Отклонения от предсказаний СМ

ных и является наименее точным и эффектив-

могут проявляться в виде рождения новых частиц,

ным, но активно обсуждается в настоящее время

резонансов, в рождении или распаде частиц СМ,

в контексте развития методов глубокого обучения

или в виде модификации характеристик взаимо-

и повышения их эффективности. В данной статье

действий частиц СМ. В первом случае примене-

мы сконцентрируемся на первых двух подходах

ние многомерных методов анализа обычно сво-

и в качестве примера рассмотрим задачу поис-

дится к подавлению процессов СМ и выделению

ка нейтральных токов, меняющих аромат кварков

новых процессов с рождением новых резонансов.

(Flavour Changing Neutral Currents — FCNC), во

Статистический анализ распределения характер-

взаимодействии топ-кварка с u- или c-кварком

ной наблюдаемой, например, инвариантной мас-

и глюоном (tqg FCNC). Модельно-независимое

сы продуктов распада нового резонанса дает воз-

теоретическое описание таких процессов может

можность количественно определить возможный

быть найдено в работе [1]. В рамках СМ такие

вклад “новой физики”. Второй случай предполага-

процессы сильно подавлены и увеличение сечения

ет аккуратный анализ характеристик определенных

этих процессов будет прямо свидетельствовать о

проявлении “новой физики”, параметризуемой в

1)Московский государственный университет имени

виде одного аномального параметра для каждого

М.В. Ломоносова, Научно-исследовательский институт

из взаимодействий tug и tcg. Моделирование таких

ядерной физики имени Д.В. Скобельцына, Москва,

Россия.

процессов проведено в пакете CompHEP [2, 3].

*E-mail: abasov.ee19@physics.msu.ru

Процессы СМ, приводящие к аналогичным сиг-

477

478

АБАСОВ и др.

натурам в детекторе, смоделированы стандартным

без тренировки сети на заранее смоделирован-

образом в пакетах MadGraph [4], POWHEG [5]

ных сигнальных событиях. Для того чтобы мо-

и Pythia [6]. Моделирование отклика детектора

дель не выучила функцию f(x) = x, в нейросети-

проведено в пакете DELPHES [7] с параметрами

автокодировщике часто используют принцип “бу-

детектора CMS коллайдера LHC.

тылочного горлышка” — понижения числа нейро-

нов в скрытых слоях. Таким образом, автокоди-

В качестве результата необходимо получить

ровщик понижает размерность данных, “фокуси-

ожидаемые ограничения на параметры аномальных

руясь” на наиболее информативных для рекон-

взаимодействий в интерпретации верхних ограни-

струкции особенностях данных. Поскольку такая

чений на бренчинги (вероятности) редких распадов

модель “выучивает” распределение нормальных

топ-кварка t → cg и t → ug. Вероятности таких

данных, аномальные данные, не попадающие в

редких распадов настолько малы, что прямой поиск

это распределение, будут иметь более высокую

таких распадов не имеет смысла, но в процессах

ошибку реконструкции — метрику разницы между

рождения одиночного топ-кварка tqg FCNC вза-

входным вектором данных и реконструированным.

имодействия могут быть обнаружены. Процессы

Чем больше такая метрика для определенного ано-

с tqg FCNC очень близки по характеристикам к

мального события, тем сильнее оно отличается от

t-канальному процессу рождения одиночного топ-

нормальных, предсказанных в СМ.

кварка в рамках СМ. Поэтому одиночное рождение

В данной статье рассматривается пример зада-

топ-кварка в рамках СМ можно использовать в ка-

чи, относящейся к классу модельно-независимых,

честве контрольного канала для проверки методов

покрывающей некоторый класс теоретических мо-

анализа. Исследование данной задачи в экспери-

делей, но требующих моделирования сигнальных

менте CMS приведено в работе [8].

событий с некоторой зависимостью от дополни-

тельных аномальных параметров. Определенная

предполагаемая модель новой физики использует-

ся для генерации событий методом Монте-Карло

2. ПРИМЕНЕНИЕ НЕЙРОННЫХ СЕТЕЙ

и в программах реконструкции, после этого на

этих событиях тренируется классификатор, чув-

В коллайдерной физике с помощью нейрон-

ствительный именно к этому процессу. После это-

ных сетей решается широкий круг задач, напри-

го дискриминатор классификатора используется

мер, классификация адронных струй (jets), рекон-

для проверки гипотез и статистического анализа

струкция треков частиц, поиск аномальных собы-

(пример дискриминатора — рис. 1). Все модели в

тий, ускорение моделирования событий [9]. В дан-

данном анализе были созданы на базе фреймворка

ной статье будет описана методология примене-

Tensorflow [12].

ния нейронных сетей в анализе высокого уров-

Важной частью анализа данных является под-

ня для поиска новой физики на примере FCNC-

готовка входных данных для предиктивной модели.

взаимодействий.

Группой ранее был представлен универсальный ме-

Как было отмечено выше, в современной

тод отбора переменных для анализа в физике высо-

физике высоких энергий существует несколько

ких энергий, основываясь на фейнмановских диа-

подходов к поиску событий, не предсказывае-

граммах исследуемых процессов [13]. После этого

шага рекомендуется удалить переменные, имеющие

мых Стандартной моделью: модельно-зависимый,

сильную линейную корреляцию. Для некоторых

модельно-независимый и поиск неизвестных ано-

моделей это уменьшит размер и увеличит скорость

малий. В модельно-независимом анализе и поиске

тренировки, а для других — напрямую повлияет на

аномалий ведется поиск общих отклонений от

предсказаний Стандартной модели в большом

качество классификации. Для оптимальной тре-

нировки нейронных сетей необходимо нормализо-

количестве физических каналов. Преимущество

вать вектор переменных — трансформировать его

таких методов заключается в покрытии больших

таким образом, чтобы среднее распределения было

областей фазового пространства и пространства

равно нулю, а стандартное отклонение — единице.

параметров, а не в чувствительности [10].

Другие многомерные методы анализа, например,

Одним из методов поиска аномальных собы-

деревья решений, не требуют такой трансформа-

тий новой физики является использование моде-

ции.

ли автокодировщика [11]. Автокодировщик — это

Смоделированные методом Монте-Карло со-

модель машинного обучения, которая обучается

бытия жестких процессов в коллайдерных экс-

реконструировать входные данные с минимальной

периментах имеют дополнительные весовые ко-

ошибкой. Для обучения такой модели не нужно

эффициенты, которые необходимо учитывать при

знать класс события, поэтому обучение автоко-

тренировке нейронной сети. Эти веса использу-

дировщика — пример обучения без учителя, т.е.

ются в функции ошибки для увеличения влияния

ЯДЕРНАЯ ФИЗИКА том 85

№6

2022

МЕТОДОЛОГИЯ ПРИМЕНЕНИЯ ГЛУБОКИХ НЕЙРОННЫХ СЕТЕЙ

479

отдельных событий с большим весом на суммар-

них, добавляя дропаут и меняя функции актива-

ную ошибку классификации набора смоделирован-

ции. Также на качество финальной модели может

ных событий (датасета). При минимизации этой

влиять оптимизатор модели с его собственными

функции в процессе обучения сети модель будет

параметрами: learning rate, weight decay, gradient

в первую очередь “стремиться” правильно клас-

clipping, momentum и другие. Все архитектурные

сифицировать именно эти события. При объеди-

и оптимизационные параметры задаются пользо-

вателем и не меняются в процессе обучения ней-

нении нескольких физических процессов в один

ронной сети. Эти параметры называются гиперпа-

набор фоновых событий необходимо учитывать их

раметрами, и их необходимо оптимизировать для

сечение и нормировать общий вес событий та-

повышения эффективности нейронной сети.

ким образом, чтобы интегральный вес событий

определенного физического процесса был пропор-

Оптимизация гиперпараметров должна прово-

ционален его сечению. Использование весов для

диться по всему числу параметров вместе, так

событий позволяет в некоторой степени решить

как один гиперпараметр может влиять на другой.

проблему несбалансированной классификации —

Совокупность гиперпараметров и их возможных

сильного неравенства числа событий в фоновом

значений называется пространством гиперпара-

метров, и в этом пространстве необходимо про-

и сигнальном датасетах. Например, если сигналь-

вести оптимизацию, найдя оптимальное сочетание

ные события составляют только 10% всего дата-

гиперпараметров для каждой конкретной задачи.

сета, то нейросетевая модель, для всех событий

Руководствоваться в этой задаче нужно специ-

предсказывающая фон, будет иметь 90%-ную точ-

альной функцией оценки модели, например, пло-

ность. Уравнивание интеграла весов сигнальных

щадью под ROC-кривой для бинарной классифи-

и фоновых событий позволяет вернуть проблему

кации (AUC). Модель тренируется с определен-

несбалансированной классификации к сбаланси-

ным набором гиперпараметров, затем выбранная

рованной. Тем не менее, малое количество событий

метрика оценивается либо на отдельной тестовой

может существенно повлиять на работу классифи-

выборке (для этого исходный датасет необходимо

катора, внося статистический шум.

разбить на три части: тренировочную, тестовую и

Важным этапом оценки работы нейросетевой

валидационную), либо с использованием кросс-

модели является измерение степени влияния от-

валидации. Проводить оптимизацию в простран-

дельных переменных на итоговый результат клас-

стве гиперпараметров можно разными способами.

сификации. Некоторые модели машинного обуче-

Можно перебрать все сочетания гиперпарамет-

ния, в частности, деревья решений, имеют встро-

ров, полностью исследовав их пространство. Этот

енные методы оценки важности переменных. Для

метод позволяет найти глобальный минимум, но

оценки важности переменных независимо от типа

требует существенных вычислительных затрат, ес-

используемой модели машинного обучения приме-

ли пространство гиперпараметров имеет большой

няют общие методы, например, permutation feature

размер и тренировка единичной модели требует

importance (метод перестановки). В рамках этого

заметных вычислительных ресурсов. Существуют

метода каждая из входных переменных модели за-

алгоритмы, с помощью которых можно найти ре-

шумляется, производится предсказание с зашум-

шение, близкое к оптимальному, за существенно

ленной переменной, и результат этого предсказа-

меньшее время, например, Bayesian Optimization

ния сравнивается с эталонным предсказанием на

или Random Search.

“чистых” переменных (пример результата такого

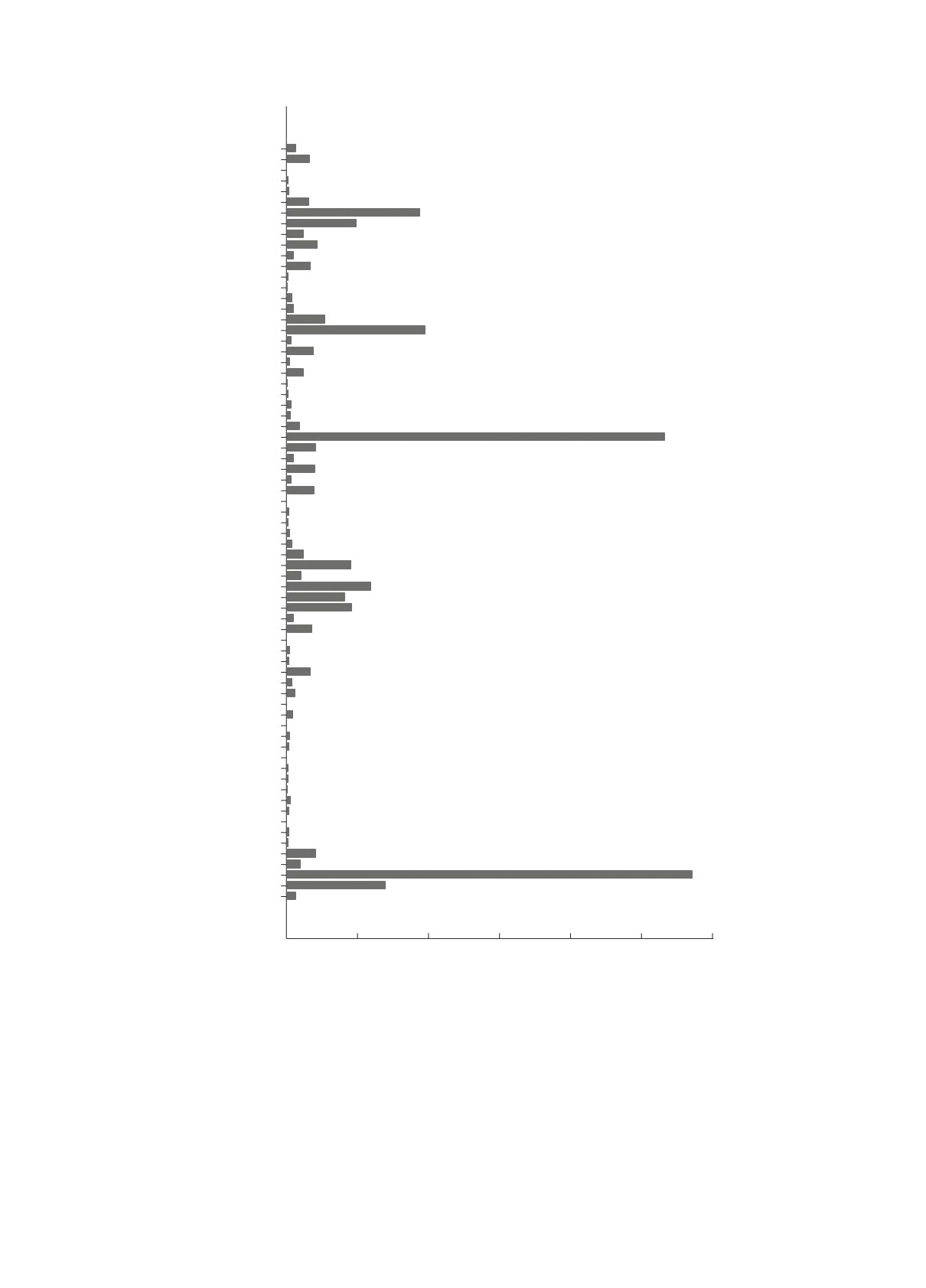

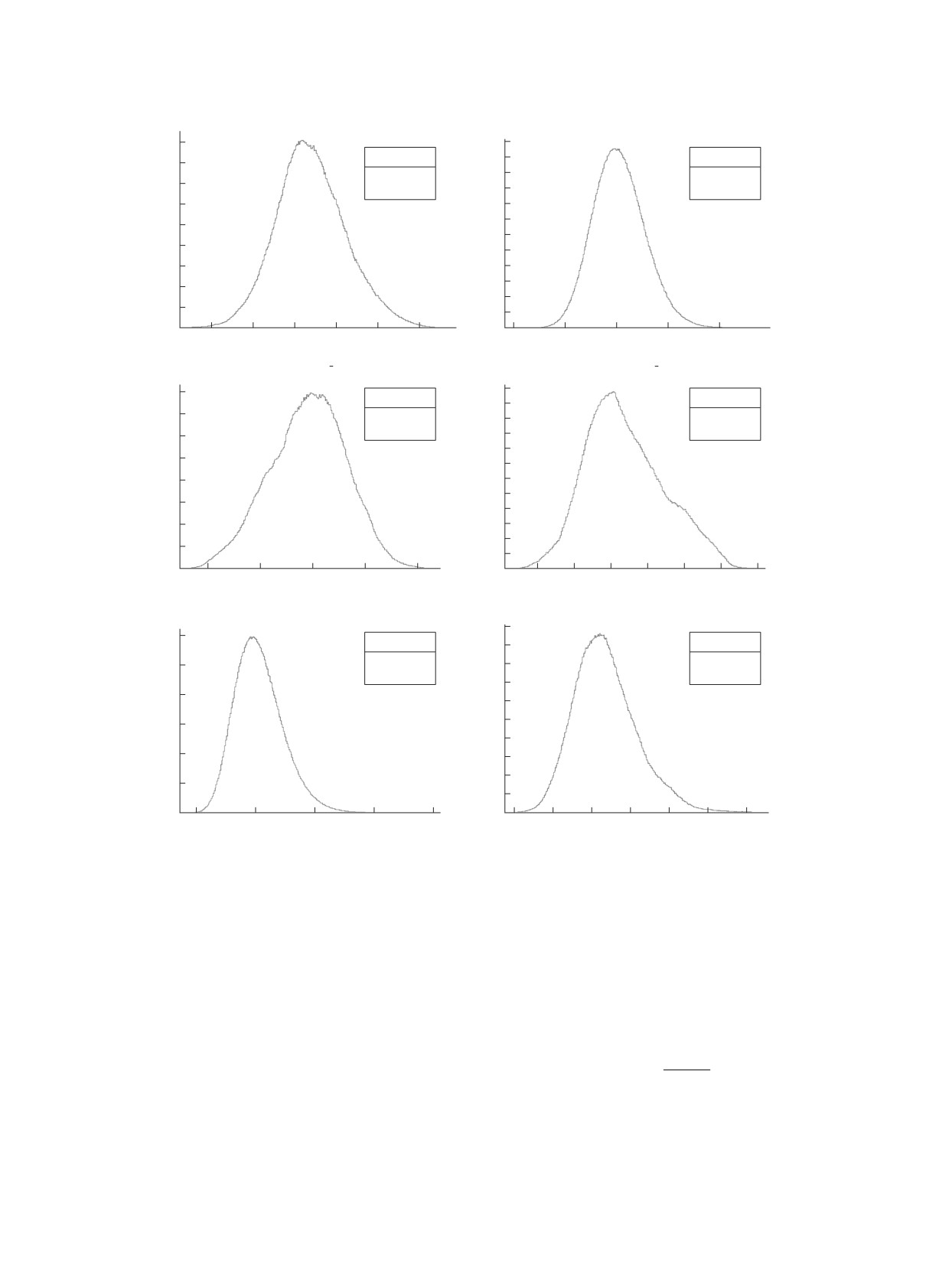

Нашей группой была проведена оптимизация

анализа — рис. 2). Чем сильнее отличается полу-

архитектурных гиперпараметров нейронной сети

ченное предсказание от эталонного, тем важнее

для типичной задачи физики высоких энергий. Их

для классификации эта переменная. Метод оценки

визуализация представлена на рис. 3. В простран-

важности переменных позволяет оценить, какие

стве гиперпараметров существуют довольно ши-

переменные имеют больший вес для модели, и

рокие области стабильности, дающие одинаково

внести некоторую ясность в причины принятия

хороший результат. Для типичной задачи физики

решений конкретной модели машинного обучения.

высоких энергий примерная область оптимальных

Также этот инструмент помогает понять, в каких

гиперпараметров следующая: скрытые слои — 1-

областях данных следует в первую очередь искать

2 слоя, число нейронов в скрытых слоях — (4-

ошибки при отладке нейросетевой модели. Этот

6)n, где n — число входных переменных, значение

анализ можно провести с помощью инструментов

дропаута — 0.2-0.3. Исследование пространства

библиотеки sklearn [14].

гиперпараметров было проведено с помощью паке-

Архитектура нейронной сети может напрямую

та Keras Tuner [15].

влиять на качество ее предсказаний. Архитектуру

Следующий возможный этап оптимизации ана-

простого многослойного перцептрона можно ме-

лиза — это объединение моделей в ансамбль. В це-

нять, варьируя число скрытых слоев и нейронов в

лом есть два пути формирования ансамбля: варьи-

ЯДЕРНАЯ ФИЗИКА том 85

№6

2022

480

АБАСОВ и др.

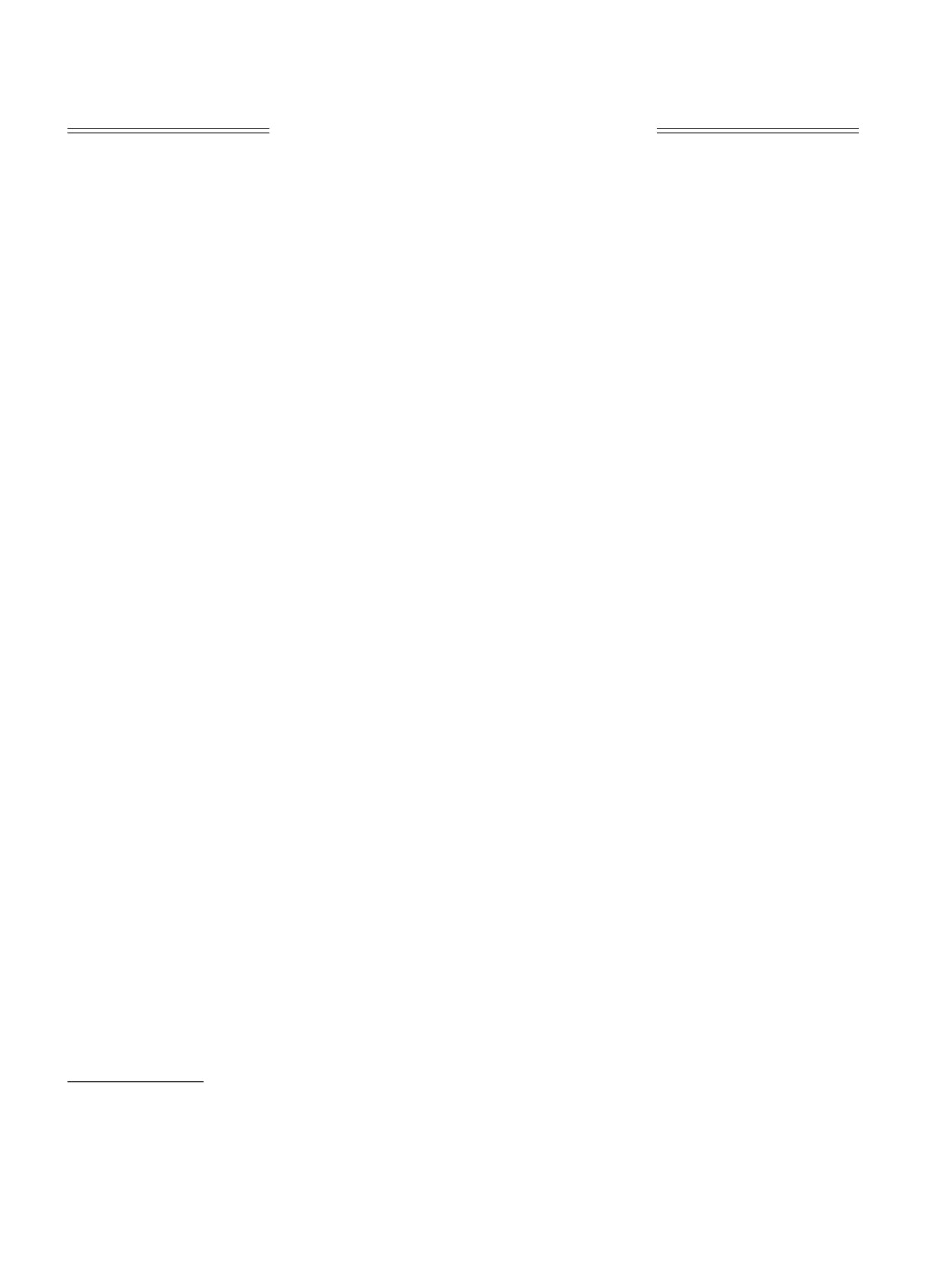

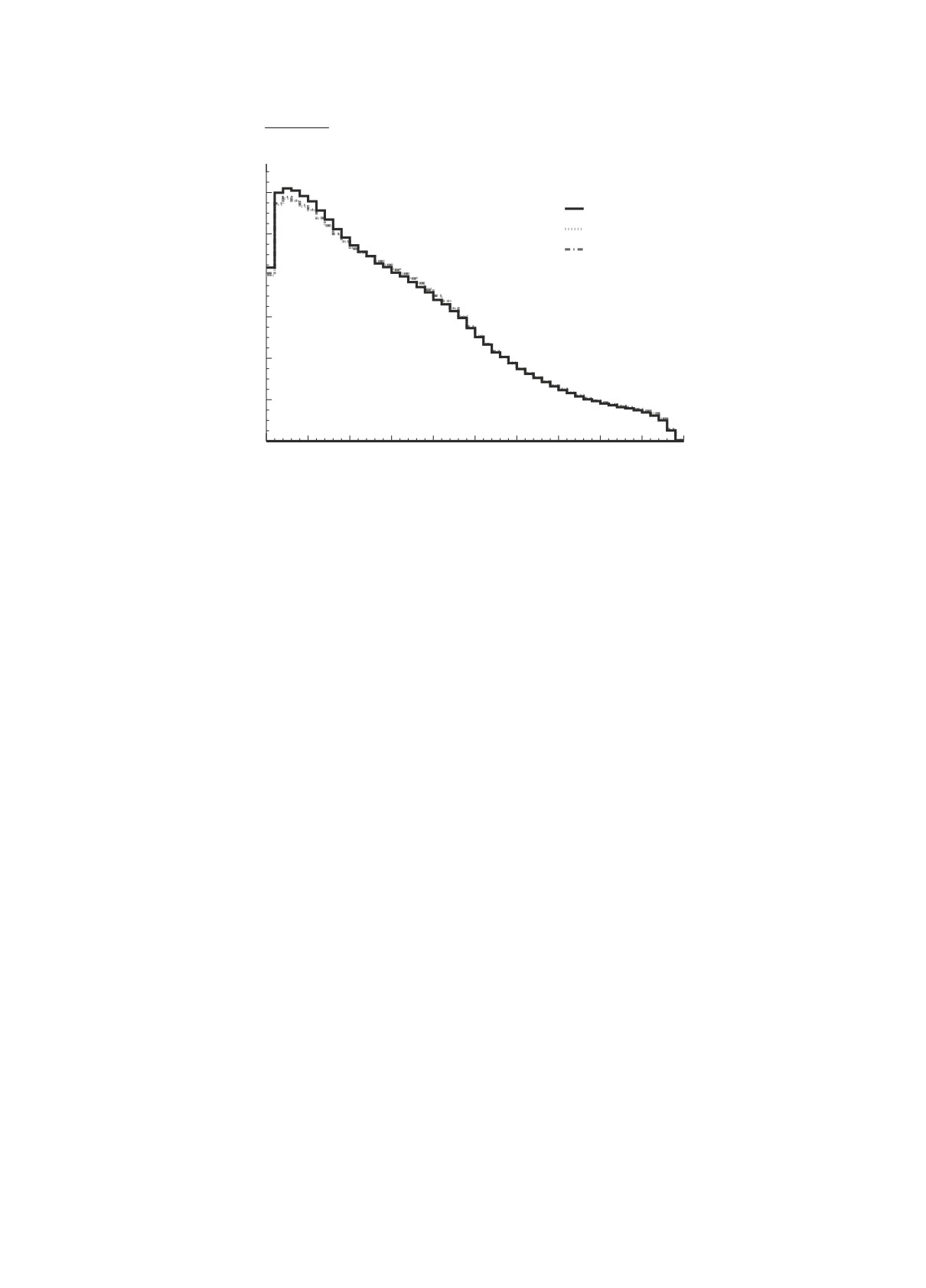

×103

dnn_sm_mc_qcd_sep

tcg

tug

Монте-Карло s = 13 ТэВ

t-chan

80

s-chan

tW-chan

70

tt-dl

tt-sl

W + light

60

Wb

Wc

WQQ

50

Diboson

Drell-Yan

QCD MC

40

30

20

10

0

0

0.2

0.4

0.6

0.8

1.0

dnn_sm_mc_qcd_sep

Рис. 1. Пример дискриминатора нейронной сети. Сигнальные процессы (t-chan) сгруппированы ближе к единице,

фоновые события расположены ближе к нулю.

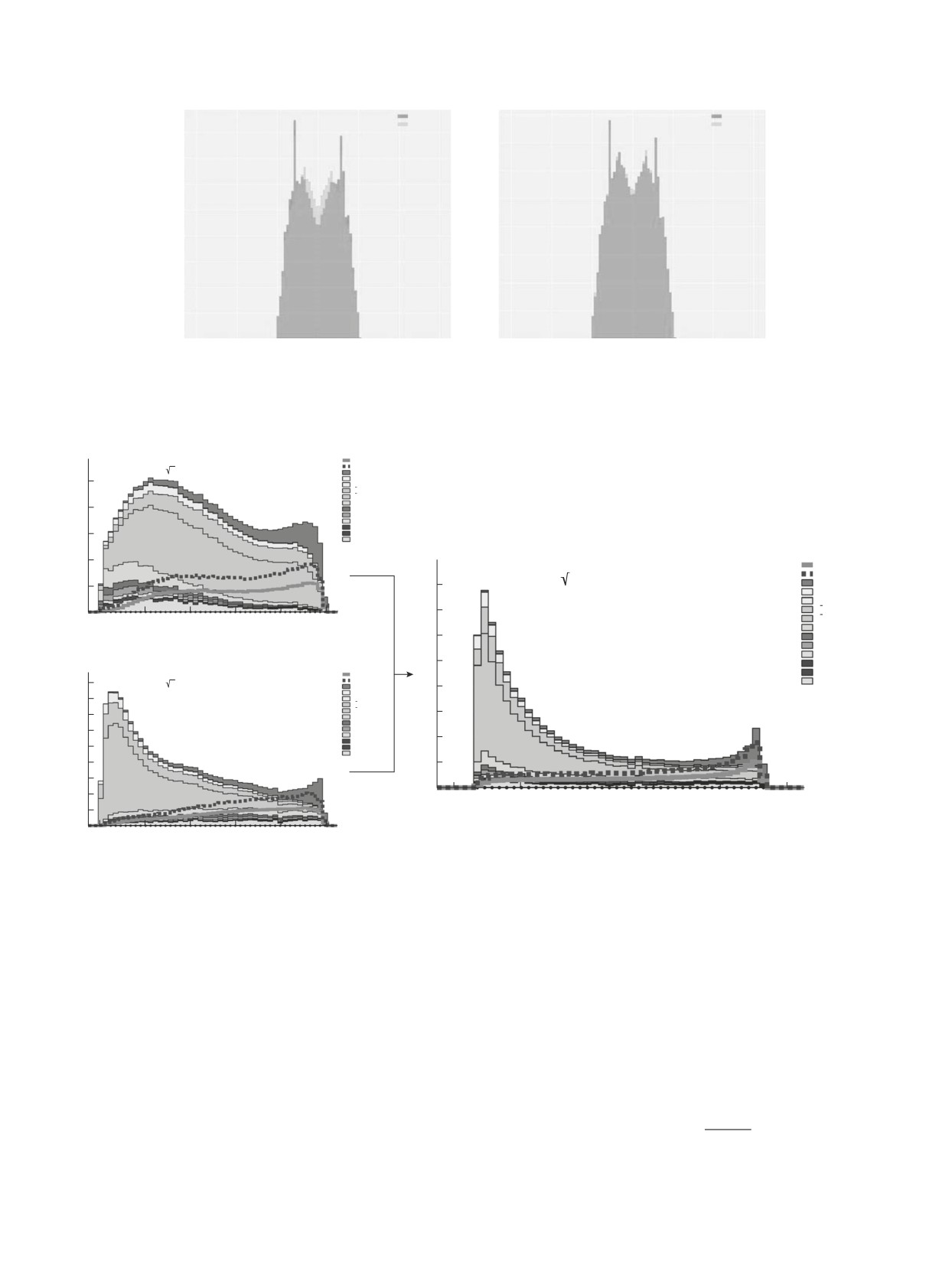

рование данных и тренировка модели на разных

и сигнал, а несколько сетей, чувствительных к

версиях датасета (Bagging), либо использование

разным процессам из фона, если их свойства

различных моделей, обученных на одном датасете

сильно различаются. Например, в данном анализе

(Stacking). В данной статье будет описан первый

существуют кинематически похожие процессы, с

метод.

рождением топ-кварков (процессы tt, tW , t +

Для реализации метода бэггинга выбранная мо-

+ X) и более мягкие процессы без рождения топ-

дель тренируется не на исходном датасете, а на

кварков (W + jets, W Z, W W , ZZ). Сети первого

модифицированном. Для получения такого дата-

уровня тренируются отдельно выделять процессы

с рождением топ-кварка от сигнала, вторая сеть

сета события из исходного выбираются с заме-

ной: таким образом, какие-то события повторятся

тренируется выделять процессы (W + jets, ...) от

несколько раз, а каких-то не будет вовсе. Со-

сигнала, а затем выходы этих сетей соединяются

здав несколько таких датасетов, можно обучить

в одномерный дискриминант с помощью третьей

на них несколько моделей и объединить их в еди-

нейронной сети (суперсети), имеющей на входе

ный ансамбль. Так как каждая индивидуальная

дискриминаторы сетей первого уровня. Такой

модель работала с несколько измененным датасе-

подход позволяет объединить две более чувстви-

том, их объединение позволяет уменьшить разброс

тельные к отдельным процессам сети и изменить

(variance) на тестовых данных, уменьшая тестовую

форму итогового дискриминатора (рис. 6).

ошибку и повышая обобщающую способность все-

го предиктора, сравнение эффективности сетей в

терминах AUC приведено на рис. 4.

3. СТАТИСТИЧЕСКИЙ АНАЛИЗ

Для событий с весами необходимо несколько

Следующим этапом является статистический

модифицировать процедуру семплирования с заме-

анализ полученного дискриминанта глубокой ней-

ной: необходимо учитывать веса каждого события

ронной сети (DNN). Данный дискриминант можно

при их случайной выборке. Вероятность выбора

представить в виде гистограммы распределения

каждого события должна быть пропорциональна

событий по значениям дискриминатора созданной

его весу. Таким образом, распределение по пере-

нейронной сети (ансамбля или суперсети). Задача

менным в датасетах, полученных семплированием

статистического анализа состоит в фитировании

с заменой, будет соответствовать распределению в

данного распределения с учетом данных и моде-

исходном (пример распределений с примененными

лирования, оценке значений случайных парамет-

весами приведен на рис. 5).

ров (например, сечений, ошибок реконструкции и

Последним возможным этапом оптимизации

т.д.) и их вероятностных распределений. На ос-

анализа стало использование каскадов нейрон-

нове статистического анализа проводятся измере-

ных сетей. Суть метода заключается в том, что

ния параметров, представляющих интерес в задаче,

тренируется не одна сеть, разделяющая весь фон

или находятся ограничения на возможные значения

ЯДЕРНАЯ ФИЗИКА том 85

№6

2022

МЕТОДОЛОГИЯ ПРИМЕНЕНИЯ ГЛУБОКИХ НЕЙРОННЫХ СЕТЕЙ

481

log(S_LjTop)

log(S_j1j2)

log(S_NuLj)

log(S_NuBj1)

log(S_Nuj2)

log(S_Nuj1)

log(S_LepLj)

log(S_LepBj1)

log(S_Lepj2)

log(S_Lepj1)

log(S_LepNu)

log(SP_j1j2)

log(SP_NuBj1)

log(SP_NuLj)

log(SP_Nuj2)

log(SP_Nuj1)

log(SP_LepBj1)

log(SP_LepLj)

log(SP_Lepj2)

log(SP_Lepj1)

log(SP_LepNu)

DPhi_LepW

Planarity

Sphericity

Cos_LepW_W

Cos_WLj_Bj1

Cos_LepLj_Bj1

DR_LepLj

DR_j1j2

log(M_jW)

log(M_jNotBest)

log(Ht_jNotBest)

log(Ht_j)

Eta_j1j2

Eta_j2

Eta_j1

Eta_Lj

Eta_Lep

log(Pttop_Bj1)

log(Pt_W)

log(Pt_jNotBest)

log(Pt_j1j2)

log(Pt_Lj)

log(Pt_Bj1)

log(Pt_j2)

log(Pt_j1)

Bj1_GTag

Lj2_GTag

Bj1_CTag

Lj2_CTag

Bj1_UDSTag

Lj2_UDSTag

Bj1_BTag

Lj2_BTag

Lj_UDSTag

j2_UDSTag

j1_UDSTag

Lj_CTag

j2_CTag

j1_CTag

Lj_GTag

j2_GTag

j1_GTag

Lj_BTag

j2_BTag

j1_BTag

DPhi_WNu

DPhi_LepNu

log(Pt_Lep)

log(MET)

log(MtW)

0

0.02

0.04

0.06

0.08

0.10

0.12

Рис. 2. Пример ранжирования переменных для модели нейронной сети по степени важности. Чем больше значение по

абсциссе (условные единицы), тем больше значимость переменной для модели.

этих параметров. В нашей задаче искомыми слу-

скому анализу: частотный и байесовский. Частот-

чайными параметрами являются константы связи,

ные методы позволяют достичь высокой скорости

характеризующие возможный вклад аномальных

обработки данных (например, асимптотические ме-

FCNC-взаимодействий, выраженные в терминах

тоды [16]), но, в отличие от байесовских методов,

бренчингов редких распадов топ-кварка t → cg и

где на выходе статистического анализа вычисля-

t → ug.

ются апостериорные распределения по каждому

Существует два основных подхода к статистиче- параметру, в частотных методах можно получить

ЯДЕРНАЯ ФИЗИКА том 85

№6

2022

482

АБАСОВ и др.

0.49

0.48

0.48

0.48

0.48

0.48

0.48

0.48

0.48

0.48

0.48

0.48

0.48

0.48

0.48

0.48

0.48

0.48

0.48

0.48

0.58

1

2

0.48

0.48

0.48

0.48

0.48

0.48

0.48

0.48

0.48

0.48

0.48

0.48

0.48

0.48

0.48

0.48

0.48

0.48

0.48

0.48

0.56

3

0.49

0.48

0.48

0.48

0.49

0.48

0.49

0.48

0.48

0.48

0.48

0.48

0.50

0.48

0.50

0.49

0.49

0.49

0.50

0.50

0.54

4

0.49

0.50

0.49

0.50

0.49

0.49

0.49

0.49

0.54

0.51

0.51

0.51

0.50

0.53

0.50

0.49

0.51

0.52

0.52

0.51

0.52

5

0.51

0.50

0.50

0.50

0.50

0.50

0.50

0.50

0.54

0.51

0.53

0.52

0.50

0.54

0.51

0.52

0.55

0.52

0.56

0.56

6

0.54

0.52

0.51

0.52

0.51

0.51

0.52

0.52

0.51

0.52

0.51

0.52

0.52

0.53

0.54

0.53

0.51

0.56

0.57

0.56

0.50

7

0.55

0.54

0.54

0.52

0.53

0.53

0.55

0.52

0.53

0.54

0.54

0.53

0.53

0.53

0.53

0.55

0.55

0.56

0.59

0.57

0.48

50

100 150 200 250 300 350 400 450 500 550 600 650 700 750 800 850 900 950 1000

hidden_layers_dim

Рис. 3. Пример визуализации пространства гиперпараметров: показана зависимость предиктивной способности модели

(функции бинарной кросс-энтропии: чем меньше, тем лучше) от числа нейронов в скрытых слоях (абсцисса) и числа

скрытых слоев (ордината). По остальным гиперпараметрам было проведено усреднение. Заметен большой регион

стабильности: для 1-2 слоев и 200-1000 нейроновсеть показывает почти одинаково хороший результат классификации.

Результат на экзаменационном наборе

0.783

0.782

0.781

0.780

0.779

Результат отдельной сети

0.778

Результат ансамбля

0

5

10

15

20

25

30

Рис. 4. Зависимостькачества классификацииAUC от числа моделейв ансамбле. Отдельнымиточками показаныметрики

индивидуальных моделей. Обобщающая способность и AUC ансамбля превосходит любую индивидуальную модель.

только конечные ограничения и оценки. Для прове-

наблюдаемых o1, o2, ..., oN . Каждая статистическая

дения статистического анализа используется пакет

модель является функцией, зависящей от случай-

theta [17] и CombinedLimit [18, 19]. Далее все

этапы анализа описаны на примере их реализации

ных параметров p. Если исходные данные опи-

в пакете theta.

сываются гистограммой (в нашем случае дискри-

минантом DNN), то необходимо задать шаблоны

3.1. Построение статистической модели

для каждого физического процесса с ожидаемым

В самом общем случае статистическая модель

в theta представляет собой набор шаблонов для количеством событий этого процесса в каждом

ЯДЕРНАЯ ФИЗИКА том 85

№6

2022

МЕТОДОЛОГИЯ ПРИМЕНЕНИЯ ГЛУБОКИХ НЕЙРОННЫХ СЕТЕЙ

483

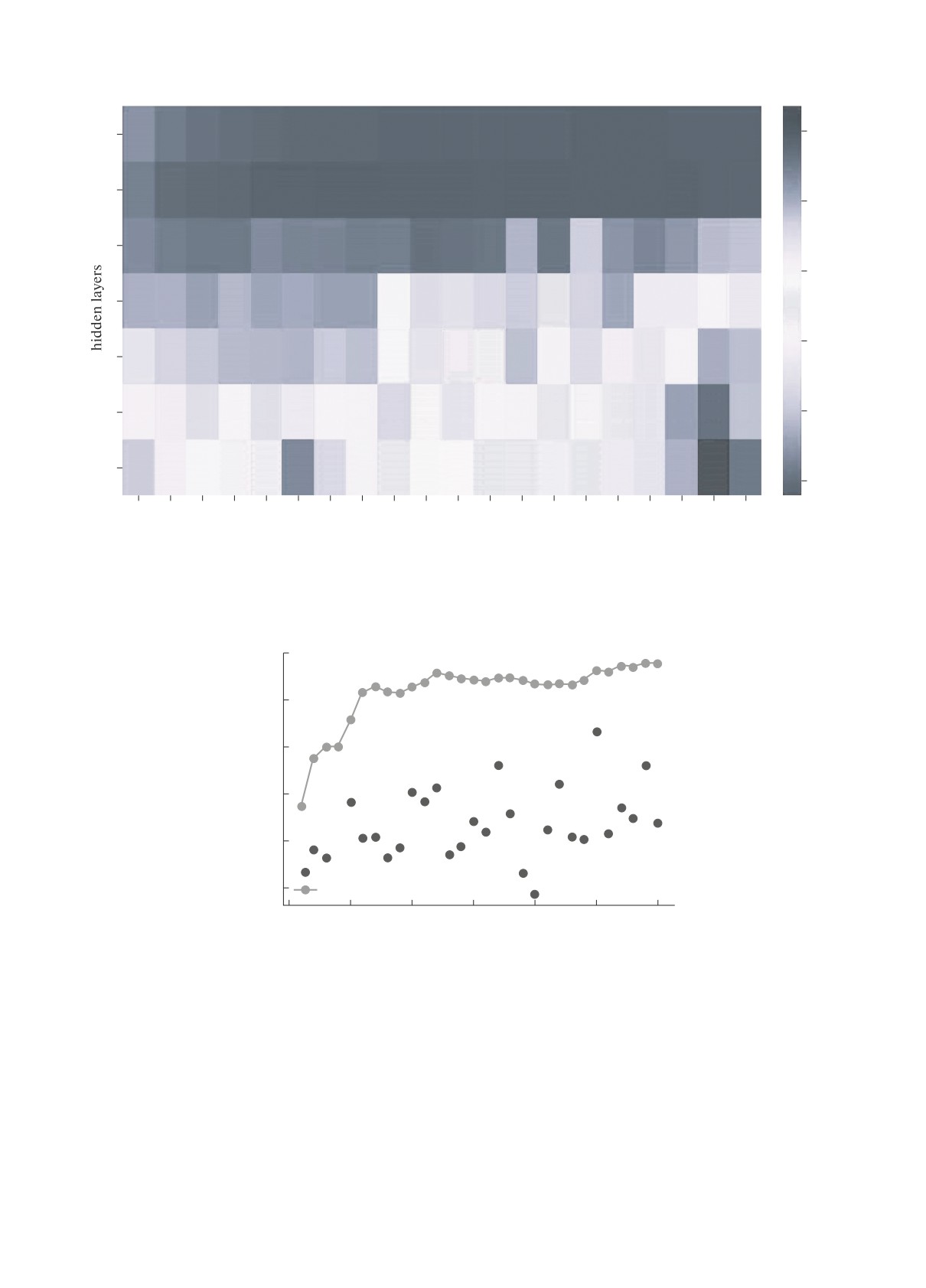

Без весов

0.40

С весами

С весами

С бутстра-

а

б

0.40

пом

0.35

0.35

0.30

0.30

0.25

0.25

0.20

0.20

0.15

0.15

0.10

0.10

0.05

0.05

0

0

-6

-4

-2

0

2

4

6

-6

-4

-2

0

2

4

6

Рис. 5. Пример применения весов к бутстрап-семплированию событий: сравнение распределения одной наблюдаемой с

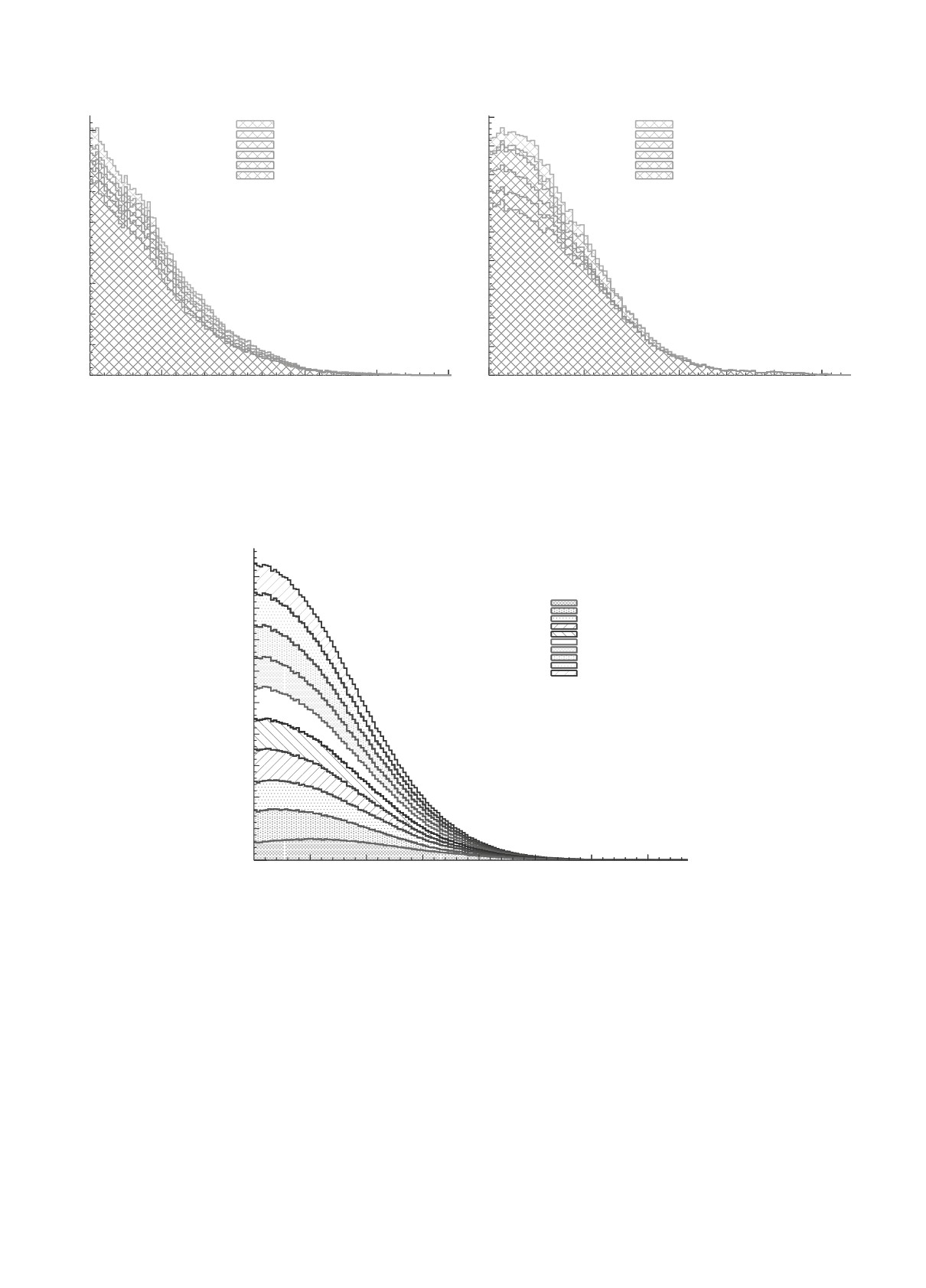

примененнымивесами и без них. Рисунок 5б демонстрируетхорошее согласованиераспределенийпосле семплирования.

3

×10

dnn_sm_wjets_qcd_mc_sep

tcg

tug

Монте Карло s = 13 ТэВ

t-chan

s-chan

50

tW-chan

tt-dl

tt-sl

W + light

40

Wb

Wc

WQQ

Diboson

30

Drell-Yan

QCD MC

×106

dnn_sm_super_qcd_mc_sep_2

20

tcg

tug

Монте Карло s = 13 ТэВ

t-chan

10

0.16

s-chan

tW-chan

0.14

tt-dl

0

tt-sl

0

0.2

0.4

0.6

0.8

1.0

W + light

0.12

Wb

dnn_sm_wjets_qcd_mc_sep

Wc

WQQ

3

0.10

Diboson

×10

dnn_sm_ttbar_qcd_mc_sep

tcg

Drell-Yan

tug

QCD MC

90

Монте Карло s = 13 ТэВ

t-chan

0.08

s-chan

80

tW-chan

tt-dl

tt-sl

0.06

70

W + light

Wb

Wc

60

WQQ

Diboson

0.04

50

Drell-Yan

QCD MC

40

0.02

30

0

20

0

0.2

0.4

0.6

0.8

1.0

10

dnn_sm_super_qcd_mc_sep_2

0

0

0.2

0.4

0.6

0.8

1.0

dnn_sm_ttbar_qcd_mc_sep

Рис. 6. Использование ансамбля сетей: сети первого уровня чувствительны к событиям (tt, tW, t + X) и (W + jets), сеть

второго уровня объединяет их выходы.

бине гистограммы, а затем просуммировать:

записать как

∏∏

∑

pm (d|p) =

Poisson (di,l|mi,l (p)) ,

(2)

mi (p) = ci,k (p) ti,k (p) ,

(1)

i=1 l=1

k=1

где индекс i пробегает по всем наблюдаемым, а

где ci,k — вещественные коэффициенты, а ti,k —

индекс l — по бинам (bi — количество бинов для

шаблоны каждого из Mi процессов в модели.

наблюдаемой oi). Здесь

Принимается, что для каждого бина ti,k — строго

положительная величина.

λne-λ

Poisson (n|λ) =

(3)

Тогда вероятность получить количество изме-

n!

ренных данных d при условии параметров p можно

— распределение Пуассона со средним λ.

ЯДЕРНАЯ ФИЗИКА том 85

№6

2022

484

АБАСОВ и др.

1

dN

Nd

dnn_sm

×103

dnn_sm

12

Central

MET Up

10

MET Down

8

6

4

2

0

0.1

0.2

0.3

0.4

0.5

0.6

0.7

0.8

0.9

1.0

dnn_sm

Рис. 7. Демонстрация влияния неопределенности на форму распределения. Приведено распределение смоделированных

событий фона по величине дискриминатора нейронной сети. Показано распределение для центрального значения систе-

матической ошибки определения недостающего поперечного импульса в событии (MET) и распределения дискриминанта

после сдвига систематической неопределенности вычисления МЕТ на ±1σ.

В нашем примере наблюдаемая единственна —

нормировочного множителя τ, который будет ва-

дискриминант выхода нейронной сети; число би-

рьироваться отдельно в соответствии с распреде-

нов выбирается при проведении анализа вручную.

лением возможных значений данной неопределен-

В связи с неопределенностью выбора количества

ности. Случай τ = 1 отвечает отсутствию измене-

бинов должен быть проведен отдельный анализ

ний по данному типу неопределенности. В качестве

влияния количества бинов на результат и достиг-

примера из ранее описанной модели в разделе 3.1

нута стабильность результата относительно коли-

неопределенность нормировки добавлена к перво-

му процессу.

чества бинов.

mi (p) = τci,1 (p) ti,1 (p) +

(4)

∑

3.2. Добавление систематических

+ ci,k (p)ti,k (p).

неопределенностей

k=2

В нашем примере основными неопределенностями

Систематические неопределенности включают-

нормировки являются неопределенности теорети-

ся в модель как дополнительный вектор q, который

ческих сечений отдельных процессов и ошибка

параметризует влияние различных неопределенно-

интегральной светимости, полученной в экспери-

стей на предсказанные распределения. В пакете

менте. В качестве априорных распределений для

theta эти параметры обрабатываются так же, как и

сечений фоновых процессов берутся логнормаль-

p, которые были описаны выше.

ные распределения, а для сигнального процесса —

плоское распределение в положительной области

В самом простом случае систематическая

[19]. Выбор логнормальных распределений обу-

неопределенность может являться лишь неопре-

словлен тем, что полные сечения процессов всегда

деленностью нормировки конкретного процесса.

неотрицательны. Плоское априорное распределе-

Этот случай обсуждается в разд. 3.2.1. В общем

ние для сечения сигнального процесса (или другого

случае неопределенность может влиять также и на

параметра интереса) обусловлено равной априор-

форму распределений (неопределенности формы).

ной вероятностью всех возможных значений этого

Этот случай описан в разд. 3.2.2.

измеряемого случайного параметра.

3.2.1. Неопределенности нормировки. Для

3.2.2. Неопределенности формы. В общем

данного типа неопределенности добавление ее в

случае неопределенностей нормировки недоста-

модель заключается лишь в добавлении нового

точно для полного описания влияния ошибок на

ЯДЕРНАЯ ФИЗИКА том 85

№6

2022

МЕТОДОЛОГИЯ ПРИМЕНЕНИЯ ГЛУБОКИХ НЕЙРОННЫХ СЕТЕЙ

485

×103

sigma_t_ch

×103

sigma_s_ch

180

240

sigma_t_ch

sigma_s_ch

bf = 0.100000

220

bf = 0.100000

160

Entries

5015222

200

Entries

5015222

140

Mean

0.9197

Mean

1.01

Std Dev

0.0419

180

Std Dev

0.1005

120

160

140

100

120

80

100

60

80

60

40

40

20

20

0

0

0.80

0.85

0.90

0.95

1.00

1.05

0.6

0.8

1.0

1.2

1.4

×103

sigma_tt-dl

×103

sigma_tt_sl

160

sigma_ttbar-sl

240

sigma_ttbar-dl

bf = 0.100000

bf = 0.100000

220

140

Entries

5015222

Entries

5015222

Mean

0.9953

200

Mean

1.038

Std Dev

0.03602

Std Dev

0.1065

120

180

160

100

140

80

120

100

60

80

40

60

40

20

20

0

0

0.90

0.95

1.00

1.05

1.10

0.8

0.9

1.0

1.1

1.2

1.3

1.4

×103

sigma_Diboson

×103

sigma_tW_ch

200

300

sigma_Diboson

sigma_tW_ch

bf = 0.100000

180

bf = 0.100000

Entries

5015222

Entries

5015222

250

Mean

1.028

160

Mean

1.072

Std Dev

0.2028

Std Dev

0.1631

140

200

120

100

150

80

100

60

40

50

20

0

0

0.5

1.0

1.5

2.0

2.5

0.6

0.8

1.0

1.2

1.4

1.6

1.8

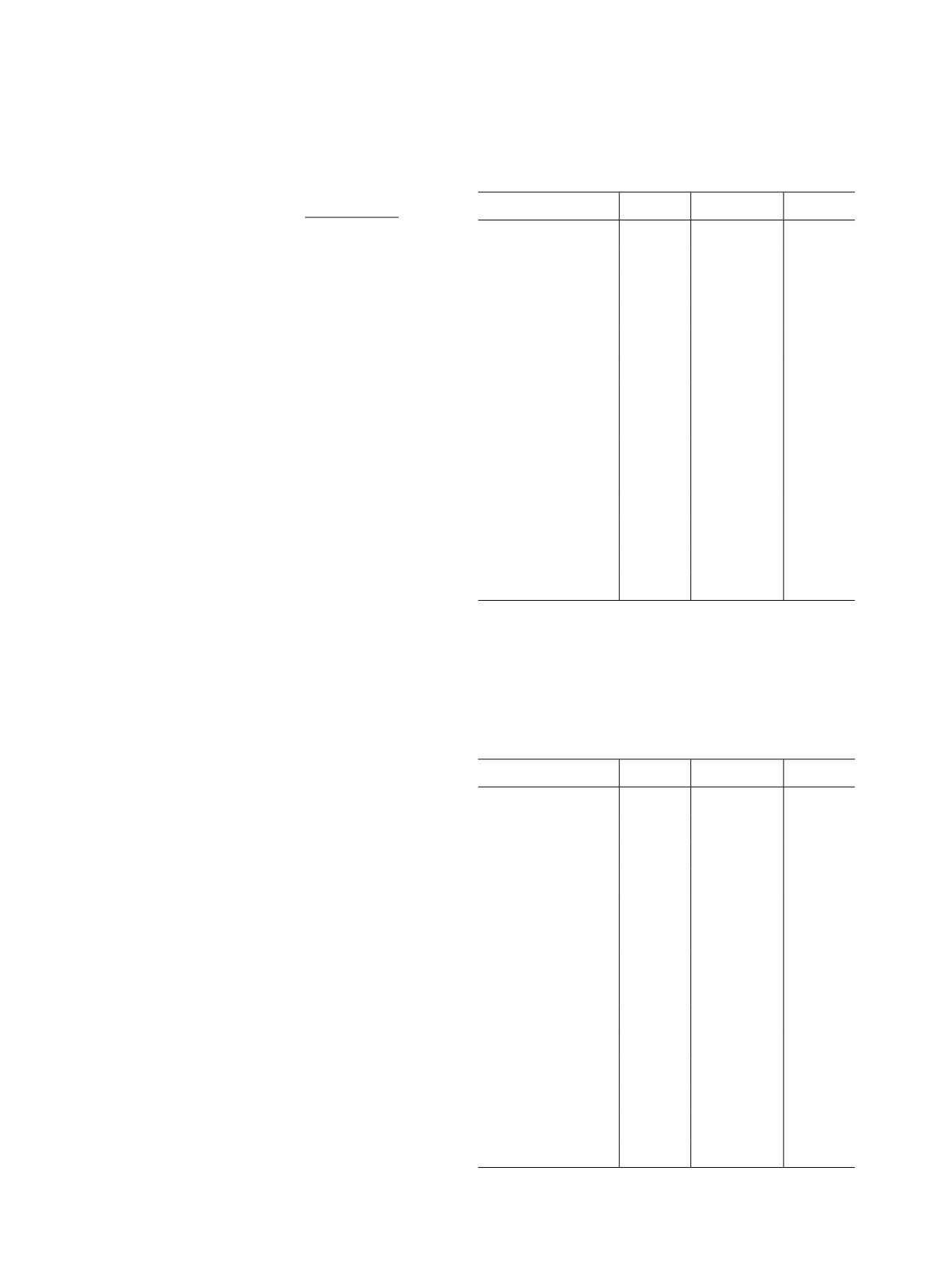

Рис. 8. Демонстрацияполучаемых в байесовскомподходеплотностейвероятностидля некоторыхслучайных параметров,

не являющихся искомыми в задаче. Приведены апостериорные плотности вероятности значений сечений некоторых

фоновых процессов, нормированных на теоретические сечения, полученные при анализе в пакете theta.

распределения наблюдаемых. Необходимо учиты-

для интерполяции между исходным шаблоном (без

вать также влияние некоторых неопределенностей

влияния систематики) и сдвинутыми шаблонами,

на форму распределений, т.е. могут получаться раз-

проводится вариация соответствующей неопреде-

личные нормировочные коэффициенты для каждо-

ленности на одно стандартное отклонение σ вверх и

го бина диаграммы, а не одинаковый коэффициент

вниз в каждом бине. В theta используется функция

для изменения нормировки конкретного процесса

интерполяции

во всех бинах. В качестве примера приведено из-

(tsign(δ))|δ|

менение распределения дискриминанта нейронной

t (δ) = t

(5)

t

сети для фоновых процессов при варьировании

недостающей поперечной энергии (МЕТ) в преде-

Здесь t — несмещенная (центральная) гистограм-

лах ошибки на ±1σ (рис. 7).

ма, а t± — смещенные гистограммы. Данный выбор

Для включения таких неопределенностей в мо-

функции не единственен, необходимо лишь соблю-

дель вводится параметр δ, который используется дение некоторых условий:

ЯДЕРНАЯ ФИЗИКА том 85

№6

2022

486

АБАСОВ и др.

Доля прожига:

Доля прожига:

9

0.00 −σ, среднее, +σ = 0.010 0.036 0.080

0.00 −σ, среднее, +σ = 0.018 0.060 0.125

16

0.05 −σ, среднее, +σ = 0.010 0.036 0.081

0.05 −σ, среднее, +σ = 0.018 0.061 0.127

0.10 −σ, среднее, +σ = 0.010 0.036 0.079

8

0.10 −σ, среднее, +σ = 0.018 0.059 0.124

0.15

-σ, среднее, +σ= 0.009 0.035 0.078

0.15 −σ, среднее, +σ = 0.018 0.061 0.127

14

0.20 −σ, среднее, +σ = 0.009 0.034 0.077

0.20 −σ, среднее, +σ = 0.019 0.063 0.130

0.25 −σ, среднее, +σ = 0.009 0.034 0.078

7

0.25 −σ, среднее, +σ = 0.019 0.065 0.133

12

6

10

5

8

4

6

a

3

б

4

2

2

1

0

0.05

0.10

0.15

0.20

0.25

0

0.05

0.10

0.15

0.20

0.25

0.30

0.35

KC

KC

Рис. 9. Демонстрация получаемых в байесовском подходе плотностей вероятности искомого случайного параметра.

Приведены апостериорные ожидаемые плотности вероятности параметра, характеризующего вклад tcg FCNC, полу-

ченные одной марковской цепью, рис. 9a и 9б демонстрируют распределения из разных марковских цепей. Приведены

распределения для разного количества исключаемых первых итераций прожига марковской цепи, соответствующих

исключению первых 25%, 20%-0% итераций.

Объединение цепей

90

Цепи:

Цепь 1

80

Цепь 2

Цепь 3

Цепь 4

Цепь 5

70

Цепь 6

Цепь 7

Цепь 8

Цепь 9

60

Цепь 10

50

40

30

20

10

0

0.05

0.10

0.15

0.20

0.25

0.30

0.35

KC

Рис. 10. Демонстрация объединения распределений из десяти марковских цепей. Приведена апостериорная ожидаемая

плотность вероятности параметра, характеризующего вклад tcg FCNC по результатам объединения десяти марковских

цепей.

• Для любых значений δ все бины гистограммы

в отличие от частотного, позволяет получать апо-

должны быть положительны.

стериорные распределения параметров, полностью

описывающих все случайные параметры, а не толь-

• Функция t(δ) должна иметь непрерывную

первую производную.

ко значения квантилей. В байесовской статисти-

ке апостериорное распределение параметра может

считаться результатом измерения и основано на

3.3. Байесовский подход в статистическом анализе

априорной информации о распределении данного

параметра.

В нашем примере используется байесовский

подход к статистическому анализу. Такой метод,

Рассмотрим простую модель с двумя парамет-

ЯДЕРНАЯ ФИЗИКА том 85

№6

2022

МЕТОДОЛОГИЯ ПРИМЕНЕНИЯ ГЛУБОКИХ НЕЙРОННЫХ СЕТЕЙ

487

рами: сечением сигнала μs и сечением фона μb.

Таблица 1. Квантили для ожидаемых сечений основных

Априорные распределения для параметров зада-

процессов, нормированных на теоретически предсказы-

ваемые сечения, и светимости, полученные из анализа в

дим как π(μs), π(μb). Тогда по теореме Байеса

пакете theta

получим

π (μs) π (μb)

Параметр

-σ

Среднее

+σ

p (μs, μb|d) = p (d|μs, μb)

,

(6)

π (d)

sigma_t_ch

0.866

0.913

0.958

p (d|μs, μb) получено при моделировании сигнала и

sigma_s_ch

0.911

1.01

1.11

фона, π(d) вычисляется из условия нормировки.

sigma_tW_ch

0.906

1.06

1.23

Для выделения из полученного многомерного

sigma_tt-sl

0.903

0.959

1.01

распределения искомого параметра интереса (в

sigma_tt-dl

0.96

1.08

1.22

данном примере это μs) производится интегриро-

вание по всем остальным случайным параметрам:

sigma_Diboson

0.832

1.01

1.23

∫

sigma_DY

0.805

0.975

1.19

p (μs|d) = p (μs, μb|d) dμb.

(7)

sigma_WQQ

0.877

1.17

1.54

Интегрирование в пакете theta реализовано при

sigma_Wc

0.828

1.08

1.41

помощи алгоритма Markov Chain Monte Carlo.

sigma_Wb

1.19

1.61

2.06

Апостериорные распределения некоторых вспомо-

гательных случайных параметров статистической

sigma_Wother

0.904

1.12

1.56

модели приведены на рис. 8. Показаны плотности

sigma_Wlight

0.775

1.02

1.34

вероятности значений сечений, нормированных на

sigma_QCD

0.491

0.644

0.799

теоретически предсказанное сечение, для процес-

сов одиночного t-, s- и tW -каналов одиночного

светимость

0.989

1.01

1.03

рождения топ-кварка, полулептонного и дилеп-

тонного каналов парного рождения топ-кварков и

рождения двух массивных калибровочных бозонов.

Из полученного апостериорного распределения

стандартным образом извлекаются среднее и кван-

Таблица 2. Квантили для ожидаемых сечений основных

процессов, нормированных на теоретически предсказы-

тили уровней 0.16 и 0.84 (отклонения на -1σ и +1σ

ваемые сечения, и светимости, полученные из анализа

соответственно). В табл. 1 приведены вышеопи-

при 2D анализе в пакете theta

санные квантили для сечений основных процессов

и светимости.

Параметр

-σ

Среднее

+σ

sigma_t_ch

0.912

0.946

0.982

3.4. Многомерный статистический анализ

sigma_s_ch

0.936

1.04

1.15

sigma_tW_ch

1.02

1.16

1.34

В качестве альтернативы анализу дискриминан-

та одной сети, в нашем примере натренированной

sigma_tt-sl

0.936

0.969

1

на разделение t-канального одиночного рождения

sigma_tt-dl

1.08

1.15

1.2

t-кварка (t-ch) от всех остальных процессов, мож-

но провести анализ дискриминантов двух сетей,

sigma_Diboson

0.854

1.04

1.28

обученных на разделение сигнала, и по отдельности

sigma_DY

0.839

1.01

1.22

двух фоновых процессов, сильно отличающихся

между собой по кинематическим характеристикам:

sigma_WQQ

0.926

1.21

1.53

tt (парное рождение топ-кварков) и Wjets (рож-

sigma_Wc

1.1

1.34

1.58

дение W -бозона и адронных струй). Такой анализ

sigma_Wb

1.57

1.82

2.09

практически не отличается от одномерного: исход-

ное двумерное распределение проходит процеду-

sigma_Wother

1.1

1.28

1.49

ру побинной развертки, после чего анализируется

sigma_Wlight

0.631

0.802

1.03

так же, как и выход одной сети. Это возможно

в силу независимости анализа от порядка бинов.

sigma_QCD

0.635

0.698

0.76

Полученные квантили для 2D-анализа приведены

светимость

0.98

0.992

1

в табл. 2.

ЯДЕРНАЯ ФИЗИКА том 85

№6

2022

488

АБАСОВ и др.

Таблица 3. Квантили для ожидаемых сечений основных

стала наблюдаться нестабильность в апостериор-

процессов, нормированных на теоретически предсказы-

ных распределениях. В качестве одного из решений

ваемые сечения, и светимости, полученные из анализа в

данной проблемы анализ проводится несколько раз

пакете CombinedLimit

при одинаковых условиях, запускается несколько

марковских цепей, а затем апостериорные распре-

Параметр

-σ

Среднее

+σ

деления суммируются. Распределения для некото-

sigma_t_ch

0.852

0.888

0.936

рых отдельных итераций приведены на рис. 9, объ-

единенное распределение нескольких марковских

sigma_s_ch

0.915

1

1.11

цепей приведено на рис. 10. В отличие от простого

sigma_tW_ch

0.942

1.05

1.15

усреднения квантилей каждой итерации, такой ме-

тод статистически объективнее, так как сохраняет

sigma_tt-sl

0.942

0.968

0.981

и форму распределения в процессе суммирования.

sigma_tt-dl

0.992

1.05

1.11

Объединение цепей позволяет избежать предвзя-

тости при выборе конкретной итерации анализа.

sigma_Diboson

0.845

1.01

1.21

sigma_DY

0.839

1.01

1.22

sigma_WQQ

0.943

1.2

1.55

4.2. Сравнение пакетов

sigma_Wc

0.916

1.17

1.45

sigma_Wb

1.1

1.34

1.75

Для дальнейшей проверки результатов про-

водится сравнение анализа, проведенного при

sigma_Wother

1

1.21

1.38

помощи пакета theta (табл.

1), с полностью

sigma_Wlight

0.775

0.959

1.21

аналогичным анализом в CombinedLimit (табл. 3).

sigma_QCD

0.534

0.71

0.855

В CombinedLimit был применен метод

MarkovChainMC. Такое сравнение позволяет убе-

светимость

0.986

1

1.02

диться в независимости результатов от выбранного

пакета для анализа и повышает достоверность

полученных результатов.

4. ПРОВЕРКА РЕЗУЛЬТАТОВ

СТАТИСТИЧЕСКОГО АНАЛИЗА

На примере результатов поиска FCNC в данном

разделе описываются различные методы проверки

5. ЗАКЛЮЧЕНИЕ

и контроля статистического анализа. Данные мето-

ды позволяют убедиться в непредвзятости анализа

В статье приведены основные этапы примене-

в зависимости от различных параметров. Для каж-

ния методов глубоких нейронных сетей в задаче

дых полученных результатов проводится проверка

поиска “новой физики” в анализе данных коллай-

независимости от числа бинов гистограммы, а так-

дерных экспериментов. Рассмотрена задача поиска

же любых других желаемых параметров анализа

нейтральных токов, меняющих аромат кварков, во

путем нескольких запусков при разных значениях

взаимодействии топ-кварка с u- или c-кварком и

параметра и дальнейшего построения зависимости

глюоном, и описаны методы оптимизации примене-

ограничений от выбранного параметра.

ния глубоких нейронных сетей и их статистической

Так как при интегрировании используются мар-

интерпретации для измерения ожидаемых ограни-

ковские цепи, то проводится визуальный анализ

чений на параметры, характеризующие возможный

апостериорных распределений от величины про-

вклад таких отклонений от СМ. Сформулирован-

жига (burn-in) — числа начальных точек цепи, ис-

ные рецепты могут быть напрямую использованы

ключаемых из анализа в силу их зависимости от

в других задачах поиска “новой физики” в коллай-

стартового значения. Данные распределения при-

дерных экспериментах.

ведены на рис. 9. На рисунке показаны апосте-

риорные гистограммы для проверки burn-in для

Результаты применения разрабатываемых ме-

различной доли исходных данных, удаленных при

тодов в задаче поиска tqg FCNC получены при

прожиге: от 0 до 0.25 с шагом 0.05.

поддержке гранта Российского научного фонда

(проект № 22-12-00152). Исследования по опти-

4.1. Объединение марковских цепей

мизации построения нейронных сетей выполнены в

В силу большого числа учитываемых система-

рамках научной программы Национального центра

тических неопределенностей в анализе и большой

физики и математики, проект “Физика частиц и

размерности пространства случайных параметров

космология”.

ЯДЕРНАЯ ФИЗИКА том 85

№6

2022

МЕТОДОЛОГИЯ ПРИМЕНЕНИЯ ГЛУБОКИХ НЕЙРОННЫХ СЕТЕЙ

489

СПИСОК ЛИТЕРАТУРЫ

12. M. Abadi, A. Agarwal, P. Barham, E. Brevdo,

Z. Chen, C. Citro, G. S. Corrado, A. Davis, J. Dean,

1.

E. E. Boos, V. E. Bunichev, L. V. Dudko, M. A. Per-

M. Devin, et al., TensorFlow: Large-Scale Machine

filov, and G. A. Vorotnikov, Phys. At. Nucl. 83, 984

(2020); arXiv: 2004.14498.

Learning on Heterogeneous Systems

(2015),

2.

E. Boos, V. Bunichev, M. Dubinin, L. Dudko, V. Ilyin,

A. Kryukov, V. Edneral, V. Savrin, A. Semenov, and

13. L. Dudko, G. Vorotnikov, P. Volkov, M. Perfilov,

A. Sherstnev (CompHEP), Nucl. Instrum. Methods

A. Chernoded, D. Ovchinnikov, and A. Shporin,

A 534, 250 (2004); hep-ph/0403113.

Int. J. Mod. Phys. A 35, 2050119 (2020); arXiv:

3.

A. Pukhov, E. Boos, M. Dubinin, V. Edneral, V. Ilyin,

2002.09350.

D. Kovalenko, A. Kryukov, V. Savrin, S. Shichanin,

14. F. Pedregosa, G. Varoquaux, A. Gramfort, V. Michel,

and A. Semenov, hep-ph/9908288.

B. Thirion, O. Grisel, M. Blondel, P. Prettenhofer,

4.

J. Alwall, R. Frederix, S. Frixione, V. Hirschi,

R. Weiss, V. Dubourg, et al., J. Machine Lear.

F. Maltoni, O. Mattelaer, H.-S. Shao, T. Stelzer,

Research 12, 2825 (2011).

P. Torrielli, and M. Zaro, JHEP 1407, 079 (2014);

arXiv: 1405.0301.

15. T. O’Malley, E. Bursztein, J. Long, F. Chollet,

5.

S. Alioli, P. Nason, C. Oleari, and E. Re, JHEP 1006,

H. Jin, L. Invernizzi, et al., Keras Tuner (2019),

043 (2010); arXiv: 1002.2581.

6.

T. Sj ¨ostrand, S. Ask, J. R. Christiansen, R. Cor-

ke, N. Desai, P. Ilten, S. Mrenna, S. Prestel,

16. G. Cowan, K. Cranmer, E. Gross, and O. Vitells, Eur.

C. O. Rasmussen, and P. Z. Skands, Comput. Phys.

Phys. J. C 71, 1554 (2011); Eur. Phys. J. C 73, 2501

Commun. 191, 159 (2015); arXiv: 1410.3012.

(Erratum) (2013); arXiv: 1007.1727.

7.

J. de Favereau, C. Delaere, P. Demin, A. Giammanco,

17. Th. M ¨uller, J. Ott, and J. Wagner-Kuhr, Tech. Rep.

V. Lemaˆıtre, A. Mertens, and M. Selvaggi

(2010), CMS-IN-2010/017.

(DELPHES 3), JHEP 1402, 057 (2014); arXiv:

1307.6346.

18. CMS-NOTE-2011-005;

ATL-PHYS-PUB-

8.

CMS Collab. (V. Khachatryan et al.), JHEP 1702,

2011-11; Tech. Rep., CERN, Geneva

(2011),

028 (2017); arXiv: 1610.03545.

9.

D. Guest, K. Cranmer, and D. Whiteson, Ann. Rev.

Nucl. Part. Sci. 68, 161 (2018); arXiv: 1806.11484.

CombinedLimit

10.

R. M. Bianchi, PhD Thesis, Freiburg U. (2014),

19. G. Cowan, Statistics, Chap. 39 in Particle Data

11.

T. Finke, M. Kr ¨amer, A. Morandini, A. M ¨uck,

rev-statistics.pdf; C. Patrignani et al. (Particle Data

and I. Oleksiyuk, JHEP 2106, 161 (2021); arXiv:

2104.09051.

Group), Chin. Phys. C 40, 100001 (2016).

METHODOLOGY FOR THE APPLICATION OF DEEP NEURAL NETWORKS

IN THE SEARCH FOR “NEW PHYSICS” AT COLLIDERS

AND STATISTICAL INTERPRETATION OF THE EXPECTED RESULTS

E. Abasov1), M. Belobrova1), P. Volkov1), G. Vorotnikov1), L. Dudko1), A. Zaborenko1),

M. Perfilov1), E. Sivakova1)

1)Skobeltsyn Institute of Nuclear Physics of Lomonosov Moscow State University, Russia

This article focuses on methods of application of neural networks to search for “New Physics” in

collider experiments. Mechanisms of observable selection, hyperparameter optimization, and constructing

cascades of deep neural networks are considered. Methods for statistical analysis of neural network

discriminants in packages theta and CombinedLimit are presented, taking into account various

uncertainties.

ЯДЕРНАЯ ФИЗИКА том 85

№6

2022