Известия РАН. Теория и системы управления, 2023, № 1, стр. 28-43

ОПТИМАЛЬНОЕ КОМПЛЕКСИРОВАНИЕ ИЗМЕРИТЕЛЕЙ ПРИ СОПРОВОЖДЕНИИ МАНЕВРИРУЮЩЕГО ОБЪЕКТА В СТАТИСТИЧЕСКИ НЕОПРЕДЕЛЕННЫХ СИТУАЦИЯХ

А. Н. Детков *

* E-mail: detkov@gosniias.ru

Поступила в редакцию 14.02.2022

После доработки 29.06.2022

Принята к публикации 01.08.2022

- EDN: BHHBHH

- DOI: 10.31857/S0002338822060075

Аннотация

Методами марковской теории оценивания случайных процессов решена задача синтеза оптимальных и квазиоптимальных алгоритмов комплексной обработки информации при сопровождении маневрирующего объекта и двухканальном векторном наблюдении с нарушениями в статистически неопределенных ситуациях. Задача решена применительно к дискретно-непрерывному марковскому процессу для случая, когда его непрерывная часть представляет собой векторную марковскую последовательность, а дискретная часть характеризуется трехкомпонентным дискретным марковским процессом, каждая компонента которого описывается цепью Маркова на несколько положений. Приводится структурная схема квазиоптимальной комплексной обработки информации. На простом примере методом имитационного моделирования показана работоспособность квазиоптимального алгоритма в статистически неопределенных ситуациях.

Введение. На практике часто возникает задача сопровождения подвижных объектов, например воздушных судов по локационным измерениям параметров их траекторий. Для решения задачи оценивания при определении параметров движения и организации сопровождения объектов широкое распространение получил линейный фильтр Калмана (ФК) [1, 2]. Однако в статистически неопределенных ситуациях в условиях маневра подвижного объекта, вызванных резким изменением траектории, например при смене эшелонов полета воздушного судна, и/или неопределенных измерений, обусловленных помехами (искусственного или естественного происхождения) и влиянием других объектов, уточнение траектории движения объекта может происходить по измерениям, не содержащим полезной информации об этом маневрирующем объекте [3–5]. В результате вычисляемая в алгоритме ковариационная матрица ошибок оказывается излишне оптимистической и значительно ухудшаются характеристики точности оценивания и условия сопровождения (вплоть до срыва сопровождения). Поэтому широко используются различные модификации ФК, пригодные для оценивания в условиях неопределенных измерений траектории маневрирующего объекта [6, 7]. В этих алгоритмах оценки параметров движения объекта формируются на выходах двух или более параллельно работающих ФК по поступающим результатам измерений. Каждый из ФК соответствует своему виду маневра и основан на представлении маневра объекта в виде стохастического процесса. Итоговая оценка находится путем объединения соответствующих оценок по каждому виду маневра с учетом их весов, что эквивалентно гауссовской аппроксимации апостериорной плотности вероятности параметров движения объекта на каждом такте. Эффективным средством синтеза модифицированных ФК является марковская теория оценивания [8, 9].

Кроме того, для повышения потенциальной точности и достоверности результатов сопровождения маневрирующих объектов широко используется комплексирование разнотипных измерителей с совпадающими зонами наблюдения и имеющими разную физическую природу, например активными радиолокационными и пассивными оптико-электронными [10–13].

Развитие средств вычислительной техники позволяет реализовать комплексную обработку информации (КОИ) в цифровой форме при достаточно большом числе уровней квантования аналого-цифровых преобразователей и разрядов для представления чисел [14]. Максимального выигрыша от комплексирования можно достичь, решив задачу синтеза, что позволяет определить оптимальную структуру и характеристики системы комплексной обработки информации [8].

Для решения задачи КОИ при сопровождении маневрирующего объекта в условиях противодействия среды может быть использован математический аппарат дискретно-непрерывных марковских процессов (ДНМП) в дискретном времени [14], адекватный решаемой задаче при реализации синтезированных алгоритмов на ЭВМ.

1. Постановка задачи оценивания дискретно-непрерывного марковского процесса в дискретном времени. Пусть вектор состояния сопровождаемого динамического маневрирующего объекта описывается линейным векторно-матричным стохастическим дифференциальным уравнением (СДУ) с постоянными во времени коэффициентами, зависящим от изменяющегося во времени случайного дискретного параметра Ak, который характеризует виды маневров объекта [15]:

(1.1)

$\frac{{d{\kern 1pt} {\kern 1pt} {\mathbf{X}}}}{{dt}} = {\mathbf{F}}\left( {{{A}_{k}}} \right){\mathbf{X}}(t) + {\mathbf{G}}\left( {{{A}_{k}}} \right){{{\mathbf{N}}}_{\xi }}(t),\quad {\mathbf{X}}(0) = {{{\mathbf{X}}}_{0}},$Решение уравнения (1.1) имеет вид [16]

(1.2)

${\mathbf{X}}(t) = {\mathbf{\Phi }}\left( {t,{{t}_{0}},{{A}_{k}}} \right){{{\mathbf{X}}}_{0}} + \int\limits_{{{t}_{0}}}^t {{\mathbf{\Phi }}\left( {t,\tau ,{{A}_{k}}} \right)} {\kern 1pt} {\kern 1pt} {\mathbf{G}}\left( {\tau ,{{A}_{k}}} \right){{{\mathbf{N}}}_{\xi }}(\tau )d\tau ,$Интеграл в правой части равенства (1.2) представляет собой векторный процесс с нулевым математическим ожиданием и матрицей центральных моментов второго порядка:

Так как для неперекрывающихся интервалов времени значения этого процесса статистически независимы, аналогично [16] уравнение состояния (1.1) может быть представлено в статистически эквивалентной форме в виде разностного уравнения с шагом дискретизации $\Delta = {{t}_{k}} - {{t}_{{k - 1}}}$:

(1.3)

${{{\mathbf{X}}}_{k}} = {\mathbf{\Phi }}(k,k - 1,{{A}_{k}}){{{\mathbf{X}}}_{{k - 1}}} + {\mathbf{\Gamma }}(k,k - 1,{{A}_{k}}){{{\mathbf{\Xi }}}_{{k - 1}}},\quad {{{\mathbf{X}}}_{0}} = {\mathbf{X}}_{0}^{*},$Эквивалентное дискретное представление (1.3) непрерывных моделей вектора состояния маневрирующего объекта (1.1) является абсолютно точным в том смысле, что для любых ${{t}_{k}} - {{t}_{{k - 1}}} > 0$ оно позволяет получить случайные процессы с теми же статистическими характеристиками, как и решение СДУ (1.1), без погрешностей аппроксимации [8].

Пусть в дискретные моменты времени ${{t}_{k}} = {{t}_{0}} + k\Delta $, k = 1, 2, …, уравнение измерений имеет вид

(1.4)

${{{\mathbf{Y}}}_{k}} = {\mathbf{H}}\left( {{{B}_{k}},{{C}_{k}}} \right){{{\mathbf{X}}}_{k}} + {\mathbf{V}}\left( {{{B}_{k}},{{C}_{k}}} \right){{{\mathbf{\Psi }}}_{k}},$Применительно к решаемой задаче синтеза вектор состояния представляет собой ДНМП $\left[ {{\mathbf{X}}_{k}^{{\text{T}}},{{A}_{k}},{{B}_{k}},{{C}_{k}}} \right]{{\,}^{{\text{T}}}} \equiv \left[ {{\mathbf{X}}_{k}^{{\text{T}}},{\mathbf{S}}_{k}^{{\text{T}}}} \right]{{\,}^{{\text{T}}}}$, где ${{{\mathbf{X}}}_{k}}$ – непрерывная ${{n}_{x}}$-мерная компонента ДНМП, описывающий в пространстве состояний динамику фазовых координат объекта; ${{{\mathbf{S}}}_{k}} = \left[ {{{A}_{k}},{{B}_{k}},{{C}_{k}}} \right]{{\,}^{{\text{T}}}}$ – дискретная компонента ДНМП – трехкомпонентный дискретный марковский процесс, причем марковские цепи ${{B}_{k}}$ и ${{C}_{k}}$ не зависят от ${{{\mathbf{X}}}_{k}}$ и ${{A}_{k}}$.

По условию задачи известны матрицы ${\mathbf{\Phi }}$, ${\mathbf{\Gamma }}$, ${\mathbf{H}}$, ${\mathbf{V}}$, а также начальные распределения марковского вектора, причем компоненты марковской цепи ${{A}_{k}}$, ${{B}_{k}}$ и ${{C}_{k}}$, характеризующие маневр объекта и нарушения в каналах измерений соответственно, не зависят друг от друга.

Цель работы – на основе марковской теории оценивания случайных процессов разработать оптимальные (квазиоптимальные) алгоритмы комплексной обработки ДНМП $\left[ {{\mathbf{X}}_{k}^{{\text{T}}},{{A}_{k}},{{B}_{k}},{{C}_{k}}} \right]{{\,}^{{\text{T}}}}$, характеризующего сопровождение маневрирующего объекта, по наблюдаемым в дискретном времени выходным сигналам измерителей ${{{\mathbf{Y}}}_{k}} = {{\left[ {{\mathbf{Y}}_{k}^{{(1){\text{T}}}},{\mathbf{Y}}_{k}^{{(2){\text{T}}}}} \right]}^{{{\kern 1pt} {\kern 1pt} {\text{T}}}}}$ в статистически неопределенных ситуациях.

2. Закон распределения смешанного вектора состояния дискретно-непрерывного марковского процесса. Обозначим апостериорное распределение смешанного вектора состояния $\left[ {{\mathbf{X}}_{k}^{{\text{T}}},{\mathbf{S}}_{k}^{{\text{T}}}} \right]{{\,}^{{\text{T}}}}$ по наблюдаемой последовательности измерений ${\mathbf{y}}_{1}^{k} = \left\{ {{{{\mathbf{y}}}_{1}},{{{\mathbf{y}}}_{2}},...,{{{\mathbf{y}}}_{k}}} \right\}$ как ${{w}_{{jmd}}}({\mathbf{x}}_{k}^{{}})$. Величина ${{w}_{{jmd}}}({\mathbf{x}}_{k}^{{}})d{\mathbf{x}}_{k}^{{}}$ равна вероятности одновременного выполнения условий ${\mathbf{X}}_{k}^{{}} \in ({\mathbf{x}}_{k}^{{}},{\mathbf{x}}_{k}^{{}} + d{\mathbf{x}}_{k}^{{}})$, ${{A}_{k}} = {{a}_{j}}$, ${{B}_{k}} = {{b}_{m}}$, ${{C}_{k}} = {{c}_{d}}$, где xk – детерминированное значение случайной величины Xk при условии ${\mathbf{Y}}_{1}^{k} = {\mathbf{y}}_{1}^{k}$. На основании свойств марковских процессов в дискретном времени запишем рекуррентное уравнение:

(2.1)

$w_{{jmd}}^{*}({\mathbf{x}}_{k}^{{}}) = \frac{{{{f}_{{md}}}\left( {{{{\mathbf{y}}}_{k}}\,{\text{|}}\,{{{\mathbf{x}}}_{k}}} \right)}}{{f({{{\mathbf{y}}}_{k}}\,{\text{|}}\,{\mathbf{y}}_{1}^{{k - 1}})}}\sum\limits_i {\sum\limits_n {\sum\limits_e {\pi _{{ij}}^{a}\pi _{{nm}}^{b}} } \pi _{{de}}^{c}} \int {{{f}_{j}}\left( {{{{\mathbf{x}}}_{k}}\,{\text{|}}\,{{{\mathbf{x}}}_{{k - 1}}}} \right){\kern 1pt} {\kern 1pt} w_{{ine}}^{*}({\mathbf{x}}_{{k - 1}}^{{}}){\kern 1pt} d{{{\mathbf{x}}}_{{k - 1}}}} ,$В (2.1) и далее для простоты записи аргументы k, $k{\text{--}}1$ всех функций, где это возможно и не вызывает сомнений, опущены, а интегрирование по переменной x ведется в области ${{\Re }^{{{{n}_{x}}}}}$.

Выражение (2.1) по своей сути – интегрально-рекуррентная формула Стратоновича–Бухалева [17, 18] апостериорного распределения смешанного вектора состояния ${{[{\mathbf{X}}_{k}^{{\text{T}}},{\mathbf{S}}_{k}^{{\text{T}}}]}^{{\text{T}}}}$ в дискретном времени и представляет собой решение задачи оценивания этого вектора состояния. Оптимальный алгоритм является рекуррентным и описывает эволюцию апостериорного распределения $w_{{jmd}}^{*}\left( {{{{\mathbf{x}}}_{k}}} \right)$ на каждом k-м шаге. Начальное условие $w_{{jmd}}^{*}\left( {{{{\mathbf{x}}}_{0}}} \right)$ равно известному априорному совместному распределению случайных величин ${\mathbf{X}}_{0}^{{}}$, ${{A}_{0}}$, ${{B}_{0}}$, ${{C}_{0}}$.

Вводя обозначение $\tilde {w}_{{jmd}}^{{}}({\mathbf{x}}_{k}^{{}})$ (экстраполированного по измерениям ${\mathbf{y}}_{1}^{{k - 1}} = \left\{ {{{{\mathbf{y}}}_{1}},{{{\mathbf{y}}}_{2}},...,{{{\mathbf{y}}}_{{k - 1}}}} \right\}$ распределения смешанного вектора состояния ${{[{\mathbf{X}}_{k}^{{\text{T}}},{\mathbf{S}}_{k}^{{\text{T}}}]}^{{\text{T}}}}$), перепишем (2.1) в виде цепочки из двух формул:

(2.2)

$\tilde {w}_{{jmd}}^{{}}\left( {{{{\mathbf{x}}}_{k}}} \right) = \sum\limits_i {\sum\limits_n {\sum\limits_e {\pi _{{ij}}^{a}\pi _{{nm}}^{b}{\kern 1pt} {\kern 1pt} } } \pi _{{de}}^{c}{\text{P}}_{{ine}}^{*}\left( {k - 1} \right)} \int {{{f}_{j}}\left( {{{{\mathbf{x}}}_{k}}\,{\text{|}}\,{{{\mathbf{x}}}_{{k - 1}}}} \right){\kern 1pt} {\kern 1pt} w_{{ine}}^{*}\left( {{{{\mathbf{x}}}_{{k - 1}}}} \right)\,d{{{\mathbf{x}}}_{{k - 1}}}} ,$(2.3)

$w_{{jmd}}^{*}\left( {{{{\mathbf{x}}}_{k}}} \right) = \frac{{{{f}_{{md}}}\left( {{{{\mathbf{y}}}_{k}}\,{\text{|}}\,{{{\mathbf{x}}}_{k}}} \right)}}{{f({{{\mathbf{y}}}_{k}}\,{\text{|}}\,{\mathbf{y}}_{1}^{{k - 1}})}}\tilde {w}_{{jmd}}^{{}}\left( {{{{\mathbf{x}}}_{k}}} \right).$Уравнение (2.2) описывает преобразование апостериорного распределения предыдущего шага в экстраполированное распределение ${{\tilde {w}}_{{jmd}}}\left( {{{{\mathbf{x}}}_{k}}} \right)$. С помощью соотношения (2.3) производится уточнение экстраполированного распределения на основе полученного измерения ${{{\mathbf{y}}}_{k}}$ и определяется апостериорное распределение $w_{{jmd}}^{*}\left( {{{{\mathbf{x}}}_{k}}} \right)$.

Для нахождения апостериорной вероятности дискретной компоненты ДНМП на текущем k-м шаге ${\text{P}}_{{jmd}}^{*}\left( k \right)$ проинтегрируем (2.1) по переменным ${{{\mathbf{x}}}_{k}}$, ${{{\mathbf{x}}}_{{k - 1}}}$, в результате получим систему рекуррентных уравнений:

(2.4)

${{{{\tilde {P}}}}_{{jmd}}}\left( k \right) = {\text{P}}({{A}_{k}} = {{a}_{j}},{{B}_{k}} = {{b}_{m}},{{C}_{k}} = {{c}_{d}}\,{\text{|}}\,{\kern 1pt} {\mathbf{y}}_{1}^{{k - 1}}) = \sum\limits_i {\sum\limits_n {\sum\limits_e {\pi _{{ij}}^{a}} } } \pi _{{nm}}^{b}\pi _{{ed}}^{c}{\text{P}}_{{ine}}^{*}\left( {k - 1} \right),$(2.5)

${\text{P}}_{{jmd}}^{*}\left( k \right) = {\text{P}}({{A}_{k}} = {{a}_{j}},{{B}_{k}} = {{b}_{m}},{{C}_{k}} = {{c}_{d}}\,{\text{|}}\,{\kern 1pt} {\mathbf{y}}_{1}^{k}) = \frac{{f({{{\mathbf{y}}}_{k}}\,{\text{|}}\,{{{\mathbf{x}}}_{k}},{{B}_{k}} = {{b}_{m}},{{C}_{k}} = {{c}_{d}},{\mathbf{y}}_{1}^{{k - 1}})}}{{f({{{\mathbf{y}}}_{k}}\,{\text{|}}\,{\mathbf{y}}_{1}^{{k - 1}})}}{{{{\tilde {P}}}}_{{jmd}}}\left( k \right),$(2.6)

$f({{{\mathbf{y}}}_{k}}\,{\text{|}}\,{{{\mathbf{x}}}_{k}},{{B}_{k}} = {{b}_{m}},{{C}_{k}} = {{c}_{d}},{\mathbf{y}}_{1}^{{k - 1}}) = \int {f\left( {{{{\mathbf{y}}}_{k}}\,{\text{|}}\,{{{\mathbf{x}}}_{k}},{{B}_{k}} = {{b}_{m}},{{C}_{k}} = {{c}_{d}}} \right)\tilde {w}_{{jmd}}^{{}}\left( {{{{\mathbf{x}}}_{k}}} \right)d{{{\mathbf{x}}}_{k}}} $Для нахождения условной ПВ непрерывной компоненты ДНМП $f_{{jmd}}^{*}\left( {{{{\mathbf{x}}}_{k}}} \right)$ = f(xk | Ak = aj, ${{B}_{k}} = {{b}_{m}},{{C}_{k}} = {{c}_{d}},{\mathbf{y}}_{1}^{k})$ введем в рассмотрение условную экстраполированную ПВ непрерывной компоненты ДНМП ${{\tilde {f}}_{{jmd}}}\left( {{{{\mathbf{x}}}_{k}}} \right) = f({{{\mathbf{x}}}_{k}}\,{\text{|}}\,{{A}_{k}} = {{a}_{j}},{{B}_{k}} = {{b}_{m}},{{C}_{k}} = {{c}_{d}},{\mathbf{y}}_{1}^{{k - 1}})$ и применим свойство условных распределений. В результате из (2.2) и (2.3) получим систему рекуррентных уравнений:

(2.7)

${{\tilde {f}}_{{jmd}}}\left( {{{{\mathbf{x}}}_{k}}} \right) = \sum\limits_i {\sum\limits_n {\sum\limits_e {\pi _{{ij}}^{a}} } } \pi _{{nm}}^{b}\pi _{{ed}}^{c}P_{{ine}}^{*}(k - 1)\int {{{f}_{j}}\left( {{{{\mathbf{x}}}_{k}}\,{\text{|}}\,{{{\mathbf{x}}}_{{k - 1}}}} \right)} f_{{ine}}^{*}\left( {{{{\mathbf{x}}}_{{k - 1}}}} \right)\,d{{{\mathbf{x}}}_{{k - 1}}},$(2.8)

$f_{{jmd}}^{*}\left( {{{{\mathbf{x}}}_{k}}} \right) = \frac{{f\left( {{{{\mathbf{y}}}_{k}}\,{\text{|}}\,{{{\mathbf{x}}}_{k}},{{B}_{k}} = {{b}_{m}},{{C}_{k}} = {{c}_{d}}} \right)}}{{f({{{\mathbf{y}}}_{k}}\,{\text{|}}\,{{{\mathbf{x}}}_{k}},{{B}_{k}} = {{b}_{m}},{{C}_{k}} = {{c}_{d}},{\mathbf{y}}_{1}^{{k - 1}})}}{{\tilde {f}}_{{jmd}}}\left( {{{{\mathbf{x}}}_{k}}} \right),$Синтезированный алгоритм совместной фильтрации компонент ДНМП (2.5)–(2.8) является нелинейным даже для линейных априорных уравнений (1.3), (1.4). Нелинейные операции выполняются при вычислении условной ПВ (2.6), используемой для определения апостериорных вероятностей (2.5). Особенность синтезированного алгоритма состоит в неразрывной связанности уравнений фильтрации и экстраполяции дискретного и непрерывного компонентов между собой.

3. Квазиоптимальный алгоритм оценивания вектора состояния дискретно-непрерывного марковского процесса. Практическая реализация синтезированного оптимального алгоритма совместной фильтрации компонент ДНМП (2.5)–(2.8) встречает значительные трудности. Они обусловлены требованием больших объемов памяти и быстродействия вычислителя при выполнении численного интегрирования многомерных ПВ. Поэтому представляет большой интерес синтез квазиоптимальных алгоритмов фильтрации и экстраполяции [8, 19].

Существует большое количество различных методов синтеза квазиоптимальных алгоритмов нелинейного оценивания [17, 18]. Наибольшее распространение получил метод гауссовской аппроксимации, который требует минимальных вычислительных затрат по сравнению с остальными методами и во многих случаях позволяет задать требуемое качество оценивания, несмотря на приближенное нахождение компонент ДНМП. Для этого необходимо выполнить двухмоментную параметрическую гауссовскую аппроксимацию апостериорного распределения $w_{{ine}}^{*}\left( {{{{\mathbf{x}}}_{{k - 1}}}} \right)$. Эта аппроксимация состоит в замене этой неизвестной функции некоторыми известными функциями, в частности условными математическим ожиданием и ковариационной функцией, случайные значения которых определяются так:

Применяя, таким образом, на каждом k-м шаге гауссовскую аппроксимацию для условного апостериорного распределения $w_{{ine}}^{*}\left( {{{{\mathbf{x}}}_{{k - 1}}}} \right)$, можно показать, что квазиоптимальный алгоритм фильтрации непрерывного компонента ДНМП описывается системой рекуррентных уравнений, вывод которых приводится в Приложении.

Вектор текущей условной оценки непрерывного компонента ДНМП и ковариационная матрица ее погрешностей

(3.1)

${\mathbf{X}}_{{jmd}}^{*}\left( k \right) = {{{\mathbf{\tilde {X}}}}_{{jmd}}}\left( k \right) + {\mathbf{K}}_{{jmd}}^{{(1)}}\left( k \right){\kern 1pt} {\kern 1pt} \left( {{\mathbf{Y}}_{k}^{{(1)}} - {\mathbf{\tilde {Y}}}_{{jmd}}^{{(1)}}\left( k \right)} \right) + {\mathbf{K}}_{{jmd}}^{{(2)}}\left( k \right){\kern 1pt} {\kern 1pt} \left( {{\mathbf{Y}}_{k}^{{(2)}} - {\mathbf{\tilde {Y}}}_{{jmd}}^{{(2)}}\left( k \right)} \right),$(3.2)

${\mathbf{R}}_{{jmd}}^{*}\left( k \right) = {\mathbf{\tilde {R}}}_{{jmd}}^{{}}\left( k \right) - {{\left[ {\begin{array}{*{20}{c}} {{\mathbf{H}}_{1}^{{\text{T}}}\left( {{{b}_{m}}} \right){\kern 1pt} {\kern 1pt} {\mathbf{\tilde {R}}}_{{jmd}}^{{}}} \\ {{\mathbf{H}}_{2}^{{\text{T}}}\left( {{{c}_{d}}} \right){\kern 1pt} {\kern 1pt} {\mathbf{\tilde {R}}}_{{jmd}}^{{}}} \end{array}} \right]}^{{\text{T}}}}{{\left[ {\begin{array}{*{20}{c}} {{\mathbf{\tilde {W}}}_{{jmd}}^{{(11)}}}&{{\mathbf{\tilde {W}}}_{{jmd}}^{{(12)}}} \\ {{\mathbf{\tilde {W}}}_{{jmd}}^{{(21)}}}&{{\mathbf{\tilde {W}}}_{{jmd}}^{{(22)}}} \end{array}} \right]}^{{ - 1}}}\left[ {\begin{array}{*{20}{c}} {{\mathbf{H}}_{1}^{{}}\left( {{{b}_{m}}} \right){\kern 1pt} {\kern 1pt} {\mathbf{\tilde {R}}}_{{jmd}}^{{}}} \\ {{\mathbf{H}}_{2}^{{}}\left( {{{c}_{d}}} \right){\kern 1pt} {\kern 1pt} {\mathbf{\tilde {R}}}_{{jmd}}^{{}}} \end{array}} \right].$Здесь

1) ${\mathbf{K}}_{{jmd}}^{{(1)}}\left( k \right)$ и ${\mathbf{K}}_{{jmd}}^{{(2)}}\left( k \right)$ – оптимальные коэффициенты передачи:

(3.3)

$\begin{gathered} {\mathbf{K}}_{{jmd}}^{{(1)}}\left( k \right) = {{{{\mathbf{\tilde {R}}}}}_{{jmd}}}\left( k \right){\kern 1pt} {\kern 1pt} {\mathbf{H}}_{1}^{{\text{T}}}\left( {{{b}_{m}}} \right){\kern 1pt} {\kern 1pt} {{({\mathbf{\tilde {W}}}_{{jmd}}^{{(11)}}\left( k \right) - {\mathbf{\tilde {W}}}_{{jmd}}^{{(12)}}\left( k \right){\kern 1pt} {\kern 1pt} {{({\mathbf{\tilde {W}}}_{{jmd}}^{{(11)}}\left( k \right))}^{{\, - 1}}}{\mathbf{\tilde {W}}}_{{jmd}}^{{(21)}}\left( k \right))}^{{ - 1}}} - \\ \, - {{{{\mathbf{\tilde {R}}}}}_{{jmd}}}\left( k \right){\kern 1pt} {\kern 1pt} {\mathbf{H}}_{2}^{{\text{T}}}\left( {{{c}_{d}}} \right)\,{{({\mathbf{\tilde {W}}}_{{jmd}}^{{(22)}}\left( k \right) - {\mathbf{\tilde {W}}}_{{jmd}}^{{(21)}}\left( k \right){\kern 1pt} {\kern 1pt} {{({\mathbf{\tilde {W}}}_{{jmd}}^{{(22)}}\left( k \right))}^{{ - 1}}}{\mathbf{\tilde {W}}}_{{jmd}}^{{(21)}}\left( k \right))}^{{ - 1}}}, \\ \end{gathered} $(3.4)

$\begin{gathered} {\mathbf{K}}_{{jmd}}^{{(2)}}\left( k \right) = - {{{{\mathbf{\tilde {R}}}}}_{{jmd}}}{\mathbf{H}}_{1}^{{\text{T}}}\left( {{{b}_{m}}} \right){\kern 1pt} {\kern 1pt} {{({\mathbf{\tilde {W}}}_{{jmd}}^{{(11)}} - {\mathbf{\tilde {W}}}_{{jmd}}^{{(12)}}{{({\mathbf{\tilde {W}}}_{{jmd}}^{{(22)}})}^{{ - 1}}}{\mathbf{\tilde {W}}}_{{jmd}}^{{(21)}})}^{{ - 1}}}{{({\mathbf{\tilde {W}}}_{{jmd}}^{{(22)}})}^{{{\kern 1pt} - 1}}}{\mathbf{\tilde {W}}}_{{jmd}}^{{(21)}} + \\ \, + {{{{\mathbf{\tilde {R}}}}}_{{jmd}}}{\mathbf{H}}_{2}^{{\text{T}}}\left( {{{c}_{d}}} \right){\kern 1pt} ({{({\mathbf{\tilde {W}}}_{{jmd}}^{{(22)}})}^{{{\kern 1pt} {\kern 1pt} - 1}}} + {{({\mathbf{\tilde {W}}}_{{jmd}}^{{(22)}})}^{{{\kern 1pt} {\kern 1pt} - 1}}}{\mathbf{\tilde {W}}}_{{jmd}}^{{(21)}}{{({\mathbf{\tilde {W}}}_{{jmd}}^{{(11)}} - {\mathbf{\tilde {W}}}_{{jmd}}^{{(12)}}{{({\mathbf{\tilde {W}}}_{{jmd}}^{{(22)}})}^{{{\kern 1pt} - 1}}}{\mathbf{\tilde {W}}}_{{jmd}}^{{(21)}})}^{{ - 1}}}){\kern 1pt} {\mathbf{\tilde {W}}}_{{jmd}}^{{(21)}}{{({\mathbf{\tilde {W}}}_{{jmd}}^{{(22)}})}^{{ - 1}}}; \\ \end{gathered} $2) ${{{\mathbf{\tilde {X}}}}_{{jmd}}}(k)$ – условно-прогнозная оценка непрерывного компонента ДНМП при условии Ak = aj, ${{B}_{k}} = {{b}_{m}}$, ${{C}_{k}} = {{c}_{d}}$ и ${{{\mathbf{\tilde {R}}}}_{{jmd}}}\left( k \right)$ – ковариационная матрица погрешностей предсказания:

(3.5)

${{{\mathbf{\tilde {X}}}}_{{jmd}}}\left( k \right) = \sum\limits_i {\sum\limits_n {\sum\limits_e {\pi _{{ij}}^{a}} } } \pi _{{nm}}^{b}\pi _{{ed}}^{c}\frac{{P_{{ine}}^{*}(k - 1)}}{{{{{\tilde {P}}}_{{jmd}}}(k)}}{\mathbf{\Phi }}\left( {{{a}_{j}}} \right){\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\mathbf{X}}_{{ine}}^{*}\left( {k - 1} \right),$(3.6)

$\begin{gathered} {{{{\mathbf{\tilde {R}}}}}_{{jmd}}}\left( k \right) = \sum\limits_i {\sum\limits_n {\sum\limits_e {\pi _{{ij}}^{a}} } } \pi _{{nm}}^{b}\pi _{{ed}}^{c}\frac{{P_{{ine}}^{*}(k - 1)}}{{{{{\tilde {P}}}_{{jmd}}}(k)}}\{ {\mathbf{\Phi }}\left( {{{a}_{j}}} \right){\kern 1pt} {\mathbf{R}}_{{ine}}^{*}\left( {k - 1} \right){\kern 1pt} {\kern 1pt} {{{\mathbf{\Phi }}}^{{\text{T}}}}\left( {{{a}_{j}}} \right) + {\mathbf{\Gamma }}{\kern 1pt} {\kern 1pt} \left( {{{a}_{j}}} \right){\kern 1pt} {\kern 1pt} {{{\mathbf{\Gamma }}}^{{\text{T}}}}\left( {{{a}_{j}}} \right)\mathop + \limits_{_{{_{{_{{_{{}}}}}}}}} \\ \, + [{\mathbf{\Phi }}\left( {{{a}_{j}}} \right){\kern 1pt} {\kern 1pt} {\mathbf{X}}_{{ine}}^{*}\left( {k - 1} \right) - {{{{\mathbf{\tilde {X}}}}}_{{jmd}}}\left( k \right)] \times {{[{\mathbf{\Phi }}\left( {{{a}_{j}}} \right){\kern 1pt} {\kern 1pt} {\mathbf{X}}_{{ine}}^{*}\left( {k - 1} \right) - {{{{\mathbf{\tilde {X}}}}}_{{jmd}}}\left( k \right)]}^{{\text{T}}}}\} ; \\ \end{gathered} $3) ${\mathbf{\tilde {Y}}}_{{jmd}}^{{(1)}}\left( k \right)$, ${\mathbf{\tilde {Y}}}_{{jmd}}^{{(2)}}\left( k \right)$ – прогнозируемые значения векторов измерений и ${{{\mathbf{\tilde {W}}}}_{{jmd}}}\left( k \right)$ – условная блочная ковариационная матрица погрешностей предсказания измерений:

(3.7)

${\mathbf{\tilde {Y}}}_{{jmd}}^{{(1)}}\left( k \right) = \sum\limits_i {\sum\limits_n {\sum\limits_e {\pi _{{ij}}^{a}} } } \pi _{{nm}}^{b}\pi _{{ed}}^{c}\frac{{{\text{P}}_{{ine}}^{*}(k - 1)}}{{{{{{{\tilde {P}}}}}_{{jmd}}}(k)}}{{{\mathbf{H}}}_{1}}\left( {{{b}_{m}}} \right){\kern 1pt} {\kern 1pt} {\mathbf{\Phi }}\left( {{{a}_{j}}} \right){\kern 1pt} {\kern 1pt} {\mathbf{X}}_{{ine}}^{*}\left( {k - 1} \right),$(3.8)

${\mathbf{\tilde {Y}}}_{{jmd}}^{{(2)}}\left( k \right) = \sum\limits_i {\sum\limits_n {\sum\limits_e {\pi _{{ij}}^{a}} } } \pi _{{nm}}^{b}\pi _{{ed}}^{c}\frac{{{\text{P}}_{{ine}}^{*}(k - 1)}}{{{{{{{\tilde {P}}}}}_{{jmd}}}(k)}}{{{\mathbf{H}}}_{2}}\left( {{{c}_{d}}} \right){\kern 1pt} {\mathbf{\Phi }}\left( {{{a}_{j}}} \right){\kern 1pt} {\kern 1pt} {\mathbf{X}}_{{ine}}^{*}\left( {k - 1} \right),$(3.9)

${{{\mathbf{\tilde {W}}}}_{{jmd}}}\left( k \right) = \left[ {\begin{array}{*{20}{c}} {{\mathbf{\tilde {W}}}_{{jmd}}^{{(11)}}}&{{\mathbf{\tilde {W}}}_{{jmd}}^{{(12)}}} \\ {{\mathbf{\tilde {W}}}_{{jmd}}^{{(21)}}}&{{\mathbf{\tilde {W}}}_{{jmd}}^{{(22)}}} \end{array}} \right],$(3.10)

$\begin{gathered} {\mathbf{\tilde {W}}}_{{jmd}}^{{(11)}} = \sum\limits_i {\sum\limits_n {\sum\limits_e {\pi _{{ij}}^{a}} } } \pi _{{nm}}^{b}\pi _{{ed}}^{c}\frac{{{\text{P}}_{{ine}}^{*}(k - 1)}}{{{{{{{\tilde {P}}}}}_{{jmd}}}(k)}}\left\{ {{{{\mathbf{H}}}_{1}}\left( {{{b}_{m}}} \right){\kern 1pt} {\kern 1pt} {\mathbf{\Phi }}\left( {{{a}_{j}}} \right){\kern 1pt} {\kern 1pt} {\mathbf{X}}_{{ine}}^{*}\left( {k - 1} \right){\kern 1pt} {\kern 1pt} {{{\mathbf{\Phi }}}^{{\text{T}}}}\left( {{{a}_{j}}} \right){\kern 1pt} {\kern 1pt} {\mathbf{H}}_{1}^{{\text{T}}}\left( {{{b}_{m}}} \right) + {{{\mathbf{V}}}_{1}}\left( {{{b}_{m}}} \right){\kern 1pt} {\kern 1pt} {\mathbf{V}}_{1}^{{\text{T}}}\left( {{{b}_{m}}} \right)\mathop + \limits_{_{{_{{_{{_{{}}}}}}}}} } \right. \\ \, + \left[ {{{{\mathbf{H}}}_{1}}\left( {{{B}_{k}}} \right){\mathbf{\Phi }}\left( {{{a}_{j}}} \right){\mathbf{X}}_{{ine}}^{*}\left( {k - 1} \right) - {\mathbf{\tilde {Y}}}_{{jmd}}^{{(1)}}\left( k \right)} \right] \times \left. {{{{\left[ {{{{\mathbf{H}}}_{1}}\left( {{{b}_{m}}} \right){\mathbf{\Phi }}\left( {{{a}_{j}}} \right){\mathbf{X}}_{{ine}}^{*}\left( {k - 1} \right) - {\mathbf{\tilde {Y}}}_{{jmd}}^{{(1)}}\left( k \right)} \right]}}^{{\text{T}}}}} \right\}, \\ \end{gathered} $(3.11)

$\begin{gathered} {\mathbf{\tilde {W}}}_{{jmd}}^{{(12)}} = \sum\limits_i {\sum\limits_n {\sum\limits_e {\pi _{{ij}}^{a}} } } \pi _{{nm}}^{b}\pi _{{ed}}^{c}\frac{{{\text{P}}_{{ine}}^{*}(k - 1)}}{{{{{{{\tilde {P}}}}}_{{jmd}}}(k)}}\left\{ {{\kern 1pt} {\kern 1pt} {{{\mathbf{H}}}_{1}}\left( {{{b}_{m}}} \right){\kern 1pt} {\kern 1pt} {\mathbf{\Phi }}\left( {{{a}_{j}}} \right){\kern 1pt} {\kern 1pt} {\mathbf{X}}_{{ine}}^{*}\left( {k - 1} \right){\kern 1pt} {\kern 1pt} {{{\mathbf{\Phi }}}^{{\text{T}}}}\left( {{{a}_{j}}} \right){\mathbf{H}}_{2}^{{\text{T}}}\left( {{{c}_{d}}} \right)\mathop + \limits_{_{{_{{_{{_{{}}}}}}}}} } \right. \\ \, + \left[ {{{{\mathbf{H}}}_{1}}\left( {{{b}_{m}}} \right){\mathbf{\Phi }}\left( {{{a}_{j}}} \right){\mathbf{X}}_{{ine}}^{*}\left( {k - 1} \right) - {\mathbf{\tilde {Y}}}_{{jmd}}^{{(1)}}\left( k \right)} \right] \times \left. {{{{\left[ {{\kern 1pt} {\kern 1pt} {{{\mathbf{H}}}_{2}}\left( {{{c}_{d}}} \right){\mathbf{\Phi }}\left( {{{a}_{j}}} \right){\mathbf{X}}_{{ine}}^{*}\left( {k - 1} \right) - {\mathbf{\tilde {Y}}}_{{jmd}}^{{(2)}}\left( k \right)} \right]}}^{{\text{T}}}}} \right\}, \\ \end{gathered} $(3.12)

$\begin{gathered} {\mathbf{\tilde {W}}}_{{jmd}}^{{(21)}} = \sum\limits_i {\sum\limits_n {\sum\limits_e {\pi _{{ij}}^{a}} } } \pi _{{nm}}^{b}\pi _{{ed}}^{c}\frac{{P_{{ine}}^{*}(k - 1)}}{{{{{\tilde {P}}}_{{jmd}}}(k)}}\left\{ {{{{\mathbf{H}}}_{2}}\left( {{{C}_{k}}} \right){\kern 1pt} {\kern 1pt} {\mathbf{\Phi }}\left( {{{A}_{k}}} \right){\kern 1pt} {\kern 1pt} {\mathbf{X}}_{{ine}}^{*}\left( {k - 1} \right){\kern 1pt} {\kern 1pt} {{{\mathbf{\Phi }}}^{{\text{T}}}}\left( {{{A}_{k}}} \right){\kern 1pt} {\kern 1pt} {\mathbf{H}}_{1}^{{\text{T}}}\left( {{{B}_{k}}} \right)\mathop + \limits_{_{{_{{_{{_{{}}}}}}}}} } \right. \\ \, + \left[ {{{{\mathbf{H}}}_{2}}\left( {{{C}_{k}}} \right){\mathbf{\Phi }}\left( {{{A}_{k}}} \right){\mathbf{X}}_{{ine}}^{*}\left( {k - 1} \right) - {\mathbf{\tilde {Y}}}_{{jmd}}^{{(2)}}\left( k \right)} \right] \times \left. {{{{\left[ {{{{\mathbf{H}}}_{1}}\left( {{{B}_{k}}} \right){\mathbf{\Phi }}\left( {{{A}_{k}}} \right){\mathbf{X}}_{{ine}}^{*}\left( {k - 1} \right) - {\mathbf{\tilde {Y}}}_{{jmd}}^{{(1)}}\left( k \right)} \right]}}^{{\text{T}}}}} \right\}, \\ \end{gathered} $(3.13)

$\begin{gathered} {\mathbf{\tilde {W}}}_{{jmd}}^{{(22)}} = \sum\limits_i {\sum\limits_n {\sum\limits_e {\pi _{{ij}}^{a}} } } \pi _{{nm}}^{b}\pi _{{ed}}^{c}\frac{{{\text{P}}_{{ine}}^{*}(k - 1)}}{{{{{{{\tilde {P}}}}}_{{jmd}}}(k)}}\left\{ {{{{\mathbf{H}}}_{2}}\left( {{{c}_{d}}} \right){\kern 1pt} {\kern 1pt} {\mathbf{\Phi }}\left( {{{a}_{j}}} \right){\kern 1pt} {\kern 1pt} {\mathbf{X}}_{{ine}}^{*}\left( {k - 1} \right){{{\mathbf{\Phi }}}^{{\text{T}}}}\left( {{{a}_{j}}} \right){\mathbf{H}}_{2}^{{\text{T}}}\left( {{{c}_{d}}} \right) + {{{\mathbf{V}}}_{2}}\left( {{{c}_{d}}} \right){\kern 1pt} {\mathbf{V}}_{2}^{{\text{T}}}\left( {{{c}_{d}}} \right)\mathop + \limits_{_{{_{{_{{_{{}}}}}}}}} } \right. \\ \, + \left[ {{{{\mathbf{H}}}_{2}}\left( {{{c}_{d}}} \right){\kern 1pt} {\kern 1pt} {\mathbf{\Phi }}\left( {{{a}_{j}}} \right){\kern 1pt} {\kern 1pt} {\mathbf{X}}_{{ine}}^{*}\left( {k - 1} \right) - {\mathbf{\tilde {Y}}}_{{jmd}}^{{(2)}}\left( k \right)} \right] \times \left. {{{{\left[ {{{{\mathbf{H}}}_{2}}\left( {{{c}_{d}}} \right){\kern 1pt} {\kern 1pt} {\mathbf{\Phi }}\left( {{{a}_{j}}} \right){\kern 1pt} {\mathbf{X}}_{{ine}}^{*}\left( {k - 1} \right) - {\mathbf{\tilde {Y}}}_{{jmd}}^{{(2)}}\left( k \right)} \right]}}^{{\text{T}}}}} \right\} \\ \end{gathered} $При этом начальные условия для квазиоптимального алгоритма КОИ (2.4), (2.5), (3.1)–(3.13):

Уравнения оценивания апостериорной вероятности дискретной компоненты ДНМП (2.4), (2.5) остаются без изменения, а условная ПВ одношагового предсказания наблюдаемых сигналов (2.6) имеет вид [15]

(3.14)

$\begin{gathered} f\left( {{{{\mathbf{Y}}}_{k}}|{{{\mathbf{X}}}_{k}},{{B}_{k}} = {{b}_{m}},{{C}_{k}} = {{c}_{d}},{\mathbf{Y}}_{1}^{{k - 1}}} \right) = \frac{1}{{\sqrt {{{{\left( {2\pi } \right)}}^{{\left( {{{n}_{{y1}}} + {{n}_{{y2}}}} \right)}}}\det \left\{ {{{{{\mathbf{\tilde {W}}}}}_{{jmd}}}} \right\}} }}\exp \left\{ { - \frac{1}{2}\left[ {\begin{array}{*{20}{c}} {{\mathbf{Y}}_{k}^{{(1)}} - {\mathbf{\tilde {Y}}}_{{jmd}}^{{(1)}}\left( k \right)} \\ {{\mathbf{Y}}_{k}^{{(2)}} - {\mathbf{\tilde {Y}}}_{{jmd}}^{{(2)}}\left( k \right)} \end{array}} \right]} \right. \times \\ \, \times \left. {{{{\left[ {\begin{array}{*{20}{c}} {{\mathbf{\tilde {W}}}_{{jmd}}^{{(11)}}}&{{\mathbf{\tilde {W}}}_{{jmd}}^{{(12)}}} \\ {{\mathbf{\tilde {W}}}_{{jmd}}^{{(21)}}}&{{\mathbf{\tilde {W}}}_{{jmd}}^{{(22)}}} \end{array}} \right]}}^{{{\kern 1pt} {\kern 1pt} - 1}}}{{{\left[ {\begin{array}{*{20}{c}} {{\mathbf{Y}}_{k}^{{(1)}} - {\mathbf{\tilde {Y}}}_{{jmd}}^{{(1)}}\left( k \right)} \\ {{\mathbf{Y}}_{k}^{{(2)}} - {\mathbf{\tilde {Y}}}_{{jmd}}^{{(2)}}\left( k \right)} \end{array}} \right]}}^{{\text{T}}}}} \right\}. \\ \end{gathered} $Задача КОИ при сопровождении маневрирующего объекта считается решенной, если на выходе оптимального фильтра на каждом k-м шаге формируется оптимальная оценка, соответствующая определенному критерию оптимальности. Байесовское решение может быть получено на основе минимизации апостериорного риска [20], который применительно к решаемой задаче имеет вид

(3.15)

${\mathbf{u}}_{k}^{o} = ({\mathbf{x}}_{k}^{o},{{A}_{k}} = a_{j}^{o},{{B}_{k}} = b_{m}^{o},{{C}_{k}} = c_{d}^{o}) = \mathop {\arg \min }\limits_{{{{{\mathbf{\overset{\lower0.5em\hbox{$\smash{\scriptscriptstyle\smile}$}}{x} }}}}_{k}},j,m,d} \sum\limits_{{{\mu }} = 1}^{{{M}_{1}}} {\sum\limits_{{{\nu }} = 1}^{{{M}_{2}}} {\sum\limits_{{{\eta }} = 1}^{{{M}_{3}}} {\int {{{g}_{{jmd\mu \nu \eta }}}\left( {{{{\mathbf{x}}}_{k}},{{{{\mathbf{\overset{\lower0.5em\hbox{$\smash{\scriptscriptstyle\smile}$}}{x} }}}}_{k}}} \right){\kern 1pt} w_{{jmd}}^{*}\left( {{{{\mathbf{x}}}_{k}}} \right){\kern 1pt} d{{{\mathbf{x}}}_{k}}} } } } ,$При решении многих практических задач малым ошибкам непрерывного компонента соответствуют меньшие потери. В таких случаях применяется функция потерь [15], простая по дискретному и квадратичная по непрерывному компонентам:

(3.16)

${{g}_{{jmd\mu \nu \eta }}}\left( {{{{\mathbf{x}}}_{k}},{{{{\mathbf{\overset{\lower0.5em\hbox{$\smash{\scriptscriptstyle\smile}$}}{x} }}}}_{k}}} \right) = \alpha \left( {1 - {{{{\delta }}}_{{jmd\mu \nu \eta }}}} \right) + \beta {{{{\delta }}}_{{jmd\mu \nu \eta }}}{{\left( {{{{\mathbf{x}}}_{k}} - {{{{\mathbf{\overset{\lower0.5em\hbox{$\smash{\scriptscriptstyle\smile}$}}{x} }}}}_{k}}} \right)}^{{\text{T}}}}\left( {{{{\mathbf{x}}}_{k}} - {{{{\mathbf{\overset{\lower0.5em\hbox{$\smash{\scriptscriptstyle\smile}$}}{x} }}}}_{k}}} \right),$Функция потерь (3.16) означает, что при любом неправильном определении значений дискретного компонента потери равны коэффициенту α, а при правильном принятии решения потери пропорциональны сумме квадратов ошибок оценки непрерывного компонента. Подставляя выражение (3.16) в (3.15) и выполняя минимизацию апостериорного риска, можно показать, что решающее правило имеет следующий вид:

(3.17)

$\begin{gathered} {\text{если}}\quad {\text{P}}_{{jmd}}^{*}(k)\left\{ {{{\alpha }} + } \right.{{\beta Tr}}\{ {\mathbf{R}}_{{jmd}}^{*}\left( k \right)\} \geqslant P_{{{{\mu \nu \eta }}}}^{*}(k)\left\{ {{{\alpha }} + } \right.{{\beta Tr}}\{ {\mathbf{R}}_{{{{\mu \nu \eta }}}}^{*}\left( k \right)\} ,\quad {\text{то}} \\ {\mathbf{X}}_{k}^{o} = {\mathbf{X}}_{{jmd}}^{*}\left( k \right),\quad a_{j}^{o} = a_{j}^{*},\quad b_{m}^{o} = b_{m}^{*},\quad c_{d}^{o} = c_{d}^{*}, \\ \end{gathered} $Таким образом, в качестве безусловной оценки непрерывного компонента ДНМП выступает условное апостериорное математическое ожидание ${\mathbf{X}}_{{jmd}}^{*}\left( k \right)$. Из (3.17) следует, что принятие решения сводится к максимизации взвешенных апостериорных вероятностей дискретных компонент ДНМП. При этом следует отметить, что с увеличением погрешности оценки непрерывного компонента ДНМП уменьшаются веса погрешностей оценки дискретных компонент ДНМП. В результате может приниматься гипотеза с меньшей апостериорной вероятностью, но и с меньшими погрешностями оценки непрерывного компонента ДНМП, т.е. может отвергаться гипотеза с большей апостериорной вероятностью.

Условная ковариационная матрица ${\mathbf{R}}_{{jmd}}^{*}\left( k \right)$ характеризует качество оценки при правильном определении значений дискретных компонент ${{A}_{k}} = {{a}_{j}}$, ${{B}_{k}} = {{b}_{m}}$, ${{C}_{k}} = {{c}_{d}}$. Безусловная ковариационная матрица ${\mathbf{R}}{\kern 1pt} {\text{*}}(k)$ погрешностей оценки непрерывного компонента ДНМП определяется по формуле

(3.18)

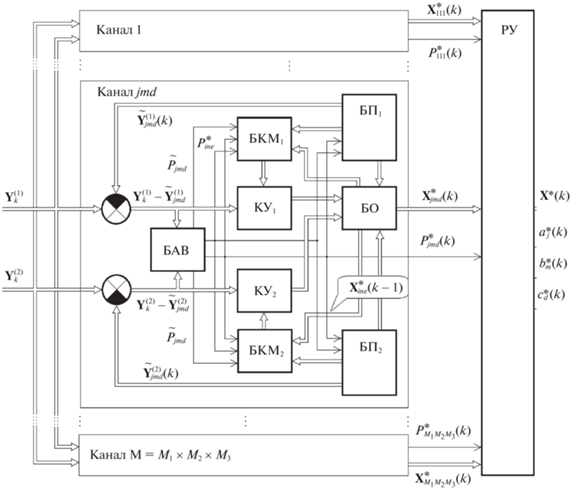

${\mathbf{R}}{\kern 1pt} {\text{*}}(k) = \sum\limits_j {\sum\limits_m {\sum\limits_d {\pi _{{ij}}^{a}\pi _{{nm}}^{b}\pi _{{ed}}^{c}{\text{P}}_{{jmd}}^{*}(k)} } } ({\mathbf{R}}_{{jmd}}^{*}(k) + ({\mathbf{X}}_{{jmd}}^{*}(k) - {\mathbf{X}}_{k}^{*}){\kern 1pt} {\kern 1pt} {{({\mathbf{X}}_{{jmd}}^{*}(k) - {\mathbf{X}}_{k}^{*})}^{{\text{T}}}}.$Квазиоптимальный цифровой фильтр КОИ (рис. 1), реализующий алгоритм (2.4), (2.5)–(3.14), (3.16)–(3.18), является многоканальным с числом каналов $M = {{M}_{1}} \times {{M}_{2}} \times {{M}_{3}}$ и в основном сохраняет структуру и все обратные связи, присущие оптимальному устройству. Каждый канал состоит из блоков КУ1 и КУ2 – вычисления коэффициентов усиления ${\mathbf{K}}_{{jmd}}^{{(1)}}\left( k \right)$ и ${\mathbf{K}}_{{jmd}}^{{(2)}}\left( k \right)$; блока оценки (БО), в котором рассчитываются ${\mathbf{X}}_{{jmd}}^{*}\left( k \right)$, ${\mathbf{X}}_{{ine}}^{*}\left( {k - 1} \right)$; блоков прогноза БП1 и БП2, в которых вычисляются ${{{\mathbf{\tilde {X}}}}_{{jmd}}}\left( k \right)$, ${\mathbf{\tilde {Y}}}_{{jmd}}^{{(1)}}\left( k \right)$, ${\mathbf{\tilde {Y}}}_{{jmd}}^{{(2)}}\left( k \right)$; блока апостериорных вероятностей (БАВ), в котором рассчитываются ${\text{P}}_{{jmd}}^{*}(k)$, ${\text{P}}_{{ine}}^{*}(k - 1)$, ${{{{\tilde {P}}}}_{{jmd}}}(k)$, и блоков вычисления корреляционных матриц БКМ1 и БКМ2, в которых вычисляются ${{{\mathbf{\tilde {R}}}}_{{jmd}}}\left( k \right)$, ${{{\mathbf{\tilde {W}}}}_{{jmd}}}\left( k \right)$, ${\mathbf{R}}_{{jmd}}^{*}\left( k \right)$ и ${\mathbf{R}}_{{ine}}^{*}(k - 1)$. Окончательное решение о принятии безусловных оценок ${\mathbf{X}}_{k}^{*} = {\mathbf{X}}_{{jmd}}^{*}\left( k \right)$, ${{A}_{k}} = a_{j}^{*}$, ${{B}_{k}} = b_{m}^{*}$, ${{C}_{k}} = c_{d}^{*}$ производится в решающем устройстве (РУ).

4. Пример. Приведены результаты моделирования алгоритма сопровождения маневрирующей цели в горизонтальной плоскости в условиях нарушений в каналах измерений угла пеленга. По условиям постановки задачи исходные вектор состояния ${\mathbf{X}}(t)$ и коэффициенты матриц априорного уравнения (1.1) определяются из системы СДУ:

Исходный вектор наблюдения ${\mathbf{Y}}(k)$ и коэффициенты матриц априорного уравнения (1.4) определяются как

(4.2)

${\mathbf{Y}}_{k}^{{(1)}} = {{[Y_{k}^{{(11)}}\,\,Y_{k}^{{(12)}}]}^{{\text{T}}}},\quad {\mathbf{Y}}_{k}^{{(2)}} \equiv Y_{k}^{{(2)}},\quad {\mathbf{H}}\left( {{{C}_{k}}} \right) = \left[ {{{h}_{{ij}}}} \right],\quad {\mathbf{V}}\left( {{{B}_{k}}} \right) = {\text{diag}}\left[ {\begin{array}{*{20}{c}} {\sqrt {{{B}_{k}}\sigma _{{y11}}^{2}} }&{\sqrt {{{B}_{k}}\sigma _{{y12}}^{2}} }&{\sqrt {\sigma _{{y2}}^{2}} } \end{array}} \right],$Проверка качества квазиоптимального алгоритма проведена с помощью статистического моделирования на электронно-вычислительной машине для случая, когда параметры уравнений (4.1), (4.2) равны: ${{\tau }_{{\text{м}}}}$ = 10 c, $\chi $ = 0.16 рад/с, $\Delta $ = 1 с, $\sigma _{{y11}}^{{}}$ = 0.01 рад; $\sigma _{{y12}}^{{}}$ = 0.02 рад; $\sigma _{{y2}}^{{}}$ = 0.5 м/с; а цепи Маркова принимают значения ${{a}_{1}}$ = 1, ${{a}_{2}}$ = 5; ${{b}_{1}}$ = 1, ${{b}_{2}}$ = 10; ${{c}_{1}}$ = 1, ${{c}_{2}}$ = 10. Вероятности перехода $\pi _{{11}}^{a}$ = $\pi _{{11}}^{b}$ = $\pi _{{11}}^{c}$ = 0.8; $\pi _{{12}}^{a}$ = $\pi _{{12}}^{b}$ = $\pi _{{12}}^{c}$ = 0.2. В целях повышения наглядности функционирования алгоритма была сформирована тестовая реализация для дискретных компонент ${{B}_{k}}$, ${{C}_{k}}$. При этом было принято, что длина реализации $k = \overline {1,200} $, а цепи Маркова запишем как

Ускорение объекта изменяется по следующему закону:

Определение статистических характеристик квазиоптимальных алгоритмов КОИ проводилось методом Монте-Карло, при этом тестовая реализация дискретной цепи Маркова $A\left( k \right)$ сохранялась неизменной, а независимые гауссовские последовательности ${{\Xi }_{1}}(k)$, ${{\Xi }_{2}}(k)$, ${{\Psi }_{1}}(k)$ – ${{\Psi }_{3}}(k)$ формировались с помощью датчика случайных чисел. Для определения оценок дискретного и непрерывного компонентов использовалось решающее правило (3.16)–(3.17), для которого коэффициенты потерь принимали значения $\alpha = 1$, $\beta = 0$.

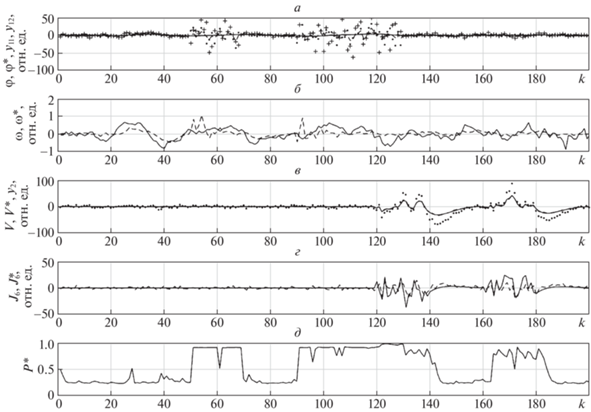

Результаты моделирования приведены на рис. 2, где показаны зависимости от дискретного времени: а) φ(k) – угла визирования объекта (сплошная), φ*(k) – оценки угла визирования объекта (пунктир), ${{y}_{{11}}}(k)$ – измерений активным каналом (точки), ${{y}_{{12}}}(k)$ – измерений пассивным каналом (крестики); б) $\omega \left( k \right)$ – угловой скорости линии визирования (сплошная), ω*(k) – оценки угловой скорости линии визирования (пунктир); в) V – скорости объекта, V* – оценки скорости объекта (пунктир), ${{y}_{2}}(k)$ – измерений скорости объекта (точки); г) ${{J}_{{\text{б}}}}$ – бокового ускорения объекта (сплошная), $J_{{\text{б}}}^{*}$ – оценки бокового ускорения объекта (пунктир); д) $P{\kern 1pt} *$ – совместной вероятности правильного обнаружения нарушений в каналах измерений и маневров объекта.

Данные рис. 2 показывают работоспособность квазиоптимального алгоритма (2.4)–(3.14), (3.16)–(3.18) при оценке угловой скорости линии визирования, что особенно важно в случае, когда одновременно наблюдается как маневр объекта, так и скачкообразные нарушения в каналах измерений. Необходимо также отметить, что при реализации квазиоптимального алгоритма отсутствует рост числа каналов фильтра, как в случае байесовского алгоритма адаптивного оценивания [8], что обусловлено марковским свойством ДНМП.

Заключение. Методами теории условных марковских процессов решена задача оптимального оценивания ненаблюдаемых компонент векторной марковской последовательности ДНМП при двухканальном векторном наблюдении. Синтезированные алгоритмы основаны на разложении смешанной апостериорной плотности вероятности вектора состояния ${{\left[ {{\mathbf{X}}_{k}^{{\text{T}}},{{A}_{k}},{{B}_{k}},{{C}_{k}}} \right]}^{{\,{\text{T}}}}}$ и являются алгоритмами с обратными связями по дискретному процессу ${\mathbf{S}}_{k}^{{\text{T}}} = \left[ {{{A}_{k}},{{B}_{k}},{{C}_{k}}} \right]$. На базе квазиоптимального алгоритма разработана соответствующая структурная схема цифрового фильтра КОИ.

Особенность синтезированного квазиоптимального алгоритма комплексирования состоит в неразрывной связанности уравнений фильтрации и экстраполяции дискретного и непрерывного компонентов ДНМП между собой, что потребует дополнительных вычислительных затрат по сравнению с известными алгоритмами. Однако современная высокопроизводительная вычислительная техника позволяет построить практически реализуемый цифровой фильтр КОИ в статистически неопределённых ситуациях.

Список литературы

Бар-Шалом Я., Ли Х.-Р. Траекторная обработка: принципы, способы и алгоритмы. Пер. с англ. Д.Д. Дмитриева. М.: МГТУ им. Н.Э. Баумана, 2011.

Bar-Shalom Y., Kirubarajan T., Li X.R. Estimation with Applications to Tracking and Navigation. N.Y.: Wiley, 2001.

Sutton Z., Willett P., Bar-Shalom Y. Target Tracking Applied to Extraction of Multiple Evolving Threats From a Stream of Surveillance Data // IEEE Transactions on Computational Social Systems. 2021. V. 8. № 2. P. 434–450.

Schoenecker S., Willett P., Bar-Shalom Y. Resolution Limits for Tracking Closely Spaced Targets // IEEE Transactions on Aerospace and Electronic Systems. 2018. V. 54. № 6. P. 2900–2910.

Gao Y., Liu Y., Li, X.R. Tracking-Aided Classification of Targets Using Multihypothesis Sequential Probability Ratio Test // IEEE Transactions on Aerospace and Electronic Systems. 2018. V. 54. № 1. P. 233–245.

Aftab W., Mihaylova L. A Learning Gaussian Process Approach for Maneuvering Target Tracking and Smoothing // IEEE Transactions on Aerospace and Electronic Systems. 2021. V. 57. № 1. P. 278–292.

Buelta A., Olivares A., Staffetti E., Aftab W., Mihaylova L. A Gaussian Process Iterative Learning Control for Aircraft Trajectory Tracking // IEEE Transactions on Aerospace and Electronic Systems. 2021. V. 57. № 6. P. 3962–3973.

Миронов М.А. Марковская теория оптимального оценивания случайных процессов. М.: Изд-во ФГУП “ГосНИИАС”, 2013.

Rezaie R., Li X.R. Destination-Directed Trajectory Modeling, Filtering, and Prediction Using Conditionally Markov Sequences // IEEE Transactions on Aerospace and Electronic Systems. 2021. V. 57. № 2. P. 820–833.

Li S., Cheng Y., Brown D., Tharmarasa R. Comprehensive Time-Offset Estimation for Multisensor Target Tracking // IEEE Transactions on Aerospace and Electronic Systems. 2020. V. 56. № 3. P. 2351–2373.

Kowalski M., Willett P., Fair T., Bar-Shalom Y. CRLB for Estimating Time-Varying Rotational Biases in Passive Sensors // IEEE Transactions on Aerospace and Electronic Systems. 2020. V. 56. № 1. P. 343–355.

Taghavi E., Tharmarasa R., Kirubarajan T., Bar-Shalom Y. Track-to-Track Fusion with Cross-covariances from Radar and IR/EO Sensor // 22th Intern. Conf. on Information Fusion (FUSION). Ottawa, ON, Canada, 2019.

Rashid M., Ali Sebt M. Tracking a Maneuvering Target in the Presence of Clutter by Multiple Detection Radar and Infra-red Sensor // 25th Iranian Conf. on Electrical Engineering (ICEE). Tehran, Iran, 2017. P. 1917–1922.

Детков А.Н. Оптимальное оценивание дискретно-непрерывных марковских процессов по наблюдаемым цифровым сигналам // РЭ. 2021. Т. 66. № 8. С. 748–759.

Детков А.Н. Оптимизация алгоритмов цифровой фильтрации смешанных марковских процессов при сопровождении маневрирующего объекта // Изв. РАН. ТиСУ. 1997. № 2. С. 73–80.

Тихонов В.И., Миронов М.А. Марковские процессы. М.: Сов радио, 1977.

Бухалёв В.А. Распознавание, оценивание и управление в системах со случайной скачкообразной структурой. М.: Наука, 1996.

Руденко Е.А. Конечномерные рекуррентные алгоритмы оптимальной нелинейной логико-динамической фильтрации // Изв. РАН. ТиСУ. 2016. № 1. С. 43–65.

Жук С.Я. Методы оптимизации дискретных динамических систем со случайной структурой. Киев: НТУУ “КПИ”, 2008.

Репин В.Г., Тартаковский Г.П. Статистический синтез при априорной неопределенности и адаптация информационных систем. М.: Сов. радио, 1978.

Гантмахер Ф.Р. Теория матриц. М.: Физматлит, 2010.

Дополнительные материалы отсутствуют.

Инструменты

Известия РАН. Теория и системы управления